梳理一下最近用到的模型 :yolov4

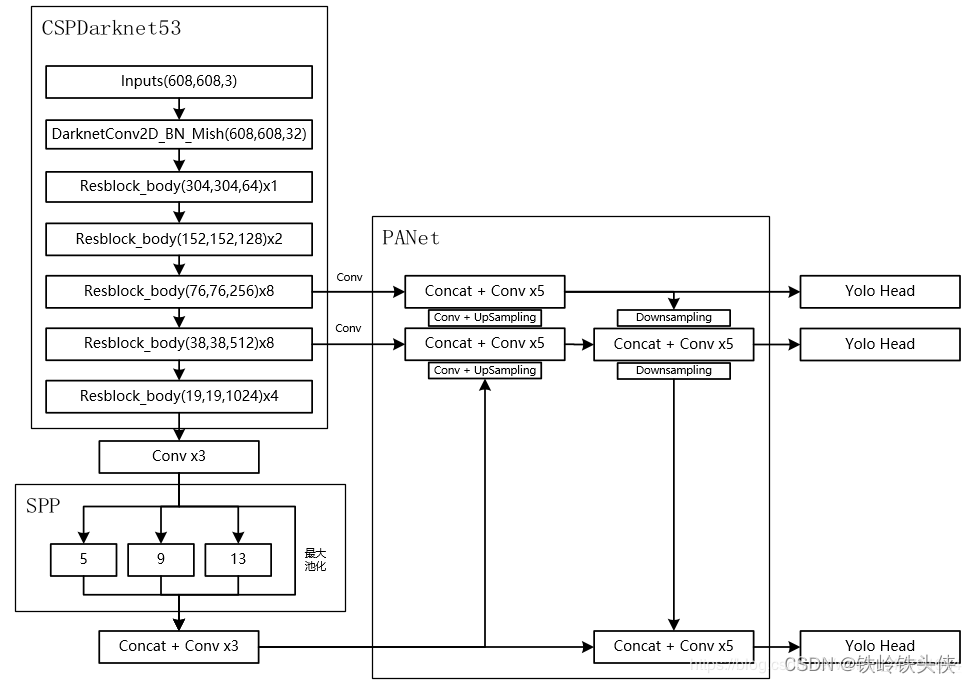

1.总体说明

YOLOV4是YOLOV3的改进版,在YOLOV3的基础上YOLOV4很好的结合了速度与精度。

YOLOV4整体上的检测思路和YOLOV3相比相差并不大,都是使用三个特征层进行分类与回归预测。

部分的提升部分

1、主干特征提取网络:DarkNet53 => CSPDarkNet53

2、特征金字塔:SPP,PAN

3、分类回归层:YOLOv3(未改变)

4、训练用到的小技巧:Mosaic数据增强、Label Smoothing平滑、CIOU、学习率余弦退火衰减

5、激活函数:使用Mish激活函数

2.模型的整体流程图:

3.cfg文件输出

在官方给出的cfg文件中,我们可以看到YOLOv4网络每一层的输出,每一层layer是如何得到的注释在了每一行后面,没有注释的就是对上一行的特征图进行卷积。可以看到YOLOv4网络共有161层,在608 × 608 分辨率下,计算量总共128.46BFLOPS,YOLOv3为141BFLOPS。

layer filters size/strd(dil) input output

0 conv 32 3 x 3/ 1 608 x 608 x 3 -> 608 x 608 x 32 0.639 BF

1 conv 64 3 x 3/ 2 608 x 608 x 32 -> 304 x 304 x 64 3.407 BF 降低特征图宽度和高度 size // 2,特征图尺寸 304 x 304 x 64

2 conv 64 1 x 1/ 1 304 x 304 x 64 -> 304 x 304 x 64 0.757 BF 1 x 1 卷积 通道不降维 64 ==> 64

3 route 1 -> 304 x 304 x 64 复制 layer 1 特征图

4 conv 64 1 x 1/ 1 304 x 304 x 64 -> 304 x 304 x 64 0.757 BF

5 conv 32 1 x 1/ 1 304 x 304 x 64 -> 304 x 304 x 32 0.379 BF

6 conv 64 3 x 3/ 1 304 x 304 x 32 -> 304 x 304 x 64 3.407 BF

7 Shortcut Layer: 4, wt = 0, wn = 0, outputs: 304 x 304 x 64 0.006 BF 由 layer 4 和 layer 6 相加得到

8 conv 64 1 x 1/ 1 304 x 304 x 64 -> 304 x 304 x 64 0.757 BF 1 x 1 卷积 通道不降维 64 ==> 64

9 route 8 2 -> 304 x 304 x 128 concatenation layer 8 和 layer 2

10 conv 64 1 x 1/ 1 304 x 304 x 128 -> 304 x 304 x 64 1.514 BF 1 x 1 特征融合并降维 128 ==> 64

11 conv 128 3 x 3/ 2 304 x 304 x 64 -> 152 x 152 x 128 3.407 BF 降低特征图宽度和高度 size // 2,特征图尺寸 152 x 152 x 128

12 conv 64 1 x 1/ 1 152 x 152 x 128 -> 152 x 152 x 64 0.379 BF 1 x 1 卷积 通道降维 128 ==> 64

13 route 11 -> 152 x 152 x 128 复制 layer 11 特征图

14 conv 64 1 x 1/ 1 152 x 152 x 128 -> 152 x 152 x 64 0.379 BF 1 x 1 卷积 通道降维 128 ==> 64

15 conv 64 1 x 1/ 1 152 x 152 x 64 -> 152 x 152 x 64 0.189 BF

16 conv 64 3 x 3/ 1 152 x 152 x 64 -> 152 x 152 x 64 1.703 BF

17 Shortcut Layer: 14, wt = 0, wn = 0, outputs: 152 x 152 x 64 0.001 BF 由 layer 14 和 layer 16 相加得到

18 conv 64 1 x 1/ 1 152 x 152 x 64 -> 152 x 152 x 64 0.189 BF

19 conv 64 3 x 3/ 1 152 x 152 x 64 -> 152 x 152 x 64 1.703 BF

20 Shortcut Layer: 17, wt = 0, wn = 0, outputs: 152 x 152 x 64 0.001 BF 由 layer 17 和 layer 19 相加得到

21 conv 64 1 x 1/ 1 152 x 152 x 64 -> 152 x 152 x 64 0.189 BFF 1 x 1 卷积 通道不降维 64 ==> 64

22 route 21 12 -> 152 x 152 x 128 concatenation layer 21 和 layer 12

23 conv 128 1 x 1/ 1 152 x 152 x 128 -> 152 x 152 x 128 0.757 BF 1 x 1 特征融合不降维 128 ==> 128

24 conv 256 3 x 3/ 2 152 x 152 x 128 -> 76 x 76 x 256 3.407 BF 降低特征图宽度和高度 size // 2,特征图尺寸 76 x 76 x 256

25 conv 128 1 x 1/ 1 76 x 76 x 256 -> 76 x 76 x 128 0.379 BF 1 x 1 卷积 通道降维 256 ==> 128

26 route 24 -> 76 x 76 x 256 复制 layer 25 特征图

27 conv 128 1 x 1/ 1 76 x 76 x 256 -> 76 x 76 x 128 0.379 BF 1 x 1 卷积 通道降维 256 ==> 128

28 conv 128 1 x 1/ 1 76 x 76 x 128 -> 76 x 76 x 128 0.189 BF

29 conv 128 3 x 3/ 1 76 x 76 x 128 -> 76 x 76 x 128 1.703 BF

30 Shortcut Layer: 27, wt = 0, wn = 0, outputs: 76 x 76 x 128 0.001 BF 由 layer 27 和 layer 29 相加得到

31 conv 128 1 x 1/ 1 76 x 76 x 128 -> 76 x 76 x 128 0.189 BF

32 conv 128 3 x 3/ 1 76 x 76 x 128 -> 76 x 76 x 128 1.703 BF

33 Shortcut Layer: 30, wt = 0, wn = 0, outputs: 76 x 76 x 128 0.001 BF 由 layer 30 和 layer 32 相加得到

34 conv 128 1 x 1/ 1 76 x 76 x 128 -> 76 x 76 x 128 0.189 BF

35 conv 128 3 x 3/ 1 76 x 76 x 128 -> 76 x 76 x 128 1.703 BF

36 Shortcut Layer: 33, wt = 0, wn = 0, outputs: 76 x 76 x 128 0.001 BF 由 layer 33 和 layer 35 相加得到

37 conv 128 1 x 1/ 1 76 x 76 x 128 -> 76 x 76 x 128 0.189 BF

38 conv 128 3 x 3/ 1 76 x 76 x 128 -> 76 x 76 x 128 1.703 BF

39 Shortcut Layer: 36, wt = 0, wn = 0, outputs: 76 x 76 x 128 0.001 BF 由 layer 36 和 layer 38 相加得到

40 conv 128 1 x 1/ 1 76 x 76 x 128 -> 76 x 76 x 128 0.189 BF

41 conv 128 3 x 3/ 1 76 x 76 x 128 -> 76 x 76 x 128 1.703 BF

42 Shortcut Layer: 39, wt = 0, wn = 0, outputs: 76 x 76 x 128 0.001 BF 由 layer 30 和 layer 41 相加得到

43 conv 128 1 x 1/ 1 76 x 76 x 128 -> 76 x 76 x 128 0.189 BF

44 conv 128 3 x 3/ 1 76 x 76 x 128 -> 76 x 76 x 128 1.703 BF

45 Shortcut Layer: 42, wt = 0, wn = 0, outputs: 76 x 76 x 128 0.001 BF 由 layer 42 和 layer 44 相加得到

46 conv 128 1 x 1/ 1 76 x 76 x 128 -> 76 x 76 x 128 0.189 BF

47 conv 128 3 x 3/ 1 76 x 76 x 128 -> 76 x 76 x 128 1.703 BF

48 Shortcut Layer: 45, wt = 0, wn = 0, outputs: 76 x 76 x 128 0.001 BF 由 layer 45 和 layer 47 相加得到

49 conv 128 1 x 1/ 1 76 x 76 x 128 -> 76 x 76 x 128 0.189 BF

50 conv 128 3 x 3/ 1 76 x 76 x 128 -> 76 x 76 x 128 1.703 BF

51 Shortcut Layer: 48, wt = 0, wn = 0, outputs: 76 x 76 x 128 0.001 BF 由 layer 48 和 layer 50 相加得到

52 conv 128 1 x 1/ 1 76 x 76 x 128 -> 76 x 76 x 128 0.189 BF 1 x 1 卷积 通道不降维 128 ==> 128

53 route 52 25 -> 76 x 76 x 256 concatenation layer 25 和 layer 52

54 conv 256 1 x 1/ 1 76 x 76 x 256 -> 76 x 76 x 256 0.757 BF 1 x 1 特征融合不降维 256 ==> 256

55 conv 512 3 x 3/ 2 76 x 76 x 256 -> 38 x 38 x 512 3.407 BF 降低特征图宽度和高度 size // 2,特征图尺寸 38 x 38 x 512

56 conv 256 1 x 1/ 1 38 x 38 x 512 -> 38 x 38 x 256 0.379 BF 1 x 1 卷积 通道降维 512 ==> 256

57 route 55 -> 38 x 38 x 512 复制 layer 55 特征图

58 conv 256 1 x 1/ 1 38 x 38 x 512 -> 38 x 38 x 256 0.379 BF 1 x 1 卷积 通道降维 512 ==> 256

59 conv 256 1 x 1/ 1 38 x 38 x 256 -> 38 x 38 x 256 0.189 BF

60 conv 256 3 x 3/ 1 38 x 38 x 256 -> 38 x 38 x 256 1.703 BF

61 Shortcut Layer: 58, wt = 0, wn = 0, outputs: 38 x 38 x 256 0.000 BF 由 layer 58 和 layer 60 相加得到

62 conv 256 1 x 1/ 1 38 x 38 x 256 -> 38 x 38 x 256 0.189 BF

63 conv 256 3 x 3/ 1 38 x 38 x 256 -> 38 x 38 x 256 1.703 BF

64 Shortcut Layer: 61, wt = 0, wn = 0, outputs: 38 x 38 x 256 0.000 BF 由 layer 61 和 layer 63 相加得到

65 conv 256 1 x 1/ 1 38 x 38 x 256 -> 38 x 38 x 256 0.189 BF

66 conv 256 3 x 3/ 1 38 x 38 x 256 -> 38 x 38 x 256 1.703 BF

67 Shortcut Layer: 64, wt = 0, wn = 0, outputs: 38 x 38 x 256 0.000 BF 由 layer 64 和 layer 66 相加得到

68 conv 256 1 x 1/ 1 38 x 38 x 256 -> 38 x 38 x 256 0.189 BF

69 conv 256 3 x 3/ 1 38 x 38 x 256 -> 38 x 38 x 256 1.703 BF

70 Shortcut Layer: 67, wt = 0, wn = 0, outputs: 38 x 38 x 256 0.000 BF 由 layer 67 和 layer 69 相加得到

71 conv 256 1 x 1/ 1 38 x 38 x 256 -> 38 x 38 x 256 0.189 BF

72 conv 256 3 x 3/ 1 38 x 38 x 256 -> 38 x 38 x 256 1.703 BF

73 Shortcut Layer: 70, wt = 0, wn = 0, outputs: 38 x 38 x 256 0.000 BF 由 layer 70 和 layer 72 相加得到

74 conv 256 1 x 1/ 1 38 x 38 x 256 -> 38 x 38 x 256 0.189 BF

75 conv 256 3 x 3/ 1 38 x 38 x 256 -> 38 x 38 x 256 1.703 BF

76 Shortcut Layer: 73, wt = 0, wn = 0, outputs: 38 x 38 x 256 0.000 BF 由 layer 73 和 layer 75 相加得到

77 conv 256 1 x 1/ 1 38 x 38 x 256 -> 38 x 38 x 256 0.189 BF

78 conv 256 3 x 3/ 1 38 x 38 x 256 -> 38 x 38 x 256 1.703 BF

79 Shortcut Layer: 76, wt = 0, wn = 0, outputs: 38 x 38 x 256 0.000 BF 由 layer 76 和 layer 78 相加得到

80 conv 256 1 x 1/ 1 38 x 38 x 256 -> 38 x 38 x 256 0.189 BF

81 conv 256 3 x 3/ 1 38 x 38 x 256 -> 38 x 38 x 256 1.703 BF

82 Shortcut Layer: 79, wt = 0, wn = 0, outputs: 38 x 38 x 256 0.000 BF 由 layer 79 和 layer 81 相加得到

83 conv 256 1 x 1/ 1 38 x 38 x 256 -> 38 x 38 x 256 0.189 BF 1 x 1 卷积 通道不降维 256 ==> 256

84 route 83 56 -> 38 x 38 x 512 concatenation layer 56 和 layer 83

85 conv 512 1 x 1/ 1 38 x 38 x 512 -> 38 x 38 x 512 0.757 BF 1 x 1 特征融合不降维 512 ==> 512

86 conv 1024 3 x 3/ 2 38 x 38 x 512 -> 19 x 19 x1024 3.407 BF 降低特征图宽度和高度 size // 2,特征图尺寸 19 x 19 x 1024

87 conv 512 1 x 1/ 1 19 x 19 x1024 -> 19 x 19 x 512 0.379 BF 1 x 1 卷积 通道降维 1024 ==> 512

88 route 86 -> 19 x 19 x1024 复制 layer 86 特征图

89 conv 512 1 x 1/ 1 19 x 19 x1024 -> 19 x 19 x 512 0.379 BF 1 x 1 卷积 通道降维 1024 ==> 512

90 conv 512 1 x 1/ 1 19 x 19 x 512 -> 19 x 19 x 512 0.189 BF

91 conv 512 3 x 3/ 1 19 x 19 x 512 -> 19 x 19 x 512 1.703 BF

92 Shortcut Layer: 89, wt = 0, wn = 0, outputs: 19 x 19 x 512 0.000 BF 由 layer 89 和 layer 91 相加得到

93 conv 512 1 x 1/ 1 19 x 19 x 512 -> 19 x 19 x 512 0.189 BF

94 conv 512 3 x 3/ 1 19 x 19 x 512 -> 19 x 19 x 512 1.703 BF

95 Shortcut Layer: 92, wt = 0, wn = 0, outputs: 19 x 19 x 512 0.000 BF 由 layer 92 和 layer 94 相加得到

96 conv 512 1 x 1/ 1 19 x 19 x 512 -> 19 x 19 x 512 0.189 BF

97 conv 512 3 x 3/ 1 19 x 19 x 512 -> 19 x 19 x 512 1.703 BF

98 Shortcut Layer: 95, wt = 0, wn = 0, outputs: 19 x 19 x 512 0.000 BF 由 layer 95 和 layer 97 相加得到

99 conv 512 1 x 1/ 1 19 x 19 x 512 -> 19 x 19 x 512 0.189 BF

100 conv 512 3 x 3/ 1 19 x 19 x 512 -> 19 x 19 x 512 1.703 BF

101 Shortcut Layer: 98, wt = 0, wn = 0, outputs: 19 x 19 x 512 0.000 BF 由 layer 98 和 layer 100 相加得到

102 conv 512 1 x 1/ 1 19 x 19 x 512 -> 19 x 19 x 512 0.189 BF 1 x 1 卷积 通道不降维 512 ==> 512

103 route 102 87 -> 19 x 19 x1024 concatenation layer 87 和 layer 102

104 conv 1024 1 x 1/ 1 19 x 19 x1024 -> 19 x 19 x1024 0.757 BF 1 x 1 特征融合不降维 1024 ==> 1024

105 conv 512 1 x 1/ 1 19 x 19 x1024 -> 19 x 19 x 512 0.379 BF 1 x 1 卷积 通道降维 1024 ==> 512

106 conv 1024 3 x 3/ 1 19 x 19 x 512 -> 19 x 19 x1024 3.407 BF 3 x 3 卷积 通道升维 512 ==> 1024

107 conv 512 1 x 1/ 1 19 x 19 x1024 -> 19 x 19 x 512 0.379 BF 1 x 1 卷积 通道降维 1024 ==> 512

108 max 5x 5/ 1 19 x 19 x 512 -> 19 x 19 x 512 0.005 BF 对 layer 107 进行 5 x 5 最大池化

109 route 107 -> 19 x 19 x 512

110 max 9x 9/ 1 19 x 19 x 512 -> 19 x 19 x 512 0.015 BF 对 layer 107 进行 9 x 9 最大池化

111 route 107 -> 19 x 19 x 512

112 max 13x13/ 1 19 x 19 x 512 -> 19 x 19 x 512 0.031 BF 对 layer 107 进行 13 x 13 最大池化

113 route 112 110 108 107 -> 19 x 19 x2048 concatenation layer 107, layer 108,layer 110 和 layer 112

114 conv 512 1 x 1/ 1 19 x 19 x2048 -> 19 x 19 x 512 0.757 BF 1 x 1 卷积 通道降维 2048 ==> 512

115 conv 1024 3 x 3/ 1 19 x 19 x 512 -> 19 x 19 x1024 3.407 BF

116 conv 512 1 x 1/ 1 19 x 19 x1024 -> 19 x 19 x 512 0.379 BF 1 x 1 卷积 通道降维 1024 ==> 512

117 conv 256 1 x 1/ 1 19 x 19 x 512 -> 19 x 19 x 256 0.095 BF 1 x 1 卷积 通道降维 512 ==> 256

118 upsample 2x 19 x 19 x 256 -> 38 x 38 x 256 上采样特征图宽度和高度 size x 2,特征图尺寸 38 x 38 x 256

119 route 85 -> 38 x 38 x 512 复制 layer 85 特征图

120 conv 256 1 x 1/ 1 38 x 38 x 512 -> 38 x 38 x 256 0.379 BF 1 x 1 卷积 通道降维 512 ==> 256

121 route 120 118 -> 38 x 38 x 512 concatenation layer 118 和 layer 120

122 conv 256 1 x 1/ 1 38 x 38 x 512 -> 38 x 38 x 256 0.379 BF 1 x 1 卷积 通道降维 512 ==> 256

123 conv 512 3 x 3/ 1 38 x 38 x 256 -> 38 x 38 x 512 3.407 BF

124 conv 256 1 x 1/ 1 38 x 38 x 512 -> 38 x 38 x 256 0.379 BF

125 conv 512 3 x 3/ 1 38 x 38 x 256 -> 38 x 38 x 512 3.407 BF

126 conv 256 1 x 1/ 1 38 x 38 x 512 -> 38 x 38 x 256 0.379 BF

127 conv 128 1 x 1/ 1 38 x 38 x 256 -> 38 x 38 x 128 0.095 BF

128 upsample 2x 38 x 38 x 128 -> 76 x 76 x 128 上采样特征图宽度和高度 size x 2,特征图尺寸 76 x 76 x 128

129 route 54 -> 76 x 76 x 256 复制 layer 54 特征图

130 conv 128 1 x 1/ 1 76 x 76 x 256 -> 76 x 76 x 128 0.379 BF 1 x 1 卷积 通道降维 256 ==> 128

131 route 130 128 -> 76 x 76 x 256 concatenation layer 128 和 layer 130

132 conv 128 1 x 1/ 1 76 x 76 x 256 -> 76 x 76 x 128 0.379 BF 1 x 1 卷积 通道降维 256 ==> 128

133 conv 256 3 x 3/ 1 76 x 76 x 128 -> 76 x 76 x 256 3.407 BF 76 x 76 YOLO Head

134 conv 128 1 x 1/ 1 76 x 76 x 256 -> 76 x 76 x 128 0.379 BF

135 conv 256 3 x 3/ 1 76 x 76 x 128 -> 76 x 76 x 256 3.407 BF

136 conv 128 1 x 1/ 1 76 x 76 x 256 -> 76 x 76 x 128 0.379 BF

137 conv 256 3 x 3/ 1 76 x 76 x 128 -> 76 x 76 x 256 3.407 BF

138 conv 255 1 x 1/ 1 76 x 76 x 256 -> 76 x 76 x 255 0.754 BF

139 yolo YOLO layer 76 x 76 x 255

[yolo] params: iou loss: ciou (4), iou_norm: 0.07, cls_norm: 1.00, scale_x_y: 1.20

nms_kind: greedynms (1), beta = 0.600000

140 route 136 -> 76 x 76 x 128 复制 layer 136 特征图

141 conv 256 3 x 3/ 2 76 x 76 x 128 -> 38 x 38 x 256 0.852 BF 降低特征图宽度和高度 size // 2,特征图尺寸 38 x 38 x 256

142 route 141 126 -> 38 x 38 x 512 concatenation layer 126 和 layer 141

143 conv 256 1 x 1/ 1 38 x 38 x 512 -> 38 x 38 x 256 0.379 BF 1 x 1 卷积 通道降维 512 ==> 256

144 conv 512 3 x 3/ 1 38 x 38 x 256 -> 38 x 38 x 512 3.407 BF 38 x 38 YOLO Head

145 conv 256 1 x 1/ 1 38 x 38 x 512 -> 38 x 38 x 256 0.379 BF

146 conv 512 3 x 3/ 1 38 x 38 x 256 -> 38 x 38 x 512 3.407 BF

147 conv 256 1 x 1/ 1 38 x 38 x 512 -> 38 x 38 x 256 0.379 BF

148 conv 512 3 x 3/ 1 38 x 38 x 256 -> 38 x 38 x 512 3.407 BF

149 conv 255 1 x 1/ 1 38 x 38 x 512 -> 38 x 38 x 255 0.377 BF

150 yolo YOLO layer 38 x 38 x 255

[yolo] params: iou loss: ciou (4), iou_norm: 0.07, cls_norm: 1.00, scale_x_y: 1.10

nms_kind: greedynms (1), beta = 0.600000

151 route 147 -> 38 x 38 x 256 复制 layer 147 特征图

152 conv 512 3 x 3/ 2 38 x 38 x 256 -> 19 x 19 x 512 0.852 BF 降低特征图宽度和高度 size // 2,特征图尺寸 19 x 19 x 512

153 route 152 116 -> 19 x 19 x1024 concatenation layer 116 和 layer 152

154 conv 512 1 x 1/ 1 19 x 19 x1024 -> 19 x 19 x 512 0.379 BF 1 x 1 卷积 通道降维 1024 ==> 512

155 conv 1024 3 x 3/ 1 19 x 19 x 512 -> 19 x 19 x1024 3.407 BF 19 x 19 YOLO Head

156 conv 512 1 x 1/ 1 19 x 19 x1024 -> 19 x 19 x 512 0.379 BF

157 conv 1024 3 x 3/ 1 19 x 19 x 512 -> 19 x 19 x1024 3.407 BF

158 conv 512 1 x 1/ 1 19 x 19 x1024 -> 19 x 19 x 512 0.379 BF

159 conv 1024 3 x 3/ 1 19 x 19 x 512 -> 19 x 19 x1024 3.407 BF

160 conv 255 1 x 1/ 1 19 x 19 x1024 -> 19 x 19 x 255 0.189 BF

161 yolo YOLO layer 19 x 19 x 255

[yolo] params: iou loss: ciou (4), iou_norm: 0.07, cls_norm: 1.00, scale_x_y: 1.05

nms_kind: greedynms (1), beta = 0.600000

Total BFLOPS 128.459

4.网络说明

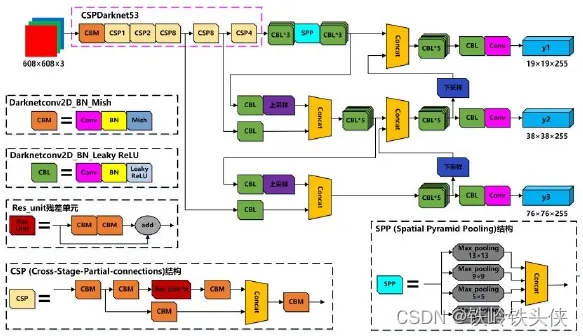

1. 主干CSPDarknet53

2. SPP与PANet

3. Yolo Head

主干CSPDarknet53:

yolov4主干特征基于yolov3提取网络Backbone的改进点有两个:

| 主干特征提取网络 | DarkNet53 => CSPDarkNet53 |

|---|---|

| 激活函数 | 使用Mish激活函数 |

特征金字塔 SPP与PANet

SPP结构参杂在对CSPdarknet53的最后一个特征层的卷积里,在对CSPdarknet53的最后一个特征层进行三次DarknetConv2D_BN_Leaky卷积后,分别利用四个不同尺度的最大池化进行处理,最大池化的池化核大小分别为13x13、9x9、5x5、1x1(1x1即无处理)

# 使用了SPP结构,即不同尺度的最大池化后堆叠。

maxpool1 = MaxPooling2D(pool_size=(13,13), strides=(1,1), padding='same')(P5)

maxpool2 = MaxPooling2D(pool_size=(9,9), strides=(1,1), padding='same')(P5)

maxpool3 = MaxPooling2D(pool_size=(5,5), strides=(1,1), padding='same')(P5)

P5 = Concatenate()([maxpool1, maxpool2, maxpool3, P5])

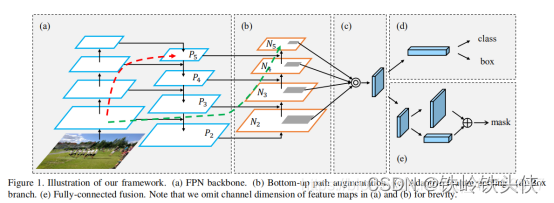

PANet是Path Aggregation Network的缩写,就是路径增强,用在YOLOv4中从cfg配置文件layer编号的顺序就是将YOLOv3三种不同尺度的处理过程先倒过来,再把后面有用的信息route前面去。

#---------------------------------------------------#

# Panet网络的构建,并且获得预测结果

#---------------------------------------------------#

def yolo_body(input_shape, anchors_mask, num_classes):

inputs = Input(input_shape)

#---------------------------------------------------#

# 生成CSPdarknet53的主干模型

# 获得三个有效特征层,他们的shape分别是:

# 52,52,256

# 26,26,512

# 13,13,1024

#---------------------------------------------------#

feat1,feat2,feat3 = darknet_body(inputs)

# 13,13,1024 -> 13,13,512 -> 13,13,1024 -> 13,13,512 -> 13,13,2048 -> 13,13,512 -> 13,13,1024 -> 13,13,512

P5 = DarknetConv2D_BN_Leaky(512, (1,1))(feat3)

P5 = DarknetConv2D_BN_Leaky(1024, (3,3))(P5)

P5 = DarknetConv2D_BN_Leaky(512, (1,1))(P5)

# 使用了SPP结构,即不同尺度的最大池化后堆叠。

maxpool1 = MaxPooling2D(pool_size=(13,13), strides=(1,1), padding='same')(P5)

maxpool2 = MaxPooling2D(pool_size=(9,9), strides=(1,1), padding='same')(P5)

maxpool3 = MaxPooling2D(pool_size=(5,5), strides=(1,1), padding='same')(P5)

P5 = Concatenate()([maxpool1, maxpool2, maxpool3, P5])

P5 = DarknetConv2D_BN_Leaky(512, (1,1))(P5)

P5 = DarknetConv2D_BN_Leaky(1024, (3,3))(P5)

P5 = DarknetConv2D_BN_Leaky(512, (1,1))(P5)

# 13,13,512 -> 13,13,256 -> 26,26,256

P5_upsample = compose(DarknetConv2D_BN_Leaky(256, (1,1)), UpSampling2D(2))(P5)

# 26,26,512 -> 26,26,256

P4 = DarknetConv2D_BN_Leaky(256, (1,1))(feat2)

# 26,26,256 + 26,26,256 -> 26,26,512

P4 = Concatenate()([P4, P5_upsample])

# 26,26,512 -> 26,26,256 -> 26,26,512 -> 26,26,256 -> 26,26,512 -> 26,26,256

P4 = make_five_convs(P4,256)

# 26,26,256 -> 26,26,128 -> 52,52,128

P4_upsample = compose(DarknetConv2D_BN_Leaky(128, (1,1)), UpSampling2D(2))(P4)

# 52,52,256 -> 52,52,128

P3 = DarknetConv2D_BN_Leaky(128, (1,1))(feat1)

# 52,52,128 + 52,52,128 -> 52,52,256

P3 = Concatenate()([P3, P4_upsample])

# 52,52,256 -> 52,52,128 -> 52,52,256 -> 52,52,128 -> 52,52,256 -> 52,52,128

P3 = make_five_convs(P3,128)

#---------------------------------------------------#

# 第三个特征层

# y3=(batch_size,52,52,3,85)

#---------------------------------------------------#

P3_output = DarknetConv2D_BN_Leaky(256, (3,3))(P3)

P3_output = DarknetConv2D(len(anchors_mask[0])*(num_classes+5), (1,1))(P3_output)

# 52,52,128 -> 26,26,256

P3_downsample = ZeroPadding2D(((1,0),(1,0)))(P3)

P3_downsample = DarknetConv2D_BN_Leaky(256, (3,3), strides=(2,2))(P3_downsample)

# 26,26,256 + 26,26,256 -> 26,26,512

P4 = Concatenate()([P3_downsample, P4])

# 26,26,512 -> 26,26,256 -> 26,26,512 -> 26,26,256 -> 26,26,512 -> 26,26,256

P4 = make_five_convs(P4,256)

#---------------------------------------------------#

# 第二个特征层

# y2=(batch_size,26,26,3,85)

#---------------------------------------------------#

P4_output = DarknetConv2D_BN_Leaky(512, (3,3))(P4)

P4_output = DarknetConv2D(len(anchors_mask[1])*(num_classes+5), (1,1))(P4_output)

# 26,26,256 -> 13,13,512

P4_downsample = ZeroPadding2D(((1,0),(1,0)))(P4)

P4_downsample = DarknetConv2D_BN_Leaky(512, (3,3), strides=(2,2))(P4_downsample)

# 13,13,512 + 13,13,512 -> 13,13,1024

P5 = Concatenate()([P4_downsample, P5])

# 13,13,1024 -> 13,13,512 -> 13,13,1024 -> 13,13,512 -> 13,13,1024 -> 13,13,512

P5 = make_five_convs(P5,512)

#---------------------------------------------------#

# 第一个特征层

# y1=(batch_size,13,13,3,85)

#---------------------------------------------------#

P5_output = DarknetConv2D_BN_Leaky(1024, (3,3))(P5)

P5_output = DarknetConv2D(len(anchors_mask[2])*(num_classes+5), (1,1))(P5_output)

return Model(inputs, [P5_output, P4_output, P3_output])

最后的yolohead部分

在特征利用部分,YoloV4提取多特征层进行目标检测,一共提取三个特征层,分别位于中间层,中下层,底层,三个特征层的shape分别为(52,52,256)、(26,26,512)、(13,13,1024)。

输出层的shape分别为(13,13,75),(26,26,75),(52,52,75),最后一个维度为75是因为该图是基于voc数据集的,它的类为20种,YoloV4只有针对每一个特征层存在3个先验框,所以最后维度为3x25;

如果使用的是coco训练集,类则为80种,最后的维度应该为255 = 3x85,三个特征层的shape为(13,13,255),(26,26,255),(52,52,255)

由第二步我们可以获得三个特征层的预测结果,shape分别为(N,13,13,255),(N,26,26,255),(N,52,52,255)的数据,对应每个图分为13x13、26x26、52x52的网格上3个预测框的位置。

但是这个预测结果并不对应着最终的预测框在图片上的位置,还需要解码才可以完成。yolo3的3个特征层分别将整幅图分为13x13、26x26、52x52的网格,每个网络点负责一个区域的检测。

我们知道特征层的预测结果对应着三个预测框的位置,我们先将其reshape一下,其结果为(N,13,13,3,85),(N,26,26,3,85),(N,52,52,3,85)。

最后一个维度中的85包含了4+1+80,分别代表x_offset、y_offset、h和w、置信度、分类结果。

yolo3的解码过程就是将每个网格点加上它对应的x_offset和y_offset,加完后的结果就是预测框的中心,然后再利用 先验框和h、w结合 计算出预测框的长和宽。这样就能得到整个预测框的位置了。

点赞收藏关注一下谢谢了,帮助到更多的人就会更有成就感!

参考博主:传送门

1710

1710

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?