没有等来OpenAI的Q*/草莓项目的发布,一家名为MultiOn初创公司却抢先发布了名为Q的智能体...

对于当下复杂reasonning问题:

当前依赖静态语言数据集的训练方法,不足以使这些模型适应动态的现实世界互动。

尤其在当下用于复杂长推理(Long reasoning)下的预或领域训练(pre&post training)数据集存在明显的稀缺状态下。

因此,在我们仍未对AGI甚至是ASI有足够的认识和发展下,以Agent这种显性reasoning模式阶段性或迭代式的补齐完全E2E模型隐层表征下reasoning模式,不失为一种对认知推理演进过程的平衡,而这种平衡短期上来看则聚焦在性能与效率、训练与推理资源的时空置换、短期与长期目标的衔接...

记得在之前的某篇笔记中,在对于System·Ⅱ E2E 长链复杂reasoning中在训练与推理与环境反馈中空间的探索与利用之平衡方面也进行了相关阐述,感兴趣的大伙可以翻看之前的笔记,或参考年初写的那本长篇电子书《融合RL与LLM思想,探寻世界模型以迈向AGI》中篇,也有相关论述。

感觉上Agent Q以一种巧妙的框架方法将reasoning目标分别对齐到短期推理和长期推理目标,来达到这种“平衡”。

这里简单向大家介绍一下这篇文章Agent Q所采取的研究思路与关键核心方法:

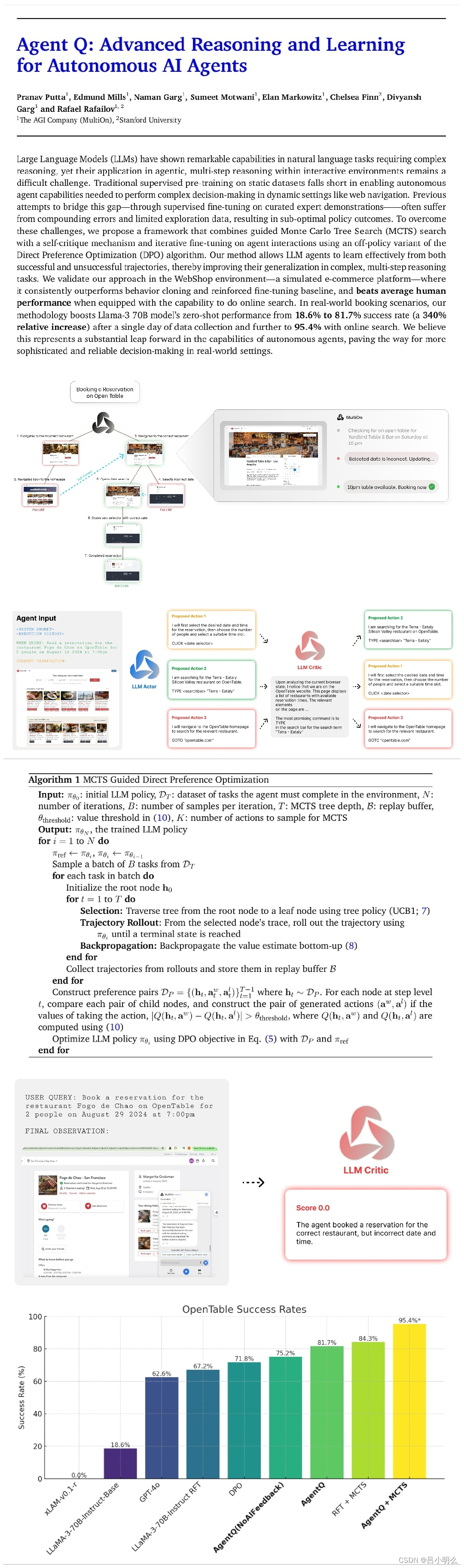

Ⅰ. 于MCTS的引导式搜索:通过探索不同的行为和网页自主生成数据,并在探索(exploration)和利用(exploitation)之间取得平衡。MCTS使用较高的采样温度和多样化提示词来扩展行为空间,确保能收集到多样化且最优的轨迹。

Ⅱ. AI自我批评:每个步骤中,基于AI的自我批评都能提供有价值的反馈,从而优化智能体的决策。这种步骤级反馈对于长周期任务至关重要,因为稀疏信号往往导致学习困难。

Ⅲ. 直接偏好优化:DPO算法通过构建由MCTS生成数据的偏好对来微调模型。这种off-policy的训练方法允许模型从聚合数据集中有效学习,包括搜索过程中探索的次优分支,从而提高复杂环境中的成功率。

当然,在整体方法思想和框架设计上,未来仍存在着诸多进一步改进空间,如推理算法在深度方面的演进学习、critic模型在推理过程中的更加灵活运用、MCTS方法的改进以及安全性等评估方面..感兴趣的大伙推荐读下原文~

426

426

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?