相比于半年前,结合当前人类历史上所积累的数据被各家llm接近压满情况下而促使各llm在寻求更复杂、多样化数据(以复杂reasoning为主导)以寻求更智能的进化中所采取的合成数据策略上,RL与LLM的融合统一这一思想正在逐渐被学术界和产业界更多的认可。

回顾一年半之前自己关于这方面的一系列思想实验再到今年年初完稿的那边10万字文章《融合RL与LLM思想,探寻世界模型以迈向AGI·上中下篇》,感兴趣的小伙伴可以关注联系我,以往的笔记或文章也多有涉及这一领域并结合前沿论文的观点和阐释。

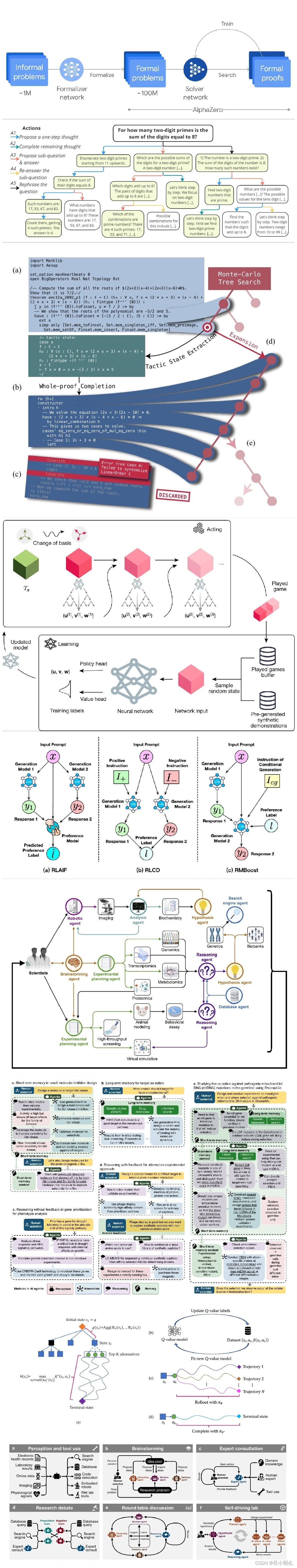

因此,现如今所观察到LLM scaling up边际收益递减的同时,采用self-play平衡探索与利用以提升llm推理能力正成为下一个技术范式。在新范式下scaling law也许也在发生着进化:model-parameter & training-time compute scaling将会因data scaling额外加入inference-time compute.

正如先前Ilya在某讲座中的一句简单的概括:让 AI 用随机路径去尝试新的任务,如果超出预期,就更新神经网络的权重让AI记得多使用成功的实践,然后开始下一次尝试..

那么在这种融合统一的趋势下,挑战也将并存:

RL的核心在于Explore和Exploit之间的权衡。如果LLM在"利用"现有知识上做到了现阶段的极致,而在"探索"新知识方面还有很大潜力,RL的引入就是为了让LLM能通过探索进一步提升推理能力,未来在探索与利用间的平衡我想将是理论研究的重点,这方面还很匮乏,当前大多研究者则是在各种策略和价值网络间尝试各变种MCTS下的探索..

同时,RM(奖励模型) 是RL中最关键的模块之一,有两个关键的卡点是需要解决的,那就是RM的泛化性和连续性。

如在开放文本领域,如何找到更加近似于棋牌、电子游戏、code编译器以及用于数学形式化定理证明(lean)那样的具备明确奖励反馈Self-play机制,或者在形式化与开放世界找到泛化可迁移之门。

即像LLM那样在通用世界而非形式化世界,或者是合理的利用形式化强验证奖励迁移到通用世界以实现奖励的泛化。另外,PRM也可作为增强奖励连续性的补充。

也许,未来的几年一种新的scaling law周期性现象将逐渐浮现:x年的model scaling-up周期..x年的RL reasoning周期...

422

422

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?