Boosting Adversarial Attacks with Momentum

摘要

深度神经网络容易受到对抗性样本的攻击,由于潜在的严重后果,这对这些算法带来了安全问题。在部署深度学习模型之前,对抗性策略可以作为一个重要的替代工具来评估深度学习模型的可行性。然而,现有的大多数对抗性攻击只能愚弄一个成功率较低的黑盒模型。为了解决这个问题,我们提出了一大类基于动量的迭代算法来增强对抗性攻击。通过在迭代过程中引入动量项,我们的方法可以在迭代过程中稳定更新方向,避免局部极值,从而产生更多可转移的对抗样本。为了进一步提高黑盒攻击的成功率,我们将动量迭代算法应用到一个模型集合中,并证明了具有强大防御能力的对手训练模型也容易受到黑盒攻击。我们希望所提出的方法能作为评估各种深部模型和防御方法鲁棒性的基准。通过这种方法,我们在NIPS 2017非目标对抗性攻击和目标对抗性攻击比赛中获得了第一名。

1、Introduction

深度神经网络(DNN)面临的挑战是,它们容易受到对抗样本的攻击[23,5],这些对抗样本是通过在合法样本中加入人类无法察觉的小噪音而构建的。但会使模型输出攻击者期望的不准确预测。由于它有助于在模型启动之前识别模型的脆弱性,因此越来越重视生成对抗样本。此外,对抗性样本还通过提供更多不同的训练数据,方便了各种DNN算法评估鲁棒性。

在了解给定模型的结构和参数的情况下,许多方法可以成功地以白盒方式生成对抗样本,包括基于优化的方法,如盒约束LBFGS[23]、基于一步梯度的方法,如快速梯度符号[5]和基于梯度方法的迭代变体[9]。一般来说,对抗样本的一个更严重的问题是其良好的可转移性[23,12,14],即,为一个模型构建的对抗样本对其他模型仍然是有利的,从而使黑盒攻击在现实世界的应用中变得实用,并提出了真正的安全问题。可转移性的现象是由于不同的机器学习模型围绕一个数据点学习相似的决策边界,使得为一个模型设计的对抗性样本对其他模型也有效。

然而,现有的攻击方法对黑盒模型的攻击效率较低,特别是对具有防御机制的黑盒模型。例如,集成对抗训练[24]显著地提高了深层神经网络的鲁棒性,并且大多数现有方法不能成功地以黑盒方式攻击它们。这在很大程度上归因于攻击能力和转移能力之间的权衡。特别是,基于优化和迭代方法生成的对抗性测试具有较差的可转移性[10],因此使得黑盒测试的效率较低。另一方面,基于一步梯度的方法产生了更多可转移的对抗性样本,但是对于白盒模型[10],它们的成功率通常较低,因此对黑盒攻击无效。鉴于实际黑盒攻击的困难,Papernot等人[16]使用自适应查询来训练替代模型,以充分描述目标模型的行为,从而将黑盒攻击转化为白盒攻击。然而,它需要目标模型给出的完全预测置信度和大量的查询,特别是对于ImageNet等大规模数据集[19]。这样的要求在实际应用中是不切实际的。因此,我们考虑如何在不知道黑盒模型的结构和参数的情况下,更进一步地,在不进行查询的情况下,有效地跟踪黑盒模型。

在本文中,我们提出了一类广泛的基于动量迭代梯度的方法来提高生成的对抗样本的成功率。除了基于迭代梯度的方法,该方法使用梯度迭代扰动输入,以使损失函数最大化[5],基于动量的方法在迭代过程中在损失函数的梯度方向上累积一个速度向量,以稳定更新方向并避免局部极大值过小。我们证明了动量迭代法生成的对抗样本在白盒和黑盒两种情况下都有较高的成功率。所提出的方法缓解了白盒攻击和可转移性之间的折衷,比一步方法[5]和普通迭代方法[9]具有更强的攻击能力。

为了进一步提高对抗样本的可转移性,我们研究了几种攻击模型集合的方法,因为如果一个对抗样本愚弄了多个模型,那么对于其他黑盒模型来说,它更有可能保持对抗性[12]。我们证明了多模型动量迭代方法生成的对抗样本,可以成功地愚弄通过黑盒方式集成对抗训练[24]获得的鲁棒模型。本文的研究结果为开发更健壮的深度学习模型提出了新的安全问题,希望我们的攻击可以作为评估各种深度学习模型和防御方法健壮性的基准。总之,我们做了以下贡献:

• 我们介绍了一类基于动量迭代梯度的攻击算法,该算法通过在每个迭代点上累积损失函数的梯度来稳定优化,避免陷入局部极大值。

• 我们研究了几种同时攻击多个模型的集成方法,通过保持较高的攻击成功率,证明了良好的可转移性。

• 我们首次证明,通过综合对抗训练获得的具有强大防御能力的模型也容易受到黑盒攻击。

2、Backgrounds

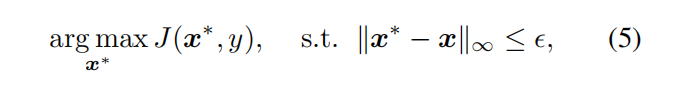

在本节中,我们提供了背景知识,并回顾了对抗攻击和防御方法的相关工作。 给定一个分类器 f ( x ) : x ∈ X → y ∈ Y f(x):x∈X→y∈Y f(x):x∈X→y∈Y,它输出一个标签 y y y作为输入 x x x的预测,对抗攻击的目标是在 x x x附近寻找一个样本 x ∗ x^* x∗ ,但是被分类器错误地分类。具体来说,有两类对抗样本——非针对性的和针对性的。对于具有正确打标记数据( ground-truth)的标签y的正确分类的输入 x x x,使得 f ( x ) = y f(x)=y f(x)=y,非目标对抗样本 x ∗ x^* x∗是通过在不改变标签的情况下向 x x x添加小噪声来制作的,但是将分类器误导为f( x ∗ ) {x ^*}) x∗) ≠ y \neq y =y;并且目标对抗样本旨在通过将特定的标签输出为f( x ∗ x^* x∗)= y ∗ y^ * y∗ 来愚弄分类器,其中 y ∗ y^ * y∗是对手指定的目标标签, y y y ≠ \neq = y ∗ y^* y∗。在大多数情况下,对手噪声的 L p L_p Lp范数要求小于允许值 ϵ \epsilon ϵ,即 ∥ x ∗ − x ∥ p \lVert x^* - x\rVert_p ∥x∗−x∥p ≤ \leq ≤ ϵ \epsilon ϵ,其中p可以是0,1,2,∞。

2.1、 Attack methods

现有的生成对抗样本的方法可以分为三类。我们在这里介绍它们的非目标版本的攻击,并且可以简单地导出目标版本。

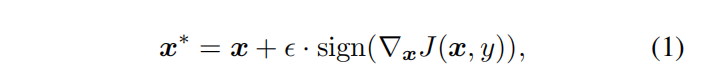

One-step gradient-based approaches,例如the fast gradient sign method (FGSM)[5],找到一个对抗样本 x ∗ x^∗ x∗通过最大化损失函数J( x ∗ x^∗ x∗ , y y y),其中J通常是交叉熵损失。FGSM产生对抗样本,以满足 L ∞ L_∞ L∞范数边界 ∥ x ∗ − x ∥ ∞ \lVert x^* - x\rVert_∞ ∥x∗−x∥∞ ≤ \leq ≤ ϵ \epsilon ϵ 作为

其中 ∇ x ∇_x ∇xJ( x , y x,y x,y)是损失函数w.r.t.x的梯度。 快速梯度法(FGM)是FGSM的推广,满足 L 2 L_2 L2范数边界 ∥ x ∗ − x ∥ 2 \lVert x^* - x\rVert_2 ∥x∗−x∥2 ≤ \leq ≤ ϵ \epsilon ϵ 作为

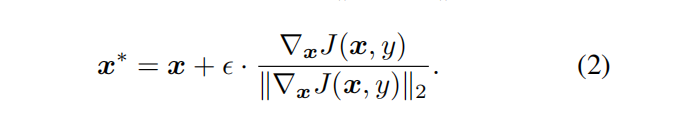

Iterative methods[9]以较小的步长α多次迭代应用快速梯度。迭代版本FGSM(I-FGSM)可表示为:

为了使生成的对抗样本满足 L ∞ L_∞ L∞(或 L 2 L_2 L2)边界,可以将 x t ∗ x^*_t xt∗裁剪到 x x x的 ϵ \epsilon ϵ 附近,或者简单地设置α= ϵ \epsilon ϵ /T,其中T是迭代次数。研究表明,迭代方法比单步方法具有更强的白盒对手,但代价是更差的可转移性[10,24]。

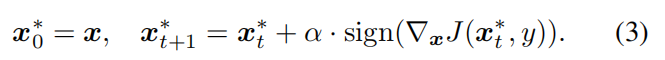

基于优化的方法[23]直接优化真实样本和对抗样本之间的距离,但会导致对抗样本的错误分类。盒约束L-BFGS可以用来解决这类问题。更复杂的方法[1]是解决:

由于它直接优化了一个对抗样本和相应的真正样本之间的距离,因此不能保证 L ∞ ( L 2 ) L_∞(L_2) L∞(L2)距离小于要求的值。基于优化的方法在黑盒攻击中也不像迭代方法那样有效。

2.2、 Defense methods

在众多的尝试中[13,3,15,10,24,17,11],对抗训练是最广泛研究的提高DNNs鲁棒性的方法[5,10,24]。通过在训练过程中注入对抗样本,对抗训练模型学习抵抗损失函数梯度方向的扰动。然而,由于对抗样本的生成和训练的参数的耦合,它们不能赋予黑盒攻击健壮性。集合对抗训练[24]使用对抗样本来扩充训练数据,这些对抗样本不仅来自于被训练的模型,而且来自于其他留出法(hold-out)模型。因此,集成对抗训练模型对单步攻击和黑盒攻击具有很强的鲁棒性。

3、Methodology

在本文中,我们提出了一类基于动量迭代梯度的方法来生成对抗样本,它可以欺骗白盒模型和黑盒模型。在本节中,我们将详细介绍提出的算法。首先说明了如何将动量迭代快速梯度符号法(MI-FGSM)与迭代FGSM相结合,在非目标攻击方式下产生满足 L ∞ L_∞ L∞范数约束的对抗样本。然后,我们介绍了几种有效攻击模型集合的方法。最后,我们将MI-FGSM扩展到 L 2 L_2 L2范数有界攻击和目标攻击,得到了一类广泛的攻击方法。

3.1. Momentum iterative fast gradient sign method

动量法[18]是一种加速梯度下降算法的技术,通过在迭代过程中沿损失函数的梯度方向累积速度向量。记忆以前的梯度有助于通过狭窄的山谷,小驼峰和贫穷的地方极小值或极大值[4]。动量法也显示了它在随机梯度下降中稳定更新的有效性[20]。我们运用动量的概念来产生对抗样本,并获得巨大的利益。

为了从满足 L ∞ L_∞ L∞范数界的真实样本 x x x生成非目标对抗样本 x ∗ x^* x∗,基于梯度的方法通过求解约束优化问题来寻找对抗性样本。

其中 ϵ \epsilon ϵ 是对抗性干扰的大小。FGSM通过假设数据点周围决策边界的线性,将梯度符号仅应用于一个真实样本一次(在公式(1)中),从而生成一个对抗样本。然而在实际中,当失真较大时,线性假设可能不成立[12],这使得FGSM生成的对抗性样本“不适合”模型,限制了其攻击能力。相反,在每次迭代中,它贪婪地沿着梯度符号的方向移动对抗样本(在等式(3)中)。因此,对抗样本很容易陷入很差的局部极大值和“过度拟合”模型,这不太可能在模型之间传递。

为了打破这一困境,我们将动量积分到迭代FGSM中,以稳定更新方向和摆脱局部极值。因此,基于动量的方法在增加运算量的同时保持了对抗样本的可转移性,同时也成为迭代FGSM等白盒模型的有力对手。它缓解了攻击能力和可转移性之间的权衡,表现出强大的黑盒攻击。

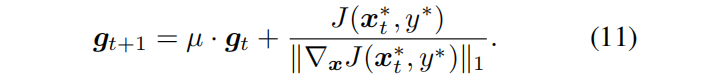

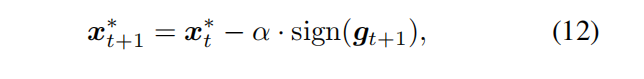

算法1总结了动量迭代快速梯度符号法(MI - FGSM)。具体来说, g t g_t gt使用衰减因子µ收集第一次t迭代的梯度,如式(6)所示。,在式(6)中定义。然后对抗样本 x t ∗ x^∗_t xt∗直到第t次迭代在式(7)中步长为α的gt符号方向上被扰动。如果µ 等于0时,MI-FGSM退化为迭代FGSM。在每个迭代中,当前的 ∇ x ∇_x ∇xJ( x t ∗ x^∗_t xt∗, y y y)被自身的 L 1 L_1 L1距离(任何距离度量都是可行的)归一化,因为我们注意到在不同迭代中的梯度的尺度在大小上是变化的。

3.2.、Attacking ensemble of models

在本节中,我们将研究如何有效地攻击模型集合。为了提高系统的性能和鲁棒性,集成方法在研究和竞赛中得到了广泛的应用[6,8,2]。集成的思想也可以应用于对抗攻击,因为如果一个样本对多个模型仍然是对抗性的,它可能捕捉到一个总是愚弄这些模型的内在方向,并且更可能同时转移到其他模型[12],从而实现强大的黑盒攻击。

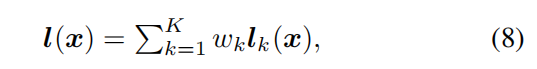

我们建议攻击多个logit活动融合在一起的模型,我们称这种方法为logits集成。由于logits捕捉概率预测之间的对数关系,因此由logits融合的模型集合汇集了所有模型的精细细节输出,其脆弱性很容易被发现。具体来说,为了攻击K模型的集合,我们将logits作为

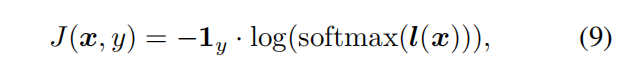

其中 l k ( x ) l_k(x) lk(x)是第 k k k个模型的对数, w k w_k wk为 w k ≥ 0 w_k≥0 wk≥0且 ∑ k = 1 K \sum^K_{k=1} ∑k=1K = 1的集合权值。损失函数 J ( x , y ) J(x, y) J(x,y)定义为给正确打标记标签 y y y和logit l ( x ) l(x) l(x)的softmax交叉熵损失。

其中,

1

y

1_y

1y是

y

y

y的一个独热编码。我们总结了MI-FGSM算法用于攻击算法2中对数取平均值的多个模型。

为了比较,我们还引入了两种替代的集成方案,其中一种方案已经在[12]中进行了研究。具体来说,K个模型在[12]的预测中可以平均为 p ( x ) = ∑ k = 1 K w k p k ( x ) p(x)=\sum^K_{k=1}w_kp_k(x) p(x)=∑k=1Kwkpk(x),式中, p k ( x ) p_k(x) pk(x)是给定输入 x x x的第 k k k个模型的预测概率。K个模型也可以在损失中平均为 J ( x , y ) = ∑ k = 1 K w k J k ( x , y ) J(x,y)=\sum^K_{k=1}w_kJ_k(x,y) J(x,y)=∑k=1KwkJk(x,y)。在这三种方法中,唯一的区别是在何处组合多个模型的输出,但它们会导致不同的攻击能力。我们经验地发现,在集合中的各种攻击方法和各种模型中,logits中的集合在预测和损失方面都优于集合,这将在第二节4.3.1.中演示。

3.3. Extensions

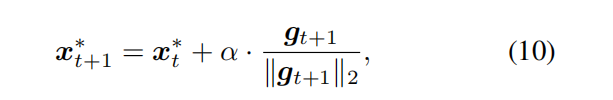

动量迭代法可以很容易地推广到其他攻击环境。通过用前面所有步骤的累积梯度代替当前梯度,任何迭代方法都可以扩展到其动量变量。本文从 L 2 L_2 L2范数界攻击和目标攻击两个方面介绍了生成对抗样本的方法。

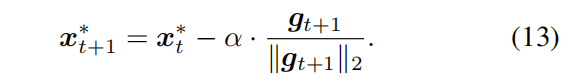

为了在 L 2 L_2 L2距离为 ∥ x ∗ − x ∥ 2 \lVert x^* - x\rVert_2 ∥x∗−x∥2 ≤ \leq ≤ ϵ \epsilon ϵ的真实样本的 ϵ \epsilon ϵ附近找到一个对抗样本,迭代快速梯度法(MI - FGM)的动量变量可以写成

式中,式(6)中定义了 g t + 1 g_{t+1} gt+1,并且α = ϵ \epsilon ϵ/T且T表示总的迭代次数。

对于目标攻击,查找误分类为目标类 y ∗ y^* y∗的对抗样本的目标是最小化损失函数 J ( x ∗ , y ∗ ) J(x^∗, y^∗) J(x∗,y∗). 累积梯度的计算公式如下:

研究了具有 L ∞ L_∞ L∞范数界的目标MI-FGSM

具有 L 2 L_2 L2范数界的目标MI-FGM是

因此,我们介绍了一类广泛的动量迭代方法来解决各种情况下的攻击,其有效性在Sec.4中得到了证明。

4、Experiments

在本节中,我们在ImageNet数据集[19]上进行了大量的实验,以验证所提方法的有效性。我们首先在第4.1节中指定实验设置。然后,我们在第4.2节报告攻击单个模型的结果,在第4.3节报告攻击多个模型的结果。我们的方法赢得了NIPS 2017年无目标和有目标的对抗性攻击比赛,在第4.4节介绍的配置。

4.1.、Setup

我们研究了7个模型,其中4个模型是正常训练的Inception v3 (Inc-v3) [22], Inception v4 (Inc-v4), Inception Resnet v2 (IncRes-v2) [21], Resnet v2-152 (Res-152)[7],另外3个模型是通过综合对抗训练—Inc-v3ens3, Inc-v3ens4, IncRes-v2ens[24]训练的。我们将简单地称后三个模型为“对抗性训练模型”,没有歧义。

如果模型不能正确地对原始图像进行分类,那么研究攻击的成功率就没有什么意义。因此,我们从ILSVRC 2012验证集中随机选择了1000张属于1000个类别的图像,它们都被正确分类。

在我们的实验中,我们比较了我们的方法与一步梯度法和迭代法。由于基于优化的方法不能明确控制对抗样本和相应的真实样本之间的距离,因此它们不能直接与我们的方法进行比较,但它们与第2.1节中讨论的迭代方法具有相似的性质。为了清晰起见,我们只报告了非针对性攻击基于 L ∞ L_∞ L∞范数界的结果,并在补充材料中保留了基于 L 2 L_2 L2范数边界和针对性攻击的结果。本文中的发现在不同的攻击设置中是普遍的。

4.2、Attacking a single model

我们在表1中报告了攻击我们所考虑的模型的成功率。分别使用FGSM、迭代FGSM(I-FGSM)和MI-FGSM攻击方法分别生成Inc-v3、Inc-v4、InvRes-v2和Res-152的对抗样本。成功率是对应模型以对抗图像作为输入的误分类率。在所有实验中,最大扰动

ϵ

\epsilon

ϵ设为16,像素值为[0,255]。I-FGSM和MI-FGSM的迭代次数为10,衰减因子µ为1.0,我们将在第4.2.1节进行研究。

从表中我们可以看出,MI-FGSM仍然是像I-FGSM一样的强大的白盒对手,因为它可以以接近100%的成功率攻击白盒模型。另一方面,可以看出I-FGSM比一步FGSM降低了黑盒攻击的成功率。但是通过积分动量,我们的MI-FGSM在黑盒攻击中的性能明显优于FGSM和I-FGSM。在大多数黑盒攻击情况下,其成功率是I-FGSM的2倍以上,证明了该算法的有效性。我们在图1中展示了为Inc-v3生成的两个敌对图像。

需要注意的是,虽然我们的方法大大提高了黑盒攻击的成功率,但对于以黑盒方式攻击对手训练的模型(例如,IncRes-v2ens不到16%)仍然无效。稍后,我们将在第4.3节展示基于集成的方法极大地改善了结果。接下来,我们研究了MI-FGSM不同于普通迭代方法的几个方面,以进一步解释为什么它在实践中表现良好。

4.2.1 Decay factor µ

衰减因子µ对提高攻击成功率起着关键作用。如果µ= 0,基于动量的迭代方法就会变成普通的迭代方法。因此,我们研究了衰变因子的合适值。我们利用MI-FGSM攻击Inc-v3模型,其摄动为

ϵ

\epsilon

ϵ = 16,迭代次数为10,衰减因子为0.0 ~ 2.0,粒度为0.1。我们在图2中展示了生成对抗样本对Inc-v3、Inc-v4、IncRes-v2和Res-152的成功率。黑盒模型的成功率曲线是单峰的,其最大值在µ= 1.0左右。当µ= 1.0时,Eq.(6)中定义的

g

t

g_t

gt的另一种解释是,它简单地将所有以前的梯度相加,执行当前的更新。

4.2.2 The number of iterations

然后我们研究当使用I-FGSM和MI-FGSM时,迭代次数对成功率的影响。我们采用相同的hyper-parameters(例如,

ϵ

\epsilon

ϵ= 16,µ= 1.0)攻击Inc-v3模型的迭代的数量从1到10,然后评估对抗案例对Inc-v3、Inc-v4、IncRes-v2和Res-152模型的成功率,结果如图3所示。

可以观察到,随着迭代次数的增加,I-FGSM对黑盒模型的成功率逐渐降低,而MI-FGSM的成功率主要保持在一个较高的值。结果证明了我们的论点,即迭代方法产生的对抗样本容易过拟合白盒模型,不可能跨模型传递。但基于动量的迭代方法有助于缓解白盒攻击和可转移性之间的折衷,从而对白盒和黑盒模型同时显示出很强的攻击能力。

4.2.3 Update directions

为了解释为什么MI-FGSM具有更好的可移植性,我们进一步研究了IFGSM和MI-FGSM在迭代过程中给出的更新方向。我们计算了两个连续扰动的余弦相似性,并在攻击Inc-v3时显示了图4中的结果。由于余弦相似度较大,MI-FGSM的更新方向比I-FGSM更稳定。

回想一下,可移植性来自于这样一个事实:模型在一个数据点[12]周围学习类似的决策边界。虽然决策边界相似,但由于dnn的高度非线性结构,它们不太可能相同。因此,在一个模型的数据点周围可能存在一些异常的决策区域(如[12]中的图4&5所示的洞),这些区域很难转移到其他模型。这些区域在优化过程中对应着较差的局部极值,迭代方法容易陷入这些区域,导致可转移的对抗样本较少。另一方面,在图4中观察到的动量方法获得的稳定更新方向可以帮助逃离这些异常区域,从而使对抗性攻击具有更好的可转移性。另一种解释是稳定更新的方向使扰动的

L

2

L_2

L2范数变大,这可能有助于传递性。

4.2.4 The size of perturbation

最后,我们研究了对抗性扰动的大小对成功率的影响。我们用FGSM、I-FGSM和MI-FGSM攻击Inc-v3型号,

ϵ

\epsilon

ϵ范围为1 ~ 40,图像强度[0,255],并对白盒模型Inc-v3和黑盒模型Res-152的性能进行了评估。在我们的实验中,我们将I-FGSM和MI-FGSM的步长大小α设为1,因此迭代次数随扰动的大小

ϵ

\epsilon

ϵ呈线性增长。结果如图5所示。

对于白盒攻击,迭代方法很快就能达到100%的成功率,但单步FGSM的成功率在扰动较大时有所下降。这种现象在很大程度上归因于对扰动大[12]时决策边界线性化的不当假设。对于黑盒攻击,虽然这三种方法的成功率随扰动大小呈线性增长,但MI-FGSM的成功率增长较快。换句话说,为了以所需的成功率攻击黑盒模型,MI-FGSM可以使用一个更小的扰动,这对人类来说在视觉上更难以区分。

4.3. Attacking an ensemble of models

在这一节中,我们展示了攻击一个模型集合的实验结果。我们首先比较3.2节中介绍的三种集成方法,然后证明对抗性训练的模型容易受到我们的黑盒攻击。

4.3.1 Comparison of ensemble methods

在本节中,我们将比较攻击的集成方法。我们的研究包括四个模型,分别是Inc-v3、Inc-v4、IncRes-v2和Res-152。在我们的实验中,我们保留一个模型作为留出法黑盒模型,分别用FGSM、I-FGSM和MI-FGSM攻击其他三个模型的一个集成,充分比较logit集成、预测集成和损失集成三种集成方法的结果。我们将 ϵ \epsilon ϵ设为16,I-FGSM和MI-FGSM的迭代次数设为10,MI-FGSM的µ设为1.0,综集权重相等。结果如表2所示。

可以看出,在白盒和黑盒攻击下,logits中的集合在所有攻击方法和不同模型中的集合中都优于预测中的集合和损失中的集合。因此,logits方案中的集合更适合对抗攻击。

表2的另一个观察结果是,MI-FGSM以高速率传输产生的对抗样本,使强大的黑盒攻击成为可能。例如,通过攻击不包含Inc-v3的Inc-v4、IncRes-v2和Res-152融合在logits中的集合,生成的对抗样本可以以87.9%的成功率欺骗Inc-v3。通常经过训练的模型在面对这种攻击时表现出极大的脆弱性。

4.3.2 Attacking adversarially trained models

为了以黑盒方式攻击对手训练过的模型,我们包括了第4.1节中介绍的所有7个模型。同样地,我们保留一个对抗性训练的模型作为流出法目标模型,以黑盒子的方式评估性能,并攻击一个集合中的其余6个模型,其对数融合在一起,具有相等的集合权。扰动ǫ为16,衰减因子µ为1.0。我们比较了FGSM、I-FGSM和MI-FGSM 20次迭代的结果。结果如表3所示。

可以看出,经过对抗训练的模型也不能有效地防御我们的攻击,这可以愚弄Inc-v3ens4超过40%的对抗样本。

因此,通过集成对抗训练得到的模型是在ImageNet上训练得到的最健壮的模型,容易受到黑盒攻击,这给开发学习健壮深度学习模型的算法带来了新的安全问题。

4.4. Competitions

NIPS 2017全方位攻击与防御比赛分为非目标对抗攻击、目标对抗攻击和防御对抗三个亚项。组织人员提供5000张与ImageNet兼容的图片,用于评估攻击和防御提交的内容。对于每一次攻击,都会为每幅图像生成一个干扰大小为4到16(由组织者指定)的对抗性示例,所有对抗性示例都会贯穿所有防御提交,以获得最终得分。通过本文介绍的方法,我们在非目标攻击和目标攻击两个方面都获得了第一名。我们将在提交文件中指定配置。

对于非目标攻击2,我们实现了MI-FGSM来攻击Inc-v3、Inc-v4、IncRes-v2、rees -152、Inc-v3ens3、Inc-v3ens4、IncRes-v2ens和Inc-v3adv[10]的集合。我们采用logit格式的集合。前七个型号的集成权重设置为1/7.25,Inc-v3adv的权重设置为0.25/7.25。迭代次数为10次,衰减因子µ为1.0。

对于目标攻击3,我们建立了两个攻击图。当扰动大小小于8时,攻击Inc-v3,增加集合权为1/3和2/3;否则,我们攻击集合权值为4/ 11,1 / 11,1 / 11,4 /11和1/11的Inc-v3, Inc-v3ens3, Inc-v3ens4, IncRes-v2ens和Inc-v3adv的集合。迭代次数分别为40次和20次,衰减系数µ也为1.0。

5、Discussion

从另一个角度来看,我们认为寻找对抗例子就是模拟训练模型,而对抗例子的可移动性也是模拟模型的可概括性。通过采用元视图,我们实际上“训练”一个对抗的例子给定一组模型作为训练数据。这样一来,动量法和集合法得到的改进的可移动性是合理的,因为模型的可泛化性通常是通过动量优化器或对更多数据进行训练来提高的。我们认为增强模型的概括性的其他技巧(例如SGD)也可以被纳入对抗性攻击中,以获得更好的可转移性。

6、Conclusion

在本文中,我们提出了一类广义的基于动量的迭代方法来增强对敌攻击,它可以有效地愚弄白盒模型和黑盒模型。在黑盒方法中,我们的方法始终优于一步基于梯度的方法和香草迭代方法。我们进行了大量的实验来验证所提出的方法的有效性,并解释了为什么它们在实践中有效。为了进一步提高生成的对抗性例子的可转移性,我们提议攻击其对数融合在一起的模型集合。我们表明,通过集合对抗训练获得的模型在我们的黑盒攻击下是脆弱的,这为开发更鲁棒的深度学习模型提出了新的安全问题。

623

623

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?