来源:AAAI 2021

Learning from History: Modeling Temporal Knowledge Graphs with Sequential Copy-Generation Networks

摘要

许多事实往往沿着时间轴呈现重复的模式,这表明,一个模型可能会从历史上出现的已知事实中学到很多东西。本文提出一种新的基于时间感知复制生成机制的时态知识图表示学习模型(CyGNet)。CyGNet不仅能从整个实体词汇表中预测未来的事实,而且能够通过重复识别事务,参考已知事实,预测未来事实。从5个数据集上表明了其先进性。

介绍

代表性的TKGs包括全球事件,语言和音调数据库(GDELT)和综合危机预警系统(ICEWS)。

许多事实在历史上反复发生,大多数现有的方法在建模TKG时并没有考虑到这种演化模式。

提出了CyGNet不仅能从整个实体词汇表中预测未来的事实,而且能够识别具有递归性的事实,并根据仅出现在过去的实体的历史词汇表相应地选择这些事实。

CyGNet包括两种推理模式,即Copy模式和Generation模式。

在这张图中,我们预测了2018年的NBA冠军是哪支球队。CyGNet首先获取每个实体的嵌入矢量(如颜色条所示)。然后,它利用这两种推理模式从历史或整个实体词汇表中推断实体概率(显示为绿色条,高度与概率值成正比)。”结合复制模式和生成模式的概率,金州勇士队被预测为2018年NBA总冠军。

相关工作

讨论了三个相关的研究方向

静态知识图谱嵌入

- 平移模型,将两个实体向量之间的关系建模为一个平移向量;

- 语义匹配模型,使用三角范数来衡量事实的可信性;

- 其他一些模型基于深度神经网络方法,在嵌入的基础上使用前向或卷积层。

时序知识图谱嵌入

尝试对时序知识图谱中的事实进行建模,提出了许多新的方法,例如TTransE,HyTE,TransH,Know-Evolve,DE-SimplE ,基于Tucker分解,ConT。但这些方法不能捕获长期依赖关系。

又设计出了一些其他方法,可以捕获图中事实的长期依赖关系,TA-DistMult,GCRN,DyREP,RE-NET ,RGCN-based。

复制机制

- 指针机制,可以直接从输入序列中选择输出序列,但不能使用输入序列之外的词汇进行预测;

- COPYNET通过将指针网络与生成机制结合,生成机制生成的词汇不会出现在输入中,解决了指针机制的弊端;

- SeqCopyNet改进复制机制,不仅可以复制单个词汇,还可以从输入文本中复制子序列。

方法

模型结合了两种推理模式,即复制模式(Copy mode)和生成模式(Generation mode),前者试图从一个特定的历史词汇表中选择实体,而后者则从整个实体词汇表中预测实体。前者试图从一个特定的历史词汇表中选择实体,而后者则从整个实体词汇表中预测实体。

H是主体实体和谓词在时间t上的组合。训练过程是从历史词汇中扩展出来的,如下所示。

复制模式

复制模式的目的是识别具有递归性的事实,并根据已知的历史事实进行复制,从而预测未来的事实。

对于特定的历史词汇表(s, p, ?, tk),CyGNet将增加在历史词汇表中选择的对象实体的估计概率。

具体来说,Copy模式首先通过一个MLP生成一个索引向量Vq:

W和b是可训练参数,tu为时间的单位阶跃,t1=tu,索引向量vq为N维向量,其中N为整个实体词汇表的基数。

对于复制模式中不感兴趣的实体,将指示符向量Htk指标值变为一个很小的负数,CyGNet通过索引向量Vq和指示符向量Htk来划分候选空间,是不感兴趣实体出现概率最小化,然后使用softmax函数估计历史词汇表中对象实体出现的概率:

Cq中不感兴趣的实体对应的值赋值接近于零。P(c)是一个向量,其大小等于整个实体词汇表的大小,表示历史词汇表的预测概率。

复制模式的优点是能从非常限定的候选空间学习预测。

Generation Mode

与Copy模式类似,Generation模式也会生成一个索引向量gq,其大小等于候选空间E的大小,并使用softmax函数进行归一化来进行预测:

学习目标

学习目标是在训练过程中存在的TKG快照的所有事实上最小化以下交叉熵损失L:

Oit为快照Gt中第i个对象实体,P为当第i个对象实体为Oit时,快照Gt中第k个对象实体的组合概率值。

为了保障实体集中所有实体的概率之和等于1,引入一个系数α来调整复制模式和生成模式之间的权重。CyGNet结合了从复制模式和生成模式的概率预测,通过添加由这两种模式给出的每个实体的概率。最终的预测ot将是组合概率最高的实体,定义如下:

p是包含所有实体概率的整个实体词汇表大小向量。

实验

实验设置

数据集

使用了五个数据集ICEWS18(2018.1.1-2018.10.31,ICEWS用时间戳记录政治事件。)、ICEWS14(2014.1-2014.12.31)、GDELT(从新闻媒体中提取的人类社会尺度行为和信念的目录)、WIKI(维基百科历史的子集)和YAGO(YAGO3的子集)。

基准方法

静态方法:TransE,DistMult,ComplEX,RGCN,ConvE,RotatE。

时序方法:TTransE,HyTE,TA-DistMult,Know-Evolve+MLP ,DyRep+MLP,R-GCRN+MLP,RE-NET。

结果

CyGNet在有些数据集上并不是表现最好的,进一步分析,将预测主体实体的结果与预测对象实体的结果分开。可以看到CyGNet在预测对象实体方面表现好,这是由于用于测试的数据集中主体和对象比例不平衡造成的,对象实体的复发率可达62%,主体实体只有23%,阻碍了CyGNet两个组件的联合学习,导致预测性能恶化。如何利用一个更健壮的元学习框架来解决CyGNet的这一缺点是一个有意义的研究方向。

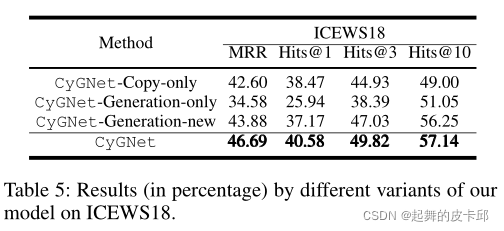

消融实验

Copy模式和Generation模式都很重要。(CyGNet-Generation-new与完整的CyGNet的区别在于前者利用Generation模式,以历史词汇为模数,预测整个实体词汇中的新事实。CyGNet的性能明显优于CyGNet- generation -new。我们相信这是因为在CyGNet中原始的Generation模式也可以在一个未来的事实被重复的情况下加强预测。然而,在修改后的CyGNet-Generation-new的生成模式中,这个优点被丢弃了。)

结论

提出的CyGNet不仅能够预测整个开放世界的事实,而且还能够识别具有递归性的事实,并根据过去出现的已知事实相应地选择未来的事实。提出的结果证明了CyGNet在预测TKGs的未来事实方面的良好性能。在未来的工作中,我们计划通过识别tkg中的全球显著实体和事件来改进顺序复制机制。将带有日期的文档与已获得的嵌入表示形式联系起来也是一个有意义的方向。此外,我们有兴趣利用所提出的技术来帮助理解自然语言文本中的动态事件过程。

论文提出CyGNet,一种结合复制和生成模式的模型,能从历史中学习时间依赖的模式,有效预测时态知识图谱中的未来事实。实验结果表明在对象实体预测上表现出色,但主体实体预测受限于不平衡数据。研究方向包括元学习和增强顺序复制机制。

论文提出CyGNet,一种结合复制和生成模式的模型,能从历史中学习时间依赖的模式,有效预测时态知识图谱中的未来事实。实验结果表明在对象实体预测上表现出色,但主体实体预测受限于不平衡数据。研究方向包括元学习和增强顺序复制机制。

1345

1345

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?