系列文章目录

TSLANet:重新思考时间序列表示学习的 Transforme ICML2024

摘要

时间序列数据以其内在的长期和短期依赖性为特征,对分析应用程序提出了独特的挑战。 虽然基于 Transformer 的模型擅长捕获远程依赖性,但它们在噪声敏感性、计算效率以及较小数据集的过度拟合方面面临限制。 为此,我们引入了一种新颖的时间序列轻量级自适应网络(TSLANet),作为各种时间序列任务的通用卷积模型。 具体来说,我们提出了一个自适应谱块,利用傅里叶分析来增强特征表示并捕获长期和短期交互,同时通过自适应阈值减轻噪声。 此外,我们引入了交互式卷积块,并利用自监督学习来改进 TSLANet 解码复杂时间模式的能力,并提高其在不同数据集上的鲁棒性。 我们的综合实验表明,TSLANet 在分类、预测和异常检测等各种任务中均优于最先进的模型,展示了其在各种噪声水平和数据大小范围内的弹性和适应性。 代码可在 https://github.com/emaldeen24/TSLANet 获取。

一、引言

时间序列数据以其顺序性和时间依赖性而闻名,在金融、医疗保健和环境监测等众多领域中无处不在。 最近,最初因其在自然语言处理方面的突破而闻名的 Transformer 模型(Vaswani 等人,2017)已被改编为分析时间序列数据的有力工具。 这是因为它能够捕获时间序列数据中的远程依赖关系和交互,显示出对预测任务的熟练程度(Wu et al., 2021b; Zhou et al., 2022; Liu et al., 2024)。 尽管 Transformer 在时间序列预测方面取得了初步成功,但在跨不同时间序列任务(尤其是数据集较小的任务)部署时遇到了障碍。 这可以归因于其参数尺寸过大,可能导致过度拟合和计算效率低下的问题(Wen et al., 2023)。 此外,他们的注意力机制经常与时间序列数据中固有的噪声和冗余作斗争(Li et al., 2022)。 此外,正如(Zeng et al., 2023; Li et al., 2023)所强调的那样,最近的工作对它们的适应性提出了质疑。 他们观察到 Transformer 中的自注意力本质上是排列不变的,这会损害时间信息的保存。 他们的实验表明,在时间序列预测方面,单个线性层的性能出人意料地优于复杂的 Transformer 架构。 然而,虽然此类线性模型对于小型、干净的数据可以表现良好,但它们可能无法处理复杂、嘈杂的时间序列。

图 1:用于分类和预测任务的 CNN 和基于 Transformer 的架构之间的比较。 分类结果是 10 个 UEA 数据集的平均值(Wu et al., 2023),而预测结果是长度 {96, 192, 336, 720} 上的平均 MSE 结果。

在这项工作中,我们从对多层感知器 (MLP) 和 Transformer 的普遍关注转向解决卷积运算在时间序列分析中的潜力。 传统上,卷积神经网络 (CNN) 因其局部感受野而在捕获时间序列中的短期模式方面表现出色,而局部感受野是分类任务的优势。 事实上,如图 1 所示,与最先进的基于 Transformer 的架构相比,简单的 3 层 CNN 网络在分类方面表现出了卓越的性能。 然而,我们的实验表明,CNN 的预测效果随数据频率的变化而变化。 例如,CNN 在天气数据集上显示出与这些基于 Transformer 的模型具有竞争力的性能,该数据集具有较短的 10 分钟频率,但在较长的每小时 ETTh1 数据集上表现不佳,这表明在不太频繁的时间变化方面存在困难。 这种差异凸显了一个关键问题:我们如何增强 CNN,以在更广泛的时间序列任务中扩展其稳健的性能? 很明显,可以通过学习时间序列数据中的短期和长期依赖性来扩展 CNN 的功能。

为此,我们引入了时间序列轻量级自适应网络(TSLANet),这是一种适用于各种时间序列任务的通用架构。 TSLANet 继承了 Transformer 的多块设计以实现可扩展性。 然而,我们用具有两个关键目标的轻量级自适应谱块(ASB)取代了计算成本高昂的自注意力。 首先,ASB 的目标是涵盖整个频谱,从而熟练地捕获数据中的长期和短期交互。 这是通过全局和局部滤波器的基于傅立叶的乘法来实现的,类似于循环卷积。 其次,ASB 通过自适应阈值方法选择性地衰减高频,该策略旨在最大限度地减少噪声并增强信号的清晰度。 此外,我们通过用交互式卷积块替换标准前馈网络来进一步改进我们的模型,其中具有不同内核大小的 CNN 相互控制,以丰富模型捕获和解释复杂时间模式的能力。 最后,我们采用每个数据集的自监督预训练来增强模型能力,特别是在大型数据集上。

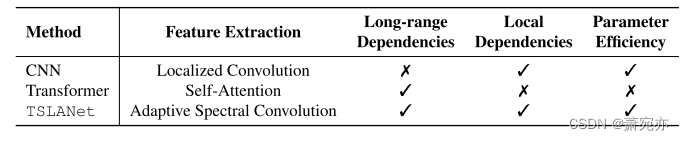

所提出的模型是轻量级的,并且具有 O(N logN) 的快速傅立叶变换 (FFT) 运算复杂度,与 self-attention 相比,展示了卓越的效率和速度(参见第 5.4 节)。 表 1 还提供了基于 CNN 和基于 Transformer 的模型的总结比较。本文的贡献可总结如下:

• 我们提出了一个通用的轻量级模型(TSLANet),旨在无缝适应无数的时间序列任务。 通过计算高效的卷积运算,TSLANet 可以学习数据中的长期和短期关系。

• 我们提出了一种自适应频谱块,它利用傅里叶变换以及全局和局部滤波器的强大功能来覆盖整个频谱,同时自适应地消除容易引入噪声的高频。 此外,我们提出了一个交互式卷积块来学习数据中复杂的空间和时间特征。

• TSLANet 在各种时间序列任务中展示了相对于不同最先进方法的卓越性能。

表 1:不同方法的比较。 “局部依赖性”是指捕获局部特征的效率。

二、 Related Works

基于变压器的网络。 自从 Transformer(Vaswani 等人,2017)在自然语言处理领域的进步以来,许多作品都采用它来进行时间序列分析。 例如,(Wu et al., 2021b;Zhou et al., 2022;Li et al., 2021;Kitaev et al., 2020;Zhang & Yan, 2023)展示了 Transformer 在时间序列数据中建模交互的能力, 将其用于预测任务。 此外,经过特殊设计的 Transformer 在异常检测任务中表现出了良好的性能(Xu et al., 2022)。

然而,变形金刚对于时间序列的功效一直存在争议。 例如,曾等人。 (2023) 认为 Transformers 中的排列不变性可能会导致时间序列中时间信息的丢失。 随后,其他基于 MLP 的架构在时间序列预测任务中表现出了有效性(Li et al., 2023;Ekambaram et al., 2023)。 此外,Transformer 通常需要大量的计算资源,并且在较小的数据集上进行训练时很容易过度拟合(Wen 等人,2023)。

基于卷积的网络。 CNN 展示了其在时间序列分析中的功效,尤其是由于其善于学习局部模式而在分类任务中表现出色(Dempster 等人,2020)。 CNN 还充当多种时间序列表示学习方法的骨干,包括 TS-TCC(Eldele 等人,2021)、TS2VEC(Yue 等人,2022)和 MHCCL(Meng 等人,2023)。

尽管有这样的承诺,CNN 在预测和异常检测方面经常面临挑战,这主要是由于它们捕获远程依赖关系的能力有限。 因此,最近的工作尝试以不同的方式增强 CNN 的能力。 例如,T-WaveNet (LIU et al., 2022) 利用频谱能量分析进行有效的信号分解,SCINet (Liu et al., 2022) 采用递归下采样-卷积-交互策略来建模复杂的时间动态,而 WFTNet (Liu 等人,2023)采用傅里叶变换和小波变换的组合来进行彻底的时频分析。 此外,TCE(Zhang 等人,2023)的目标是通过解决干扰卷积以获得更好的低频分量焦点来改进 1DCNN,而 BTSF(Yang 和 Hong,2022)则引入了用于无监督学习的双线性时谱融合技术, 强调维护时间序列数据的全球背景的重要性。

图 2:我们提出的 TSLANet 的结构。 输入时间序列被分割成补丁,并添加位置嵌入。 接下来,输出嵌入通过 TSLANet 层,其中每层由两个主要组件组成。 第一个是自适应频谱块,它利用频域表示进行稳健的特征提取,并采用自适应阈值来减轻噪声。 第二个是交互式卷积块,它通过卷积运算捕获复杂的时间模式。

利用 CNN 执行多个时间序列任务的一个值得注意的尝试是 TimesNet 模型(Wu et al., 2023),它利用多周期性来合并 2D 空间内的周期内和周期间变化,从而增强时间模式的表示。 然而,TimesNet 可能无法完全解决缺乏明确周期性的非平稳数据集带来的挑战。 最近的一些工作探索了将 CNN 与 Transformer 结合起来,以利用它们的优势(Li et al., 2022; Wu et al., 2021a; D’Ascoli et al., 2021),尽管与时间序列分析相比,这种混合方法仍未得到充分探索。 及其在计算机视觉中的应用。

我们的工作走了一条独特的道路,提出了一种通用的基于卷积的架构,擅长通过自适应光谱特征提取来处理各种时间序列任务。 这种方法不仅利用了 CNN 强大的局部特征学习能力,而且还可以有效捕获全局时间模式,为时间序列数据中的局部和远程依赖性提供平衡的解决方案。

三、 Method

3.1. Preliminaries: Discrete Fourier Transform

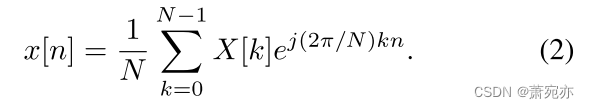

我们首先探索离散傅立叶变换(DFT),因为它是我们框架的基石。 考虑一系列 N 复数 x[n],其中 0 ≤ n ≤ N − 1。一维 DFT 将该系列转换为频域表示:

其中 j 表示虚数单位,

W

N

=

e

−

j

(

2

π

/

N

)

W_{N}=e^{-j(2\pi/N)}

WN=e−j(2π/N)。 该公式是通过在时域和频域上进行离散化而从连续傅立叶变换导出的。 序列 x[n] 在频率 ωk = 2πk/N 处的频谱用 X[k] 表示,它是周期性的,间隔长度为 N,因此只考虑前 N 个点。

由于 DFT 的双射性质,原始序列 x[n] 可以通过逆 DFT (IDFT) 检索:

对于实值 x[n],DFT 表现出共轭对称性,即 X[N − k] = X*[k]。 这种对称性至关重要,因为对共轭对称 X[k] 执行 IDFT 会产生真实的离散信号。 DFT 频谱的一半,特别是 X[k] : 0 ≤ k ≤ ⌈N/2⌉,充分描述了 x[n] 的频率特性。

TSLANet 中选择 DFT 的动机有两个:它的离散性质与数字处理和高效计算方法的存在非常契合。 快速傅立叶变换 (FFT) 利用 W N k n W_{N}^{kn} WNkn的对称性和周期性,将 DFT 计算从 O(N2) 优化到 O(N logN)。 IDFT 与 DFT 的形式类似,同样受益于逆 FFT (IFFT)。

3.2. Overall Architecture

我们的模型集成了两个新颖的组件,即自适应谱块 (ASB) 和交互式卷积块 (ICB),如图 2 所示。这两个组件形成一个可以扩展到多个层的单层。 ASB 采用傅立叶分析将时间序列数据转换到频域,其中我们应用自适应阈值来衰减高频噪声并突出相关频谱特征。 处理后,IFFT 重建时域特征,现在噪声减少并增强了表示。 ICB 是一个简化的卷积块,它使用不同的内核大小交互地细化特征,从而提高对时间序列中时间动态的适应性。 这些组件共同形成一个内聚结构,平衡时间序列分析的局部和全局时间特征提取。

3.3. Embedding Layer

给定一个输入时间序列 S,每个信号 S ∈ R C × L S\in\mathbb{R}^{C\times L} S∈RC×L 具有 C 个通道和序列长度 L。首先,信号 S 被划分为一组 M 个补丁 { P 1 , P 2 , . . . , P M } \{P_{1},P_{2},...,P_{M}\} {P1,P2,...,PM},其中每个 patch P i P_i Pi 捕获 S 的一段。每个 patch 的维度由预定义的 patch 大小 p 确定,使得每个 patch P i ∈ R C × p P_i\in\mathbb{R}^{C\times p} Pi∈RC×p。

然后将每个补丁映射到另一个维度 p′,即 P i → P i ′ ∈ R C × p ′ P_{i}\to P_{i}^{\prime}\in\mathbb{R}^{C\times p^{\prime}} Pi→Pi′∈RC×p′。 接下来,将位置嵌入添加到每个补丁中,以保留分割过程中中断的时间顺序。 第 i 个补丁的位置嵌入表示为 E i E_i Ei,一个与补丁在维度上对齐的向量。 增强补丁是通过添加两个输入而产生的,即 S P E i = P i ′ + E i S_{PE_{i}}=P_{i}^{\prime}+E_{i} SPEi=Pi′+Ei和 S P E = { S P E 1 , S P E 2 , … S P E M } S_{PE}=\{S_{PE_{1}},S_{PE_{2}},\ldots S_{PE_{M}}\} SPE={SPE1,SPE2,…SPEM}。 值得注意的是,位置嵌入是可学习的参数,使模型能够有效地捕获时间序列数据中的时间关系。

3.4. Adaptive Spectral Block

受(Rao 等人,2021)的启发,我们提出了采用傅里叶域处理的自适应谱块(ASB)。 该模块旨在通过全局循环卷积运算来学习空间信息。 此外,它还提供自适应局部滤波器来隔离任何时间序列数据的噪声高频分量。

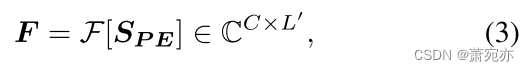

快速傅里叶变换。 给定一个离散时间序列 x[n],我们通过沿空间维度执行 FFT(如方程 1 所示)获得其频域表示 X[k]。类似地,给定

S

P

E

S_{PE}

SPE,其表示计算如下:

其中F[·]表示1D FFT运算,L’是频域中变换后的序列长度,根据FFT实现和时间序列数据的性质,它可能与L不同。 时间序列的每个通道都经过独立变换,产生一个综合的频域表示 F,它封装了所有通道上原始时间序列的频谱特征。

自适应去除高频噪声。 高频成分通常代表偏离潜在趋势或感兴趣信号的快速波动,使它们显得更加随机且难以解释(Rhif 等人,2019)。 因此,我们提出了一种自适应局部滤波器,允许模型根据数据集特征动态调整滤波级别,并去除这些高频噪声成分。 这在处理非平稳数据时至关重要,因为频谱可能随时间变化。 所提出的滤波器自适应地为每个特定时间序列数据设置适当的频率阈值。

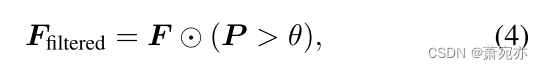

给定从 FFT 运算获得的频域表示 F,我们首先计算 F 的功率谱,这有助于识别主要频率分量。 功率谱 P 计算为频率分量幅度的平方: P = ∣ F ∣ 2 \boldsymbol{P}=|\boldsymbol{F}|^{2} P=∣F∣2,它为我们提供了时间序列数据中不同频率强度的度量。

有效降噪的关键在于自适应地滤除功率谱 P 中的高频分量。我们通过可训练的阈值 θ 来实现这一点,该阈值根据数据的频谱特性进行调整。 该阈值 θ 被设置为在训练期间通过反向传播优化的可学习参数,特别是

∂

L

∂

θ

\frac{\partial\mathcal{L}}{\partial\theta}

∂θ∂L ,使 θ 能够区分基本信号频率和噪声。 我们将这种自适应阈值制定如下:

其中 ⊙ 表示逐元素乘法,(P > θ) 是一个二元掩码,其中功率高于阈值 θ 的频率被保留,其他频率被滤除。

阈值θ的适应性确保ASB能够有效去除高频,同时保留关键信息。 通过自适应地选择频率阈值,ASB 可以针对每个特定的时间序列数据集定制其过滤过程,从而增强模型在处理各种数据场景时的整体有效性。

可学习的过滤器。 在对频域数据进行自适应滤波后,该模型采用了两组可学习滤波器; 全局滤波器从原始频域数据F学习,局部滤波器从自适应滤波数据

F

f

i

l

t

e

r

e

d

F_{filtered}

Ffiltered学习。 令

W

G

a

n

d

W

L

W_{\mathrm{G}}\mathrm{~and~}W_{\mathrm{L}}

WG and WL 分别为可学习的全局和局部滤波器。 这些过滤器的应用表示为:

接下来,我们整合这些过滤后的特征来捕获全面的光谱细节,即

F

i

n

t

e

g

r

a

t

e

d

=

F

G

+

F

L

.

\boldsymbol{F_\mathrm{integrated}}=\boldsymbol{F_\mathrm{G}}+\boldsymbol{F_\mathrm{L}}.

Fintegrated=FG+FL.。

值得注意的是,等式 5 和 6 中的乘法运算相当于循环卷积过程(参见附录 A)。 循环卷积在整个序列上具有较大的感受野,特别适合捕获时间序列数据中的周期性模式。

傅里叶逆变换。 为了将集成的频域数据转换回时域,我们应用快速傅里叶逆变换(IFFT)。 所得时域信号 S’ 由下式给出:

IFFT 确保增强的特征与输入时间序列的原始数据结构保持一致。 附录中的算法 1 描述了 ASB 的完整操作。

3.5. Interactive Convolution Block

在通过ASB增强特征表示后,我们提出了交互式卷积块(ICB),它利用双层卷积结构,如图2所示。ICB的设计包括具有不同内核大小的并行卷积来捕获局部特征和 更长范围的依赖关系。 具体来说,第一个卷积层旨在使用较小的内核捕获数据中的细粒度、局部模式。 相比之下,第二层旨在识别具有更大内核的更广泛、更长范围的依赖关系。 我们设计 ICB,使得每一层的输出调制另一层的特征提取。 按元素相乘鼓励以不同尺度提取的特征之间的交互,从而有可能更好地建模复杂关系。

给定 IFFT 运算 S’ 的输出,它用作 ICB 的输入。 ICB内部的流程如下:

其中 Conv1(·) 和 Conv2(·) 是两个一维卷积层, 是 GELU 激活函数.

然后添加激活的特征并通过最终的卷积层 Conv3(·):

输出 OICB 表示为网络中最后一层准备的增强功能,由根据任务的可定制线性层表示。

3.6. Self-Supervised Pretraining

为了扩展 TSLANet 的功能,我们纳入了一个自监督预训练阶段,该阶段因其从未标记数据中学习高级表示的功效而受到广泛关注(Nie 等人,2023)。 受到自然语言处理和计算机视觉应用方法的启发,我们采用了时间序列数据的屏蔽自动编码器范例(He et al., 2022)。

我们的实现涉及对输入序列补丁进行选择性屏蔽,然后训练 TSLANet 以准确地重建这些屏蔽片段。 然后,屏蔽数据作为训练输入,迫使模型学习并推断数据中的底层模式和依赖关系。 与在各个时间步骤应用掩蔽的方法不同,我们的方法侧重于较大的补丁。 这种设计选择避免了从相邻时间点进行简单插值,并鼓励模型深入理解整个序列。 这些补丁的重建是通过优化均方误差(MSE)损失函数来实现的。

四、 Experiments

在本节中,我们评估 TSLANet 在时间序列分类、预测和异常检测任务上的功效。 我们证明,我们的 TSLANet 可以作为基础模型,在这些任务上具有具有竞争力的性能。 详细的实验设置在 D 节中描述,而详细的实验结果在附录 F 节中介绍。

表2:不同数据集的分类结果。 结果对每个数据集子集进行平均。 结果以准确度表示(以%表示)。 蓝色:最好的结果,紫色:第二好的结果。 完整结果列于附录的表 10、11 和 12 中。

表 3:预测长度 ∈ {96, 192, 336, 720} 的多元预测结果。 结果是所有预测长度的平均值。 Avg 表示按子集进一步平均。 蓝色:最好的结果,紫色:第二好的结果。 完整结果列于附录表 13 中。

4.1. Classification

数据集。 我们在总共 116 个数据集上检查了 TSLANet 的分类能力,包括 85 个单变量 UCR 数据集(Dau et al., 2019)、26 个多变量 UEA 数据集(Bagnall et al., 2018)。 我们还包括另外 5 个数据集,即两个生物医学数据集,即基于 EEG 的睡眠阶段分类的 Sleep-EDF 数据集 (Goldberger et al., 2000) 和基于 ECG 的 MIT-BIH 数据集 (Moody & Mark, 2001) 心律失常分类和三个人类活动识别(HAR)数据集,即 UCIHAR(Anguita 等人,2013)、WISDM(Kwapisz 等人,2011)和 HHAR(Stisen 等人,2015)。 这些数据集具有不同的特征,并且涵盖了广泛的时间序列应用。 有关这些数据集的更多详细信息包含在附录 E.2 中。

基线和实验设置。 我们选择了八个最先进的基线,即 GPT4TS (Zhou et al., 2023)、TimesNet (Wu et al., 2023)、ROCKET (Dempster et al., 2020)、TS-TCC (Eldele et al., 2023)、TS-TCC (Eldele et al., 2023) al., 2021)、TS2Vec (Yue et al., 2022)、Crossformer (Zhang & Yan, 2023) 和 PatchTST (Nie et al., 2023),因为它们比其他基于 Transformer 的架构表现出了最佳的分类精度。 最后,我们用一个简单的单层 MLP 进行实验。

结果。 表 2 报告了分类结果,其中我们提出的 TSLANet 表现出了优于最先进基线的性能。 值得注意的是,基于卷积的方法,包括 ROCKET、TS-TCC 和我们的方法,优于基于 Transformer 的模型,凸显了它们在分类任务中的优越性。 例如,在 UCR 存储库中,TSLANet 达到了 83.18% 的令人印象深刻的准确率,优于包括 ROCKET 在内的其他模型,后者的得分为 81.42%。 UEA 存储库结果进一步增强了我们的功效,准确率达到 72.73%,而排名第二的模型 PatchTST 的准确率为 69.38%。 在生物医学信号和 HAR 等更专业的数据集中,我们的优势更加明显,分别实现了 90.24% 和 97.46% 的总体准确率。 这些结果凸显了 TSLANet 在不同时间序列背景下的稳健性和适应性。

在我们的比较分析中,Transformer 模型通常面临各种数据集的挑战,反映了处理时间序列数据的固有局限性。 MLP 模型在较简单的 UCR 数据集上表现良好,但在复杂、嘈杂的环境中表现不佳。 TimesNet 擅长处理频率信息丰富的数据集,但在处理较简单的数据集时表现不佳。 最后,由于 GPT 模型的高容量,GPT4TS 模型在较大的数据集中表现出了良好的前景,但由于可能过度拟合,因此在较小的数据集中表现不佳。

4.2. Forecasting

数据集。 为了评估 TSLANet 的预测效果,我们对八个基准数据集进行了综合评估。 即,电力(ECL),包含电力消耗数据,四个ETT数据集(ETTh1,ETTh2,ETTm1,ETTm2),涵盖能源传输技术的一系列场景,交换,包含波动的货币汇率,流量,包含交通流量信息,以及 天气可提供随时间变化的各种气象变量的见解。 我们在附录 E.3 中提供了有关其特性的更多详细信息。

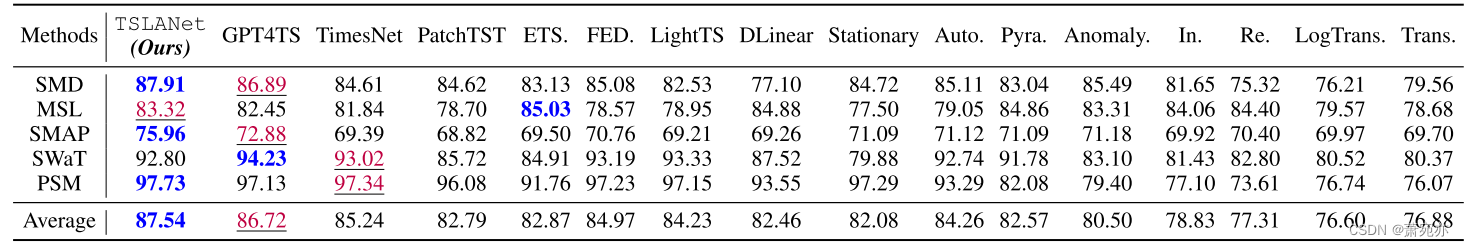

表 4:异常检测任务。 我们计算每个数据集的 F1 分数(以百分比表示)。 *。 变形金刚中表示*former的名字。 蓝色:最好,紫色:第二好。 附录中的表 14 显示了完整结果。

基线和实验设置。 我们将 TSLANet 与各种最先进的基线进行比较。 对于 Transformer 架构,我们与 iTransformer (Liu et al., 2024)、PatchTST、Crossformer、FEDformer (Zhou et al., 2022) 和 Autoformer (Wu et al., 2021b) 进行比较。 对于基于 MLP 的模型,我们与 RLinear (Li et al., 2023) 和 DLinear (Zeng et al., 2023) 模型进行比较。 对于通用时间序列模型,我们将我们的模型与 TimesNet 和 GPT4TS 进行比较。 对于基于卷积的预测模型,我们与 SCINet 进行比较(Liu et al., 2022)。 最后,我们包括基于大语言模型的 Time-LLM(Jin 等人,2024)。 与(Zhou et al., 2023)设置类似,我们将 ETT 数据集的回顾窗口设置为 336,将 Exchange 的回顾窗口设置为 96,将交通和天气数据集的回顾窗口设置为 512,将 ECL 数据集的回顾窗口设置为 96。 我们还在预测任务中纳入了数据标准化块和反向实例标准化(Kim 等人,2021)。 对于基线,如果与我们的设置一致,我们会报告他们原始作品中的最佳结果,否则,我们会再次重新运行他们的代码。

结果。 在表 3 所示的预测实验中,我们注意到 Time-LLM 的优越性,因为它依赖于大型 Llama-7B 模型(Touvron 等人,2023),这使其能够捕获数据中的复杂模式和依赖性。 除了 Time-LLM 之外,TSLANet 在各种数据集上的表现始终优于基线模型。 具体来说,它在八个数据集中的七个中实现了第二低的 MSE 和 MAE,在 ETT(avg) 和天气数据集中,MSE 分别比最先进的 PatchTST 提高了 3% 和 3.8%。 这表明我们的模型在处理具有不同特征和复杂性的数据集方面的有效性。 此外,它还显示了 ASB 模块的附加功能在学习远程依赖关系方面的效果。

结果还表明我们的模型优于专门的基于 Transformer 的架构和基于 MLP 的模型。 这些模型,例如 iTransformer 和 Dlinear,在某些数据集中表现出有竞争力的性能,但在其他数据集中却落后了。 此外,GPT4TS 通过在某些数据集中获得第二好的表现,展示了 GPT 模型在预测任务中的强大功能。

虽然 Time-LLM 提供了稍好的性能,但其计算成本明显高于 TSLANet。 为了说明这一点,TSLANet 在 ETTh1 数据集上展示了与 Time-LLM 几乎相同的性能,MSE 为 0.413,而 Time-LLM 为 0.408,但 TSLANet 的计算成本显着降低,为 6.9e+10 FLOPS,而对于 7.3e+12 时间-法学硕士。 这展示了我们的 TSLANet 中性能和计算效率之间的有效平衡。

4.3. Anomaly Detection

数据集。 在本研究中,我们专注于检测无监督时间序列数据中的异常。 我们使用五个基准数据集进行实验:用于服务器监控的 SMD (Su et al., 2019)、用于空间遥测的 MSL (Hundman et al., 2018)、用于地球观测的 SMAP (Hundman et al., 2018)、SWaT ( Mathur & Tippenhauer,2016)用于水处理安全,PSM(Abdulaal 等人,2021)用于工业泵传感器。 我们在附录 E.4 中讨论它们的详细信息。

基线和实验设置。 我们遵循相同的实验设置,并在 GPT4TS 中采用相同的基线(Zhou et al., 2023)。 这些是 GPT4TS、TimesNet、PatchTST、ETSformer(Woo 等人,2022)、FEDformer、LightTS(Zhang 等人,2022)、DLinear、Stationary(Liu 等人,2022)、Autoformer、Pyraformer(Liu 等人,2022)。 ,2021)、Anomalyformer(Xu 等人,2022)、Informer、Reformer、LogTransformer(Li 等人,2019)以及 vanilla Transformer。 为了准备数据,我们使用滑动窗口对每个数据集进行分段,如下(Xu 等人,2022)。 我们采用重建误差作为我们的评估指标,这在用于发现异常的无监督学习中很常见。

表 5:对每个成分的影响的消融研究。 ASB-L 是指 ASB 中的本地过滤器。 UWaveGL 是来自 UEA 存储库的 UWaveGestureLibrary 数据集。

结果。 表 4 显示了结果,其中 TSLANet 在大多数数据集中表现最好,总体 F1 得分为 87.54%。 它的性能优于 FEDformer 和 Autoformer 等高级模型,尤其是在 SMD 和 PSM 数据集中,F1 分数分别为 87.91% 和 97.73%。 GPT4TS模型紧随其后,以86.72%的总体平均分排名第二。 其高容量使其能够有效地检测异常,尽管它稍显落后。 值得注意的是,基于 Transformer 的模型通常在异常检测方面表现出较低的效率。 这可以被视为注意力机制专注于主导正常点,从而错过了罕见的异常。 考虑周期性的模型(例如 TimesNet 和 FEDformer)表现良好,这表明周期性分析在突出异常模式方面的价值。

5. Model Analysis

5.1. Ablation Study

在表 5 中,我们评估了模型中不同组件的贡献,其中报告了单独删除每个组件时模型的性能。 值得注意的是,删除自适应频谱块(即不带 ASB)会导致性能显着下降。 对于 FordA 和 UWaveGestureLibrary 数据集上的分类任务,准确率分别下降至 87.3% 和 77.5%。 同样,它的缺失会导致 ETTh1 和 Exchange 数据集的预测任务中的 MSE 值较高,分别为 0.421 和 0.380。 这强调了 ASB 在特征提取和降噪方面的关键作用。 同样,排除 ASB 的局部自适应部分(即,无 ASB-L)对噪声数据集的影响大于噪声较小的数据集,突出了局部组件在处理噪声方面的价值。

ICB 的效果小于 ASB,这两个任务的性能下降较少。 然而,它的删除表明分类精度降低,预测 MSE 增加,这表明了它的重要性。 预训练的作用也得到了类似的验证,因为预训练的缺失会略微降低模型在这两项任务中的性能。

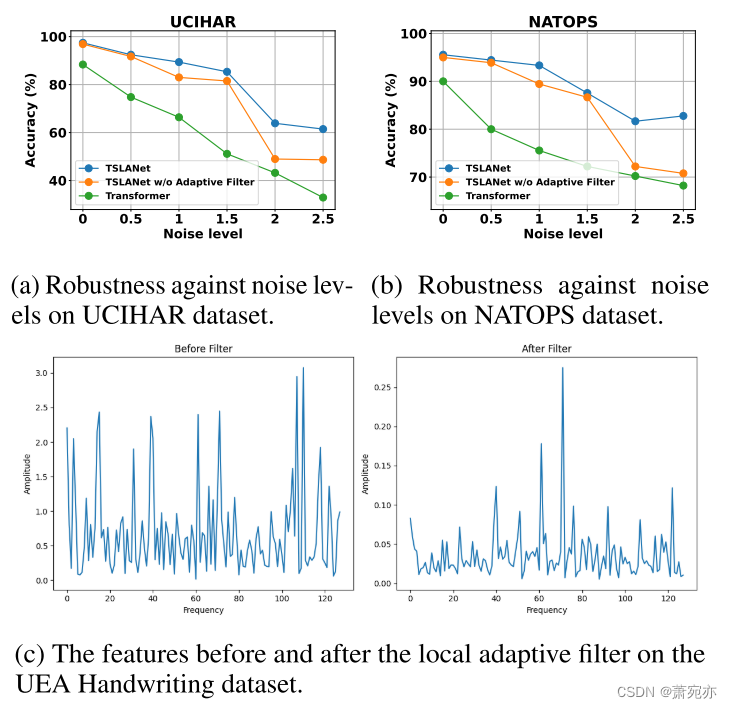

图 3:自适应滤波器在降噪方面的有效性。

5.2. Efficacy of Adaptive Filtering in Noise Reduction

我们通过检查图 3 来深入研究自适应滤波器在减轻噪声和增强模型鲁棒性方面的有效性。具体来说,图 3a 和图 3b 展示了 TSLANet(无论是否有自适应滤波器)通过添加不同高斯噪声与 Transformer 模型相比的性能 时间序列的水平。 随着噪声的增加,变压器的性能迅速恶化。 相比之下,TSLANet 保持了相对稳定的性能,使用自适应滤波器的变体表现出最强的抗噪声能力。 这在较高噪声水平下尤其值得注意,其中标准 Transformer 的精度急剧下降,而带有自适应滤波器的 TSLANet 的下降幅度则要小得多。

在图 3c 中,我们观察了应用自适应滤波器之前和之后的频谱。 左图显示了各种频率上具有高振幅尖峰的噪声频谱。 然而,应用自适应滤波器后,频谱明显更清晰,噪声尖峰的幅度显着降低,特别是在较高频率范围内。 这证明了滤波器能够衰减不需要的噪声,同时保留相关信号。

5.3. Scaling Efficiency

我们通过观察 TSLANet 在不同数据集大小和层数上的性能,将 TSLANet 的可扩展性与分类任务中性能最佳的 Transformer 模型之一(即 PatchTST(Nie 等人,2023))进行比较。 具体来说,我们使用 uWaveGestureLibraryAll 数据集中的可变数据大小进行实验,如图 4 所示。值得注意的是,在较小的数据大小中,TSLANet 表现出一致的准确度水平,随着层数的增加而略有下降。 相比之下,PatchTST 在增加层数后准确性显着下降,这表明存在潜在的过度拟合问题或在处理有限数据时效率低下以及模型复杂性增加。

图 4:对于 uWaveGestureLibraryAll 数据集中的不同数据百分比,TSLANet 与 PatchTST 在准确性方面的比较(不同层数)。

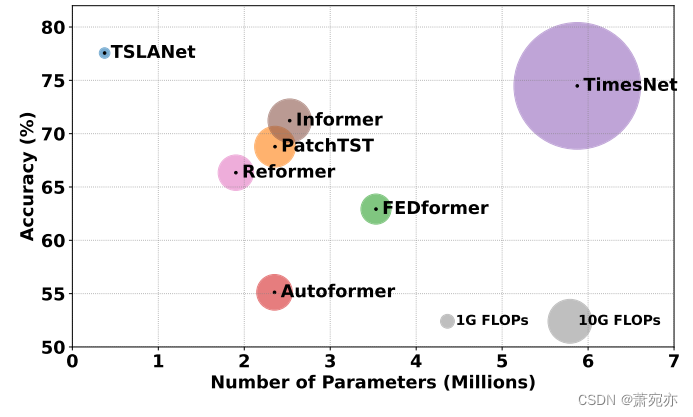

图 5:TSLANet 与基线在参数数量和 FLOPS 计数方面与 UEA Heartbeat 数据集的分类准确性的比较。

随着数据集大小的增长,TSLANet 的性能仍然保持强劲,随着层数的增加,准确性略有变化。 这种稳定性与 PatchTST 性能形成鲜明对比,后者在层数较高时往往会显着下降。 PatchTST 的这种趋势可能归因于其固有的设计,随着模型深度的增加,这可能会导致收益递减或优化挑战。 最后,我们注意到 TSLANet 有效地利用了更大的数据集样本,因为它的性能随着层数的增加而提高,突出了它利用更广泛的数据来提高准确性的能力。

5.4. Complexity Analysis

我们将 TSLANet 与基于 TimesNet 和 Transformer 的模型(例如 PatchTST、FEDFormer、AutoFormer、Informer 和 Reformer)的复杂性进行了比较,包括 UEA Heartbeat 数据集上的参数数量、FLOP 和准确性,如图 5 所示 TSLANet 在时间序列分析方面表现出卓越的效率和准确性,在比较模型中以最低的计算量和参数占用实现了最高的 77.56% 的准确率。 与 PatchTST 相比,它所需的 FLOP 次数减少了 93%,参数减少了 84%,但准确度却高出了 8% 以上。 与 TimesNet 相比,TSLANet 的运行次数和参数减少了 99% 以上,同时精度仍高出 3%。

计算需求的大幅减少证实了 TSLANet 与基于 Transformer 的替代方案相比的轻量级性质,强调了其使时间序列分析更加高效的能力。

六、 Conclusions

在本文中,我们介绍了 TSLANet,这是一种用于时间序列分析的新型轻量级模型,它重新审视了卷积方法,将其作为 Transformer 的有效替代品,并创新地将卷积运算与自适应谱分析相结合。 我们在分类、预测和异常检测方面对各种数据集进行的全面实验证明了其优于传统 Transformer 模型的性能,特别是在噪声条件下和不同数据大小下保持高精度水平的能力。 此外,我们深入的逐层性能分析表明,TSLANet 不仅在较小的数据集中优于 Transformer,而且随着层数的增加,尤其是在较大的数据集中,可扩展性也有所提高。 TSLANet 是迈向时间序列分析基础模型的一步。

3732

3732

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?