目录

💥1 概述

📚2 运行结果

🎉3 参考文献

👨💻4 Matlab代码

💥1 概述

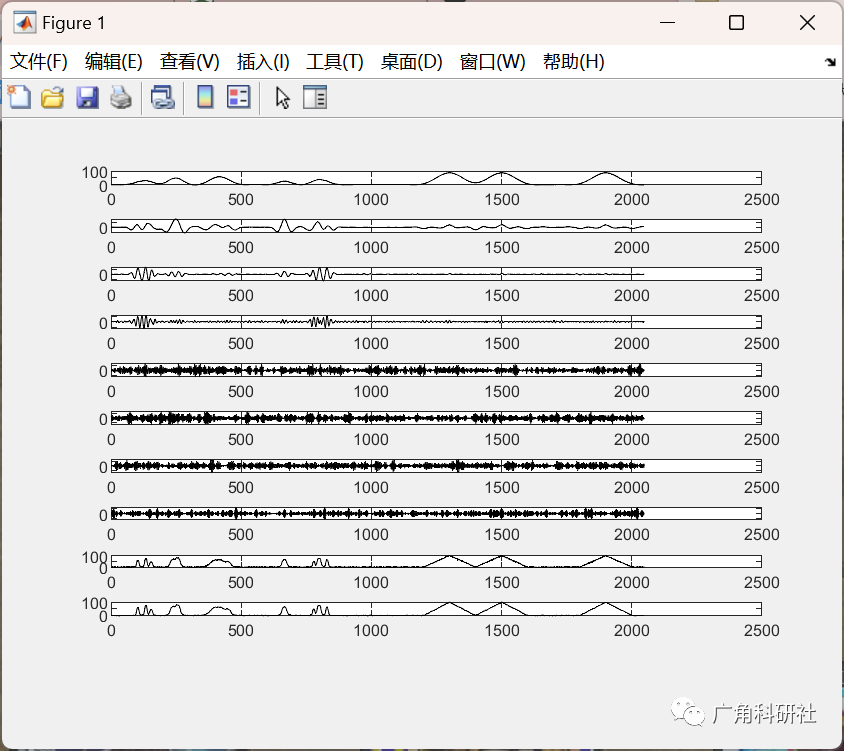

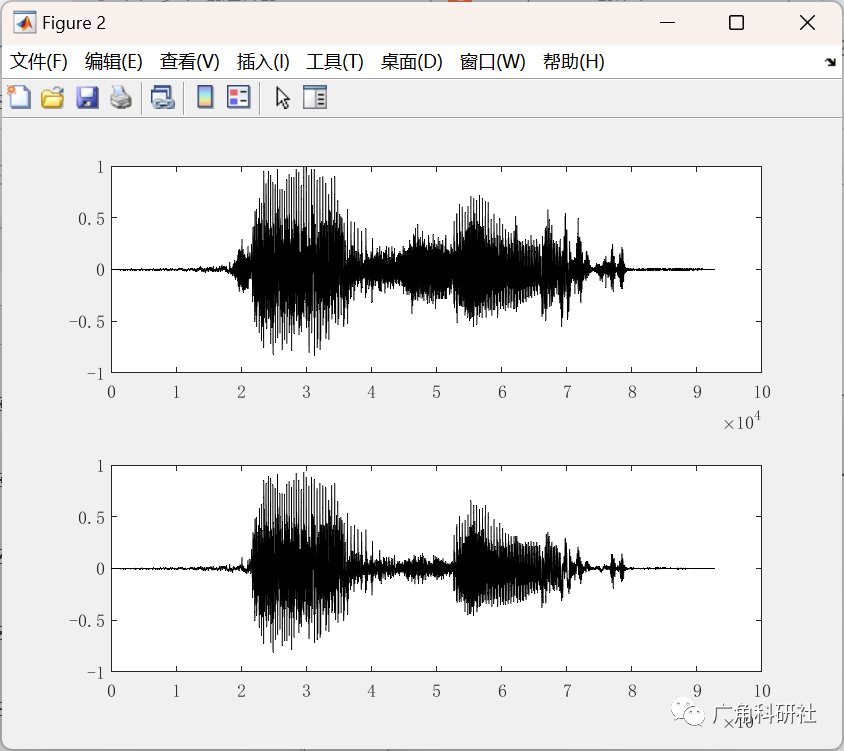

使用vmd算法对含有噪声的图像信号进行分解,去除掉噪声信号,将剩余信号合成,得到去噪声图像。分别使用alo、ao、ga、gwo、mpa、spo、woa算法对vmd算法中的参数进行优化,实现快速、准确的完成图像信号的分解。

本代码描述的是一个涉及图像信号处理和优化算法的复杂任务。VMD(Variational Mode Decomposition,变分模态分解)是一种信号分解方法,可以用于分解含有噪声的图像信号,并去除噪声以得到去噪声图像。而ALO(Ant Lion Optimizer)、AO(Artificial Bee Colony)、GA(Genetic Algorithm)、GWO(Grey Wolf Optimizer)、MPA(Moth-flame Optimization)、SPO(Sine Cosine Optimization)和WOA(Whale Optimization Algorithm)等是不同的优化算法,用于优化VMD算法中的参数以实现更快速和准确的分解结果。

在这样的任务中,通常需要进行以下步骤:

图像预处理:对含有噪声的图像进行预处理,可能包括去噪、平滑等操作,以便在VMD分解前减少干扰。

VMD分解:使用VMD算法对图像信号进行分解,得到一系列分量(模态)。其中某些分量可能包含噪声信号。

优化算法参数设置:选择您所感兴趣的优化算法(ALO、AO、GA、GWO、MPA、SPO、WOA等),并设置算法的参数,例如迭代次数、种群大小等。

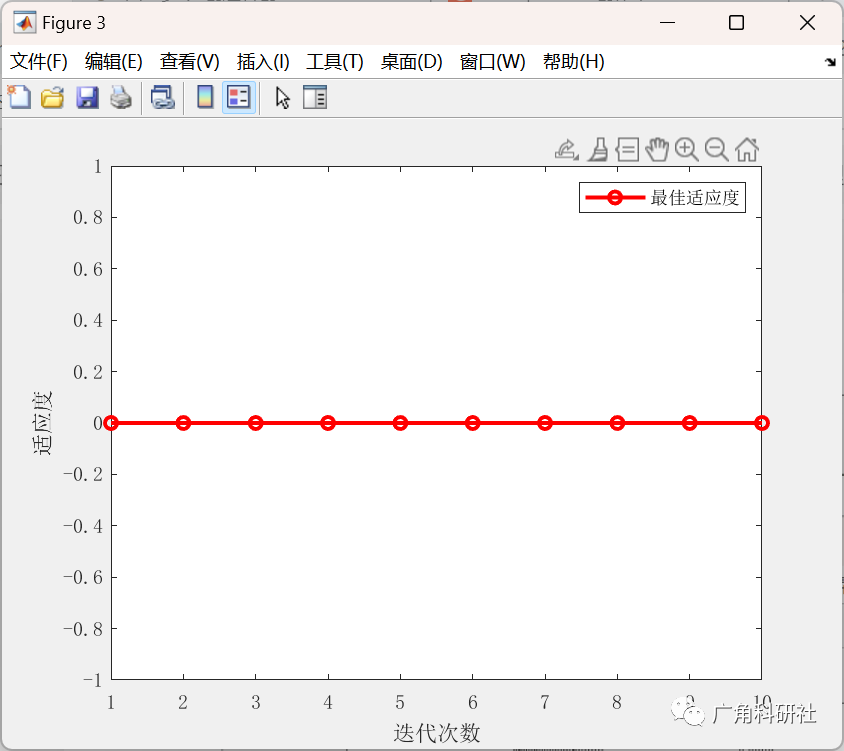

参数优化:使用所选的优化算法对VMD算法中的参数进行优化,以获得更准确的分解结果。

分量合成:将经过优化参数的VMD分解的各分量进行合成,得到去噪声图像。

评估和调优:对于不同的优化算法,您可能需要评估其性能,比较结果并进行调优,以找到最佳的组合。

结果分析:最后,对比不同算法的结果,分析其优缺点以及在特定情况下的适用性。

需要注意的是,每种优化算法都有其特点和适用范围,因此可能需要进行多次实验和调整以找到最适合您问题的方法。同时,实现这个任务可能需要涉及图像处理和编程技能,以及对每个优化算法的原理和应用有深入的理解。

如果您需要更详细的步骤、代码实现或特定的帮助,建议您在相关领域的论文、书籍或教程中查找更多信息,或者咨询专业的图像处理和优化算法领域的专家。

📚2 运行结果

主函数部分代码:

%通过WOA算法,找到最优解给VMD

clear all;

clc;

tic%启动秒表计时器

x=load('moni_noise.dat');%加载数据

%size(x)信号为1*2048

signal=x;%两处vmd函数用到此参数,此参数为一个信号,从表中读取的参数

tau=0;%两处vmd函数用到此参数

DC=0;%两处vmd函数用到此参数

init=1;%两处vmd函数用到此参数

tol=1e-5;%是1x10的-5次方,两处vmd函数用到此参数

SearchAgents_no=10; % 种群数量,Number of search agents

Max_iter=10; % 最大迭代次数,用于计算a,a2。用于zeros函数生成一个1*10的矩阵。Maximum numbef of iterations

dim=2; % 此例需要优化两个参数c和g位置向量,用于zeros函数生成一个1*2的矩阵。number of your variables

lb=[2,100]; % 参数取值下界,是一个向量,这个向量有2个元素

ub=[10,5000]; % 参数取值上界,是一个向量,这个向量有2个元素

% The Whale Optimization Algorithm

% function [Leader_score,Leader_pos,Convergence_curve]=WOA(SearchAgents_no,Max_iter,lb,ub,dim,fobj)

% 为leader初始化位置向量和得分,initialize position vector and score for the leader

Leader_pos=zeros(1,dim);%生成一个1*2的矩阵。

Leader_score=inf; %inf为无穷大量+∞,-inf为无穷小量-∞ change this to -inf for maximization problems

%初始化搜索代理的位置

Positions=initialization(SearchAgents_no,dim,ub,lb);%初始化函数,Positions为一个10*2的随机限制矩阵

%最后initialization函数返回的是Positions为一个10*2的随机限制矩阵

%Positions里面存放着10个限制的坐标信息

%收敛曲线

Convergence_curve=zeros(1,Max_iter);%生成一个1*10的0矩阵。

t=0;% 循环计数器Loop counter

% 主循环Main loop

while t<Max_iter%最大迭代次数为10

for i=1:size(Positions,1)%循环十次

% 返回超出搜索空间边界的搜索代理Return back the search agents that go beyond the boundaries of the search space

Flag4ub=Positions(i,:)>ub;%两个矩阵比较,是每一个对应位置的值比较

Flag4lb=Positions(i,:)<lb;

Positions(i,:)=(Positions(i,:).*(~(Flag4ub+Flag4lb)))+ub.*Flag4ub+lb.*Flag4lb;

%多出的代码

%计算每个搜索代理的目标函数 Calculate objective function for each search agent

%round(Positions(i,2))带宽限制,经验取值为抽样点长度1.5-2.0 倍

%round(Positions(i,1))需要恢复的模式个数,分解模态(IMF)个数

%不接收那两个参数了

[u, ~, ~] = VMD(signal, round(Positions(i,2)), tau, round(Positions(i,1)), DC, init, tol);

%计算每一个position的得分

for ii=1:Positions(i,1)%size(Positions,1)=10,每一个i时,循环Positions第一个参数的x次

bao=hilbert(u(ii,:));

bao=abs(bao);

p=bao./sum(bao);

e110(ii,:)=-sum(p.*log10(p));

end

fitness=min(e110);%计算每一个position的得分

% fitness=fobj(Positions(i,:));

% 更新领导者Update the leader

if fitness<Leader_score % Leader_score初始值为无穷大Change this to > for maximization problem

Leader_score=fitness; % Update alpha更新领导者的得分

Leader_pos=Positions(i,:);%10个位置.更新领导者的位置

end

end

% a decreases linearly fron 2 to 0 in Eq. (2.3)

a=2-t*((2)/Max_iter); %在公式(2.3)中,a从2到0线性下降。

% a2 linearly dicreases from -1 to -2 to calculate t in Eq. (3.12)

a2=-1+t*((-1)/Max_iter);%% a2从-1到-2线性递减来计算公式(3.12)中的t

%根据公式,更新搜索代理的位置 Update the Position of search agents

for i=1:size(Positions,1)%size(Positions,1)=10

r1=rand(); % r1 is a random number in [0,1]

r2=rand(); % r2 is a random number in [0,1]

A=2*a*r1-a; % Eq. (2.3) in the paper

C=2*r2; % Eq. (2.4) in the paper

b=1; % parameters in Eq. (2.5)

l=(a2-1)*rand+1; % parameters in Eq. (2.5)

p = rand(); % p in Eq. (2.6)

for j=1:size(Positions,2)%size(Positions,2)=2

if p<0.5

if abs(A)>=1

rand_leader_index = floor(SearchAgents_no*rand()+1);%floor函数将 X 的每个元素四舍五入到小于或等于该元素的最接近整数。

X_rand = Positions(rand_leader_index, :);

D_X_rand=abs(C*X_rand(j)-Positions(i,j)); % Eq. (2.7)

Positions(i,j)=X_rand(j)-A*D_X_rand; % Eq. (2.8)

elseif abs(A)<1

D_Leader=abs(C*Leader_pos(j)-Positions(i,j)); % Eq. (2.1)

Positions(i,j)=Leader_pos(j)-A*D_Leader; % Eq. (2.2)

end

🎉3 参考文献

[1]梁智,孙国强,李虎成等.基于VMD与PSO优化深度信念网络的短期负荷预测[J].电网技术,2018,42(02):598-606.

部分理论引用网络文献,若有侵权联系博主删除。

1225

1225

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?