标题:HR-Pro:通过分层可靠性传播实现点监督的时序动作定位

原文链接:https://ojs.aaai.org/index.php/AAAI/article/view/28539

源码链接:https://github.com/pipixin321/HR-Pro

发表:AAAI-2024

摘要

点监督时序动作定位(Point-supervised Temporal Action Localization, PSTAL)是一种新兴的高效标签学习研究方向。然而,现有方法主要集中于在片段级(snippet-level)或实例级(instance-level)优化网络,忽视了点注释在这两个层面固有的可靠性。在本文中,我们提出了一个分层可靠性传播(Hierarchical Reliability Propagation, HR-Pro)框架,该框架包含两个具有可靠性感知能力的阶段:片段级判别学习和实例级完整性学习,两个阶段均探索点注释中高置信线索的高效传播。

对于片段级学习,我们引入一个在线更新的记忆模块,用于为每个类别存储可靠的片段原型。我们随后引入一个可靠性感知注意力模块(Reliability-aware Attention Block)来捕捉片段的视频内和视频间依赖关系,从而得到更具判别性和鲁棒性的片段表示。

对于实例级学习,我们提出一种基于点的候选生成方法,用于连接片段和实例,从而生成高置信的候选用于进一步实例级优化。通过多层次的可靠性感知学习,我们能够获得更可靠的置信度得分和更准确的候选预测边界。

我们提出的 HR-Pro 在多个具有挑战性的基准测试上取得了当前最优的性能,包括在 THUMOS14 数据集上达到 60.3% 的平均 mAP。值得注意的是,我们的 HR-Pro 大幅超过了所有已有的点监督方法,甚至优于若干具有竞争力的全监督方法。

代码将公开于:https://github.com/pipixin321/HR-Pro

引言

时序动作定位是视频理解领域的一个基本任务,其目标是在未经裁剪的视频中对动作实例进行时间定位和分类,由于其在多个领域中的潜在应用,正受到越来越多的关注(Lee, Ghosh, and Grauman 2012; Vishwakarma and Agrawal 2013)。然而,传统的全监督方法(Lin et al. 2018, 2019; Xu et al. 2020; Qing et al. 2021; Wang et al. 2022b,a; Nag et al. 2022)需要精确的时间注释,这既耗时又费力,严重限制了其实际应用。

因此,许多研究者(Wang et al. 2017; Shou et al. 2018; Wang et al. 2021b)开始关注弱监督时序动作定位(Weakly-supervised Temporal Action Localization, WSTAL),该设置下仅提供视频级标签。虽然 WSTAL 取得了显著进展,但由于缺乏动作边界信息,模型在区分动作与背景时面临重大挑战,导致相比全监督方法表现仍不理想。

在 WSTAL 设置下,为了平衡标注成本与检测性能,Ma 等人(Ma et al. 2020)引入了**点监督时序动作定位(PSTAL)**任务,即仅为每个动作实例提供一个时间戳标签。他们的开创性研究表明,点级注释的人工成本几乎与视频级注释相当,但能提供更丰富的指导信息。随后,许多工作开始采用该设置,并提出了各种定制方案。例如,LACP(Lee and Byun 2021)提出通过贪心算法搜索最优伪序列来学习动作实例的完整性;Ju 等人(Ju et al. 2021)提出使用种子帧检测器生成候选,并对这些候选进行回归和分类。

尽管上述方法已取得显著成果,但仍局限于在片段级或实例级优化网络。片段级方法(Ma et al. 2020; Lee and Byun 2021)可能产生许多不可靠的检测(例如,过度完整或假阳性),因为它们仅考虑单个片段,忽视了整个动作实例;而实例级方法(Ju et al. 2021)由于缺乏从片段得分中生成的可靠候选,优化效果也不理想。

我们认为,点注释中的高可靠性信息可以在片段级和实例级传播。为此,我们通过考虑其置信得分与相对点注释位置,提取不同层次上的可靠原型。利用这些可靠原型进行高置信度信息传播,可以使网络学习到更具判别性的片段级表示和更可靠的实例级候选。

基于以上见解,我们提出了一种**分层可靠性传播(Hierarchical Reliability Propagation)**方法,包含两个具备可靠性感知能力的阶段:片段级动作判别学习(Snippet-level Action Discrimination Learning)和实例级动作完整性学习(Instance-level Action Completeness Learning),如图1所示。

图 1 :动机示意图。给定点级标注(紫色),我们在片段级和实例级提议层面都引入动作置信度先验,以实现置信度感知的动作表示学习。具体而言,我们的思路是传播可靠原型,从而生成更具判别性的片段级得分和更可靠、更完整的实例级得分。颜色越深(更绿或更橙)表示置信度越高。此处为简洁,仅展示单一动作类别的示例。

-

在片段级判别学习阶段,我们的目标是获取判别性片段得分,以生成更可靠的候选。为此,我们引入一个在线更新的记忆模块,存储每个类别的可靠原型,并设计了一个可靠性感知注意力模块,将这些可靠原型中的高置信线索传播到其他片段。通过对记忆与片段特征的对比优化,我们得到更具判别性的动作表示。

-

在实例级完整性学习阶段,我们通过实例级特征学习来优化候选的置信度得分与边界。我们提出一种基于点的候选生成方法,生成可靠的实例级原型候选及高置信的正负样本。这些候选特征被送入得分预测头(Score Head)和边界回归头(Regression Head),以预测动作的完整性得分和精细边界。

总结而言,我们的主要贡献如下:

- 我们提出的 HR-Pro 方法,是首个在点监督时序动作定位(PSTAL)领域同时利用点标注的内在置信度,在片段级和实例级优化中实现置信度感知的方案。

- 在片段级,我们设计了一个感知置信度的注意力模块,并引入基于可靠记忆库的对比损失,以获得具有更强判别能力的片段级表示。

- 在实例级,我们提出了一种基于置信度的提议生成与排序方法,以产出高置信度的动作提议,进而在实例级对其进行进一步优化。

- 我们的 HR-Pro 在四个标准时序动作定位基准上取得了最先进的性能,其中在 THUMOS14 数据集上实现了令人印象深刻的平均 mAP 60.3%,甚至超过了若干竞争力很强的全监督方法。

相关工作

全监督的时间动作定位。

主流的全监督方法可分为两类,即单阶段方法和双阶段方法。单阶段方法(Xu et al. 2020;Zhang, Wu, and Li 2022)直接预测动作的边界与类别作为最终检测结果。双阶段方法(Lin et al. 2018, 2019;Qing et al. 2021;Wang et al. 2022b, 2021a)首先生成大量提议,然后对提议进行分类。尽管近年来取得了显著进展,这些全监督方法仍需要昂贵的标注成本,限制了其应用。

弱监督的时间动作定位。

为降低标注成本,许多弱监督时间动作定位(WSTAL)方法(Wang et al. 2017;Shou et al. 2018;Liu et al. 2019)被提出,其中仅提供视频级标签。当前多数 WSTAL 方法遵循分类定位(localization-by-classification)模式,首先使用片段分类器评估每个片段的类别概率,即类别激活序列(Class Activation Sequence,CAS),然后使用多个预定义阈值定位时间边界。

近期,为提升模型性能已做出多项努力。例如:BaS-Net(Lee, Uh, and Byun 2020)引入背景类别和背景分支以抑制背景片段的类别激活值;ACM-Net(Qu et al. 2021)提出三路注意力分支以区分前景、背景和上下文;CoLA(Zhang et al. 2021)提出困难片段挖掘算法和片段对比损失,以优化特征空间中困难片段的表示;ACG-Net(Yang, Qin, and Huang 2022)和 DGCNN(Shi et al. 2022)使用图网络增强特征嵌入和动作片段之间的关系建模;ASM-Loc(He et al. 2022)利用片内与片间注意力建模动作动态并捕捉时间依赖性。由于缺乏帧级标注,这些方法在性能上仍大幅落后于全监督方法。

点监督的时间动作定位。

为在标注成本与模型性能之间取得平衡,Ma 等人(Ma et al. 2020)提出了点监督时间动作定位(PSTAL)任务,为每个动作实例提供一个时间戳标签。为充分挖掘点标注提供的引导信息,SF-Net(Ma et al. 2020)利用单帧标签挖掘其邻近伪标签用于训练分类器;Ju 等人(Ju et al. 2021)使用两阶段方法,先用种子帧检测器生成提议,再对提议进行回归和分类;LACP(Lee and Byun 2021)通过贪婪算法搜索最优伪序列,引导网络学习动作实例的完整性。然而,这些方法仍仅限于在片段级或实例级对网络进行优化,导致片段级的判别表示能力不强,以及实例级得分不可靠。

预备知识

问题定义

在点监督的时间动作定位(PSTAL)中,模型的训练数据为每段未裁剪视频中每个动作实例提供一个单帧标注。每个动作实例被标注为时间点 p i p_i pi 和类别为 c c c 的独热向量 y p i y_{p_i} ypi,其中 y p i [ c ] = 1 y_{p_i}[c] = 1 ypi[c]=1。该视频共包含 N N N 个动作实例。在推理阶段,对于每个测试视频,模型生成 M M M 个预测结果 ( s m , e m , c m , p m ) (s_m, e_m, c_m, p_m) (sm,em,cm,pm),其中 s m s_m sm 和 e m e_m em 是第 m m m 个动作实例的起止时间, c m c_m cm 是预测类别, p m p_m pm 是置信度分数。

基线架构

首先将输入视频划分为多个多帧片段(snippets),然后使用预训练的视频分类模型提取每个片段的 RGB 和光流特征,并在通道维度上拼接,得到的特征为

X

∈

R

T

×

D

X \in \mathbb{R}^{T \times D}

X∈RT×D,其中

T

T

T 表示片段数量,

D

D

D 表示特征维度。将

X

X

X 输入特征嵌入层,得到任务特定的嵌入特征

X

e

∈

R

T

×

D

X_e \in \mathbb{R}^{T \times D}

Xe∈RT×D。

参考前人工作(Lee and Byun 2021),我们首先将嵌入特征输入片段级分类器,获得类别激活序列(CAS)

S

∈

R

T

×

C

S \in \mathbb{R}^{T \times C}

S∈RT×C,其中

C

C

C 为类别数。为了减少来自背景片段的噪声,我们使用卷积层生成类别无关的注意力序列

A

∈

R

T

A \in \mathbb{R}^T

A∈RT,然后按元素乘法融合得到最终片段级预测

P

∈

R

T

×

C

P \in \mathbb{R}^{T \times C}

P∈RT×C,即:

P

=

S

⋅

A

P=S \cdot A

P=S⋅A

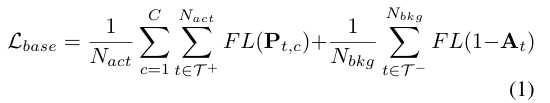

基线优化损失

基于如下特性:每个动作实例仅有一个点标注,并且相邻点标注来自不同动作实例,我们基于点标注与类别无关注意力序列选取伪动作片段集合

T

+

=

{

t

i

}

i

=

1

N

a

c

t

T^+ = \{t_i\}_{i=1}^{N_{act}}

T+={ti}i=1Nact 与背景片段集合

T

−

=

{

t

j

}

j

=

1

N

b

k

g

T^- = \{t_j\}_{j=1}^{N_{bkg}}

T−={tj}j=1Nbkg。具体而言,靠近点标注且类别无关注意力值高于阈值的片段被标记为伪动作片段,类别与点标注一致;相反,两个点标注之间的片段中注意力值最低或低于阈值的被标记为伪背景片段。

我们使用这些伪样本进行监督训练,损失函数为:

其中, N a c t N_{act} Nact 与 N b k g N_{bkg} Nbkg 分别为伪动作与背景片段数量, FL \text{FL} FL 表示焦点损失函数(focal loss)(Lin et al. 2017)。

方法:层次化置信度传播

图 2:层次化置信度传播(HR‑Pro)概览。在两个阶段的动作定位学习中传播可靠原型,即片段级判别学习和实例级完整性学习。(1)片段级:我们的目标是获得具有良好类间判别能力和动作–背景区分能力的片段表示。(2)实例级:我们的目标是在片段级输出生成的粗提议基础上,细化其置信度分数和时间边界。

置信度有助于网络挖掘更多伪样本,从而缓解点监督设定下监督信息稀疏的问题。我们认为,点标注所蕴含的内在置信度可以在片段级与实例级优化中进行传播。因此,我们提出了一个层次化置信度传播(Hierarchical Reliability Propagation)框架,将动作定位学习划分为两个级联阶段:

1.片段级动作判别学习(Snippet-level Action Discrimination Learning)

2.实例级动作完整性学习(Instance-level Action Completeness Learning)

片段级动作判别学习(Snippet-level Action Discrimination Learning)

前人方法主要关注于估计时间伪标签以扩充训练样本,这限制了高置信度片段信息在单个视频内的传播。因此,我们引入感知置信度的片段级动作判别学习(Reliability-aware Snippet-level Action Discrimination Learning),该方法提出为每个类别存储可靠原型,并通过片内与片间方式将高置信度线索从这些原型传播至其他片段。

可靠原型构建(Reliable Prototype Construction)

由于片段级动作表示(即片段特征)仅能捕捉短期和局部动作状态,因此特征容易受到噪声干扰而不可靠。因此,我们的核心思路是通过去噪机制构建可靠的片段原型,以用于后续感知置信度的优化。

具体地,我们创建一个在线更新的原型记忆池,在表示学习过程中为每个类别存储可靠原型,使得我们能够利用整个数据集的特征信息缓解单个特征的噪声干扰。形式上,我们用

m

c

∈

R

D

m_c \in \mathbb{R}^D

mc∈RD 表示记忆池中类别

c

c

c 的项(

c

=

1

,

2

,

.

.

.

,

C

c = 1, 2, ..., C

c=1,2,...,C)。在 PSTAL 设定下,我们首先利用点标注片段的特征初始化原型池。具体方式为:对所有训练视频中属于类别

c

c

c 的点标注片段

x

p

i

x_{p_i}

xpi 求平均。初始原型记忆表示为:

接着,我们使用伪动作片段的特征更新每个类别的原型,更新公式为:

其中,

μ

\mu

μ 表示动量系数。

如图 3 所示,为了获得原型,我们将特征提取器提取的片段级特征输入一个感知置信度的注意力模块(Reliability-aware Attention Block,RAB)。RAB 设计用于捕捉片内与片间的片段依赖关系,建模互补的时间关系。长期时间依赖建模对长视频尤为重要,这一点已被前人工作所验证(Zhang, Wu, and Li 2022;Wang et al. 2022c;Xu et al. 2022;Wang et al. 2023)。但注意力机制往往变得稀疏,只关注同一视频中具有判别性的片段,导致信息交互受限。

因此,RAB 引入从可靠原型(即片段)记忆中传播的全局类别信息,从而增强片段特征的鲁棒性,并提升对非判别性片段的关注。

感知置信度的注意力模块(RAB)结构

技术上,我们首先使用线性层

f

q

f_q

fq 将视频特征投影为查询向量(Query)。然后我们将视频特征

X

X

X 与原型记忆中的所有原型特征

[

m

1

;

…

;

m

C

]

[m_1; \dots; m_C]

[m1;…;mC] 级联(符号

[

;

]

[;]

[;] 表示拼接),并分别通过线性层

f

k

f_k

fk 和

f

v

f_v

fv 投影为键(Key)和值(Value):

接着,计算非局部注意力:

随后将注意力结果与值向量相乘,并送入由 FC-GELU-FC 层组成的前馈层(Feed Forward Layer, FFL)。我们采用 LayerNorm 和残差连接用于标准化和保留原始信息。输出的感知置信度特征将送入后续网络用于时间动作定位任务。

感知置信度的优化(Reliability-aware Optimization)

为了将不同类别的伪动作片段特征与其原型之间拉近,同时拉远伪动作片段与背景片段(同一视频)之间的距离,我们采用对比学习策略,提出了一个感知置信度的片段对比损失(Reliability-aware Snippet Contrastive Loss),定义如下:

其中,

t

c

i

t_c^i

tci 表示属于类别

c

c

c 的伪动作片段;

s

(

⋅

,

⋅

)

s(\cdot, \cdot)

s(⋅,⋅) 是相似度函数,定义为:

s

(

x

1

,

x

2

)

=

exp

(

x

ˉ

1

⋅

x

ˉ

2

/

τ

)

s(x_1, x_2) = \exp(\bar{x}_1 \cdot \bar{x}_2 / \tau)

s(x1,x2)=exp(xˉ1⋅xˉ2/τ)

τ

\tau

τ 是温度系数,

x

ˉ

\bar{x}

xˉ 表示归一化后的特征。

最终,片段级动作判别学习的总损失函数为基线损失与我们提出的对比损失的加权组合:

实例级动作完整性学习(Instance-level Action Completeness Learning)

片段级表示学习为我们的模型赋予了鲁棒的片段级动作判别能力。然而,尽管片段特征具有判别性,基于片段的检测流程仍可能产生大量不令人满意的检测结果,因为提议的得分在未考虑完整实例的情况下是不可靠的(例如:在长跳项目中,运动员助跑的背景帧可能具有很高的片段得分,但并不构成完整的长跳动作)。为充分挖掘动作的时间结构并优化提议的得分排序,我们引入了实例级动作完整性学习(Instance-level Action Completeness Learning),旨在通过实例级特征学习细化提议的置信度分数与边界,并利用可靠实例原型进行引导。

可靠原型构建(Reliable Prototype Construction)

为了在训练过程中利用点标注的实例级先验信息,我们提出了一种基于点的提议生成方法,用于生成可靠的实例级原型提议,以及高置信度的正负提议样本。

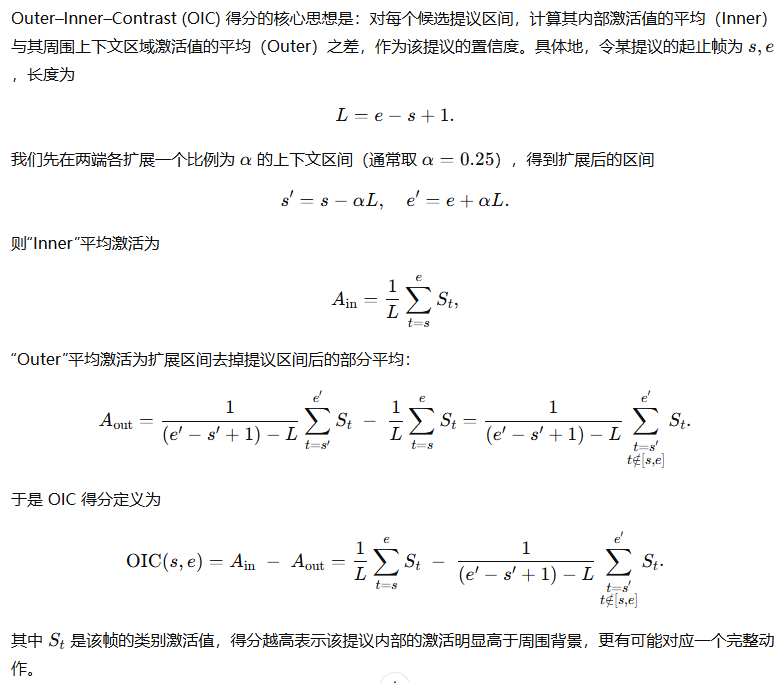

首先,我们针对每个预测类别,选取类别特异性激活得分高于阈值

θ

P

\theta_P

θP 的片段(实际实现中使用多个阈值)生成候选提议。我们为每个候选提议计算 OIC(Outer-Inner-Contrast)得分(Shou et al. 2018)作为其置信度分数,记为

p

OIC

p_{\text{OIC}}

pOIC。较低的 OIC 得分表明提议预测可能是不完整或过度完整的。

我们将每个候选提议表示为

(

s

i

,

e

i

,

c

i

,

p

OIC

)

(s_i, e_i, c_i, p_{\text{OIC}})

(si,ei,ci,pOIC),并根据其置信度分数与时间位置,将这些提议划分为两类:

可靠提议(RP):对于每个类别的每个点标注,选取包含该点并具有最高 OIC 得分的提议;

正样本提议(PP):其余候选提议。

为了保证正负样本数量的平衡,我们选取类别无关注意力低于阈值

θ

A

\theta_A

θA 的片段生成负样本提议(NP)。

感知置信度的优化(Reliability-aware Optimization)

对于每个提议,我们选取其内部所有片段的特征作为中心特征

I

c

I_c

Ic,然后将其边界扩展比例为

ε

\varepsilon

ε,从而获得提议的起始区域和结束区域特征,分别为

I

s

I_s

Is 与

I

e

I_e

Ie。在实践中

ε

=

0.25

\varepsilon = 0.25

ε=0.25。

(1)为了预测每个提议的完整性得分,我们采用边界敏感的提议特征(参照 Ren et al. 2023)作为输入,输入至得分头(Score Head)

φ

s

\varphi_s

φs,计算方式如下:

其中,

I

s

,

I

c

,

I

e

I_s, I_c, I_e

Is,Ic,Ie 分别是区域内特征在时间维度上的最大池化结果。

随后,实例级完整性分数的感知置信度监督损失定义为:

其中 N p , N n N_p, N_n Np,Nn 为正样本与负样本提议的总数, g comp g_{\text{comp}} gcomp 表示当前提议与与之匹配的最可靠提议(RP)之间的 IoU 值。

(2)为了获得更准确的动作提议边界,我们将每个正样本提议(PP)的起始特征与结束特征输入回归头(Regression Head)

φ

r

\varphi_r

φr,预测起止偏移量

Δ

s

^

\Delta\hat{s}

Δs^ 与

Δ

e

^

\Delta\hat{e}

Δe^:

然后可得到细化后的提议边界:

其中

w

p

=

e

p

−

s

p

w_p = e_p - s_p

wp=ep−sp 是原始提议的长度。

实例级边界回归的感知置信度监督损失定义为:

其中

r

^

comp

\hat{r}_{\text{comp}}

r^comp 表示细化后提议与与之匹配的最可靠提议(RP)之间的 IoU 值。

最终,实例级动作完整性学习的整体损失函数包括得分损失与边界回归损失,加权组合如下:

时间动作定位推理(Temporal Action Localization Inference)

我们首先提取每段视频中预测类别的片段级预测

P

c

P_c

Pc 以及类别无关注意力

A

A

A,用于生成候选提议,表示为

(

s

i

,

e

i

,

c

i

,

p

OIC

)

(s_i, e_i, c_i, p_{\text{OIC}})

(si,ei,ci,pOIC)。随后,我们将每个提议的实例级特征输入得分头和回归头,得到两个部分的预测提议:

得分细化部分:

(

s

i

,

e

i

,

c

i

,

p

OIC

+

p

^

comp

)

(s_i, e_i, c_i, p_{\text{OIC}} + \hat{p}_{\text{comp}})

(si,ei,ci,pOIC+p^comp)

边界细化部分:

(

s

^

r

,

e

^

r

,

c

i

,

p

OIC

+

p

^

r

)

(\hat{s}_r, \hat{e}r, c_i, p_{\text{OIC}} + \hat{p}_r)

(s^r,e^r,ci,pOIC+p^r)

其中,

p

^

r

\hat{p}_r

p^r 表示细化后提议的完整性得分,由训练好的得分头估计。

最后,我们将两部分结果结合,并采用类别级的 Soft-NMS(Bodla et al. 2017)去除重复提议。

实验

实验设置(Experimental Setup)

数据集。我们在四个常用的动作定位数据集上进行了实验,并且仅使用点级标注进行训练。我们使用(Lee and Byun 2021)提供的点级标注,以确保公平比较。

1.THUMOS14(Idrees et al. 2017):包含 20 个动作类别的 413 段未裁剪体育视频,其中 200 段用于训练,213 段用于测试,每段视频平均包含约 15 个动作实例。动作实例长度与视频长度差异较大,使该数据集极具挑战性。

2.GTEA(Fathi, Ren, and Rehg 2011):包含 7 类厨房中细粒度日常活动的 28 段视频。由 4 个不同参与者执行,每段视频包含约 1800 帧。

3.BEOID(Damen et al. 2014):包含 58 个样本视频,共 30 个动作类别,平均持续时长 60 秒,每段视频平均包含 12.5 个动作实例。

4.ActivityNet 1.3(Caba Heilbron et al. 2015):包含 10,024 个训练、4,926 个验证和 5,044 个测试视频,涵盖 200 个动作类别。每段视频平均包含 1.6 个动作实例。

评估指标。我们遵循标准协议,在不同 IoU 阈值下评估平均精度均值(mean Average Precision, mAP)。只有当预测提议的 IoU 超过设定阈值且预测类别正确时,才视为正样本。

实现细节。为了公平比较,我们遵循已有方法(Lee and Byun 2021)将每段视频划分为 16 帧的片段,并使用在 Kinetics-400 上预训练的 Two-stream I3D 网络作为特征提取器。

对于 THUMOS14,我们使用 Adam 优化器,学习率为

1

×

1

0

−

4

1\times10^{-4}

1×10−4,权重衰减为

1

×

1

0

−

3

1\times10^{-3}

1×10−3,batch size 设置为 16。超参数通过网格搜索设定:

τ

=

0.1

\tau = 0.1

τ=0.1,

μ

=

0.999

\mu = 0.999

μ=0.999,

λ

1

=

λ

2

=

1

\lambda_1 = \lambda_2 = 1

λ1=λ2=1。视频级阈值设为 0.5,

θ

P

\theta_P

θP 从 0 到 0.25,以 0.05 为步长,

θ

A

\theta_A

θA 从 0 到 0.1,以 0.01 为步长。RAB 的数量设置为 2。

与最新方法比较(Comparison with State-of-The-Art Methods)

我们通过与目前最先进的全监督和弱监督时间动作定位方法进行比较,验证我们所提出方法的有效性。

THUMOS14。我们提出的方法 HR-Pro 在 THUMOS14 测试集上针对点级弱监督时间动作定位任务取得了最先进的性能。如表 1 所示,HR-Pro 在 IoU 阈值从 0.1 到 0.7 的区间上获得了平均 mAP 为 60.3%,相比之前的最新方法(Fu, Gao, and Xu 2022)提升了 6.5%。

值得注意的是,我们的点监督方法甚至能够取得与竞争激烈的全监督方法相当的性能,例如 AFSD(在 IoU 阈值 0.3:0.7 区间上我们的 51.1% vs. AFSD 的 52.0%)。此外,HR-Pro 相比于具有相近标注成本的视频级弱监督方法表现出更强的检测能力,这得益于点标签提供的位置引导信息。

GTEA & BEOID & ActivityNet 1.3。如表 2 所示,我们的方法在多个不同基准上均展现出良好的通用性和优越性,分别在 GTEA、BEOID 和 ActivityNet 1.3 数据集上取得了 3.8%、7.6% 和 2.0% 的显著性能提升。

消融实验(Ablation Study)

为了进一步分析模型各组件对性能的贡献,我们在 THUMOS14 上进行了系列消融实验。我们将不同设置与基线设置(仅使用

L

base

\mathcal{L}_{\text{base}}

Lbase,其检测结果为 49.4%)进行对比,结果如表 3 所示。

片段级判别学习。引入对比损失(

L

contra

\mathcal{L}_{\text{contra}}

Lcontra)后,性能提升了 2.1%。对比优化不仅减少了分类误差,还提升了模型区分动作与背景的能力,从而提高了检测性能。进一步引入感知置信度的注意力模块(RAB)后,检测性能又提升了 3.2%。我们推测引入 RAB 后增强了对低置信度动作片段的关注,从而能检测出更多非判别性动作片段。

实例级完整性学习。引入回归损失与得分损失显著提升了检测性能。同时,基于点标注生成的可靠提议(RP)与负样本提议(NP)也进一步增强了效果。以上结果表明,实例级完整性学习的各个模块是互补的,使网络能够更加准确地估计提议的得分与边界。

定性结果

图 4:在 THUMOS14 数据集上,两个动作类别 GolfSwing(左)和 HammerThrow(右)的定性结果。我们比较了 HR‑Pro 与 LACP 的检测结果。橙色条和蓝色条分别表示真实标注与预测的定位结果;蓝色曲线代表片段级预测。预测错误用红色边框标出。

定性比较

在图 4 中,我们将 HR-Pro 与 LACP 在 THUMOS14 测试视频上的时序动作定位结果进行了对比。我们的模型能够更准确地检测动作实例。具体而言,对于 GolfSwing 动作,我们的方法能够有效地区分动作片段与背景片段,从而减少 LACP 中常见的误检;对于 HammerThrow 动作,我们的方法检测出的动作片段更加完整,而 LACP 在非判别性动作片段上激活值较低,导致检测不完整。

实例级完整性学习的效果

图 5 显示,实例级完整性学习帮助我们的方法降低了对过度完整或误报提议的评分,从而提升了整体检测效果。

图 5:在 THUMOS14 数据集上,实例级完整性学习前(左)与后(右)的检测结果可视化。横轴为时间,纵轴为置信度分数。我们可以观察到,实例级完整性学习后,“正确预测”与“错误预测”之间的差异显著增大。

结论(Conclusion)

本文提出了一种新颖的框架 HR-Pro,用于点监督的时间动作定位任务。HR-Pro 包含两个感知置信度的阶段,能够在片段级与实例级有效地传播点标注中的高置信度线索,使得网络能够学习到更具判别力的片段表示和更可靠的提议。

在多个基准数据集上的广泛实验表明,HR-Pro 显著优于现有方法,并取得了当前最先进的结果,充分证明了我们方法的有效性以及点标注在时间动作定位任务中的潜力。

1004

1004

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?