点击下方卡片,关注「计算机视觉工坊」公众号

选择星标,干货第一时间送达

作者:Jian Liu | 编辑:计算机视觉工坊

添加小助理:dddvision,备注:方向+学校/公司+昵称,拉你入群。文末附行业细分群

扫描下方二维码,加入3D视觉知识星球,星球内凝聚了众多3D视觉实战问题,以及各个模块的学习资料:近20门视频课程(星球成员免费学习)、最新顶会论文、计算机视觉书籍、优质3D视觉算法源码等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

0. 读者个人理解

目标姿态估计是一个基本的计算机视觉问题,在增强现实和机器人领域有广泛的应用。在过去的十年中,由于其卓越的准确性和稳健性,深度学习模型逐渐取代了依赖于设计好的点对特征的传统算法。然而,当代方法仍然面临几个挑战,包括它们对标注训练数据的依赖性、模型紧凑性、在挑战性条件下的稳健性,以及它们对新颖未见对象的泛化能力。最近缺少了一篇讨论该领域不同方面进展、突出挑战和有希望的未来方向的综述。为了填补这一空白,我们讨论了基于深度学习的目标姿态估计的最新进展,涵盖了该问题的三种表述,即实例级、类别级和未见对象姿态估计。我们的调查还涵盖了多种输入数据模态、输出姿态的自由度、对象属性和下游任务,为读者提供了对这一领域的全面理解。此外,它还讨论了不同领域的训练范式、推理模式、应用领域、评估指标和基准数据集,以及报告了当前最先进方法在这些基准上的性能,从而帮助读者选择最适合其应用的方法。最后,该调查确定了关键挑战,审查了当前的趋势及其优缺点,并确定了未来研究的有希望的方向。我们还在此https URL跟踪最新工作。

1. 导读

目标姿态估计是一个基本的计算机视觉问题,旨在估计给定图像中对象相对于捕获图像的摄像机的姿态。对象姿态估计是增强现实,机器人操作,手-物体交互等的关键技术。根据应用需求,对象姿态被估计到不同程度的自由度(DoF),比如只包括3D旋转的3DoF,此外还包括3D平移的6DoF,或者包括除了3D旋转和3D平移之外还要估计对象的3D大小的9DoF。

在深度学习时代之前,许多基于手工制作特征的方法,比如SIFT、FPFH、VFH和点对特征(PPF),被设计用于对象姿态估计。然而,当面对复杂场景时,这些方法在准确性和鲁棒性方面存在缺陷。这些传统方法现在已经被利用深度神经网络学习高维特征表示的数据驱动深度学习方法所取代,从而提高了准确性和对复杂环境的鲁棒性。

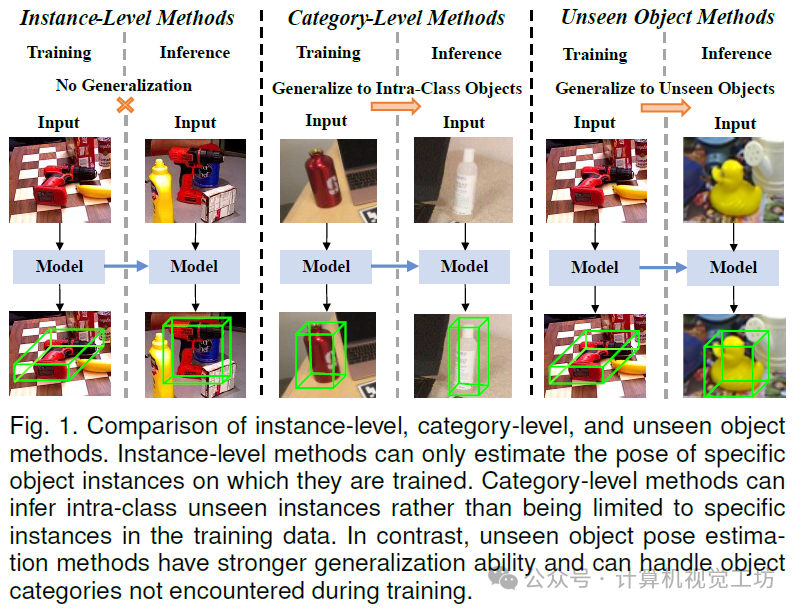

基于深度学习的对象姿态估计方法可以根据问题的制定分为实例级别、类别级别和未见对象方法。图1显示了这三种方法的比较。

早期的方法主要是实例级别的,训练来估计特定对象实例的姿态。实例级别方法可以进一步分为基于对应、基于模板、基于投票和基于回归的方法。然而,由于实例级别方法是在实例特定数据上训练的,它们可以对给定的对象实例进行高精度的姿态估计。然而,它们的泛化性能较差,因为它们只能应用于它们被训练的实例。此外,许多实例级别方法需要对象的CAD模型。为了克服这些限制,王等人提出了第一个类别级别的对象姿态和大小估计方法。他们能够推广到类内未见对象,无需在推断过程中重新训练和使用CAD模型。随后的类别级方法可以分为基于形状先验和无形状先验的方法。尽管提高了类内泛化能力,但这些类别级方法仍然需要为每个对象类别收集和标记大量训练数据。此外,这些方法无法推广到未见的对象类别。因此,最近提出了一些未见对象姿态估计方法,可以进一步分类为基于CAD模型和基于手动参考视图的方法。这些方法进一步提高了对象姿态估计的泛化性,即它们可以推广到未见的对象而无需重新训练。然而,它们仍然需要获取对象CAD模型或标注一些对象的参考图像。

尽管在对象姿态估计领域已经取得了显著进展,但当前方法仍然存在一些挑战,如依赖标记的训练数据,难以推广到新颖的未见对象,模型的紧凑性和在挑战性场景中的鲁棒性。为了让读者迅速了解对象姿态估计的最新技术水平,并促进该领域的进一步研究,提供所有相关问题表述的全面审查至关重要。对现有学术文献的仔细审查揭示了对象姿态估计中各种问题表述的全面审查存在显著差距。目前主流的评论往往具有狭窄的焦点,要么限于特定的输入模态,要么与特定的应用领域有关。此外,这些评论主要关注实例级和类别级方法,从而忽视了在领域中最实际的问题表述的探索,即未见对象姿态估计。这妨碍了读者对该领域的全面理解。

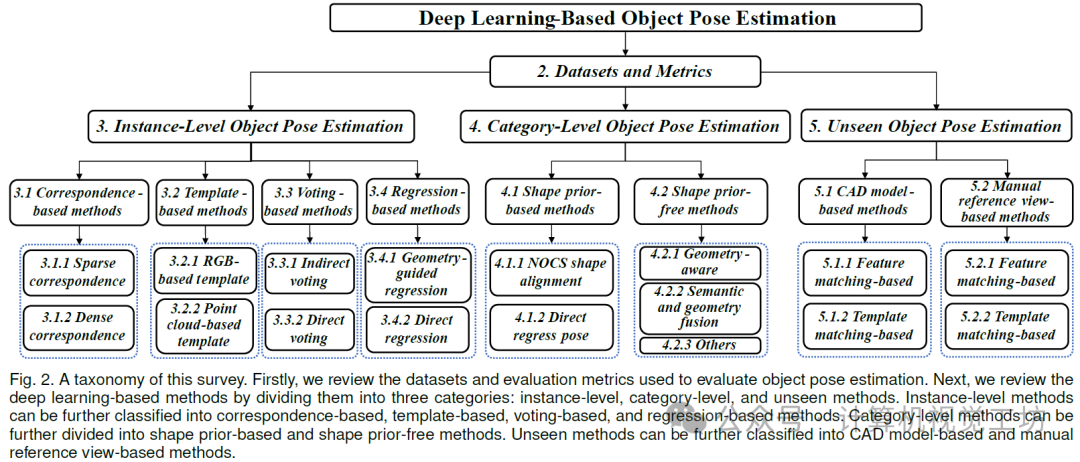

为了解决上述问题,我们提出了对基于深度学习的对象姿态估计方法的最新进展进行全面调查。我们的调查涵盖了所有问题表述,包括实例级别、类别级别和未见对象姿态估计,旨在为读者提供对该领域的整体理解。此外,我们讨论了不同的域训练范式、应用领域、评估指标和基准数据集,以及报告了这些基准数据集上最先进方法的性能,以帮助读者选择适合其应用的方法。此外,我们还强调了目前的趋势,并讨论了它们的优势和劣势,以及确定仍然存在的对象姿态估计中的关键挑战和有前景的研究方向。这项调查的分类如图2所示。

我们的主要贡献和亮点如下:

我们提出了基于深度学习的对象姿态估计方法的全面调查。这是第一个涵盖该领域所有三种问题表述的调查,包括实例级别、类别级别和未见对象姿态估计。

我们的调查涵盖了流行的输入数据模态(RGB图像、深度图像、RGBD图像)、输出姿态中不同的自由度(3DoF、6DoF、9DoF),以及刚性、关节式对象的属性,用于姿态估计以及跟踪任务。在单一调查中涵盖所有这些方面对于给读者提供完整的图景至关重要,而这一方面是现有调查所忽视的。

我们讨论了不同的域训练范式、推断模式、应用领域、评估指标和基准数据集,以及报告了这些基准数据集上现有最先进方法的性能,以帮助读者选择最适合在其应用中部署的方法。

我们强调了过去十年中对象姿态估计技术发展的流行趋势,并讨论了它们的优势和劣势。我们还确定了仍然存在的对象姿态估计中的关键挑战,以及有前景的研究方向,以指导未来的努力。

本文的其余部分安排如下。第2节回顾了用于评估三种对象姿态估计方法类别的数据集和度量。然后我们在第3节回顾了实例级方法,在第4节回顾了类别级方法,在第5节回顾了未见对象姿态估计方法。在上述三个部分中,我们还讨论了特定类别中代表性方法相关的训练范式、推断模式、挑战和流行趋势。接下来,第6节回顾了对象姿态估计的常见应用。最后,第7节总结了本文,并根据该领域的挑战展望了未来的研究方向。

2. 数据集

基于深度学习的目标姿态估计的发展与挑战性和可信度较高的大规模数据集的创建和利用密切相关。本节介绍了常用的主流目标姿态估计数据集,根据问题表述将其分类为实例级、类别级和未见目标姿态估计方法。时间顺序概述如图3所示。此外,我们还对相关的评估指标进行了概述。

2.1 实例级方法的数据集

由于BOP挑战数据集目前是评估实例级方法最受欢迎的数据集,我们将实例级数据集分为BOP挑战和其他数据集以进行概述。

2.1.1 BOP挑战数据集

Linemod数据集(LM)包括15个RGBD序列,其中包含带有地面真实6DoF对象姿态、对象CAD模型、2D边界框和二进制掩模的带注释的RGBD图像。通常按照Brachmann等人的方法,将每个序列的约15%的图像用于训练,其余85%用于测试。这些序列呈现出具有挑战性的场景,包括杂乱的场景、无纹理的对象和不同的光照条件,这使得准确的对象姿态估计变得困难。

Linemod遮挡数据集(LM-O)是LM数据集的扩展,专门设计用于评估遮挡场景中的性能。该数据集包含来自LM数据集中基本序列的1214个RGBD图像,用于8个严重遮挡对象。这对于评估和改进在充满遮挡的复杂环境中的姿态估计算法至关重要。

IC-MI / IC-BIN数据集用于无纹理对象的姿态估计。IC-MI包括六个对象:2个无纹理和4个有纹理的家庭物品模型。IC-BIN数据集专门设计用于解决机器人垃圾箱捡拾场景中的杂乱和遮挡带来的挑战。IC-BIN包含IC-MI中的2个对象。

RU-APC数据集旨在解决仓库拣选任务中的挑战,并提供了丰富的数据来评估和改进仓库自动化背景下机器人的感知能力。该数据集包括10,368张注册深度和RGB图像,涵盖了24种对象,这些对象被放置在仓库货架上的不同盒子中,以模拟多样的实验条件。

YCB-Video数据集(YCB-V)包括21个对象,分布在92个RGBD视频中,每个视频包含来自YCB对象数据集(总共50个对象)的3到9个对象。它包括133,827帧,分辨率为640×480,非常适合对象姿态估计和跟踪任务。

T-LESS数据集是一个设计用于工业环境中常见的无纹理对象的RGBD数据集。它包括30个电气对象,没有明显的纹理或可区分的颜色属性。此外,它还包括分辨率不同的图像。在训练集中,图像主要呈现黑色背景,而测试集则展示了具有不同光照条件和遮挡的多样化背景。由于对象上纹理的缺失和复杂的环境设置,T-LESS具有挑战性。

ITODD数据集包括28个现实世界的工业对象,分布在800多个场景中,约有3,500张图像。该数据集利用了两个工业3D传感器和三个高分辨率灰度相机,以实现对场景的多角度观察,为工业对象的分析和评估提供全面和详细的数据。

TYO-L / TUD-L数据集关注不同的光照条件。具体来说,TYO-L提供了3个对象在8种光照条件下的观察。这些场景旨在评估姿态估计算法对光照变化的鲁棒性。与TYO-L不同,TUD-L的数据收集方法涉及固定摄像机并手动移动对象,提供了更真实的对象物理移动表示。

HB数据集涵盖了各种场景,包括遮挡和光照条件的变化。它包括33个对象,包括17个玩具、8个家居物品和8个与行业相关的对象,分布在13个不同的场景中。

HOPE数据集专门为家庭物品设计,包含28个玩具杂货对象。HOPE-Image数据集包括50个场景中的对象。每个场景包括多达5种光照变化,例如背光和斜向照明,带有产生阴影的效果。此外,HOPE-Video数据集包括10个视频序列,总共2,038帧,每个场景展示了5到20个对象。

2.1.2其他数据集

YCBInEOAT数据集专门用于机器人操作中基于RGBD的对象姿态跟踪。它包含一个双臂机器人操作YCB对象的自我中心的RGBD视频。有三种操作方式:单臂拾取放置、手臂内操作和手臂间拾取放置。该数据集包含7449帧的地面真实姿态注释,包括9个视频中的5个不同对象。

ClearPose数据集专为透明物体设计,这些物体在日常生活中非常普遍,对视觉感知和传感系统带来重大挑战,因为它们的纹理特征不明显,深度信息不可靠。它包括超过350K真实世界的RGBD图像和63个家庭物品的5M实例注释。

MP6D数据集是一个设计用于金属部件姿态估计的RGBD数据集,包括20个无纹理金属部件。它由来自各种场景的20,100张真实世界图像和50K合成图像组成,涵盖了杂乱和遮挡的场景。

2.2 类别级方法的数据集

在这一部分中,我们将类别级数据集分为刚性和可展开对象数据集进行详细介绍。

2.2.1 刚性对象数据集

CAMERA25数据集包括6个对象类别的1085个实例:碗、瓶子、罐头、相机、杯子和笔记本电脑。值得注意的是,CAMERA25中的对象CAD模型来自合成的ShapeNet数据集。该数据集中的每个图像都包含多个实例,附带分割掩模和9DoF姿态标签。

REAL275数据集是一个包含18个视频和约8K个RGBD图像的真实世界数据集。该数据集分为三个子集:一个训练集(7个视频)、一个验证集(5个视频)和一个测试集(6个视频)。与CAMERA25数据集中的对象类别一致,REAL275包括了6个类别的42个对象实例。REAL275是一个广泛用于学术研究中的类别级对象姿态估计的重要真实世界数据集。kPAM数据集专为机器人应用量身定制,强调关键点的使用。值得注意的是,它采用了一种涉及3D重建的方法,然后对这些重建进行手动关键点注释的方法。kPAM提供了117个训练序列和245个测试序列,为与机器人感知和操作相关的算法提供了大量数据来训练和评估。

TOD数据集包括15个透明对象,分为6个类别,每个类别都用相关的3D关键点进行了注释。它包含了一个庞大的收集48K立体和RGBD图像,捕捉了透明和不透明深度变化。TOD数据集的主要重点是透明的3D对象应用,为涉及透明度的挑战性场景中的对象检测和姿态估计等任务提供了重要资源。

Objectron数据集包含了15K个带注释的视频片段,其中包含了超过4M个属于瓶子、书籍、自行车、相机、椅子、谷物盒、杯子、笔记本电脑和鞋子类别的图像。该数据集来自覆盖5个大陆的10个国家,确保了地理上的多样性。由于其丰富的内容,它对评估基于RGB的类别级对象姿态估计和跟踪方法非常有利。

Wild6D数据集是一个大规模真实世界数据集,用于评估自监督类别级对象姿态估计方法。它专门为486个测试视频提供注释,这些视频具有多样化的背景,展示了5个类别的162个对象(不包括CAMERA25和REAL275中的"罐头"类别)。

PhoCaL数据集包括RGBD和RGBP(极化)模态。它包含60个精心制作的家庭物品3D模型,包括对称、透明和反射物品。PhoCaL专注于24个序列中的8个特定对象类别,刻意引入遮挡和杂乱等挑战。

HouseCat6D数据集是一个全面的数据集,专门设计用于多模态类别级对象姿态估计和抓取任务。该数据集涵盖了各种家庭物品类别,包括194个高质量的3D模型。它包括了各种光度复杂性的对象,如透明和反射物品,并跨越了41个具有不同视角的场景。该数据集专门为解决对象姿态估计中的挑战而策划,包括遮挡和缺乏标记,使其适用于在真实世界条件下评估算法。

2.2.2 可展开对象数据集

BMVC数据集包括4个可展开对象:笔记本电脑、柜子、橱柜和玩具火车。每个对象被建模为包含组件和相互连接的头部的运动链。关节受到一个旋转和一个平移的DoF的限制。该数据集为每个对象提供了CAD模型和详细的文本文件,详细说明了每个对象底层运动链结构的拓扑。

RBO数据集包含了人类环境中常见的14个可展开对象,在不同的实验条件下进行了358个交互序列,总共67分钟的手动操作。实验条件包括交互类型、光照、视角和背景设置的变化。

HOI4D数据集对于推进类别级人类-物体交互研究至关重要。它包括240万个自我中心的RGBD视频帧,描述了超过9个参与者和800个对象实例之间的交互。这些实例被分成16个类别,包括7个刚性和9个可展开的对象。

ReArtMix / ReArtVal数据集旨在解决部分级多个可展开对象姿态估计的挑战,其中包括未知的运动结构。ReArtMix数据集包含超过10万张渲染在不同背景场景中的RGBD图像。ReArtVal数据集包括6个真实桌面场景,包含超过6,000张RGBD帧。

ContactArt数据集是使用远程操作系统在模拟环境中操作可展开对象生成的。该系统利用智能手机和笔记本电脑精确注释姿态和接触信息。该数据集包含5个常见类别的可展开对象:笔记本电脑、抽屉、保险箱、微波炉和垃圾桶,共80个实例。所有对象模型均来自PartNet数据集,因此具有可扩展性。

2.3 未见方法的数据集

目前用于评估未见方法的主流数据集是BOP挑战数据集,如第2.1.1节所述。除了这些BOP挑战数据集之外,还有一些设计用于评估手动参考视图方法的数据集,如下所述。

MOPED数据集是一个无模型对象姿态估计数据集,包括11个家庭物品。它包括参考图像和测试图像,涵盖了所有对象的所有视图。测试序列中的每个对象在五个不同的环境中呈现,每个对象约有300张测试图像。

GenMOP数据集包括10个对象,从平面对象到薄结构对象。对于每个对象,都有两个视频序列,收集自不同的背景和照明情况。每个视频序列包含大约200张图像。

OnePose数据集包括超过450个现实世界视频序列,涵盖了150个对象。这些序列在各种背景条件下收集,捕捉了对象的所有角度。每个环境的平均持续时间为30秒。该数据集随机划分为训练集和验证集。

OnePose-LowTexture数据集是对现有OnePose数据集测试集的补充,后者主要包含有纹理的对象。该数据集包括40个低纹理的家庭物品。对于每个对象,都有两个视频序列:一个作为参考视频,另一个用于测试。每个视频以1920×1440的分辨率、30帧每秒(FPS)捕获,并持续约30秒。

3. 实例级目标位姿估计

实例级物体姿态估计描述了在模型训练期间已经见过的物体的姿态估计任务。我们将现有的实例级方法分为四类:基于对应关系的(第3.1节)、基于模板的(第3.2节)、基于投票的(第3.3节)和基于回归的(第3.4节)方法。

3.1 基于匹配关系的方法

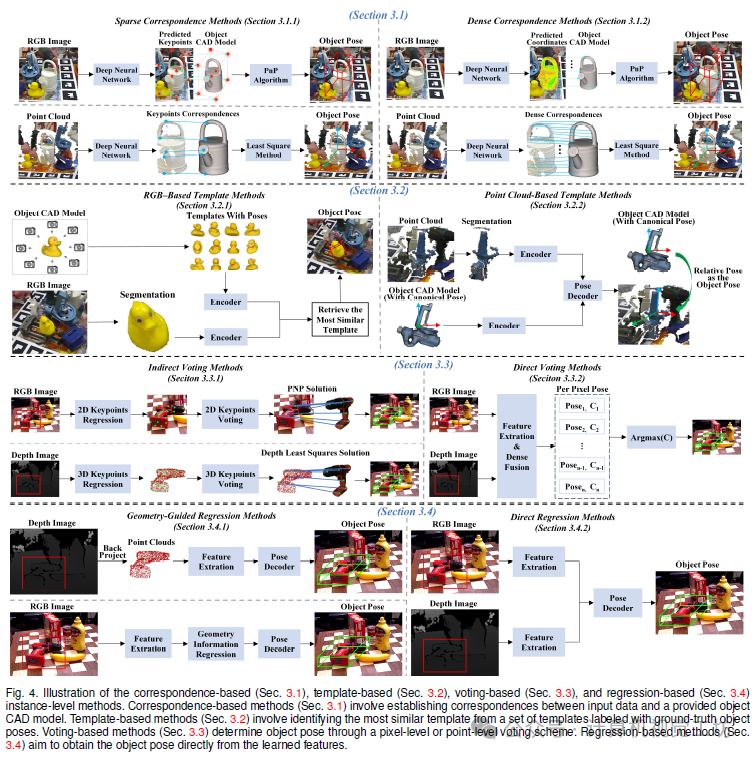

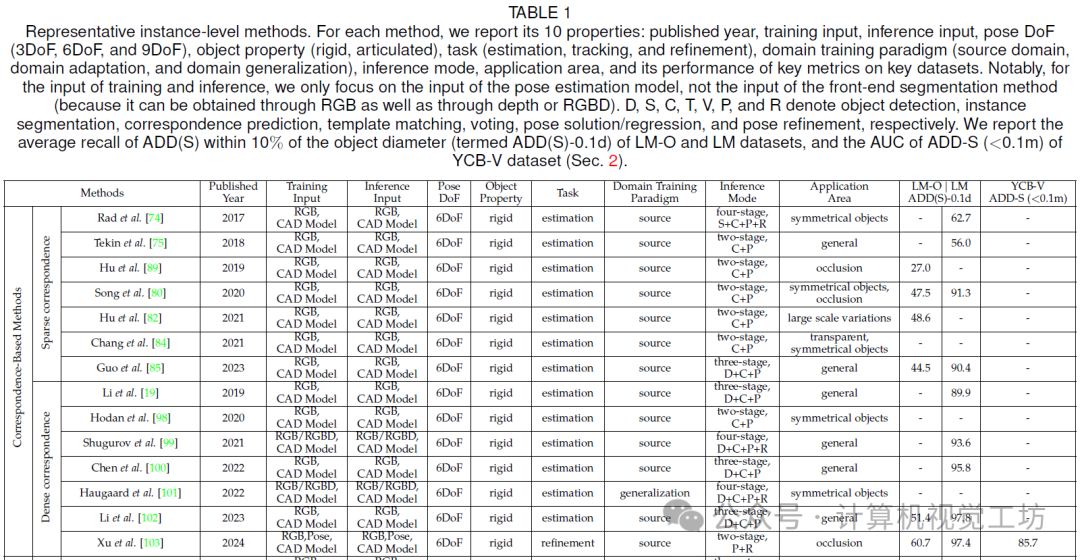

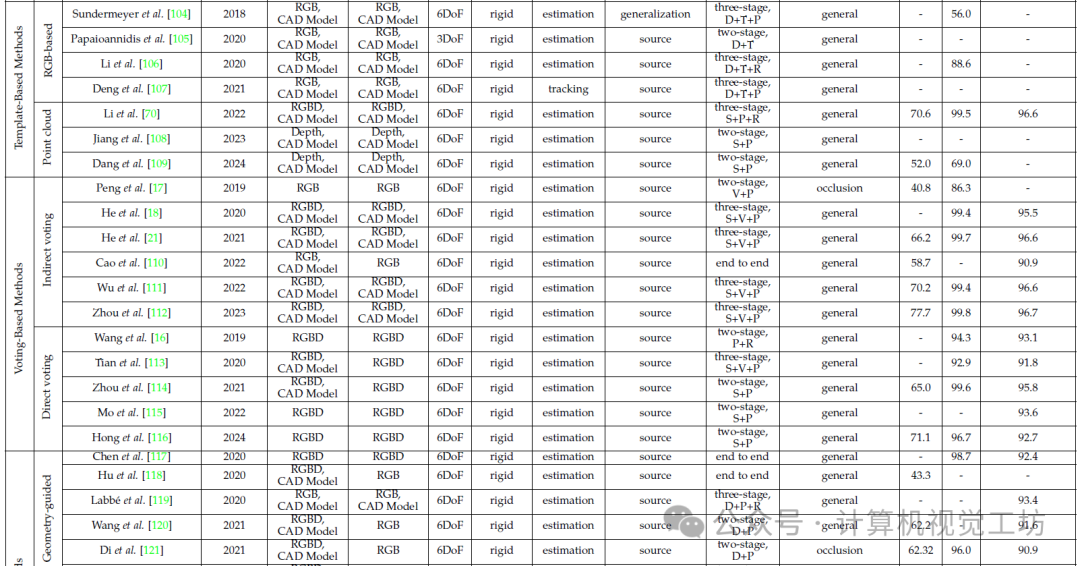

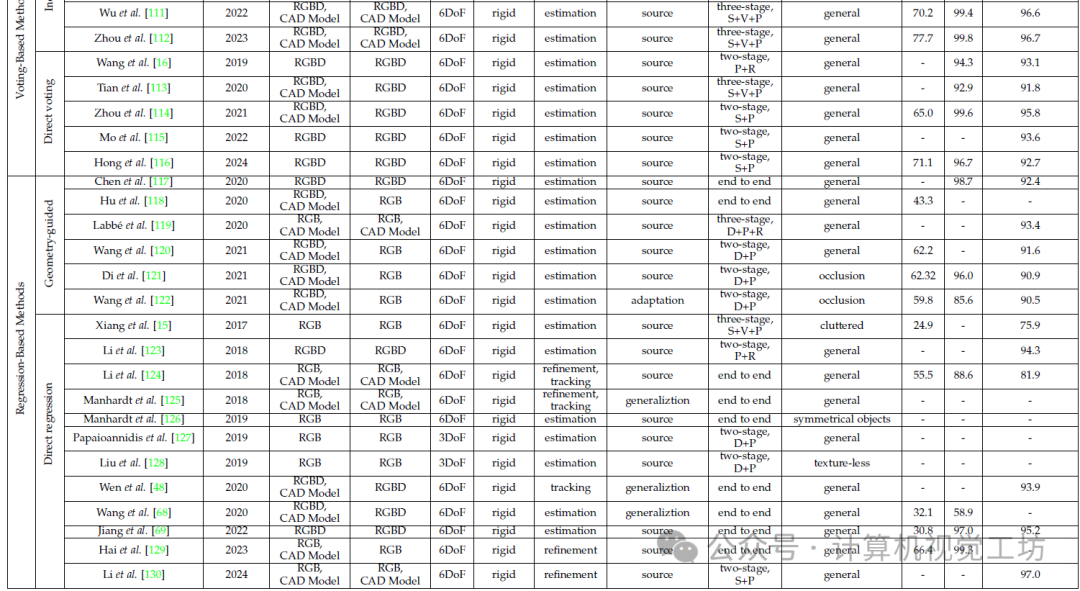

基于对应关系的物体姿态估计是指涉及识别输入数据与给定完整物体 CAD 模型之间对应关系的技术。基于对应关系的方法可以分为稀疏和密集对应关系。稀疏对应关系方法(第3.1.1节)涉及在输入图像或点云中检测物体关键点,以建立输入数据和物体 CAD 模型之间的 2D-3D 或 3D-3D 对应关系,随后利用 Perspective-n-Point(PnP)算法[73]或最小二乘法来确定物体姿态。密集对应关系方法(第3.1.2节)旨在建立密集的 2D-3D 或 3D-3D 对应关系,最终导致更准确的物体姿态估计。对于 RGB 图像,它们利用每个像素或多个补丁来生成像素级对应关系,而对于点云,它们使用整个点云来找到点级对应关系。这两种方法的示意图如图4所示。一些代表性方法的属性和性能如表1所示。

3.1.1 稀疏对应关系方法

作为代表性方法,Rad 等人首先使用分割方法在 RGB 图像中检测感兴趣的物体。然后,他们预测物体的 3D 边界框角点的 2D 投影。最后,他们使用 PnP 算法来估计物体姿态。此外,他们使用分类器来实时确定姿态范围,解决对称物体中的歧义问题。Tekin 等人提出了一种受 YOLO启发的 CNN 网络,将物体检测和姿态估计整合在一起,直接预测 3D 物体边界框的投影顶点的位置。Pavlakos 等人预测了预定义语义关键点的 2D 投影。Doosti 等人引入了一个由两个自适应图卷积神经网络(GCNNs)组成的紧凑模型,共同估计物体和手部姿态。为了进一步增强物体姿态估计的鲁棒性,Song 等人使用混合中间表示来传达输入图像中的几何细节,包括关键点、边缘向量和对称对应关系。Liu 等人提出了一个多方向特征金字塔网络以及一种通过整合空间和平面信息来计算物体姿态估计置信度的方法。Hu 等人引入了一个单阶段分层的端到端可训练网络,以解决航天器中尺度变化相关的姿态估计挑战。最近的一个发展是,Lian 等人增加了预定义 3D 关键点的数量,以增强对应关系的建立。此外,他们设计了一种逐渐细化对应关系的分层二进制编码方法,用于 RGB 图像位置,实现对应关系的渐进细化并将对应关系回归转换为更有效的分类任务。为了估计透明物体的姿态,Chang 等人使用了一个 3D 边界框预测网络和多视角几何技术。该方法首先检测 3D 边界框顶点的 2D 投影,然后基于多视角检测的 2D 投影结合相机运动数据重构 3D 点。此外,他们引入了一种广义的姿态定义来解决对称物体的姿态歧义问题。为了增强姿态估计网络的效率,Guo 等人将知识蒸馏集成到物体姿态估计中,将教师的本地预测分布蒸馏到学生网络中。Liu 等人认为,可微 PnP 策略与 PnP 问题的平均性质相冲突,导致梯度可能鼓励网络降低个别对应关系的准确性。为了缓解这一问题,他们引入了线性协方差损失,可用于稀疏和密集对应关系方法。

为了减轻大遮挡引起的脆弱性,Crivellaro 等人使用多个控制点来表示每个物体部分。然后,他们预测这些控制点的 2D 投影以计算物体姿态。一些研究人员通过使用小补丁预测关键点来解决遮挡问题。Oberweger 等人分别处理每个补丁以生成热图,然后汇总结果以获得精确可靠的预测。此外,他们提供了一种简单但有效的策略,用于在训练期间解决补丁和热图之间的歧义。Hu 等人揭示了一个基于分割的姿态估计框架,在该框架中,每个可见物体部分通过 2D 关键点位置提供本地姿态预测。此外,Huang 等人将 2D 关键点位置概念化为损失函数中的概率分布,并设计了一个基于置信度的网络。

减少对注释的真实世界数据的依赖也是一项重要任务。一些方法利用几何一致性作为额外信息,以减轻注释的需求。Zhao 等人利用带有物体注释和视点之间相对变换的图像对,自动识别几何和视觉一致的物体 3D 关键点。此外,Yang 等人对具有标记的 2D 边界框的双尺度图像使用关键点一致性正则化。使用半监督学习,Liu 等人开发了一个统一的框架来估计 3D 手部和物体姿态。他们构建了一个联合学习框架,对手部和物体表示之间进行显式的上下文推理。为了在半监督学习中生成伪标签,他们利用大规模手物体视频中发现的时空一致性作为约束。合成数据也是解决注释问题的一种方式。Georgakis 等人通过选择关键点并在 RGB 图像和 CAD 模型渲染中保持视点和模态不变性,减少了昂贵的 3DoF 姿态注释需求。Sock 等人利用自监督来缩小合成数据和真实数据之间的差距,并跨不同物体视图强化光度一致性以微调模型。此外,Zhang 等人利用真实和合成领域之间关键点之间几何关系的不变性进行域自适应。Thalhammer 等人引入了一个专门的特征金字塔网络来计算多尺度特征,实现对各种特征图分辨率的同时生成姿态假设。

总的来说,稀疏对应关系方法可以有效地估计物体姿态。然而,仅依赖少数控制点可能导致次优的准确性。

3.1.2 密集匹配关系方法

密集对应关系方法与稀疏对应关系方法相比利用了更多的对应关系,从而能够实现更高的准确性并更有效地处理遮挡。Li 等人主张区分旋转和平移,并提出基于坐标的解耦姿态网络。该网络将姿态估计分为旋转和平移的独立预测。Zakharov 等人引入了密集多类 2D-3D 对应关系的物体姿态检测器以及一个定制的基于深度学习的精细化过程。此外,Cai 等人提出了一种技术,可自动识别并持续匹配不同视图中的图像标志,旨在增强学习 2D-3D 映射的过程。Wang 等人开发了一个受重建指导的姿态估计流水线,利用几何一致性。此外,Shugurov 等人在 Zakharov 等人的基础上开发了一个统一的深度网络,能够适应多种图像模态(如 RGB 和深度)并整合基于可微渲染的姿态精化方法。Su 等人引入了一种由分层二进制分组实现的离散描述符,能够密集表示物体表面。因此,该方法可以预测细粒度的对应关系。Chen 等人引入了一个用于一般端到端姿态估计的概率 PnP 层。该层在 SE(3) 流形上生成姿态分布。另一方面,Xu 等人认为,编码姿态敏感的局部特征并对内点姿态的统计分布进行建模对于准确和鲁棒的 6DoF 姿态估计至关重要。受到 PPF的启发,他们利用每对定向点携带的姿态敏感信息和多余姿态预测集合来实现对严重物体间遮挡和场景点云中系统噪声的稳健性能。

一些方法通过建立 3D-3D 对应关系恢复物体姿态。Huang 等人使用 RGB 图像来预测相机锥体中的 3D 物体坐标,从而建立 3D-3D 对应关系。此外,Jiang 等人介绍了一种基于中心的解耦框架,利用鸟瞰图和前视图进行物体中心投票。他们利用中心对齐的物体与物体 CAD 模型之间的特征相似性来建立基于奇异值分解(SVD)的旋转估计的对应关系。最近,Lin 等人利用 RGBD 图像作为输入,并采用点到表面匹配来估计物体表面对应关系。他们通过迭代收缩表面,将其过渡为对应点,逐渐消除异常值,从而建立 3D-3D 对应关系。

一些方法更加注重处理具有挑战性的情况,例如对称物体和无纹理物体。Park 等人利用生成对抗训练来重建遮挡部分以减轻遮挡的影响。他们通过将预测引导到最近对称姿态来处理对称物体。此外,Hodan 等人模拟了一种有效处理物体建模中的对称性的紧凑表面片段模型。对于每个像素,网络预测:每个物体存在的概率、条件于物体存在的片段的概率以及每个片段的精确 3D 平移。最后,通过 PnP-RANSAC 算法的强大和高效版本确定物体姿态。此外,Wu 等人利用几何感知的密集匹配网络获得可见的密集对应关系。此外,他们利用这些对应关系的距离一致性来缓解对称物体中的歧义。对于无纹理物体,Wu 等人利用物体 CAD 模型的信息,并利用伪孪生神经网络建立 2D-3D 对应关系。

随着研究的发展,领域自适应、弱监督和自监督技术已被引入姿态估计。Li 等人注意到不同真实主义和语义水平的图像在合成和真实领域之间展现出不同的可转移性。因此,他们将输入图像分解为多层语义表示,并将这些表示的优势融合起来以减轻领域差异。此外,Hu 等人提出了一种专门在合成图像上训练的方法,该方法推断出用于精化粗姿态的必要姿态校正。Haugaard 等人利用学习的分布对姿态假设进行采样、评分和精化。利用对比损失学习对应关系分布。该方法在视觉模糊方面是无监督的。最近,Li 等人引入了一个弱监督的基于重建的管道。最初,他们使用隐式神经表示从各个视点重建物体。随后,他们训练一个网络来预测像素级的 2D-3D 对应关系。Hai 等人提出了一种利用多视图捕获的合成到真实图像对中的几何约束的精化策略。

还有一些方法专注于姿态精化。Lipson 等人以紧密耦合的方式迭代地优化姿态和对应关系。他们引入了一个可微层,通过解决双向深度增强 PnP 问题来优化姿态。此外,Xu 等人将物体姿态精化表述为非线性最小二乘问题,利用估计的对应场,即 RGB 图像和初始姿态的渲染图像之间的对应关系。然后,通过可微的 Levenberg-Marquardt 算法解决非线性最小二乘问题,实现端到端的训练。

总的来说,前述基于对应关系的方法对遮挡表现出鲁棒性,因为它们可以利用局部对应关系来预测物体姿态。然而,当处理缺乏显著形状特征或纹理的物体时,这些方法可能会遇到挑战。

3.2 基于模板的方法

通过利用图像中的全局信息,基于模板的方法可以有效地解决无纹理对象带来的挑战。基于模板的方法涉及从带有地面真实对象姿态标签的一组模板中识别最相似的模板。它们可以分为基于RGB的模板(第3.2.1节)和基于点云的模板(第3.2.2节)方法。这两种方法在图4中有所说明。当输入是RGB图像时,模板包括从对象CAD模型中提取的2D投影,并带有地面真实姿态的注释。这个过程将对象姿态估计转化为图像检索。相反,当处理点云时,模板包括带有规范姿态的对象CAD模型。值得注意的是,我们将直接回归对象CAD模型和观察到的点云之间的相对姿态的方法归类为基于模板的方法。这是因为这些方法可以解释为寻找将观察到的点云与模板对齐的最佳相对姿态。因此,确定的相对姿态作为对象姿态。一些代表性方法的特征和性能如表1所示。

3.2.1 基于RGB的模板方法

Sundermeyer等人通过变体去噪自编码器实现了3D旋转估计,该方法学习了对象旋转的隐式表示。如果有深度信息可用,则可以用于姿态细化。Liu等人开发了一个类似自编码器的CNN,用于重建包含目标对象的任意场景并提取对象区域。此外,Zhang等人利用目标检测器和关键点提取器简化了模板搜索过程。Papaioannidis等人建议在合成图像中估计对象姿态更加直接。因此,他们使用生成对抗网络将真实图像转换为合成图像,同时保持对象姿态。Li等人进一步利用姿态表示(3D位置字段)指导自编码器提取姿态相关特征,从而增强了姿态模糊处理。Stevˇsiˇc等人提出了一种空间注意机制来识别和利用姿态细化的空间细节。与上述方法不同,Deng等人在Rao-Blackwellized粒子滤波框架内解决了6DoF对象姿态跟踪问题。他们对旋转空间进行了细粒度离散化,并训练了一个自编码器网络来构建这些离散旋转的特征嵌入的码书。该方法有效地估计了3D平移以及对3D旋转的完整分布。

RGB相机广泛用作视觉传感器,然而它们在光照条件不佳下很难捕获足够的信息。这导致了姿态估计性能较差。

3.2.2 基于点云的模板方法

随着消费级3D相机的普及,基于点云的方法充分利用了其适应光照不足并捕获几何信息的能力。Li等人采用了一个特征解耦和对齐模块来建立部分点云和对象CAD模型之间的部分对应关系,增强了几何约束。Jiang等人提出了一个基于SE(3)扩散模型的点云配准框架,通过连续注入扰动变换来逐渐扰动一对点云的最优刚性变换。然后,使用SE(3)反向去噪过程逐渐去噪,使其更接近于准确的姿态估计的最优变换。Dang等人提出了两个关键贡献来提高真实世界数据上的姿态估计性能。首先,他们引入了一个直接监督的损失函数,绕过了SVD操作,减轻了基于SVD的损失函数对输入部分点云和对象CAD模型之间旋转范围的敏感性。其次,他们设计了一种匹配归一化策略,以解决部分点云和CAD模型之间特征分布不均的问题。

通常,基于模板的方法利用图像中的全局信息,使其能够有效处理无纹理对象。然而,实现高姿态估计精度可能会导致模板的内存使用增加和计算复杂性的迅速提高。此外,在遇到遮挡对象时,它们可能还会表现出性能较差。

3.3 基于投票的方法

基于投票的方法通过像素级或点级投票方案确定对象姿态,可以分为两种主要类型:间接投票和直接投票。间接投票方法(第3.3.1节)通过像素级投票从RGB图像中估计一组预定义的2D关键点,或通过点级投票从点云中估计一组预定义的3D关键点。随后,通过输入图像和CAD模型之间的2D-3D或3D-3D关键点对应来确定对象姿态。直接投票方法(第3.3.2节)直接在像素级或点级预测姿态和置信度,然后选择具有最高置信度的姿态作为对象姿态。这些类型方法的说明如图4所示。一些代表性方法的属性和性能如表1所示。

3.3.1 间接投票方法

一些研究人员预测了2D关键点,然后通过2D-3D关键点对应推导出对象姿态。Liu等人引入了一种连续表示方法,称为关键点距离场(KDF),它通过在每个KDF上进行投票来提取2D关键点。此外,Liu等人引入了一个双向深度残差融合网络来融合RGBD信息,从而精确估计2D关键点。与此同时,Cao等人提出了一种称为动态图PnP的方法,用于从2D-3D对应关系中学习对象姿态,实现端到端的训练。受扩散模型启发,Xu等人提出了一个基于扩散的框架,将2D关键点检测建模为一个去噪过程,以建立更准确的2D-3D对应关系。

与预测2D关键点的上述方法不同,He等人提出了一个深度Hough投票网络来预测3D关键点。随后,他们通过Levenberg-Marquardt算法估计对象姿态。此外,He等人引入了一个双向融合网络来补充RGB和深度异构数据,从而更好地预测3D关键点。为了更好地捕获3D空间中对象点之间的特征,Mei等人利用图卷积网络促进了3D空间中点之间的特征交换,旨在提高预测3D关键点的准确性。Wu等人提出了一种基于交叉球面的3D关键点投票方案,允许生成更小、更分散的3D关键点集,从而提高估计效率。为了获得更准确的3D关键点,Wang等人提出了一个迭代3D关键点投票网络,以优化3D关键点的初始定位。最近,Zhou等人引入了一种新型加权向量3D关键点投票算法,采用非迭代全局优化策略来精确定位3D关键点,同时实现几乎实时的推理速度。

针对拥挤或遮挡等具有挑战性的场景,Peng等人引入了一个像素级投票网络来回归指向3D关键点的像素级向量。这些向量为定位遮挡或截断的3D关键点提供了灵活的表示。由于大多数工业零部件是参数化的,Zeng等人通过驱动参数和对称性将关键点与参数相关联。这种方法有效地解决了堆叠场景中对象姿态的估计。

与使用单视角RGBD图像不同,Duffhauss等人采用了多视角RGBD图像作为输入。他们从每个RGB图像中提取视觉特征,而几何特征则是从对象点云(通过融合所有深度图像生成)中提取的。这种基于多视角RGBD特征融合的方法可以在拥挤的场景中准确预测对象姿态。

一些研究人员提出了新的训练策略来提高姿态估计性能。Yu等人开发了一个可微的代理投票损失,模拟了投票过程中的假设选择,实现端到端训练。此外,Lin等人提出了一个新颖的学习框架,利用基于RGBD的姿态细化方法的准确结果来监督基于RGB的姿态估计器。为了弥合合成数据和真实数据之间的域差距,Ikeda等人提出了一种方法,将对象风格从合成转移到真实而无需手动干预。

总的来说,间接投票方法为实例级对象姿态估计提供了一个优秀的解决方案。然而,姿态估计的准确性严重依赖于关键点的质量,这可能导致较低的鲁棒性。

3.3.2 直接投票方法

间接投票方法的性能严重依赖于关键点的选择。因此,提出了直接投票方法作为替代方案。Tian等人在SO(3)中均匀采样旋转锚点。随后,他们对每个锚点向目标预测约束偏差,使用不确定性得分选择最佳预测。然后,他们通过将点到中心向量聚合到对象中心来检测3D平移,以恢复6DoF姿态。Wang等人在像素级基础上融合了RGB和深度特征,并利用姿态预测器为每个像素生成6DoF姿态和置信度。随后,他们选择具有最高置信度的像素姿态作为最终姿态。Zhou等人采用CNN提取RGB特征,然后将其集成到点云中以获得融合特征,融合特征采用点集的形式而不是特征映射。

然而,上述RGBD融合方法仅将RGB和深度特征简单连接起来,而不深入挖掘它们的内在关系。因此,Zhou等人提出了一种新的多模态融合图卷积网络,以增强RGB和深度图像的融合,通过局部信息传播捕获跨模态相关性。Liu等人将深度图像中的尺度相关和尺度不变信息解耦,以指导网络感知场景的3D结构并为RGB图像特征提取提供场景纹理。与使用静止图像的方法不同,Mu等人提出了一个时间融合模型,将RGBD图像中的时间运动信息集成到6DoF对象姿态估计中。该方法有效地捕捉对象运动和变化,从而提高姿态估计的准确性和稳定性。

对称对象可能具有多个真实姿态,导致姿态估计中的歧义。为了解决这个问题,Moet al.设计了一种对称不变姿态距离度量,使网络能够准确估计对称对象。Cai等人引入了一种3D旋转表示来学习对象的隐式对称性,消除了对对象对称性的额外先验知识的需要。为了减少对标注实际数据的依赖性,Zeng等人仅在合成数据集上训练了他们的模型。然后,他们利用一个从合成到真实的学习网络来提高其泛化能力。在姿态估计过程中,他们将场景点转换成质心空间,并通过聚类和投票获得对象姿态。

总的来说,基于投票的方法在姿态估计任务中表现出了优越的性能。然而,投票过程耗时且增加了计算复杂性。

3.4 回归方法

回归方法的目标是直接从学习到的特征中获取对象姿态。它们可以分为两种主要类型:几何引导回归和直接回归。

几何引导回归方法(第 3.4.1 节)利用 RGBD 图像中的几何信息(例如将深度图转换为点云或利用 2D-3D 几何约束)来辅助对象姿态估计。直接回归方法(第 3.4.2 节)直接回归对象姿态,利用 RGBD 图像信息。这两种方法的示意图如图 4 所示。一些代表性方法的属性和性能如表 1 所示。

3.4.1 几何引导回归方法

Gao 等人使用解耦网络从对象点云中回归旋转和平移。Lin 等人使用网络提取对象点云的几何特征。然后,他们通过在成对兼容性图上应用谱卷积来增强几何特征的成对一致性。

为了进一步利用点云信息,Chen 等人引入了旋转残差估计器,用于估计预测旋转与地面真值之间的残差,提高了旋转预测的准确性。此外,Shi 等人在点云块内学习几何和上下文特征。然后,他们训练一个子块网络来预测每个点云块的姿态。最后,选择最可靠的块姿态作为对象姿态。为了解决基于点云的对象姿态跟踪的挑战,Liu 等人提出了在相邻帧的点云之间进行平移点卷积操作,以促进局部上下文交互。

仅依赖于对象点云的方法通常忽视对象纹理细节。因此,Wen 等人和 An 等人利用 RGB 和深度信息的互补性质。他们通过采用注意机制来改进交叉模态融合策略,从而有效地对齐和整合这两种异构数据源,从而提高性能。

与直接从深度图像或对象 CAD 模型中导出几何信息的上述方法相比,许多研究人员更专注于从 RGB 图像中生成几何约束。Hu 等人从 RGB 图像中学习从 CAD 模型中心到 3D 边界框角的 2D 偏移,并直接从 2D-3D 对应中回归对象姿态。此外,Di 等人使用共享编码器和两个独立的解码器生成 2D-3D 对应和自遮挡信息,提高了在遮挡情况下对象姿态估计的鲁棒性。此外,Wang 等人提出了一种几何引导直接回归网络(GDR-Net),以端到端的方式从稠密的 2D-3D 对应中学习对象姿态。Wang 等人引入了基于 GDR-Net 的噪声增强学生训练和可微渲染,通过多个几何约束的自监督学习实现了对遮挡场景的鲁棒性。Zhang 等人提出了一种基于 Transformer 的姿态估计方法,包括一个感知补丁特征融合模块和一个基于 Transformer 的姿态细化模块,以解决基于 CNN 的网络在捕获全局依赖性方面的局限性。最近,Feng 等人将旋转分解为两组相应的 3D 法线。这种解耦策略显著提高了旋转准确性。

考虑到真实世界数据标注的劳动密集性,一些方法利用合成数据训练以推广到真实世界。Gao 等人构建了一个轻量级的合成点云生成管道,并利用增强的基于点云的自动编码器来学习对象姿态信息以回归对象姿态。为了提高对真实场景的泛化能力,Zhou 等人利用注释的合成数据监督网络收敛。他们提出了一种自监督管道,通过最小化从地面真值姿态变换的 CAD 模型到预测姿态的距离来处理未注释的真实数据。Tan 等人提出了一种自监督单眼对象姿态估计网络,包括教师和学生模块。教师模块包含一个用于初始对象姿态估计的骨干估计网络,而学生模型从未注释的真实图像中预测相机姿态。学生模块通过从相机姿态中推断的几何约束向教师模块获取对象姿态估计知识。

几何引导回归方法通常需要额外的处理步骤来提取和处理几何信息,这会增加计算成本和复杂性。

3.4.2 直接回归方法

直接回归方法的目标是直接从 RGBD 图像中恢复对象姿态,而无需额外的转换步骤,从而降低了复杂性。直接回归方法包括各种策略,包括耦合姿态输出、解耦姿态输出和输出 3D 旋转。这三种主要策略将进行详细讨论。

耦合姿态:Garon 等人提出了一种实时跟踪方法,在训练过程中学习了连续帧之间的变换关系,并使用 FCN获取两个帧之间的相对姿态用于训练和推断。为了克服环境中的光变化,Rambach 等人使用铅笔滤镜将输入图像标准化为光不变表示进行训练和推断。此外,Kleeberger 等人提出了一个用于处理对象之间遮挡的鲁棒框架,能够以 65 FPS 的速度实时运行。Sarode 等人提出了一个基于 PointNet的框架,用于对齐点云以进行姿态估计,旨在减少姿态不对齐的敏感性。从单个 RGB 图像估计对象姿态引入了固有的模糊问题。Manhardt 等人建议明确解决这些模糊。他们为每个对象预测多个 6DoF 姿态以估计由对称性和重复纹理引起的特定姿态分布。受可见表面差异度量启发,Bengtson 等人依赖于可微渲染器和 CAD 模型生成多个加权姿态,避免陷入局部最小值。此外,Park 等人提出了一种基于对象空间中的局部网格的姿态估计方法。该方法在相机空间的射线上定位感兴趣的网格区域,并通过估计的姿态将网格转换为对象空间。转换后的网格是采样网格和姿态估计的新标准。

耦合姿态可能导致旋转和平移之间的信息耦合,使得在优化过程中难以区分它们的关系,从而影响估计精度。解耦姿态:解耦 6DoF 对象姿态可以有效降低模型的复杂性并提高其泛化能力。在对象姿态估计中,Xiang 等人通过定位图像中的对象中心并预测从对象中心到相机的距离来估计 3D 平移。他们进一步通过回归到四元数表示来估计 3D 旋转,并引入了一种新的损失函数来更好地处理对称对象。同时,Kehl 等人将流行的 SSD范式扩展到生成 2D 检测框。他们记录了对象 ID 的得分和所有视点以及平面旋转的得分,从而建立姿态假设并选择最佳姿态。Wu 等人、Do 等人和 Bukschat 等人使用两个平行的 FCN分支独立地回归对象的旋转和平移。为了消除对真实数据注释的依赖性,Wang 等人使用合成 RGB 数据进行全监督训练,然后利用神经渲染对未注释的真实 RGBD 数据进行自监督学习。此外,Jiang 等人融合了 RGBD、内置 2D 像素坐标编码和深度法线向量特征,以更好地估计对象的旋转和平移。单视图方法存在歧义,因此,Li 等人提出了一种多视图融合框架来减少单视图框架固有的歧义。此外,Labb´e 等人提出了一种统一的方法,用于多视图、多对象 6DoF 姿态估计。最初,他们利用单视图、单对象姿态估计技术推导出个体对象的姿态假设。然后,他们在多个输入图像中对齐这些对象姿态假设,以集体推断统一场景中的相机视点和对象姿态。最近,Hsiao 等人引入了基于分数的扩散方法来解决基于 RGB 的对象姿态估计中的姿态歧义问题。

对于对象姿态跟踪,Wen 等人提出了一种数据驱动的优化策略,以稳定 6DoF 对象姿态跟踪。具体而言,他们通过预测相邻帧之间的相对姿态来预测 6DoF 姿态。Liu 等人提出了一种基于上述方法的新的减法特征融合模块,以建立足够的时空信息交互。改进了在复杂场景中对象姿态跟踪的鲁棒性。与基于 RGBD 输入的方法不同,Ge 等人设计了一种新颖的深度神经网络架构,将视觉和惯性特征整合起来,以预测连续图像帧之间的相对对象姿态。

在对象姿态精化方面,Li 等人通过将 RGB 图像与对象 CAD 模型的渲染图像对齐来迭代地精化姿态。此外,他们预测光流和前景掩码来稳定训练过程。Manhardt 等人通过将 RGB 图像中的对象轮廓与渲染轮廓对齐来精化 6DoF 姿态。渲染轮廓是使用初始姿态从对象 CAD 模型中获得的。Hai 等人提出了一种形状约束递归匹配框架来精化初始姿态。他们首先根据初始和当前估计的姿态计算出由姿态引起的流动,然后直接将 6DoF 姿态从姿态引起的流动解耦。为了解决姿态精化方法的低运行效率,Iwase 等人引入了一种基于深度纹理渲染的姿态精化方法,以使用具有可学习纹理的对象 CAD 模型进行快速特征提取。最近,Li 等人提出了一种两阶段方法。第一阶段执行姿态分类,并在分类的姿态中渲染对象 CAD 模型。第二阶段执行回归,以预测分类的姿态中的细粒度残差。该方法通过通过姿态分类引导残差姿态回归来提高鲁棒性。

其他:一些研究人员通过仅回归 3D 旋转来追求更高效和实用的姿态估计。

Papaioannidis 等人提出了一种新颖的基于四元数的多目标损失函数,该函数集成了流形学习和回归以学习 3DoF 姿态描述符。他们通过回归学习的描述符获得了 3DoF 姿态。Liu 等人训练了一个基于卷积神经网络的三元网络来从二值图像中提取区分特征。他们将姿态引导方法和回归约束并入构建的三元网络中,以使特征适用于回归任务,从而增强了鲁棒性。此外,Josifovski 等人通过构建一个视角估计模型,估计与对象坐标系相关的相机视角,从而获得边界框中出现的 3DoF 姿态。

总的来说,直接回归方法简化了对象姿态估计过程,并进一步提高了实例级方法的性能。然而,实例级方法只能估计训练数据中的特定对象实例,限制了其对未见对象的泛化能力。此外,大多数实例级方法需要准确的对象 CAD 模型,这是一个挑战,尤其是对于具有复杂形状和纹理的对象。

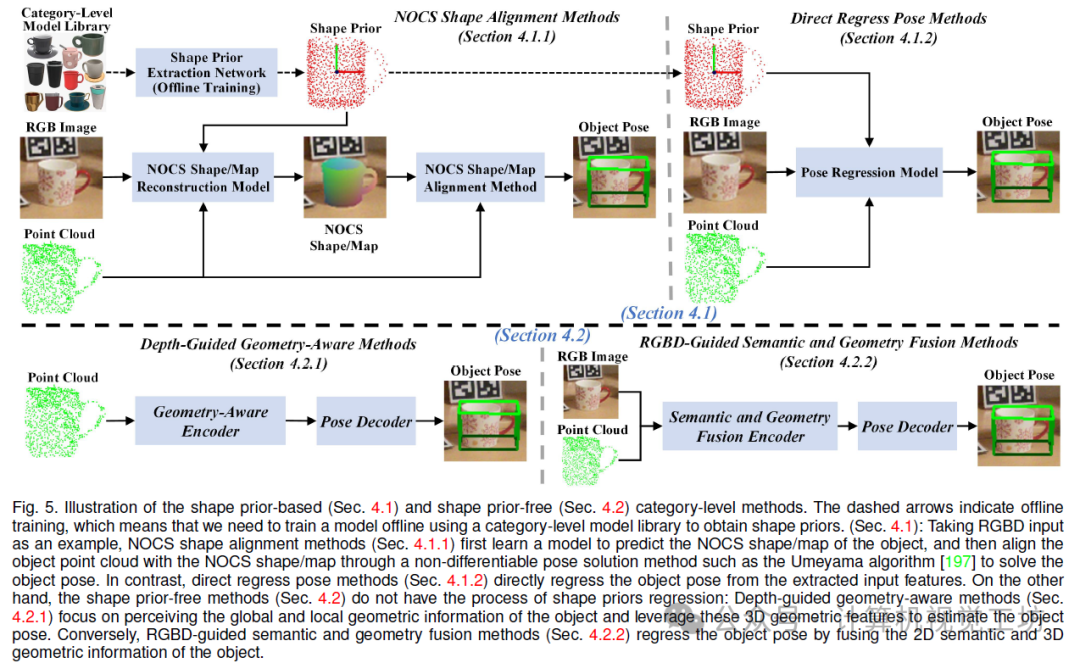

4. 类别级目标位姿估计

由于类别级方法具有泛化到已建立类别中看不见的对象的潜力,因此对类别级方法的研究引起了广泛关注[196]。在本节中,我们将类别级方法分为基于形状先验的方法(Sec. 4.1)和不基于形状先验的方法(Sec. 4.2)进行综述。这两个类别的示意图如图5所示。一些代表性的SOTA方法的特征和性能如表2所示。

4.1 基于形状先验的方法

基于形状先验的方法首先使用离线模式中类内见对象的CAD模型来学习神经网络以获取形状先验,然后将其作为3D几何先验信息来引导类内看不见对象的姿态估计。在本部分中,我们将基于形状先验的方法分为两类,根据它们处理对象姿态估计的方法。第一类是规范化对象坐标空间(NOCS)形状对齐方法(Sec. 4.1.1)。它们首先预测NOCS形状/映射,然后使用离线姿态解算方法(例如Umeyama算法)将对象点云与预测的NOCS形状/映射对齐,以获取对象姿态。另一类是姿态回归方法(Sec. 4.1.2)。它们直接从特征级别回归对象姿态,使姿态获取过程可微分化。这两个类别的示意图如图5所示。

4.1.1 NOCS形状对齐方法

作为开创性工作,Tian等人首先在离线模式中提取形状先验,用于表示一类对象的平均形状。例如,杯子由圆柱形杯体和弧形手柄组成。接下来,他们为类内看不见对象引入了形状先验变形网络来重建其NOCS形状。最后,采用Umeyama算法来通过对齐NOCS形状和对象点云来解决对象姿态。在Tian等人之后,一些方法旨在更准确地重建NOCS形状。具体来说,Wang等人设计了一个递归重建网络来迭代地优化重建的NOCS形状。此外,Chen等人通过使用RGBD图像和形状先验之间的结构相似性动态调整形状先验。Zou等人提出了两种基于多尺度变换器的网络(Pixelformer和Pointformer),用于提取RGB和点云特征,并随后将它们融合以进行形状先验变形。与以前的方法不同,Fan等人引入了一种对抗规范表示重建框架,其中包括NOCS表示的重建器和鉴别器。具体来说,重建器主要由姿态无关模块和关系重建模块组成,以减少对旋转和平移的敏感性,并分别生成高质量特征。然后,鉴别器用于引导重建器生成真实的NOCS表示。Nie等人通过几何信息感知的实例特定先验和多阶段形状重建来提高姿态估计的准确性。最近,Zhou等人设计了一个由变形和配准组成的两阶段流水线来提高准确性。Zou等人引入了一个图引导点变换器,由图引导注意力编码器和迭代非参数解码器组成,进一步提取点云特征。此外,Li等人利用实例-类别结构的差异以及潜在的几何-语义关联来更好地研究类内形状信息。Yu等人进一步将NOCS形状重建过程划分为粗略变形、精细变形和递归细化三个部分,以增强NOCS形状重建的准确性。

考虑到地面实况对象姿态标注的耗时性,He等人探索了一种自监督方法,通过强制点云与类别先验网格之间的几何一致性,避免使用真实世界的姿态标注。此外,Li等人首先通过部分分割网络提取语义基元,然后利用语义基元计算SIM(3)不变形状描述符来生成优化的形状。然后,利用Umeyama算法来恢复对象姿态。通过这种方法,他们实现了域泛化,弥合了合成与实际应用之间的差距。

在一些具有挑战性的场景中可能无法获得深度图像(例如,在强光或低光条件下)。因此,实现单眼类别级对象姿态估计在各种应用中具有重要意义。Fan等人直接从单眼RGB图像中预测对象级深度和NOCS形状,通过形状先验变形,随后利用Umeyama算法解决对象姿态。然后,他们重建了NOCS形状,利用RANSAC算法去除异常值,然后利用PnP算法恢复对象姿态。另一方面,Wei等人首先估计2.5D草图,并使用形状先验分离尺度恢复。然后,他们重建了NOCS形状,利用RANSAC算法去除异常值,然后利用PnP算法恢复对象姿态。对于透明对象,Chen等人提出了一种基于立体视觉的新解决方案,该解决方案定义了一个背景NOCS映射,以解决图像内容混叠的问题。

总的来说,尽管这些NOCS形状对齐方法可以恢复对象姿态,但对齐过程是不可微分的,并且没有集成到学习过程中。因此,对NOCS形状/映射的预测错误会显著影响姿态估计的准确性。

4.1.2 直接回归姿态方法

由于NOCS形状对齐过程的不可微性(依赖于离线Umeyama算法),最近提出了几种基于直接回归的姿态方法。Irshad等人将对象实例视为空间中心,并提出了一种将对象检测、重建和姿态估计相结合的端到端方法。Wang等人开发了一个可变形的模板场,以解耦形状和姿态变形,提高了形状重建和姿态估计的准确性。另一方面,Zhang等人提出了一种对称感知形状先验变形方法,将形状先验集成到直接姿态估计网络中。此外,Zhang等人引入了一种几何引导的剩余对象边界框投影框架,以解决姿态敏感特征提取不足的挑战。为了获得更精确的对象姿态,Liu等人设计了CATRE,一种基于形状先验与对象点云对齐的姿态细化方法,用于优化以上方法估计的对象姿态。Zheng等人扩展了CATRE以解决几何变化问题,通过集成混合范围层和可学习仿射变换。

由于标注真实世界训练数据所需的广泛手动工作,Lin等人探索了每个类内看不见实例相对其对应的类别级形状先验的形状对齐,隐含地表示了其3D旋转。该方法促进了从合成到实际场景的域泛化。此外,Ze等人提出了一种基于姿态和形状可微渲染的新框架,以实现域自适应对象姿态估计。此外,他们收集了一个大型Wild6D数据集,用于野外类别级对象姿态估计。在Ze等人之后,Zhang等人引入了2D-3D和3D-2D几何对应关系,以增强域自适应能力。与以前的方法不同,Remus等人通过单个RGB图像实现了基于实例级方法的域泛化类别级对象姿态估计。Lin等人提出了一种基于深度先验变形的网络,并利用并行学习方案实现了域泛化。这种方法意味着网络需要仅在渲染的合成数据集上进行训练,才能有效地泛化到实际世界。最近,Liu等人设计了一个多假设一致性学习框架。该框架通过采用多个特征提取和融合技术解决了不确定性问题,并通过缩小合成和实际世界数据集之间的域差距来降低不确定性问题。

总的来说,尽管上述基于形状先验的方法显著提高了姿态估计性能,但获取形状先验需要构建类别级CAD模型库,然后训练网络,这既繁琐又耗时。

4.2 无形状先验方法

无形状先验方法不依赖于使用形状先验,因此具有更好的泛化能力。这些方法可以分为三个主要类别:深度引导的几何感知(Sec. 4.2.1)、RGBD引导的语义和几何融合(Sec. 4.2.2)和其他方法(Sec. 4.2.3)。前两个类别的示意图如图5所示。

4.2.1 深度引导的几何感知方法

由于3D图形卷积(3DGC)的快速发展,Chen等人利用3DGC并引入了一种快速的基于形状的方法,该方法包括一个基于RGB的网络用于实现2D对象检测,一个基于形状的网络用于3D分割和旋转回归,以及一个基于残差的网络用于平移和尺寸回归。受Chen等人的启发,Liu等人改进了网络,引入了结构编码器和推理注意力。此外,Di等人提出了一种几何引导的逐点投票方法,利用几何洞察来增强姿态敏感特征的学习。具体地,他们设计了一种对称感知的点云重建网络,并在训练过程中引入了逐点边界框投票机制,以增加额外的几何指导。由于3DGC的平移和尺寸不变性,这些方法在感知对象平移和尺寸信息方面受到限制。基于此,Zheng等人进一步设计了一个混合范围特征提取层,该层可以同时感知全局和局部几何结构,并编码尺寸和平移信息。

除了上述基于3DGC的方法外,Deng等人将类别级自动编码器与粒子滤波器框架相结合,实现了对象姿态估计和跟踪。Wang等人利用可学习的稀疏查询作为隐式先验进行变形和匹配以进行姿态估计。此外,Wan等人开发了一个语义感知的对象坐标空间,以解决NOCS的语义不一致问题。最近,Zhang等人提出了一种基于得分的扩散模型来解决对称对象和部分点云中的多假设问题。他们首先利用得分扩散模型生成多个姿态候选,然后利用基于能量的扩散模型去除异常姿态。另一方面,Lin等人首先引入了一种实例自适应的关键点检测方法,然后基于检测到的关键点设计了一个几何感知的全局和局部特征聚合网络,用于姿态和尺寸估计。Li等人利用类别级方法确定零件对象的姿态,用于组装多部分多关节3D形状。

为了对关节对象进行姿态估计,Li等人受到Wang等人的启发,通过设计关节感知的规范化坐标空间层次结构,为同一类别中的不同关节对象引入了标准表示,同时构建了一个规范化对象空间和一组规范化零件空间。Weng等人进一步提出了CAPTRA,一个统一的框架,可以同时实现刚性和关节对象的9自由度姿态跟踪。由于服装的自由度几乎没有限制和极端自遮挡,Chi等人引入了GarmentNets,将可变形对象姿态估计概念化为规范化空间内的形状完成问题。最近,Liu等人开发了一种基于强化学习的管道,通过强化代理训练来预测9自由度关节对象姿态,通过拟合关节状态。进一步,Liu等人通过姿态感知等变换点卷积运算符学习了零件级SE(3)-等变特征,以解决自监督关节对象姿态估计问题。

为了避免使用大量真实世界标记的数据进行训练,Li等人利用SE(3)等变点云网络进行自监督对象姿态估计。You等人引入了一种类别级点对特征投票方法,以减少合成到实际世界域的影响,实现了野外通用对象姿态估计。此外,Peng等人提出了一种基于深度隐式形状表示的实际世界自监督训练框架。他们利用深度符号距离函数作为3D表示来实现从合成到实际世界的域自适应。

总的来说,这些方法充分提取了与姿态相关的几何特征,但缺乏语义信息的指导限制了它们的性能。语义和几何信息的适当融合可以有效提高姿态估计的鲁棒性。

4.2.2 基于RGBD引导的语义和几何融合方法

作为开创性研究,Wang等人设计了一个标准化的物体坐标空间,为一类物体提供了一个规范的表示。他们首先预测了类别标签、掩码和类内不可见物体的NOCS(标准化物体坐标系统)图。然后,他们利用Umeyama算法通过将NOCS图与物体点云对齐来解决物体姿态。为了处理类内物体的各种形状变化,Chen等人学习了一个规范形状空间作为统一表示。另一方面,Lin等人探索了稀疏可定向卷积(SSC)在物体姿态估计中的适用性,并提出了基于SSC的流程。此外,Lin等人提出了一个双姿态网络,包括一个共享姿态编码器和两个并行的显式和隐式姿态解码器。当推断过程中没有CAD模型时,隐式解码器可以强制执行预测的姿态一致性。此外,Wang等人设计了一个注意力引导网络,用于RGB图像和点云特征的关系感知和结构感知融合。最近,Liu等人探讨了形状先验对类内不可见物体形状重建的必要性。他们证明了变形过程比形状先验更重要,并提出了一个无先验的隐式空间转换网络。Lin等人通过将旋转估计解耦为视点和平面内旋转来解决旋转估计精度不佳的问题。此外,他们还提出了一种基于空间球面卷积的球形特征金字塔网络来处理球形信号。随着大型视觉模型(LVM)的快速发展,Chen等人进一步利用了LVM DINOv2来提取SE(3)一致的语义特征,并将其与特定对象的分层几何特征融合,以封装类别级别的信息用于旋转估计。

由于上述方法仍然需要大量真实世界的标注训练数据,它们在真实世界场景中的适用性受到限制。为此,Lee等人引入了一种师生自监督学习机制。他们仅在源域中使用监督训练,并在目标域中使用自监督训练,有效实现了域自适应。最近,Lee等人进一步提出了一个用于域泛化类别级物体姿态估计的测试时适应框架。具体来说,他们首先使用标记的合成数据训练模型,然后在推断期间利用预训练模型进行测试时适应于现实世界。

为了提高物体姿态估计方法的运行速度,在获取第一帧的物体姿态后,可以利用连续的时空信息跟踪物体姿态。Wang等人提出了一种基于锚点的物体姿态跟踪方法。他们首先将每个帧的锚点检测为关键点,然后通过关键点对应解决相对物体姿态。此外,Wen等人首先通过视频分割网络传导-VOS获取连续帧RGBD掩码,然后利用LF-Net进行通用关键点检测。接下来,他们匹配相邻帧之间的关键点,并进行粗略配准以估计初始相对姿态。最后,提出了一种基于记忆增强的姿态图优化方法,用于连续姿态跟踪。

总的来说,这些基于RGBD引导的语义和几何融合方法取得了卓越的性能。然而,当输入的深度图像存在错误时,姿态估计性能会急剧下降。因此,在深度图像存在错误或不可用时确保姿态估计的稳健性非常重要。

4.2.3 其他

由于大多数移动设备未配备深度摄像头,Chen等人结合了基于梯度的拟合过程的神经合成模块,以同时预测物体形状和姿态,实现了单眼物体姿态估计。此外,Lee等人估计了物体的NOCS形状和度量尺度形状,并在它们之间执行了相似性变换以解决物体姿态和大小。此外,Yen-Chen等人倒置神经辐射场以进行单眼类别级别姿态估计。与之前的方法不同,Lin等人提出了基于关键点的单阶段流水线,通过单个RGB图像实现。Guo等人从长期视觉导航的角度重新定义了单眼类别级别物体姿态估计问题。另一方面,Ma等人通过神经特征的粗到精渲染增强了单眼方法在遮挡场景中的鲁棒性。鉴于透明实例缺乏颜色和深度信息,Zhang等人提出利用深度补全和表面法线估计来实现透明实例的类别级别姿态估计。此外,为了提高单眼方法的运行效率,Lin等人开发了一种基于关键点的单眼物体姿态跟踪方法。该方法展示了使用跟踪条件深度网络和概率过滤集成不确定性估计的重要性。在Lin等人之后,Yu等人通过结合卷积和变压器的网络进一步提高了姿态跟踪的准确性。

为了进一步提高类别级别方法的泛化能力,Goodwin等人引入了基于参考图像的零样本方法,首先提取空间特征描述符并建立循环描述符距离。然后,他们为姿态估计建立了前k个语义对应关系。Zaccaria等人提出了一种通过光流一致性的自监督框架。最近,Cai等人开发了一个开放式词汇框架,旨在利用未见类别的文本提示在未见场景图像中进行泛化。Felice等人探索了基于扩散模型的零样本新视角合成,用于3D物体重建,并通过对应关系恢复了物体姿态。此外,Lin等人利用预训练的视觉语言模型充分利用丰富的语义知识,并通过多模态对比学习在特征空间中对三种模态(图像、点云和文本)的表示进行了对齐。

总的来说,这些无形状先验的方法绕过了对形状先验的依赖,并进一步提高了类别级别物体姿态估计方法的泛化能力。然而,这些方法局限于在类内不可见物体内部进行泛化。对于不同类别的物体,需要收集训练数据并重新训练模型,这仍然存在重大限制。

5. 未见目标

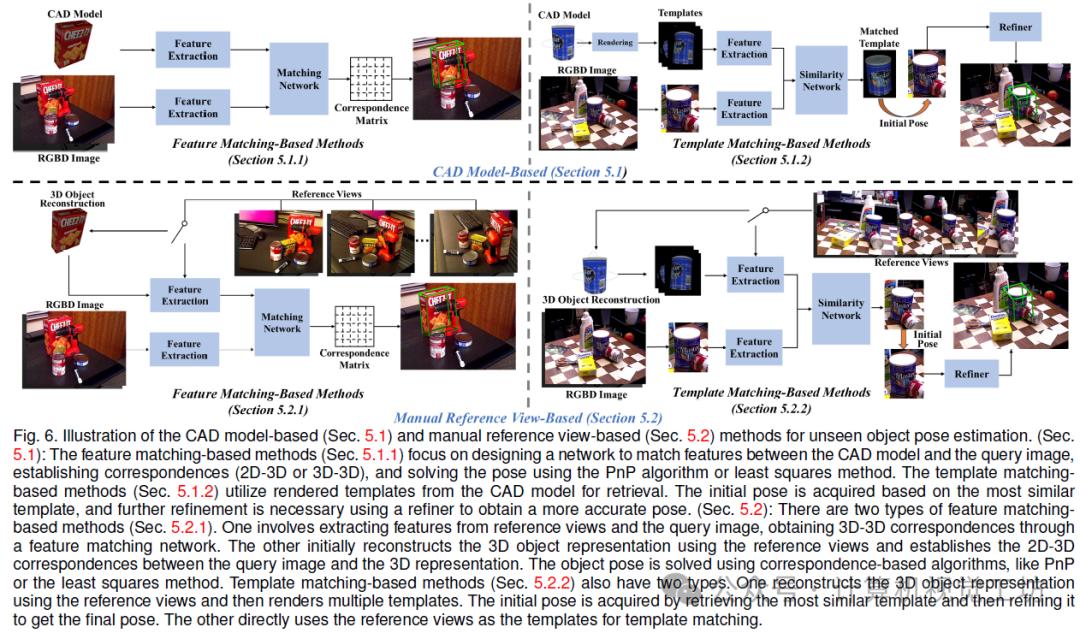

隐形物体姿态估计方法能够推广到未见过的物体,无需重新训练。点对特征(PPF)[11]是一种用于隐形物体姿态估计的经典方法,它利用了定向点对特征和快速投票方案。然而,PPF存在准确率低和运行时间慢的问题,限制了其适用性。相比之下,基于深度学习的方法利用神经网络从数据中学习更复杂的特征,而无需手动设计特征工程,从而提高了准确性和效率。在本节中,我们回顾了基于深度学习的隐形物体姿态估计方法,并将它们分类为基于CAD模型(第5.1节)和基于手动参考视图(第5.2节)的方法。这两类方法的示意图如图6所示。

5.1 基于CAD模型的方法

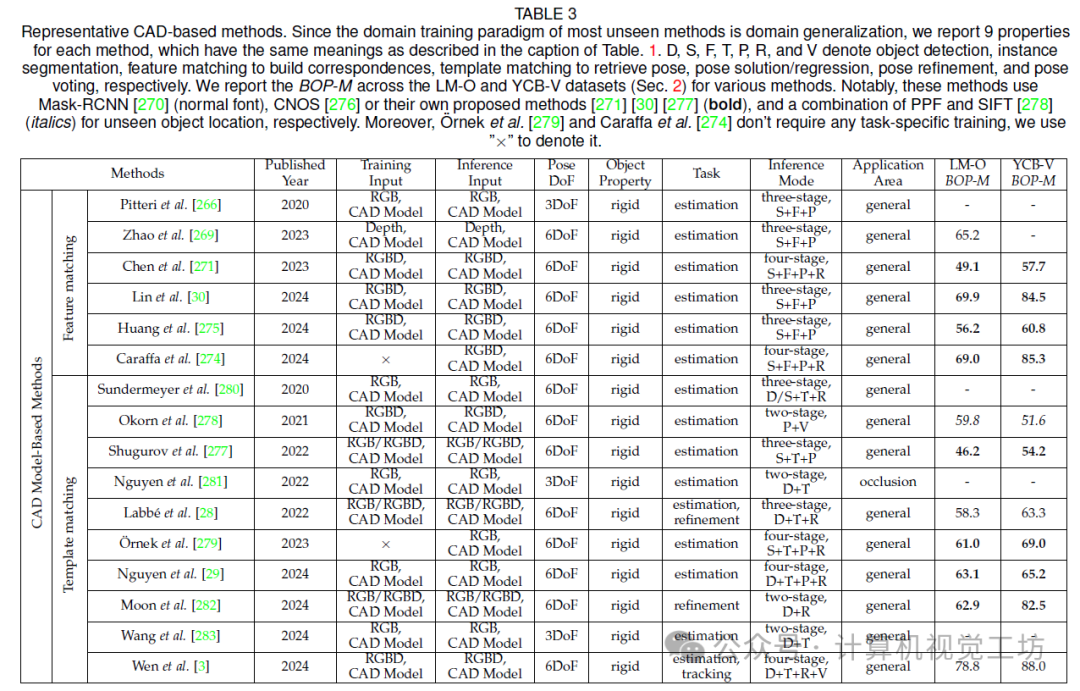

基于CAD模型的方法在估计隐形物体姿态的过程中利用了物体CAD模型作为先验知识。这些方法可以进一步分类为基于特征匹配和基于模板匹配的方法。基于特征匹配的方法(第5.1.1节)着重于设计一个网络来匹配CAD模型和查询图像之间的特征,建立2D-3D或3D-3D对应关系,并通过PnP算法或最小二乘法解决姿态问题。基于模板匹配的方法(第5.1.2节)利用CAD模型的渲染模板进行检索。初始姿态是根据最相似的模板获得的,进一步的细化需要使用一个细化器来获得更准确的姿态。这两类方法的示意图如图6所示。一些代表性方法的特性和性能如表3所示。

5.1.1 基于特征匹配的方法

作为早期的探索性工作,Pitteri等人提出了一种近似物体几何的3DoF姿态估计方法,仅使用CAD模型的角点。然而,为了有效工作,需要训练和测试物体之间的高度相似性。因此,Pitteri等人进一步引入了一种嵌入,捕捉了物体表面上3D点的局部几何。匹配这些嵌入可以创建2D-3D对应关系,然后使用PnP+RANSAC算法确定姿态。然而,这些方法只能估计3DoF姿态。Gou等人定义了估计未见物体6DoF姿态的挑战,并通过在物体和场景点云之间识别3D对应关系提供了一个基线解决方案。同样,Hagelskjær等人训练了一个网络,将CAD模型中的关键点与物体点云匹配。然而,它专注于具有同质箱子的箱子拾取,这只是表明了在受限制的场景中泛化姿态估计可以取得出色的性能。受到对未见物体的点云配准方法的启发,Zhao等人提出了一种基于几何对应的方法,利用通用和物体不可知的几何特征建立明确和稳健的3D-3D对应关系。然而,它仍然需要通过其他方法(如Mask-RCNN)获取未见物体的类标签和分割掩码。为此,Chen等人探索了一个名为ZeroPose的框架,实现了未见物体的联合实例分割和姿态估计。具体而言,他们利用基础模型SAM生成可能的物体提议,并采用模板匹配方法完成实例分割。之后,他们基于GeoTransformer开发了一个分层几何特征匹配网络来建立对应关系。在ZeroPose之后,Lin等人设计了一个新的匹配得分,从语义、外观和几何角度获得更好的分割。至于姿态估计,他们提出了一个两阶段的局部到局部点匹配模型,有效构建了密集的3D-3D对应关系。

除了使用几何特征的这些方法之外,Caraffa等人设计了一种融合来自不同预训练模型的视觉和几何特征的方法,以增强姿态预测的稳定性和准确性。这是利用几何和视觉基础模型之间的协同作用来估计未见物体姿态的第一种技术。此外,Huang等人提出了一种从RGBD图像预测物体姿态的方法,通过结合2D纹理和3D几何线索。

总的来说,基于特征匹配的方法旨在提取通用的物体不可知特征,并通过匹配这些特征来获得强大的对应关系。然而,这些方法不仅需要稳健的特征匹配模型,还需要量身定制的设计来增强物体特征的表达,提出了重大挑战。

5.1.2 基于模板匹配的方法

模板匹配在计算机视觉中被广泛应用,并且是解决隐形物体姿态估计挑战的有效方法。Wohlhart等人和Balntas等人是使用深度姿态描述符进行对象匹配和姿态检索的先驱。然而,他们的描述符针对特定方向和类别进行了定制,限制了它们对外观相似的物体的实用性。相反,Sundermeyer等人提出了一种单编码器多解码器网络,用于同时估计多个物体的3D旋转。该方法消除了在潜在空间中分离不同物体视图的需要,并在编码器中实现了共享特征。然而,它仍然需要训练多个解码器来推广到未见物体。Wen等人解决了这个问题,通过在潜在表示中解耦物体形状和姿态,实现了自动编码,而无需为不同物体使用多路径解码器,从而提高了可扩展性。

Okorn等人不是训练网络来学习跨对象的特征,而是首先通过PPF生成候选姿态,并将每个姿态投影到场景中。随后,他们设计了一个评分网络,通过比较投影物体点云与RGBD图像之间的颜色和几何差异来评估假设。Busam等人将6DoF姿态检索重新表述为动作决策过程,并通过迭代地估计可能的移动来确定最终姿态。Cai等人从目标物体视点代码本中检索各种候选视点,然后在每个检索到的候选视点上进行平面内2D旋转回归,以获得一组3D旋转估计。使用一致性得分来评估这些估计值,生成最终的旋转预测。与此同时,Shugurov等人将检测到的对象与渲染数据库进行匹配,用于初始视点估计。然后,他们通过特征匹配明确预测模板和图像之间的密集2D-2D对应关系。姿态估计最终通过使用PnP+RANSAC或Kabsch+RANSAC来执行。

由于估计未见物体的完整6DoF姿态极具挑战性,一些工作集中于估计3D旋转以简化问题。与之前的作品不同,Nguyen等人使用CNN提取的局部特征来比较输入图像与模板之间的相似性,显示出更好的性能和遮挡鲁棒性。另一个值得注意的方法是基于多尺度局部相似性的图像检索框架,由Zhao等人开发。他们从输入图像中提取不同大小的特征图,并设计了一个相似性融合模块,以从多尺度配对特征图中稳健地预测图像相似度得分。此外,Thalhammer等人和Ausserlechner等人扩展了Nguyen等人的方案,并证明了预训练的Vision-Transformer (ViT)在模板匹配方面优于任务特定的微调CNN。然而,这些方法在已见和未见物体之间仍然存在明显的性能差距。为此,Wang等人引入了扩散特征,展示了在建模未见物体方面的巨大潜力。此外,他们设计了三个聚合网络,以有效地捕捉和聚合不同粒度的扩散特征,从而提高了其泛化能力。

为了进一步提高6DoF姿态估计的泛化性和鲁棒性,Labb´e等人使用了一种渲染比较方法和粗到细的策略。值得注意的是,他们利用大规模3D模型数据集生成了一个包含200万张图像和20000个模型的合成数据集。通过在此数据集上训练网络,它实现了强大的泛化性能。与Labb´e等人的不可微渲染管道不同,Tremblay等人利用了可微渲染的最新进展,设计了一个灵活的细化器,允许在无需重新训练的情况下对设置进行微调。另一方面,Moon等人提出了一种形状约束的循环流框架,用于预测模板和查询图像之间的光流,并迭代地优化姿态。它直接利用形状信息来提高准确性和可扩展性。最近,Wen等人继承了Labb´e等人的思想,并使用新兴的大规模3D模型数据库、大语言模型(LLMs)和扩散模型开发了一种新颖的合成数据生成流程。它极大地扩展了数据的数量和多样性,最终以渲染比较的方式实现了与实例级方法可比较的结果。

众所周知,基于模板匹配的方法对遮挡非常敏感,并且需要大量时间来匹配大量模板。因此,Nguyen等人通过在模板匹配和补丁对应之间找到合适的权衡来实现快速而稳健的姿态估计。特别是,使用ViT提取查询图像和模板的特征,然后使用次线性最近邻搜索进行快速模板匹配。最相似的模板为方位和俯仰提供了两个DoFs,而剩余的四个DoFs则通过在查询图像和该模板之间建立对应关系来获得。O¨rnek等人利用DINOv2提取查询图像和模板的描述符。此外,他们介绍了一种基于从DINOv2补丁描述符构建的视觉词的快速模板检索方法,从而减少了对大量数据的依赖,并提高了与Labb´e等人相比的匹配速度。

总之,基于模板匹配的方法充分利用了大量模板提供的优势,实现了高精度和强泛化性。然而,它们在时间消耗、对遮挡的敏感性以及复杂背景和光照变化带来的挑战方面存在局限性。

无论是上述基于特征匹配的方法还是基于模板匹配的方法,它们都需要目标物体的CAD模型提供先验信息。在实践中,精确的CAD模型通常需要专门的硬件来构建,这在一定程度上限制了这些方法的实际应用。

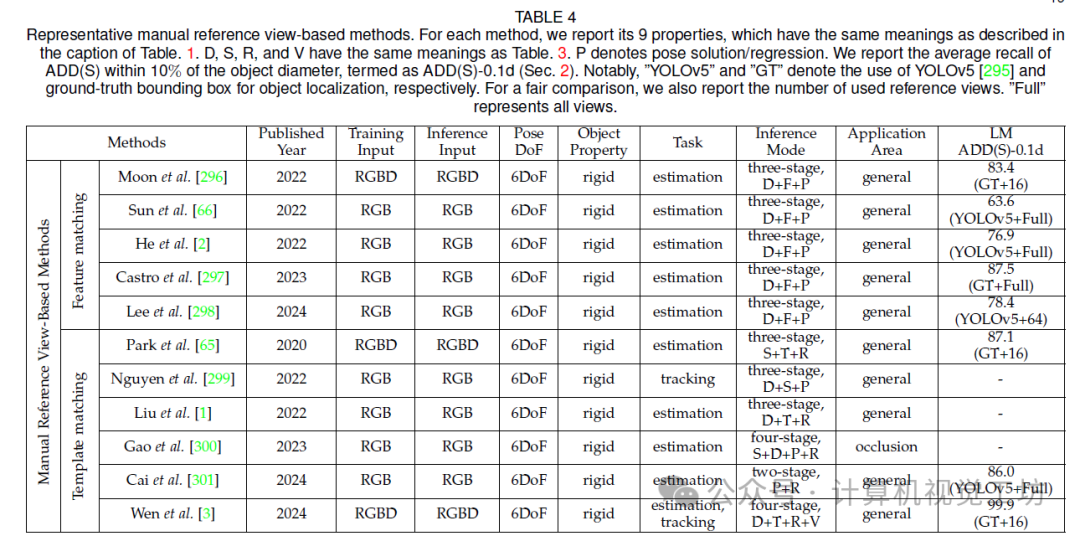

5.2 基于手动参考视图的方法

除了这些基于CAD模型的方法外,还有一些不需要未见物体CAD模型作为先决条件的手动参考视图的方法,而是需要提供一些手动标记的目标物体的参考视图。与基于CAD模型的方法类似,这些方法也分为两种类型:基于特征匹配的(第5.2.1节)和基于模板匹配的(第5.2.2节)方法。这两种类别的方法在图6中进行了说明。一些代表性方法的属性和性能在表4中显示。

5.2.1 基于特征匹配的方法

与基于CAD模型的特征匹配方法不同,手动参考视图的特征匹配方法主要在RGBD查询图像与RGBD参考图像之间建立3D-3D对应关系,或在查询图像与由参考视图重建的稀疏点云之间建立2D-3D对应关系。随后,根据不同的对应关系解决物体姿态问题。

He等人提出了第一种少样本6DoF物体姿态估计方法,它可以通过几个支持视图估计未见物体的姿态,而无需额外的训练。具体地说,他们设计了一个基于变压器的密集RGBD原型匹配框架,以充分探索查询图像和支持视图之间的语义和几何关系。Corsetti等人使用文本提示进行对象分割,并将问题重新表述为两个场景之间的相对姿态估计。相对姿态通过点云配准获得。

一些方法从重建后的匹配角度采取了另一种路径。Wu等人开发了一种基于全局注册的方法,该方法使用参考和查询图像重建全景和单视图模型,然后在两个模型之间搜索点匹配。Sun等人从视觉定位中汲取灵感,并修改了管道以适应姿态估计。更确切地说,他们使用所有参考视点的RGB序列重建了未见物体的Structure from Motion (SfM)模型。然后,他们通过图注意力网络将查询图像中的2D关键点与SfM模型中的3D点进行匹配。然而,由于其依赖于可重复检测到的关键点,它在低纹理物体上表现不佳。

为了解决这个问题,He等人[2]设计了一种新的无关键点的SfM方法,根据LoFTR的无检测器特征匹配方法,基于低纹理对象的半密点云模型重建了点云模型。

不幸的是,这些作品仍然需要密集的支持视图(即≥ 32个视图)。为了解决这个问题,范等人将6DoF物体姿态估计任务转化为目标视图中检索到的物体与参考视图之间的相对姿态估计。只给定一个参考视图,他们通过使用DINOv2模型进行全局匹配和使用LoFTR模型进行局部匹配来实现。这再次展示了预训练的大规模模型在未见物体姿态估计应用中的巨大潜力。然而,Castro等人指出这些预训练的特征匹配模型无法捕捉用于姿态估计的最优关键点描述,因为它们并不是为姿态估计而设计的。

为了克服这个问题,他们提出了一个新的物体关键点匹配和物体网格生成框架,能够通过几何特征匹配来实现更稳健的姿态估计。具体来说,他们使用生成对抗网络(GAN)生成具有真实形状的3D物体模型,并训练了一个特征匹配模型,用于区分两个关键点描述的对应关系。

总的来说,手动参考视图的方法通过匹配查询图像和参考视图之间的特征来实现未见物体姿态估计。然而,它们的性能高度依赖于特征匹配模型的性能,尤其是在挑战性的纹理条件下。

5.2.2 基于模板匹配的方法

与基于CAD模型的模板匹配方法不同,手动参考视图的模板匹配方法主要利用重建后的RGBD参考视图作为模板,并根据其与查询图像的相似性来解决姿态问题。具体而言,通过密集的RGBD重建,可以轻松地从参考视图中提取特征,并将其与查询图像进行比较。

Teng等人提出了一种多层次特征聚合的方法,将双流网络用于RGB和深度信息。基于对齐的注意力机制,他们可以从不同层次的特征图中提取有关物体的多尺度表示。由于可以处理不同尺度和分辨率的输入,该方法在噪声和遮挡的情况下表现出良好的稳健性。相似地,Hao等人设计了一种用于RGBD图像的多层次特征聚合网络,可以有效地解决部分遮挡和噪声干扰问题。利用传统的PnP算法,可以进一步实现6DoF姿态估计。

值得一提的是,一些方法通过渲染参考视图并与查询图像进行比较来解决问题。Zhao等人通过使用检测到的物体三维关键点,然后通过深度图转换为3D空间,并在渲染的虚拟参考视图中检测匹配的关键点,从而实现了稳健的物体姿态估计。这样的方法通过在关键点和视图之间建立2D-3D对应关系,从而进一步提高了性能。

总之,基于模板匹配的方法通过比较查询图像和参考视图之间的相似性来实现未见物体姿态估计。然而,与基于特征匹配的方法不同,它们无法建立明确的3D-3D对应关系,从而限制了它们的性能。

6. 应用

随着物体姿态估计技术的进步,已经部署了几个利用这一进展的应用。在本节中,我们将详细阐述这些应用的发展趋势。具体来说,这些应用包括机器人操纵(第6.1节)、增强现实(AR)/虚拟现实(VR)(第6.2节)、航空航天(第6.3节)、手-物体交互(第6.4节)和自动驾驶(第6.5节)。时间上的概览如图7所示。

6.1 机器人操纵

我们将机器人操纵应用分为实例级别、类别级别和未见过的对象。这种分类有助于更好地理解不同级别之间的挑战和要求。

6.1.1 实例级别操纵

为了解决训练期间标注真实数据的挑战,许多作品利用合成数据进行训练,因为它易于获取和标注。同时,合成数据可以模拟各种场景和环境变化,从而有助于提高机器人操纵的适应性。李等人使用了大规模的合成数据集和小规模的弱标记的真实世界数据集,以降低系统部署的难度。此外,陈等人提出了一个迭代的自训练框架,使用在合成数据上训练的教师网络为真实数据生成伪标签。与此同时,付等人仅基于物理渲染训练了合成图像。合成数据的一个关键挑战是与现实之间的差距,Tremblay等人通过将域随机化与真实数据结合起来成功地克服了这一挑战。

处理堆叠遮挡场景是另一个重要的挑战,特别是在工业自动化和物流中。在这些场景中,机器人必须准确识别并定位叠放在一起的物体,这需要一种有效的遮挡物体和准确的姿态估计过程。董等人认为,来自同一对象的点的回归姿态应紧密驻留在姿态空间中。因此,这些点可以被聚类到不同的实例中,并且它们对应的对象姿态可以同时估计。该方法可以处理严重的物体遮挡。此外,庄等人建立了一个端到端的流水线,从未分段的点云中同步回归所有潜在的对象姿态。最近,Wada等人提出了一个系统,充分利用了识别到的准确对象CAD模型和未识别结构的非参数重建,以实时估计遮挡对象的姿态。

低纹理对象缺乏物体表面纹理信息,使得机器人操纵具有挑战性。因此,张等人提出了一种用于无纹理工业零件的姿态估计方法。贫乏的表面纹理和亮度使得计算具有区分性的局部外观描述符具有挑战性。该方法通过优化边缘图像中的姿态来实现更准确的结果。此外,张等人通过使用一个基于多视图几何的无模型方法估计对象姿态来进行透明对象抓取。在农业场景中,Kim等人构建了一个基于3D模拟环境的自动化数据收集方案,实现了目标水果的三级成熟度分类和姿态估计。

6.1.2 类别级别操纵

为了研究类别级别对象姿态估计在机器人操纵中的应用,刘等人引入了一种细分引导的类别级别方法,其中包含了对机器人抓取的形状变形。余等人提出了一种基于形状先验的方法,并探索了其在机器人抓取中的应用。此外,刘等人开发了一个具有预定义向量方向的机器人连续抓取系统,基于形状变换器引导的对象姿态估计。为了提高效率并使姿态估计方法能够应用于具有更高实时要求的任务,孙等人利用帧间一致的关键点来执行空中操纵的对象姿态跟踪。为了进一步避免在现实场景中进行手动数据注释,余等人构建了一个机器人抓取平台,并设计了一种基于自我监督的类别级别机器人抓取方法。最近,刘等人探索了一种对比学习引导的无先验对象姿态估计方法,用于领域通用机器人拾取。

6.1.3 未见过的对象操纵

由于未见过的对象姿态估计属于新兴研究,目前缺乏专门设计的机器人。在这里,我们报道了几种通过机器人操纵验证未见过的对象姿态估计效果的方法。Okorn等人提出了一种在混乱环境中进行零样本对象姿态估计的方法。通过评分姿态假设并选择最高评分的姿态,他们成功地使用机器人手臂抓住了一种新型钻头。Labb´e等人和Wen等人采用了渲染与比较策略,并在大规模合成数据集上训练了网络,结果表现出了出色的泛化能力。他们通过机器人抓取实验进一步验证了他们方法的有效性。

6.2 增强现实/虚拟现实

物体姿态估计在AR和VR领域有着各种特定的应用。在AR中,准确的姿态估计可以实现虚拟对象精确地叠加到现实世界上。VR技术的关键在于跟踪头戴式显示器的姿态和3D空间中的控制器。

苏等人将两种CNN架构合并成一个新网络,由状态估计分支和姿态估计分支组成,明确在合成图像上进行训练,以实现AR组装应用。Pandey等人介绍了一种自动标注手持对象姿态在摄像机空间的方法,解决了手持控制器的有效6自由度姿态跟踪问题,从自我中心摄像机的视角来看。刘等人提出了一个通用的无模型6自由度对象姿态估计器,实现了完整的对象检测和姿态估计过程。通过简单地捕获未见对象的参考图像并检索参考图像的姿态,该方法可以预测任意查询图像上的对象姿态,并且可以轻松应用于AR/VR应用中的日常对象。何等人采用了重建策略后进行匹配,建立了查询图像与参考视图的重建点云之间的对应关系。该方法不依赖于关键点匹配,并且可以在低纹理对象上进行AR应用。Wen等人通过采用大规模综合训练和创新的基于变压器的架构实现了强大的泛化能力。该方法已成功应用于包括增强现实(AR)和机器人操纵在内的各个领域。

6.3 航空航天

在空间中估计对象的姿态存在着与地球环境中不常见的独特挑战。最显著的区别之一是缺乏大气散射,使得对象可以在长距离内可见,同时使光照条件复杂化。在轨道接近操作中,进行空间会合、对接和除夕物体移除需要在各种光照条件下精确估计姿态,并且需要在高纹理背景上进行估计。Proenc¸a等人提出了URSO,这是一个在虚幻引擎4上开发的模拟器,用于生成绕地球轨道运行的航天器的带注释图像,这些图像可以用于航空航天应用中的宝贵数据。胡等人提出了一种编码器-解码器架构,可可靠地处理在挑战性条件下的大规模变化,增强了鲁棒性。Wang等人介绍了一个反事实分析框架,以实现复杂背景中太空目标的鲁棒姿态估计。Ulmer等人为对象生成了多个姿态假设,并引入了一个像素级后验公式来估计每个假设的概率。这种方法可以处理极端的视觉条件,包括过曝光、高对比度和低信噪比。

6.4 手-物体交互

当人类/机器人与物理世界进行交互时,他们主要通过手来完成。因此,准确理解手如何与物体交互至关重要。手-物体交互通常依赖于对象CAD模型,并且从日常生活场景中获取对象CAD模型具有挑战性。为了克服这一限制,Patten等人重建了高质量的对象CAD模型,以减少在手-物体交互中对对象CAD模型的依赖。为了进一步增强手-物体交互,林等人利用了一种有效的注意力模型来改进手和物体特征的表示能力,从而提高了手和物体姿态估计的准确性。这种方法对底层几何结构的利用有限,导致对视觉特征的增加依赖。当物体缺乏视觉特征或这些特征被遮挡时,性能可能会下降。因此,Rezazadeh等人引入了一种分层图神经网络架构,结合了多模态(视觉和触觉)数据,以补偿视觉缺陷并提高鲁棒性。此外,齐等人引入了一种由符号距离场(SDF)引导的手-物体姿态估计网络,该网络同时利用了手和物体的SDF,提供了完整的全局隐式表示。这种方法有助于在遮挡场景中引导手和物体的姿态估计。

6.5 自动驾驶

物体姿态估计可用于感知周围的车辆、行人和障碍物,从而帮助自动驾驶系统及时做出决策。为了解决自动驾驶中的姿态估计问题,Hoque等人提出了基于深度混合结构的6自由度姿态假设。最近,孙等人设计了一种有效的关键点选择算法,考虑了机器人车厢检查场景内面板对象的形状信息,解决了高度可变面板对象的6自由度姿态估计的挑战。

7. 结论 & 未来方向

在本调查中,我们系统地概述了最新的基于深度学习的物体姿态估计方法,涵盖了全面的分类、优势和劣势的比较,以及其应用的探索。尽管取得了巨大的成功,但仍然存在许多挑战,如第3节、第4节和第5节所讨论的。基于这些挑战,我们进一步指出了一些有前景的未来方向,旨在推动物体姿态估计的研究。

从标签有效学习的角度来看,流行的方法主要依赖于利用真实世界的标记数据进行训练。然而,手动收集和注释训练数据的劳动密集性是被广泛承认的。因此,我们主张探索标签有效学习技术用于物体姿态估计,可以通过以下途径实现:1)LLM/LVM引导的弱/自监督学习方法。随着预训练LLM/LVM的快速进展,通过无监督方式在各种场景中的多样化应用已成为可能。利用LLM/LVM作为先验知识在物体姿态估计中探索弱或自监督学习技术是有希望的。2)从合成到现实领域适应和泛化方法。由于通过手动努力获取真实世界训练数据的成本高昂,合成数据生成提供了一种成本效益的替代方案。我们相信,通过探索从合成到真实世界领域的领域适应和泛化技术,我们可以减少领域差距,并实现合成数据训练的模型对真实世界应用的泛化能力。

在应用方面,促进物体姿态估计方法在移动设备和机器人上的部署至关重要。我们认为,通过以下方法可以提高现有方法的部署性:1)集成检测或分割的端到端方法。当前的SOTA方法通常需要使用预训练模型进行初始对象检测或分割,然后将图像输入姿态估计模型(间接姿态估计模型甚至需要使用不可微分的PnP或Umeyama算法来解决姿态),这使得部署复杂化。未来的研究可以通过探索集成检测或分割的端到端物体姿态估计方法,从而在移动设备和机器人上增强部署性。2)基于单个RGB图像的方法。鉴于大多数移动设备(如智能手机和平板电脑)缺乏深度摄像头,使用单个RGB图像对未见对象姿态进行高精度估计至关重要。由于2D图像中固有的几何限制,未来的研究可以探索基于LVM的单眼深度估计方法,通过结合场景级深度信息来提高单眼对象姿态估计的准确性。3)模型轻量化。现有的SOTA模型通常具有大量参数和低效的运行性能,这对于具有有限计算资源的移动设备和机器人构成了挑战。未来的工作可以探索有效的轻量级方法,例如师生模型,以研究减少模型参数数量(GPU内存)和提高模型运行效率。

现有的方法主要设计用于常见对象和场景,使其对具有挑战性的对象和场景无效。我们相信通过以下途径可以提高适用性:1)关节对象姿态估计。关节对象(如衣物和抽屉)相比刚性对象具有多个自由度和显着的自遮挡,使得姿态估计具有挑战性。未来的工作可以探索关节对象姿态估计,以增强对象分类、检测和跟踪任务的准确性。2)无着色/低纹理对象姿态估计。大多数现有的方法都依赖于输入图像的颜色信息,使其对无着色/低纹理对象无效。由于无着色/低纹理对象通常缺乏清晰的边缘和纹理信息,这使得提取区分性特征和准确估计对象姿态变得具有挑战性。未来的工作可以通过探索使用多模态输入(如形状、纹理和深度)来解决这一问题。3)遮挡对象姿态估计。大多数现有的方法都依赖于全局特征,使其对于遮挡对象无效。未来的工作可以通过探索结合全局和局部特征以及关系推理来解决遮挡对象姿态估计问题。

通过这些有前景的未来方向,我们相信物体姿态估计的研究将取得更加丰硕的成果,并在实际应用中得到更广泛的应用。

0. 参考

[1] Deep Learning-Based Object Pose Estimation: A Comprehensive Survey

计算机视觉工坊交流群

目前我们已经建立了3D视觉方向多个社群,包括2D计算机视觉、大模型、工业3D视觉、SLAM、自动驾驶、三维重建、无人机等方向,细分群包括:

2D计算机视觉:图像分类/分割、目标/检测、医学影像、GAN、OCR、2D缺陷检测、遥感测绘、超分辨率、人脸检测、行为识别、模型量化剪枝、迁移学习、人体姿态估计等

大模型:NLP、CV、ASR、生成对抗大模型、强化学习大模型、对话大模型等

工业3D视觉:相机标定、立体匹配、三维点云、结构光、机械臂抓取、缺陷检测、6D位姿估计、相位偏折术、Halcon、摄影测量、阵列相机、光度立体视觉等。

SLAM:视觉SLAM、激光SLAM、语义SLAM、滤波算法、多传感器融合、多传感器标定、动态SLAM、MOT SLAM、NeRF SLAM、机器人导航等。

自动驾驶:深度估计、Transformer、毫米波|激光雷达|视觉摄像头传感器、多传感器标定、多传感器融合、自动驾驶综合群等、3D目标检测、路径规划、轨迹预测、3D点云分割、模型部署、车道线检测、BEV感知、Occupancy、目标跟踪、端到端自动驾驶等。

三维重建:3DGS、NeRF、多视图几何、OpenMVS、MVSNet、colmap、纹理贴图等

无人机:四旋翼建模、无人机飞控等

除了这些,还有求职、硬件选型、视觉产品落地、最新论文、3D视觉最新产品、3D视觉行业新闻等交流群

添加小助理: dddvision,备注:研究方向+学校/公司+昵称(如3D点云+清华+小草莓), 拉你入群。

3D视觉学习知识星球

3D视觉从入门到精通知识星球、国内成立最早、6000+成员交流学习。包括:星球视频课程近20门(价值超6000)、项目对接、3D视觉学习路线总结、最新顶会论文&代码、3D视觉行业最新模组、3D视觉优质源码汇总、书籍推荐、编程基础&学习工具、实战项目&作业、求职招聘&面经&面试题等等。欢迎加入3D视觉从入门到精通知识星球,一起学习进步。

3DGS、NeRF、结构光、相位偏折术、机械臂抓取、点云实战、Open3D、缺陷检测、BEV感知、Occupancy、Transformer、模型部署、3D目标检测、深度估计、多传感器标定、规划与控制、无人机仿真、三维视觉C++、三维视觉python、dToF、相机标定、ROS2、机器人控制规划、LeGo-LAOM、多模态融合SLAM、LOAM-SLAM、室内室外SLAM、VINS-Fusion、ORB-SLAM3、MVSNet三维重建、colmap、线面结构光、硬件结构光扫描仪,无人机等。

3D视觉相关硬件

| 图片 | 说明 | 名称 |

|---|---|---|

| 硬件+源码+视频教程 | 精迅V1(科研级))单目/双目3D结构光扫描仪 |

| 硬件+源码+视频教程 | 深迅V13D线结构光三维扫描仪 |

| 硬件+源码+视频教程 | 御风250无人机(基于PX4) |

| 硬件+源码 | 工坊智能ROS小车 |

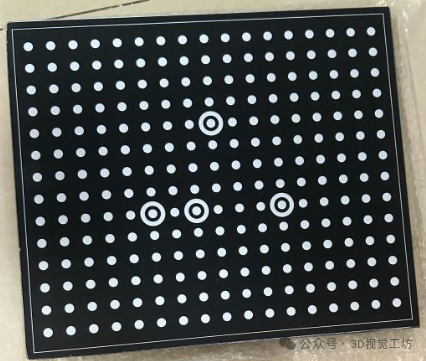

| 配套标定源码 | 高精度标定板(玻璃or大理石) |

| 添加微信:cv3d007或者QYong2014 咨询更多 | ||

256

256

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?