《白话机器学习的数学》笔记01

目前以立石贤吾的《白话机器学习的数学》一书来作为深度学习的入门基础第一本参考书。意在了解机器学习与深度学习中所用到的基础数学知识与数学模型。

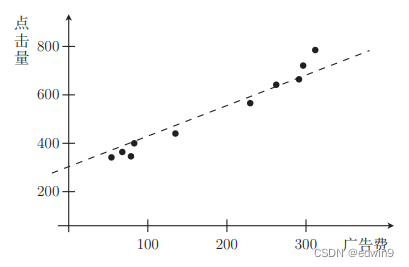

学习回归

先从最基本的线性回归问题开始学习

fθ(x) = θ0 + θ1x

参数表达:在统计学领域,常常使用 θ 来表示未知数和推测值,更易于理解。函数表达同样如此,如上式就表示一个含有参数 θ,并且和变量 x 相关的函数

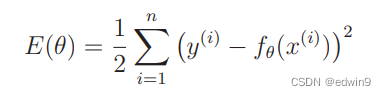

最小二乘法

目的是使目标函数(误差函数)达到最小值。

1/2是为了给之后的微分约去2,并且这个比例只影响函数的横向状态,不影响最小值点的位置;平方则是因为微分起来比绝对值简单。

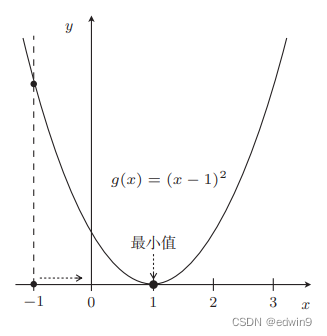

最速下降法

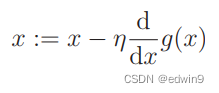

最速下降法/梯度下降法:向与导数的符号相反的方向移动 x,g(x) 就会自然而然地沿着最小值的方向前进,由此获得下式。

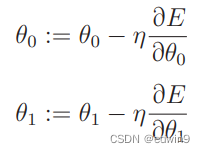

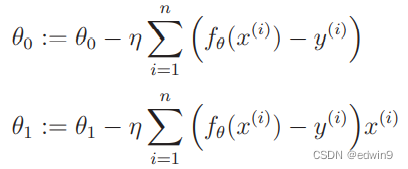

A := B 的意思是通过 B 来定义 A。η为学习率。η如果较大,那么前进距离可能过大,有可能产生“振荡”,甚至有可能远离最小值,即发散状态。而当 η 较小时,移动量也变小,更新次数就会增加,但是值确实是会朝着收敛的方向而去。

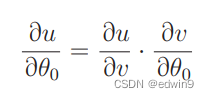

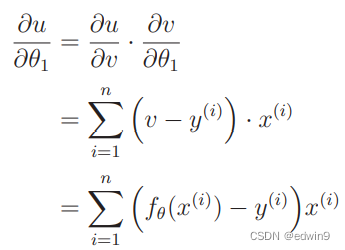

如果所求函数并非单未知量,如前面的目标函数有θ0 和θ1两个参数,就要使用偏微分,当参数包含于另一个函数中时就要采用复合函数的阶梯微分。

如下式所示:

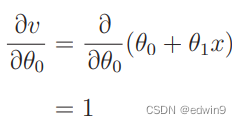

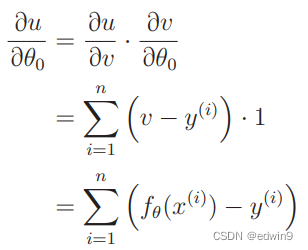

令u = E(θ) , v = fθ(x),先求θ0更新表达式

分别计算两个偏微分

由此可得

同理得对θ1的偏微分

最终写出两个参数的更新表达式

对于更高次的多项式回归,只需要对多出来的参数进行偏微分即可。

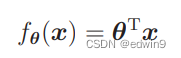

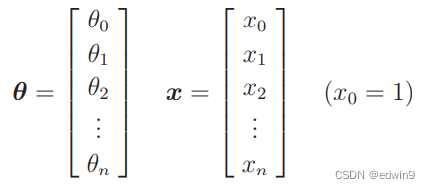

而对于更多自变量的多重回归,采取向量方式进行表达,更简洁明了。

最速下降法缺点:慢,容易陷入局部最优解

随机梯度下降法

随机选取数据索引进行参数更新,随机选择一小批即称为小批次梯度下降法。

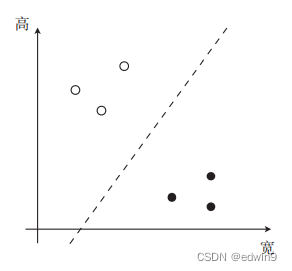

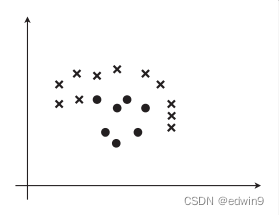

学习分类

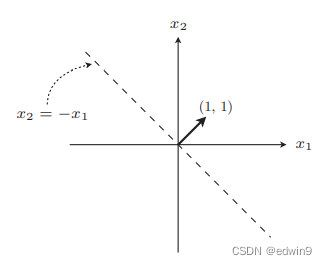

目标即为将有标签的训练数据分开。此线为使权重向量成为法线向量的直线(接下来会理解)

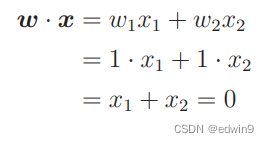

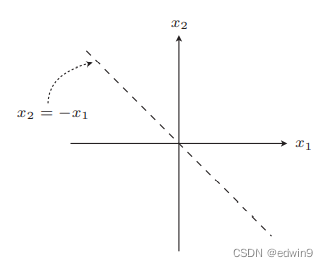

设权重向量为w = (1, 1)

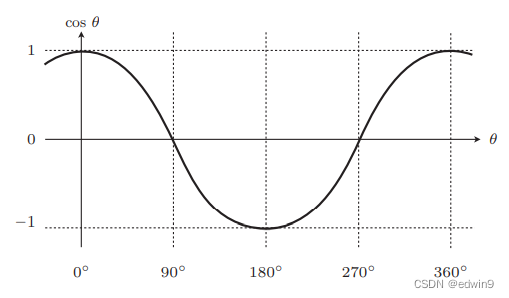

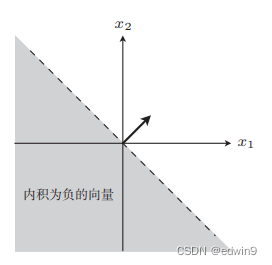

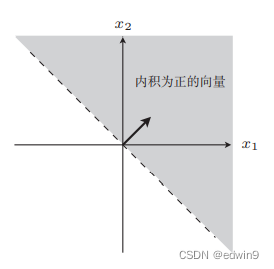

内积表达式为w · x = |w|·|x| · cos θ

所以要想使内积为0,只能使 cos θ = 0。要想使 cos θ = 0,也就意味着 θ = 90°或θ = 270°,这两种情况也是直角。

所以最终目的是找到与所画直线成直角的权重向量。

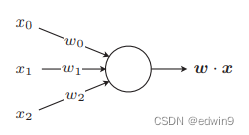

感知机

感知机是接受多个输入后将每个值与各自的权重相乘,最后输出总和的模型。

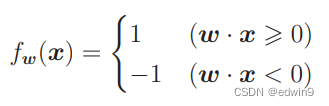

判别函数:

|w| 和 |x| 必定为正数,所以决定内积符号的是 cos θ,在 90◦°<θ< 270° 的时候 cos θ 为负。

内积是衡量向量之间相似程度的指标。结果为正,说明二者相似;为 0 则二者垂直;为负则说明二者不相似。

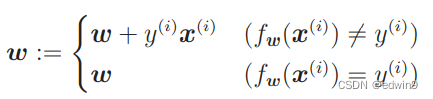

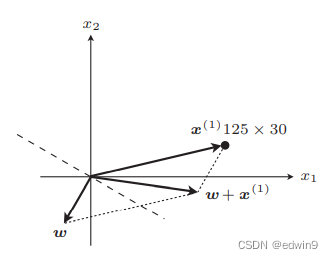

定义权重更新表达式:

后面括号中条件为判别函数的分类结果正不正确,只有在判别函数分类失败的时候才会更新参数值

前面式子的意义为判别错误时将权重向量与所选的数据向量相加,达到“靠近”真实数据的目的。

感知机的缺点是只能解决线性可分问题。

线性不可分问题下次再看。

860

860

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?