用于千兆像素全切片病理图像生存预测的多模态下跨模态注意机制的transformer

概念:

premutation invariance(置换不变):指输入顺序的改变不会影响输出值

permutation-equivariant(置换等边):与premutation invariance 相反,输出与输入的顺序有关。

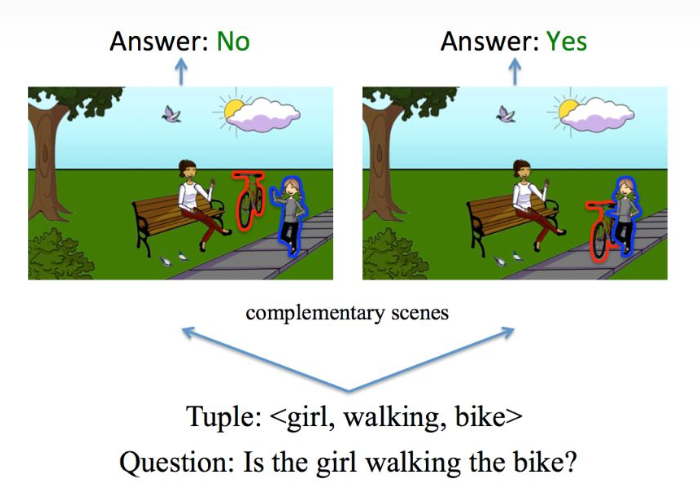

Visual Question Answer (VQA) 是对视觉图像的自然语言问答,作为视觉理解 (Visual Understanding) 的一个研究方向

什么叫做模态(Modality):每一种信息的来源或者形式,都可以称为一种模态。例如,人有触觉,听觉,视觉,嗅觉;信息的媒介,有语音、视频、文字等

1、摘要

在计算病理学中,生存结果的预测一直是比较有挑战的若监督任务、有序回归任务,它涉及到在千兆WSI的肿瘤微观环境中模拟复杂的相互作用。尽管在最近的多实例学习中将wsi转化为包的形式取得了一定的进展,但是对于整个WSI的表示学习仍然是一个开放的,有挑战性的问题,尤其是在一下几个方面:

- 在大的包中特征聚合的计算复杂度

- 对于纳入生物先验知识(例如基因测量)的数据异质性差异大

所以在这项工作中,作者提出了一个多模式共同注意力机制的transformer(MCAT)框架,该框架在WSIs和基因特征组成的嵌入空间学习有解释性的,密集的共同注意映射。

受到视觉问答(Visual question answering VQA)的启发:该方法可以确定,在回答问题时,单词嵌入是如何关注图像中的突出对象;当预测病人的生存情况时,MCAT学习病理图像是如何与基因相关的。除了可视化的多模式交互,1) 作者的共同注意力transformer减少了 WSI bags的空间复杂度,2)这也使得transformer 层在多实例学习中能够作为通用的编码器主干。作者将他们的方法运用在5个不同的癌症数据集上,实验结果证明,与最先进的方法相比,该方法始终取得最优异的性能。

1、Introduction

在许多学科中,深度学习已经彻底改变了计算机视觉任务,但是在计算病理学中,数千兆的wsi仍然是一个复杂有障碍的计算机视觉领域任务,这些障碍使得当前的方法对于有监督的学习任务

本文提出了一种名为MCAT的框架,用于在千兆像素全切片病理图像中进行生存预测。MCAT采用基因引导的跨模态注意力机制,学习在WSI和基因特征之间的密集注意力映射,解决了传统多实例学习方法在生存分析中的局限。实验证明,MCAT在多个癌症数据集上优于现有方法。

本文提出了一种名为MCAT的框架,用于在千兆像素全切片病理图像中进行生存预测。MCAT采用基因引导的跨模态注意力机制,学习在WSI和基因特征之间的密集注意力映射,解决了传统多实例学习方法在生存分析中的局限。实验证明,MCAT在多个癌症数据集上优于现有方法。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?