一.简介

贝叶斯分析方法(Bayesian Analysis)是贝叶斯学习的基础,它提供了一种计算假设概率的方法,这种方法是基于假设的先验概率、给定假设下观察到不同数据的概率以及观察到的数据本身而得出的。

二、具体步骤

- 1)确定先验概率:根据历史数据、经验或其他信息,确定事件或类别的初始概率分布。

- (2)收集新的证据或信息:这些证据或信息可以是新的观测数据、实验结果或其他相关信息。

- (3)计算条件概率:根据新的证据或信息,计算条件概率,即在给定新信息的情况下,事件或类别发生的概率。

- (4)应用贝叶斯定理:使用贝叶斯定理将先验概率和条件概率结合起来,计算后验概率。

- (5)根据后验概率做出决策或预测:根据计算得到的后验概率,对事件或类别进行分类、预测或做出其他决策。

三、代码

import numpy as np

class NaiveBayesClassifier:

def __init__(self):

self.class_probs = None

self.feature_probs = None

def fit(self, X, y):

n_samples, n_features = X.shape

self.classes = np.unique(y)

n_classes = len(self.classes)

# 计算每个类别的先验概率

self.class_probs = np.zeros(n_classes)

for i, c in enumerate(self.classes):

self.class_probs[i] = np.sum(y == c) / n_samples

# 计算每个特征在每个类别下的条件概率

self.feature_probs = np.zeros((n_classes, n_features))

for i, c in enumerate(self.classes):

X_c = X[y == c]

self.feature_probs[i] = (X_c.sum(axis=0) + 1) / (np.sum(X_c) + n_features) # Laplace smoothing

def predict(self, X):

predictions = []

for x in X:

class_probs_x = []

for i, c in enumerate(self.classes):

# 计算后验概率 P(y|X) ∝ P(X|y) * P(y)

class_prob_x = np.prod(self.feature_probs[i, np.where(x == 1)]) * self.class_probs[i]

class_probs_x.append(class_prob_x)

predicted_class = self.classes[np.argmax(class_probs_x)]

predictions.append(predicted_class)

return np.array(predictions)

def load_data():

# 加载训练数据和测试数据

# 这里使用西瓜数据集作为示例数据

# 西瓜数据集

# 根据色泽、根蒂、敲声三个特征来判断西瓜是好瓜(1)还是坏瓜(0)

# 色泽:0-青绿,1-乌黑,2-浅白

# 根蒂:0-蜷缩,1-稍蜷,2-硬挺

# 敲声:0-浊响,1-沉闷,2-清脆

X_train = np.array([[0, 0, 0], [0, 0, 1], [1, 0, 0], [2, 2, 0], [2, 2, 1],

[2, 2, 2], [1, 1, 0], [0, 0, 0], [0, 0, 1], [2, 0, 1]])

y_train = np.array(["坏瓜", "坏瓜", "好瓜", "好瓜", "好瓜", "坏瓜", "好瓜", "坏瓜", "坏瓜", "好瓜"])

X_test = np.array([[0, 0, 0], [1, 0, 1], [2, 2, 1]])

return X_train, y_train, X_test

def evaluate_model(y_true, y_pred):

# 计算分类器的准确率

accuracy = np.mean(y_true == y_pred)

return accuracy

if __name__ == "__main__":

# 加载数据

X_train, y_train, X_test = load_data()

# 创建朴素贝叶斯分类器并训练模型

classifier = NaiveBayesClassifier()

classifier.fit(X_train, y_train)

# 用户输入特征

print("请输入要预测的西瓜特征(色泽、根蒂、敲声):")

feature_input = []

for i in range(3):

feature = input(f"请输入第{i+1}个特征:")

feature_index = ["青绿", "乌黑", "浅白"].index(feature) if feature in ["青绿", "乌黑", "浅白"] else \

["蜷缩", "稍蜷", "硬挺"].index(feature) + 3 if feature in ["蜷缩", "稍蜷", "硬挺"] else \

["浊响", "沉闷", "清脆"].index(feature) + 6

feature_input.append(feature_index)

feature_input = np.array(feature_input)

# 使用训练好的模型进行预测

y_pred = classifier.predict([feature_input])

print("预测结果:", y_pred[0])

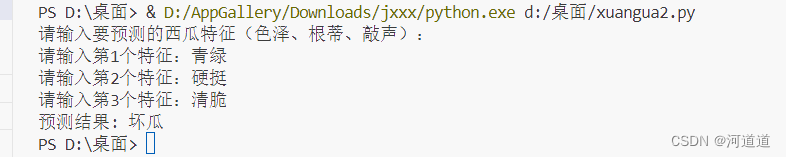

四、结果

五、问题与解决

-

数据预处理不足: 在实际应用中,需要对原始数据进行一些预处理操作,如缺失值处理、特征标准化或归一化等。

解决办法: 在加载数据之前,可以添加一些数据预处理步骤,例如处理缺失值、标准化特征等。 -

过拟合问题: 在训练模型时,可能会出现过拟合问题,导致模型在训练集上表现很好,但在测试集上表现不佳。

解决办法: 可以使用交叉验证、正则化等方法来减轻过拟合问题,或者简化模型结构。 -

特征选择问题: 选择了不合适的特征可能导致模型性能不佳。

解决办法: 可以通过特征分析、特征工程等方法选择和提取有效的特征,或者使用特征选择算法来自动选择特征。 -

类别标签处理不当: 在分类问题中,类别标签可能是字符串形式,需要转换成数值形式才能输入模型进行训练。

解决办法: 可以使用标签编码器(LabelEncoder)将类别标签转换为数值形式。 -

代码可读性差: 如果代码结构混乱,命名不规范,会降低代码的可读性和可维护性。

解决办法: 可以通过良好的代码组织、适当的注释和规范的命名来提高代码的可读性。 -

错误处理不完善: 如果没有对可能出现的错误进行处理,程序可能会在运行时崩溃。

解决办法: 可以添加适当的错误处理机制,例如使用 try-except 语句捕获异常,并给出友好的错误提示信息。

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?