第二篇博客 一篇关于pixelNeRF的论文的阅读

文章目录

摘要部分refinery

①我们提出pixelNeRF:一个学习框架,可以预先预测以一个或多个输入图像为条件的连续神经场景表示。

②老的NeRF缺点:需要许多校准的视图和大量的计算时间。

③引入了一种架构,以完全卷积的方式在图像输入上对NeRF进行条件。这允许网络在多个场景中进行训练,以便在之前学习一个场景,使其能够从一组稀疏的视图(只有一个)中以前馈方式执行新颖的视图合成。

④利用NeRF的体积渲染方法,我们的模型可以直接从图像中训练,无需清晰3D监督。

⑤我们对带有保留对象以及整个看不见类别的单图像新视图合成任务的ShapeNet基准进行了广泛的实验。我们通过在多对象ShapeNet场景和DTU数据集的真实场景上演示,进一步展示了像素-NeRF的灵活性。在所有情况下,pixelNeRF在新视图合成和单图像3D重建方面都优于当前最先进的基线。

一、introduction refinery

我们提出pixelNeRF:能够以前馈方式从一张或几张图像中预测NeRF。

与不使用任何图像特征的原始NeRF网络不同,pixelNeRF将空间图像特征与每个像素对齐作为输入。这允许框架在一组多视图图像上进行训练,通过先学习场景从一个或多个输入视图执行视图合成。

具体来步骤:

我们通过首先从输入图像计算全卷积图像特征网格来对输入图像进行条件处理NeRF。然后,对于视图坐标框架中感兴趣的每个查询空间点x和视图方向d,我们通过投影和双线性插值对相应的图像特征进行采样。查询规范与图像特征一起发送到输出密度和颜色的NeRF网络,其中空间图像特征作为残差馈送到每个层。当有多个图像可用时,输入首先被编码为每个相机坐标系中的潜在代表,然后在预测颜色和密度之前将其汇集在中间层中。该模型受到监督,在groundtruth图像和传统体积渲染技术渲染的视图之间存在重建loss。

PixelNeRF具有许多少样本合成的理想特性:

①pixelNeRF可以在多视图图像的数据集上进行训练,而无需额外的监督,如地面真值3D形状或对象掩码

②pixelNeRF在输入图像的相机坐标系中预测NeRF表示,而不是canonical坐标框架。这不仅是不可见场景和对象类别的概括性不可或缺的一部分,也是灵活性的组成部分,因为在具有多个对象或真实场景的场景上不存在明确的规范坐标系统

③它是完全卷积的,允许它保持图像和输出3D重复之间的空间对齐

④pixelNeRF可以在测试时合并可变数量的输入视图,而无需任何测试时间优化。

实验表明,pixelNeRF可以从单个图像输入中为特定or不可知类别设置生成新的视图,即使在看不见的对象类别的情况下也是如此。对于框架的灵活性,既使用ShapeNet的新多对象基准测试,其中pNeRF优于以前的方法,以及对真实汽车图像的模拟到真实传输演示。最后,我们使用DTU数据集在真实图像上测试pixelNeRF的能力,尽管在100个以下场景上进行了训练,但它可以从三个姿势的输入视图中生成真实场景的合理新颖视图。

二、related work refinery

1.新视图合成

有一些方法可以通过学习跨场景的共享先验,从少数输入视图甚至单个图像中预测新颖视图。传统方法使用深度引导图像插值。最近,探索了从单个图像预测新视图的问题。然而,这些方法采用2.5D表示,因此它们可以合成的相机运动范围有限。在这项工作中,我们推断出三维体积NeRF表示,该表示从更大的基线进行新颖的视图合成。

Sitzmann等人[39]引入了基于连续3D特征空间的表示,以跨场景实例学习先验。然而,在测试时间使用之前学到的,需要对已知的绝对相机姿势进行进一步优化。相比之下,我们的方法完全是前馈的,只需要相对的相机姿势。我们提供与这种方法的广泛比较,以展示我们的设计提供的广告优势。最后,请注意,并发工作[43]为NeRF添加了图像功能。一个关键的区别是,我们在视野中操作,而不是规范空间,这使得我们的方法适用于更一般的设置。此外,我们在几镜头视图合成中广泛展示了我们方法的表现,而GRF显示了这项任务的定量结果非常有限。

2.基于学习的3D重建

深度学习的进步导致了单视图或多视图3D重建的快速进展。许多方法提出了具有各种3D表示的学习框架,均需要真实的3D模型进行监督。而多视图限制更小更合理。然而,其中许多方法需要对象掩码;相比之下,pixelNeRF可以仅从图像进行训练,无需修改即可应用于两个对象的场景。

大多数单视图3D重建方法在输入图像上调节神经3D表示。大多数使用全局图像功能,虽然内存高效,但无法保留图像中存在的细节,通常会导致类似检索的结果。空间对齐的局部图像特征已被证明可以从单个视图实现详细的重建。然而,这两种方法都需要3D监督。我们的方法受到这些方法的启发,但只需要多视图监督。

在现有方法中,可以重建的场景类型是有限的,特别是对于以对象为中心的方法。CoReNet[31]通过带偏移量的体素网格重建具有多个对象的场景,但它需要3D监督,包括对象的身份和位置。我们制定了一个场景级学习框架,原则上可以训练到任意结构的场景。

3.以观众为中心的3D重建

对于3D学习任务,预测可以在以观众为中心的共坐标系统(即视图空间)或以对象为中心的共坐标系统(即规范空间)中完成。大多数现有的方法在规范空间中预测,其中语义类别的所有对象都与一致的引用对齐。虽然这使得学习空间规律性变得更容易,但使用规范空间会抑制在没有预定义或明确定义的规范姿势的看不见的物体类别和场景中的预测性能。PixelNeRF在视图空间中运行,这已被证明可以更好地重建看不见的对象类别,并阻止记住训练集。我们在表1中总结了我们与先前工作相关的关键方面。

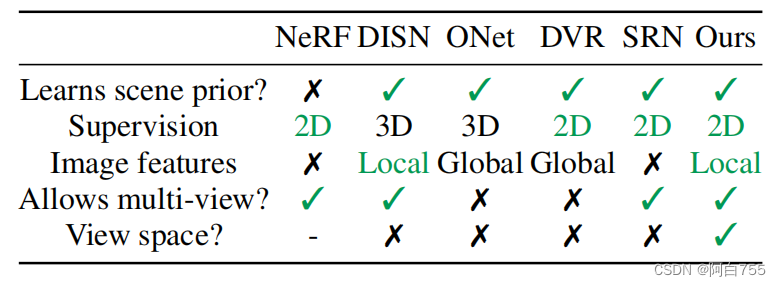

表1:与之前重建神经场景表示的工作的比较。

该方法仅使用多视图二维图像监督进行一个或少量视图重建。与之前的方法不同,我们不需要在整个训练语料库中使用一致的规范空间。此外,我们结合了局部图像特征来保存局部信息,这与将结构和外观压缩成单个潜在向量的方法不同,如占用网络(ONet)和DVR

三、背景refinery

1.公式

NeRF的原理公式

2.局限

NeRF是一种基于优化的方法,使用几何一致性作为唯一信号,类似于经典的多视图立体声方法。每个场景必须单独优化,场景之间没有知识共享。这不仅耗费时间,而且在单一或极稀疏视图的范围内,它无法利用任何先前的场景知识来加速重建或完成形状。

四、 image-condition NeRF

为了克服NeRF表示形式无法在场景之间共享知识,我们提出了一个架构来对空间图像特征进行NeRF的调节。我们的模型由两个部分组成:一个全卷积的图像编码器E,将输入图像编码成像素对齐的特征网格,以及一个NeRF网络f,它输出颜色和密度,给定空间位置及其匹配的编码特征。出于§2中讨论的原因,我们选择在输入视图的相机空间中对空间查询进行建模,而不是规范空间。

在下面,我们首先介绍我们的单视图案例模型。然后,我们展示了如何轻松地扩展此公式以合并多个输入图像。

4.1.单图像pixelNeRF

我们现在描述我们从一个输入图像呈现新颖视图的方法。我们将坐标系固定为输入图像的视图空间,并在此坐标系中指定位置和相机射线。

给定一个场景的输入图像I,我们首先提取一个特征体积W = E(I)。然后,对于相机射线x上的一个点,我们通过将x投影到图像平面上到图像坐标π(x)来检索相应的图像特征。然后在像素特征之间进行双线性插值,以提取特征向量W(π(x))。然后,图像特征与位置和视图方向一起传递到NeRF网络(都在输入视图坐标系中)

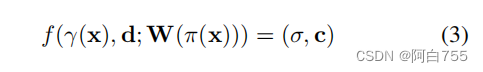

公式3

其中γ(·)是x上的位置编码,具有原始NeRF中引入的6个指数增加频率。图像功能被合并为每个层的残差。

在少样本视图合成任务中,查询视图方向是确定NeRF网络中特定图像特征的重要性的有用信号。如果查询视图方向与输入视图方向相似,模型可以更直接地依赖输入;如果它不同,模型必须利用之前学到的东西。此外,在多视图案例中,视图方向可以作为不同视图的相关性和定位的信号。因此,我们在NeRF网络的开头输入视图方向。

4.2. 合并多个视图

多个视图提供了有关场景的额外信息,并解决了单视图案例固有的3D几何模糊性。我们扩展了我们的模型,以允许在测试时提供任意数量的视图,这将我们的方法与现有方法区分开来,这些方法旨在仅在测试时使用单个输入视图。 此外,我们的模拟与世界空间的选择和输入视图的顺序无关。

如果我们有场景的多个输入视图,我们只假设相对的相机姿势是已知的。为了解释起见,可以为场景固定任意的世界坐标系。我们注意到第i个输入图像作为I(i)及其相关的从世界空间到其视图空间的相机转换。

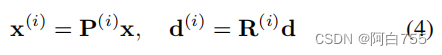

对于新的目标相机射线,我们将具有视图方向d的查询点x转换为每个输入视图i与世界的坐标系,以相机转换为

公式4

为了获得输出密度和颜色,我们独立处理每个视图坐标系中的坐标和相应特征,并在NeRF网络内的视图中聚合。为了便于解释,我们将NeRF网络的初始层表示为f1,该层分别处理每个输入视图空间,将最终层表示为f2,该层处理聚合视图。

我们将每个输入图像编码为特征卷W(i) = E(I(i))。对于视空间点x(i),我们从投影图像坐标π(x(i))处的特征体积W(i)中提取相应的图像特征。然后,我们将这些输入传递到f1中,以获得中间向量:

V(i) = f1 γ(x(i)), d(i); W(i)π(x(i))。(5)

然后,中间V(i)与平均年龄池运算符ψ聚合,并传递到最终层,表示为f2,以获得预测的密度和颜色:

(Σ,c) = f2 ψV(1),…,V(n)。(6)

在单视图特殊情况下,通过将视图空间视为世界空间,通过f = f2 ◦ f1简化为公式3。

五、experiment refinery

我们在三个实验类别中广泛地展示了我们的方法:1)现有的ShapeNet[4]基准,用于特定类别和不可知类别的视图合成;2)具有未见类别和多个对象的ShapeNet场景,这两种场景都需要几何先验而不是识别,以及域转移到真实的汽车照片;3)DTU MVS数据集的真实场景。

baseline好多词看不懂啊。。。SRN DVR 这些后面再查

评估 我们报告所有评估的标准图像质量指标PSNR和SSIM。除特定类别的设置外,我们还在所有评估中包括LPIPS,它更准确地反映了人类感知。在此设置中,我们完全遵循SRN的pro-tocol,以保持与之前作品的可比性。

5.1 ShapeNet Benchmarks

六、Discussion refinery

还有一些挑战有待探索:

1)像NeRF一样,我们的渲染时间很慢。当给定更多输入视图时,我们的运行时间会提前增加。此外,一些方法可以从图像中恢复网格,以便事后快速渲染和操作,而基于NeRF的表示形式无法非常可靠地转换为网格。

2)与香草NeRF(?)一样,我们手动调整射线采样边界tn,tf和位置编码的刻度。使NeRF相关方法尺度不变是一个关键挑战。

3)虽然我们已经展示了我们关于DTU数据集真实数据的方法,但我们承认该数据集是在受控设置下捕获的,并且在所有场景中都有匹配的相机姿势,视角有限。归根结底,我们的方法受到大规模宽基线多视图数据集的可用性的制约,限制了对ShapeNet和DTU等数据集的适用性。

(1比较适用 2和3是对于采用和数据集而言)

3111

3111

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?