论文:https://arxiv.org/abs/2110.06864

代码:https://github.com/ifzhang/ByteTrack

文章目录

Abstract

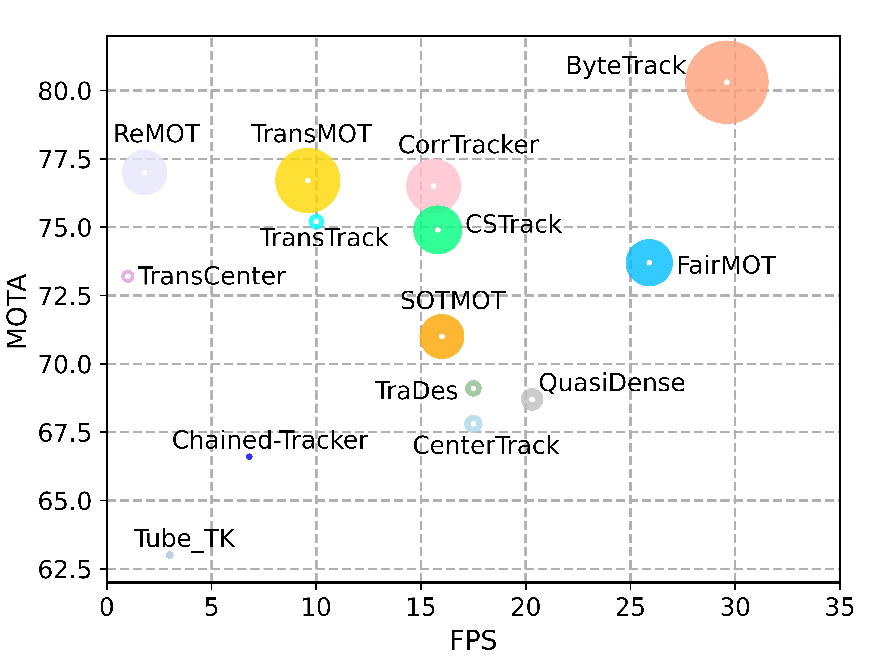

多目标跟踪(Multi-object tracking,MOT)旨在估计视频中物体的边界框和身份。大多数方法通过将得分高于阈值的检测框进行关联来获取身份。低得分的物体,例如被遮挡的物体,通常被直接丢弃,这会导致丢失真实物体和轨迹碎片化的问题。为了解决这个问题,我们提出了一种简单、有效和通用的关联方法,即通过关联几乎每个检测框而不仅仅是得分高的框。对于低得分的检测框,我们利用它们与轨迹片段的相似性来恢复真实物体,并过滤掉背景检测。当应用于9种不同的最先进的跟踪器时,我们的方法在IDF1分数上实现了一致的改进,提升范围为1到10个点。为了推动MOT的最新性能,我们设计了一种简单而强大的跟踪器,名为ByteTrack。我们首次在MOT17的测试集上实现了80.3的MOTA、77.3的IDF1和63.1的HOTA,并且在单个V100 GPU上以30FPS的运行速度。ByteTrack在MOT20、HiEve和BDD100K的跟踪基准上也取得了最先进的性能。

源代码、预训练模型及其部署版本,以及应用到其他跟踪器的教程已经在https://github.com/ifzhang/ByteTrack发布。

Introduction

Tracking-by-detection是当前多目标跟踪(MOT)中最有效的范式。由于视频中复杂的场景,检测器往往会做出不完美的预测。最先进的MOT方法需要处理检测框中真正的正例/误例权衡,以消除置信度较低的检测框。然而,消除所有置信度较低的检测框是否正确?我们的答案是否定的:正如黑格尔所说,“合理的即为现实;现实的即为合理。”置信度较低的检测框有时表示物体的存在,例如被遮挡的物体。过滤掉这些物体会导致MOT的不可逆错误,并引起相当大的漏检和碎片化轨迹。

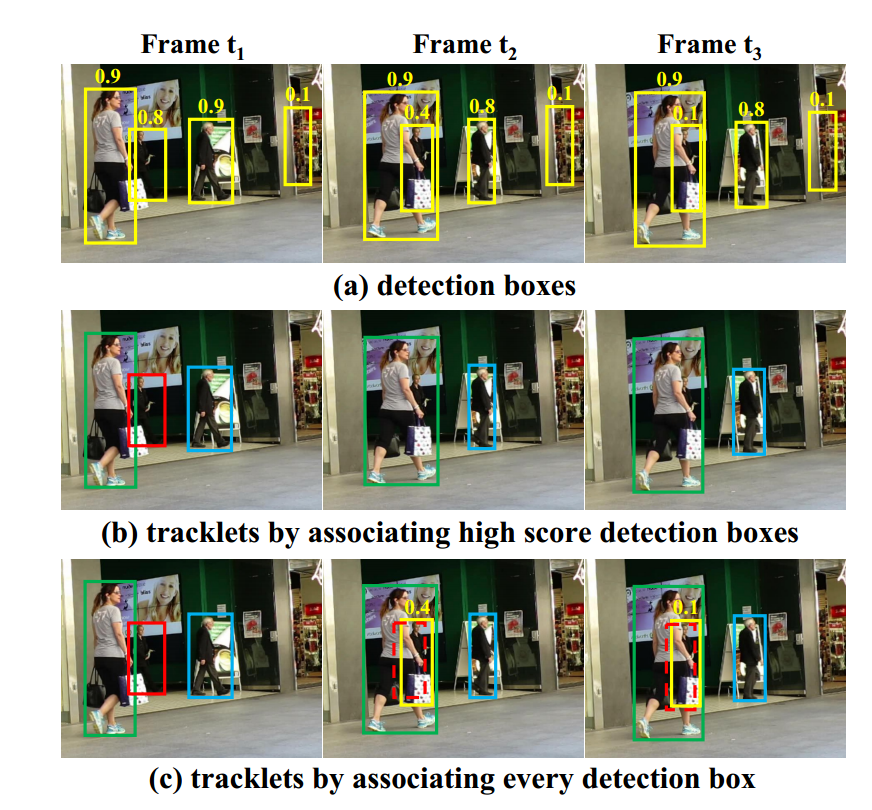

图2(a)和(b)展示了这个问题。在帧t1中,我们初始化了三个不同的轨迹,因为它们的分数都高于0.5。然而,在发生遮挡的帧t2和t3中,红色轨迹对应的检测分数变低,从0.8降到0.4,然后再从0.4降到0.1。这些检测框通过阈值机制被消除,红色轨迹也相应消失。

然而,如果我们考虑每一个检测框,会立即引入更多的误检,例如图2(a)中t3帧最右边的框。据我们所知,很少有MOT方法能够处理这种检测困境。

在本文中,我们确定了与轨迹相似性是区分低分检测框中的物体和背景的强大线索。如图2(c)所示,通过运动模型预测的框将两个低分检测框与轨迹匹配,从而正确恢复了物体。同时,由于没有匹配的轨迹,背景框被去除。

为了充分利用从高分到低分的检测框,在匹配过程中,我们提出了一种简单有效的关联方法BYTE,每个检测框都是轨迹的基本单位,就像计算机程序中的字节一样,我们的跟踪方法重视每一个细节的检测框。我们首先基于运动相似性或外观相似性将高分检测框与轨迹匹配。类似于[6],我们采用Kalman滤波器[29]来预测新帧中轨迹的位置。相似性可以通过预测框和检测框的IoU或Re-ID特征距离来计算。图2(b)正是第一次匹配后的结果。然后,我们使用相同的运动相似性对未匹配的轨迹(即红框中的轨迹)和低分检测框进行第二次匹配。图2(c)展示了第二次匹配后的结果。具有低检测分数的被遮挡的人正确地与之前的轨迹匹配,背景(图像的右侧)被去除。

作为目标检测和关联的集成主题,对于MOT来说,一个理想的解决方案不应该只有检测器和后续的关联;此外,它们的连接区域的良好设计也很重要。BYTE的创新之处在于检测和关联的连接区域,其中低分检测框成为加强两者的桥梁。受益于这一集成创新,当BYTE应用于包括Re-ID方法[33,47,69,85]、基于运动的方法[71,89]、链式方法[48]和注意力方法[59,80]在内的9种不同的最先进跟踪器时,几乎所有指标,包括MOTA、IDF1分数和ID切换,都取得了显著改进。例如,我们将CenterTrack [89]的MOTA从66.1提高到67.4,IDF1从64.2提高到74.0,IDs减少从528到144,在MOT17的半验证集上。

为了推动MOT的最新性能,我们提出了一种简单而强大的跟踪器,称为ByteTrack。我们采用最近高性能的检测器YOLOX [24]获取检测框,并将它们与我们提出的BYTE进行关联。在MOT挑战赛中,ByteTrack在MOT17和MOT20上分别排名第1,在MOT17上以30 FPS的运行速度在V100 GPU上实现80.3 MOTA、77.3 IDF1和63.1 HOTA,在更拥挤的MOT20上实现77.8 MOTA、75.2 IDF1和61.3 HOTA。ByteTrack在HiEve [37]和BDD100K [79]跟踪基准上也取得了最先进的性能。我们希望ByteTrack的高效和简洁能够使其在社交计算等实际应用中具有吸引力。

图2展示了我们方法的示例,它关联了每个检测框。(a)展示了所有检测框及其得分。(b)展示了通过先前方法得到的轨迹,这些轨迹关联了得分高于阈值(如0.5)的检测框。

相同颜色的框表示相同的标识。©展示了我们方法得到的轨迹。虚线框表示使用卡尔曼滤波器预测的先前轨迹的预测框。基于较大的IoU值,两个得分较低的检测框被正确地与先前的轨迹匹配。

Related Work

Object Detection in MOT

目标检测是计算机视觉中最活跃的研究领域之一,也是多目标跟踪的基础。MOT17数据集提供了由流行的检测器(如DPM、Faster R-CNN和SDP)得到的检测结果。许多方法致力于基于这些给定的检测结果来改进跟踪性能。

Tracking by detection 基于检测的跟踪。随着目标检测的快速发展,越来越多的方法开始利用更强大的检测器来获得更高的跟踪性能。例如,RetinaNet等单阶段目标检测器已经被一些方法采用。CenterNet作为最简单高效的检测器,被大多数方法采用。YOLO系列检测器在精度和速度方面的平衡也被很多方法采用。这些方法中,大多数直接使用单个图像上的检测框进行跟踪。

然而,当视频序列中发生遮挡或运动模糊时,缺失检测和得分较低的检测开始增加,这是视频目标检测方法所指出的。因此,通常利用先前帧的信息来提高视频检测性能。

Detection by tracking 跟踪辅助检测。跟踪也可以用来帮助获取更准确的检测框。一些方法利用单目标跟踪(SOT)或卡尔曼滤波器来预测下一帧中轨迹的位置,并将预测的框与检测框融合以增强检测结果。其他方法则利用先前帧中的跟踪框来增强后续帧的特征表示。最近,一些方法采用了基于Transformer的检测器,因其在帧间传递框的能力而被采用。我们的方法也利用轨迹的相似性来增强检测框的可靠性。

在使用各种检测器获取检测框之后,大多数MOT方法只保留高得分的检测框(阈值为0.5),并将这些框作为数据关联的输入。这是因为低得分的检测框中包含了许多背景信息,它们会对跟踪性能造成负面影响。但是我们观察到,许多被遮挡的目标可以正确检测到,但得分较低。为了减少错过的检测和保持轨迹的连续性,我们保留所有的检测框,并在它们之间进行关联。

Data Association

数据关联是多目标跟踪的核心,它首先计算轨迹和检测框之间的相似度,并根据相似度利用不同的策略进行匹配。

相似度度量。位置、运动和外观是关联的有用线索。SORT [6]非常简单地将位置和运动线索结合起来。它首先采用卡尔曼滤波器[29]预测新帧中轨迹的位置,然后计算检测框与预测框之间的交并比作为相似度。一些最近的方法[59, 71, 89]设计了网络来学习物体运动,在大幅度摄像机移动或低帧率情况下取得更稳健的结果。位置和运动的相似度在短距离匹配中是准确的。外观的相似度在长距离匹配中是有帮助的。

当物体被长时间遮挡后,可以使用外观相似度重新识别物体。外观相似度可以通过重新识别特征的余弦相似度来衡量。DeepSORT [70]采用独立的重新识别模型从检测框中提取外观特征。最近,由于其简单性和高效性,联合检测和重新识别模型 [33, 39, 47, 69, 84, 85]变得越来越受欢迎。

匹配策略。在计算相似度之后,匹配策略将身份分配给物体。这可以通过匈牙利算法[31]或贪婪分配[89]完成。SORT [6]通过一次匹配将检测框与轨迹匹配。DeepSORT [70]提出了一种级联匹配策略,该策略先将检测框与最近的轨迹匹配,然后再匹配丢失的轨迹。

MOTDT [12]首先利用外观相似度进行匹配,然后利用交并比相似度来匹配未匹配的轨迹。QDTrack [47]通过双向softmax操作将外观相似度转化为概率,并采用最近邻搜索来完成匹配。注意机制[64]可以直接在帧之间传播框,并隐式执行关联。最近的方法,如[42, 80]提出了跟踪查询来查找后续帧中被跟踪对象的位置。匹配是在注意交互过程中隐式执行的,而不使用匈牙利算法。

所有这些方法都关注如何设计更好的关联方法。然而,我们认为检测框的利用方式决定了数据关联的上限,我们专注于如何在匹配过程中充分利用从高得分到低得分的检测框。

BYTE

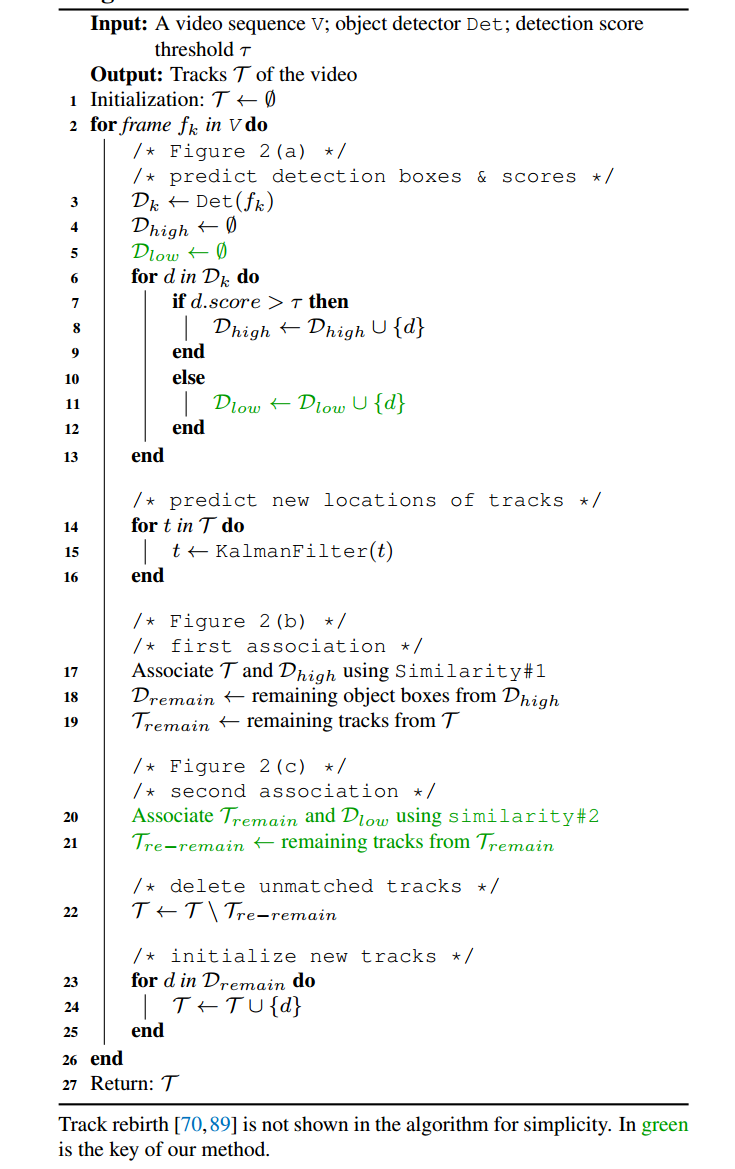

我们提出了一种简单、有效和通用的数据关联方法 BYTE。与之前的方法 [33, 47, 69, 85] 不同,前者只保留高分检测框,我们保留几乎所有的检测框,并将其分为高分和低分两类。我们首先将高分检测框与轨迹进行关联。由于遮挡、运动模糊或尺寸变化等原因,一些轨迹无法与适当的高分检测框匹配。然后,我们将低分检测框与这些未匹配的轨迹进行关联,以恢复低分检测框中的对象并同时滤除背景。BYTE 的伪代码如 Algorithm 1 所示。

BYTE 的输入是视频序列 V 和目标检测器 Det,我们还设置了一个检测分数阈值 τ。BYTE 的输出是视频的跟踪信息 T,每个轨迹包含每帧中对象的边界框和标识。

对于视频中的每一帧,我们使用检测器 Det 预测检测框和得分。根据检测分数阈值 τ,我们将所有的检测框分成两部分:高分检测框 Dhigh 和低分检测框 Dlow。将分数高于 τ 的检测框放入高分检测框 Dhigh,将分数低于 τ 的检测框放入低分检测框 Dlow(Algorithm 1 中的第 3 至 13 行)。

在分离低分检测框和高分检测框之后,我们采用卡尔曼滤波器来预测 T 中每个轨迹在当前帧中的新位置(Algorithm 1 中的第 14 至 16 行)。

第一次关联是在高分检测框 Dhigh 和所有轨迹 T(包括丢失的轨迹 Tlost)之间进行的。可以通过 IoU 或 Re-ID 特征之间的距离计算相似度#1。然后,我们采用匈牙利算法 [31] 来基于相似度完成匹配。我们保留 Dremain 中的未匹配检测框和 Tremain 中的未匹配轨迹(Algorithm 1 中的第 17 至 19 行)。

BYTE 非常灵活,可以与其他不同的关联方法兼容。例如,当将 BYTE 与 FairMOT [85] 结合时,在 Algorithm 1 中的第一次关联中添加 Re-ID 特征,其余部分保持不变。在实验中,我们将 BYTE 应用于 9 种不同的最先进的跟踪器,并在几乎所有指标上取得了显著的改进。

第二次关联是在低分检测框 Dlow 和第一次关联后剩余的轨迹 Tremain 之间进行的。我们保留 Tre−remain 中的未匹配轨迹,并删除所有未匹配的低分检测框,因为我们将其视为背景(Algorithm 1 中的第 20 至 21 行)。我们发现在第二次关联中仅使用 IoU 作为相似度#2 非常重要,因为低分检测框通常包含严重的遮挡或运动模糊,外观特征不可靠。因此,当将 BYTE 应用于其他基于 Re-ID 的跟踪器 [47, 69, 85] 时,我们不在第二次关联中采用外观相似度。

关联完成后,未匹配的轨迹将从轨迹集合中删除。为简化起见,我们没有在 Algorithm 1 中列出轨迹重生的步骤 [12, 70, 89]。实际上,对于长期关联来保留轨迹的标识,这是必要的。对于第二次关联后的未匹配轨迹 Tre−remain,我们将其放入 Tlost。对于 Tlost 中的每个轨迹,只有当其存在时间超过一定帧数(例如30帧)时,我们将其从轨迹集合 T 中删除。否则,我们保留丢失的轨迹 Tlost 在 T 中(Algorithm 1 中的第 22 行)。最后,我们从第一次关联后剩余的高分检测框 Dremain 初始化新的轨迹(Algorithm 1 中的第 23 至 27 行)。每个单独帧的输出是当前帧中跟踪信息 T 的边界框和标识。请注意,我们不输出 Tlost 的边界框和标识。

为了提升多目标跟踪的最先进性能,我们设计了一种简单而强大的跟踪器,名为 ByteTrack,将高性能检测器 YOLOX [24] 与我们的关联方法 BYTE 结合使用。

Experiments

Setting

数据集。我们在 MOT17 [44] 和 MOT20 [17] 数据集上使用“私有检测”协议评估 BYTE 和 ByteTrack 的性能。这两个数据集都包含训练集和测试集,没有验证集。对于消融研究,我们使用 MOT17 训练集中每个视频的前一半进行训练,后一半进行验证,遵循 [89] 的方法。我们根据 [59, 71, 80, 89] 的方法,在 CrowdHuman 数据集 [55] 和 MOT17 的前一半训练集上进行训练。当在 MOT17 的测试集上进行测试时,我们添加了 Cityperson [82] 和 ETHZ [21] 进行训练,遵循 [33, 69, 85] 的方法。我们还在 HiEve [37] 和 BDD100K [79] 数据集上测试了 ByteTrack。HiEve 是一个大规模的以人为中心的数据集,重点关注拥挤和复杂的事件。BDD100K 是最大的驾驶视频数据集,MOT 任务的数据集划分为 1400 个训练视频、200 个验证视频和 400 个测试视频。它需要跟踪8类物体,并包含大运动相机的情况。

指标。我们使用 CLEAR 指标 [4] 包括 MOTA、FP、FN、IDs 等,IDF1 [51] 和 HOTA [40] 来评估跟踪性能的不同方面。MOTA 是基于 FP、FN 和 IDs 计算的。考虑到 FP 和 FN 的数量大于 IDs,MOTA 更关注检测性能。IDF1 评估标识保留能力,并更关注关联性能。HOTA 是最近提出的一种指标,明确平衡了准确检测、关联和定位的效果。对于 BDD100K 数据集,还有一些多类别指标如 mMOTA 和 mIDF1。mMOTA / mIDF1 是将所有类别的 MOTA / IDF1 平均计算得到的。

实现细节。对于 BYTE,除非另有说明,否则默认的检测分数阈值 τ 为0.6。对于 MOT17、MOT20 和 HiEve 的基准评估,我们只使用 IoU 作为相似度度量。在线性分配步骤中,如果检测框和轨迹框之间的 IoU 小于0.2,则匹配将被拒绝。对于丢失的轨迹,我们保留它 30 帧,以防它再次出现。对于 BDD100K,我们使用 UniTrack [68] 作为 Re-ID 模型。在消融研究中,我们使用 FastReID [27] 提取 MOT17 的 Re-ID 特征。

对于 ByteTrack,检测器是 YOLOX [24],使用 YOLOX-X 作为主干网络,COCO 预训练模型 [36] 作为初始化权重。对于 MOT17,训练计划是在 MOT17、CrowdHuman、Cityperson 和 ETHZ 的组合上进行 80 个 epoch 的训练。对于 MOT20 和 HiEve,我们只添加了 CrowdHuman 作为额外的训练数据。对于 BDD100K,我们不使用额外的训练数据,仅进行 50 个 epoch 的训练。输入图像大小为 1440 × 800,最短边在多尺度训练中的范围从 576 到 1024。数据增强包括 Mosaic [8] 和 Mixup [81]。模型在 8 个 NVIDIA Tesla V100 GPU 上进行训练,批大小为 48。优化器使用带有权重衰减为 5 × 10^-4 和动量为 0.9 的 SGD。初始学习率为 10^-3,有 1 个 epoch 的预热和余弦退火调度。总的训练时间约为 12 小时。根据 [24],FPS 是在单个 GPU 上以 FP16 精度 [43] 和批大小为 1 进行测量的。

Ablation Studies on BYTE

相似性分析。我们选择不同类型的相似性方法来进行BYTE的第一次关联和第二次关联。结果如表1所示。可以看出,在MOT17数据集上,无论是IoU还是Re-ID都是Similarity#1的很好选择。IoU在MOTA和IDs指标上更好,而Re-ID在IDF1指标上更高。在BDD100K数据集上,与IoU相比,Re-ID在第一次关联中获得了更好的结果。这是因为BDD100K包含大量的相机运动,并且注释帧率低,导致运动线索失效。在两个数据集上的第二次关联中重要的是利用IoU作为Similarity#2,因为低分数的检测框通常包含严重的遮挡或运动模糊,因此Re-ID特征不可靠。从表1可以看出,与Re-ID相比,使用IoU作为Similarity#2可以增加约1.0的MOTA,这表明低分数检测框的Re-ID特征不可靠。

与其他关联方法的比较。我们将BYTE与其他流行的关联方法,包括SORT [6]、DeepSORT [70]和MOTDT [12]在MOT17和BDD100K的验证集上进行比较。结果如表2所示。

SORT可以看作是我们的基准方法,因为这两种方法都只采用了卡尔曼滤波器来预测目标运动。我们可以发现,BYTE将SORT的MOTA指标从74.6提高到76.6,IDF1指标从76.9提高到79.3,同时将IDs从291减少到159。这凸显了低分数检测框的重要性,并证明了BYTE从低分数检测框中恢复目标框的能力。

DeepSORT利用额外的Re-ID模型来增强长期关联。令人惊讶的是,我们发现相比于DeepSORT,BYTE也有额外的收益。这表明简单的卡尔曼滤波器可以执行长距离关联,并在检测框足够准确时获得更好的IDF1和IDs结果。我们注意到,在严重遮挡的情况下,Re-ID特征容易受到干扰,可能导致身份切换,而运动模型的行为更可靠。

MOTDT将运动引导的框传播结果与检测结果整合,以将不可靠的检测结果与轨迹相关联。尽管有着相似的动机,但MOTDT在许多方面都落后于BYTE。我们解释道,MOTDT使用传播的框作为轨迹框,这可能导致跟踪中的定位偏差。相反,BYTE使用低分数的检测框重新关联那些没有匹配的轨迹,因此轨迹框更准确。

表2还显示了在BDD100K数据集上的结果。

与其他关联方法相比,BYTE也大幅优于其他关联方法。卡尔曼滤波器在自动驾驶场景中失败,这是SORT、DeepSORT和MOTDT性能较低的主要原因。因此,我们在BDD100K上不使用卡尔曼滤波器。现成的ReID模型极大地提高了BYTE在BDD100K上的性能。

对检测分数阈值的鲁棒性。检测分数阈值τhigh是一个敏感的超参数,在多目标跟踪任务中需要仔细调整。我们将其从0.2变化到0.8,并比较了BYTE和SORT的MOTA和IDF1得分。结果如图3所示。从结果可以看出,相比于SORT,BYTE对检测分数阈值更具鲁棒性。这是因为BYTE中的第二次关联恢复了分数低于τhigh的对象,并且几乎考虑了每个检测框,而不考虑τhigh的变化。

低分数检测框的分析。为了证明BYTE的有效性,我们统计了BYTE获得的低分数框中TPs和FPs的数量。我们使用MOT17和CrowdHuman的一半训练集进行训练,并在MOT17的一半验证集上进行评估。首先,我们保留所有分数从τlow到τhigh的低分数检测框,并使用地面实况注释对TPs和FPs进行分类。然后,我们从低分数检测框中选择BYTE获得的跟踪结果。

每个序列的结果如图4所示。我们可以看出,即使某些序列(如MOT17-02)在所有的检测框中有更多的FPs,BYTE从低分数检测框中获得的TPs明显多于FPs。如表2所示,这些得到的TPs显著提高了MOTA,从74.6增加到76.6。

在其他的跟踪器上的应用。我们将BYTE应用于9种不同的最新跟踪器,包括JDE [69]、CSTrack [33]、FairMOT [85]、TraDes [71]、QDTrack [47]、CenterTrack [89]、Chained-Tracker [48]、TransTrack [59]和MOTR [80]。在这些跟踪器中,JDE、CSTrack、FairMOT和TraDes采用了运动和Re-ID相似性的组合。QDTrack仅采用Re-ID相似性。

CenterTrack和TraDes通过学习网络预测运动相似性。Chained-Tracker采用链式结构,同时输出两个连续帧的结果,并通过IoU在同一帧中进行关联。

TransTrack和MOTR采用注意机制在帧之间传播边界框。它们的结果显示在表3中每个跟踪器的第一行。

为了评估BYTE的效果,我们设计了两种不同的模式将BYTE应用于这些跟踪器。

• 第一种模式是将BYTE插入到不同跟踪器的原始关联方法中,如表3中每个跟踪器结果的第二行所示。以FairMOT [85]为例,在完成原始关联后,我们选择所有未匹配的轨迹,并按照算法1中的第二次关联将它们与低分数检测框关联起来。

需要注意的是,对于低分数的目标,Re-ID特征不可靠,因此我们只采用运动预测后检测框和轨迹框之间的IoU作为相似性。我们没有将第一种模式应用于Chained-Tracker,因为我们发现在链式结构中实现较困难。

• 第二种模式是直接使用这些跟踪器的检测框,并使用算法1中的整个过程进行关联,如表3中每个跟踪器结果的第三行所示。

我们可以看到,在两种模式下,BYTE可以为几乎所有指标带来稳定的改进,包括MOTA、IDF1和IDs。例如,BYTE将CenterTrack的MOTA提高了1.3,IDF1提高了9.8;Chained-Tracker的MOTA提高了1.9,IDF1提高了5.8;TransTrack的MOTA提高了1.2,IDF1提高了4.1。表3中的结果表明,BYTE具有很强的泛化能力,并且可以轻松应用于现有的跟踪器以获得性能提升。

Benchmark Evaluation

我们将ByteTrack与MOT17、MOT20和HiEve的最新跟踪器进行了比较,在私有检测协议下分别列在表4、表5和表6中。所有结果均直接从官方的MOT Challenge评估服务器和Human in Events服务器获取。

在MOT17中,ByteTrack在MOT17的排行榜中名列第一。它不仅取得了最佳的准确性(即80.3的MOTA、77.3的IDF1和63.1的HOTA),而且具有最高的运行速度(30帧/秒)。它的表现大大超过了第二名的跟踪器[76](即+3.3的MOTA,+5.3的IDF1和+3.4的HOTA)。此外,我们使用的训练数据比许多高性能方法(如[33,34,54,65,85])少(29K张图像对比73K张图像)。值得注意的是,与其他方法[33,47,59,67,80,85]相比,我们在关联步骤中只采用了最简单的相似性计算方法Kalman滤波器,而其他方法还额外采用了Re-ID相似性或注意机制。

所有这些都表明ByteTrack是一个简单而强大的跟踪器。

在MOT20中,与MOT17相比,MOT20的场景更加拥挤,遮挡情况更多。在MOT20的测试集中,图像中的行人平均数量为170。ByteTrack也在MOT20的排行榜中名列第一,并在几乎所有指标上大幅优于其他跟踪器。例如,它将MOTA从68.6提高到77.8,IDF1从71.4提高到75.2,并将身份切换减少了71%(从4209减少到1223)。值得注意的是,ByteTrack实现了极低的身份切换,这进一步表明在遮挡情况下关联每个检测框非常有效。

与MOT17和MOT20相比,HiEve包含更复杂的事件和更多样化的摄像机视角。我们在CrowdHuman数据集和HiEve的训练集上训练了ByteTrack。ByteTrack也在HiEve的排行榜中名列第一,并在几乎所有指标上大幅优于其他最新跟踪器。例如,它将MOTA从40.9提高到61.3,IDF1从45.1提高到62.9。这些优异的结果表明ByteTrack在复杂场景中具有鲁棒性。

BDD100K是自动驾驶场景下的多类别跟踪数据集。挑战包括低帧率和大相机运动。我们使用UniTrack的简单ResNet-50 ImageNet分类模型来提取Re-ID特征并计算外观相似性。ByteTrack在BDD100K的排行榜中名列第一。它将验证集上的mMOTA从36.6提高到45.5,在测试集上从35.5提高到40.1,这表明ByteTrack也可以处理自动驾驶场景中的挑战。

Conclusion

我们提出了一种简单而有效的多目标跟踪数据关联方法 BYTE。BYTE可以轻松应用于现有的跟踪器,并实现一致的改进。我们还提出了一种强大的跟踪器 ByteTrack,在MOT17测试集上以30FPS的速度实现了80.3的MOTA、77.3的IDF1和63.1的HOTA,排名跟踪器榜单的第一位。ByteTrack对遮挡非常鲁棒,这是由于其准确的检测性能以及关联低得分检测框的帮助。它也为如何充分利用检测结果提升多目标跟踪提供了启示。我们希望ByteTrack的高准确性、快速速度和简单性能够在实际应用中具有吸引力。

附加

我们注意到 MOT17 [44] 需要覆盖整个物体的边界框 [89],即使该物体被遮挡或部分超出图像。然而,YOLOX 的默认实现会将检测框剪裁在图像区域内。为了避免图像边界周围错误的检测结果,我们在数据预处理和标签分配方面修改了 YOLOX。在数据预处理和数据增强过程中,我们不会将边界框剪裁在图像内部。只有在数据增强后完全超出图像的情况下才会删除框。

在 SimOTA 标签分配策略中,正样本需要在物体的中心周围,而整个物体边界框的中心可能位于图像外部,所以我们将物体的中心剪裁在图像内部。

MOT20 [17]、HiEve [37] 和 BDD100K 将边界框注释剪裁在图像内部,因此我们只使用 YOLOX 的原始设置。

我们使用轻量级检测模型比较了 BYTE 和 DeepSORT [70]。我们使用不同的主干网络作为检测器,其中使用了 YOLOX [24]。所有模型都在 CrowdHuman 数据集和 MOT17 的一半训练集上进行训练。输入图像大小为 1088×608,并且在多尺度训练期间,最短边的长度范围为 384 到 832。结果如表8所示。我们可以看到,与 DeepSORT 相比,BYTE 在 MOTA 和 IDF1 上带来了稳定的改进,这表明 BYTE 对检测性能具有鲁棒性。值得注意的是,当使用 YOLOX-Nano 作为主干网络时,BYTE 的 MOTA 比 DeepSORT 高出3个百分点,使其在实际应用中更具吸引力。

速度与准确性。我们评估了 ByteTrack 在推理过程中使用不同大小输入图像的速度和准确性。所有实验使用相同的多尺度训练。

结果如表9所示。推理过程中的输入大小范围为 512 × 928 到 800 × 1440。检测器的运行时间范围为 17.9 毫秒到 30.0 毫秒,关联时间大约为 4.0 毫秒。ByteTrack 可以实现 75.0 的 MOTA,运行速度为 45.7 帧/秒;可以实现 76.6 的 MOTA,运行速度为 29.6 帧/秒,这在实际应用中具有优势。

训练数据。我们使用不同的训练数据组合评估 ByteTrack 在 MOT17 的一半验证集上的性能。结果如表10所示。仅使用 MOT17 的一半训练集时,性能达到了 75.8 的 MOTA,已经超过了大多数方法。

这是因为我们使用了强大的数据增强,例如 Mosaic [8] 和 Mixup [81]。当进一步添加 CrowdHuman、Cityperson 和 ETHZ 进行训练时,我们可以实现 76.7 的 MOTA 和 79.7 的 IDF1。IDF1 的显着提高是因为 CrowdHuman 数据集可以帮助检测器识别被遮挡的人,从而使卡尔曼滤波器生成更平滑的预测,并增强跟踪器的关联能力。

关于训练数据的实验表明,ByteTrack 不需要大量数据。与之前的方法 [33,34,65,85] 相比,它只需要超过 7 个数据源 [19, 21, 44, 55, 73, 82, 88] 即可达到高性能。这对于真实应用来说是一个巨大的优势。

1885

1885

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?