第一次任务比较简单,跟着教程操作就行。

-

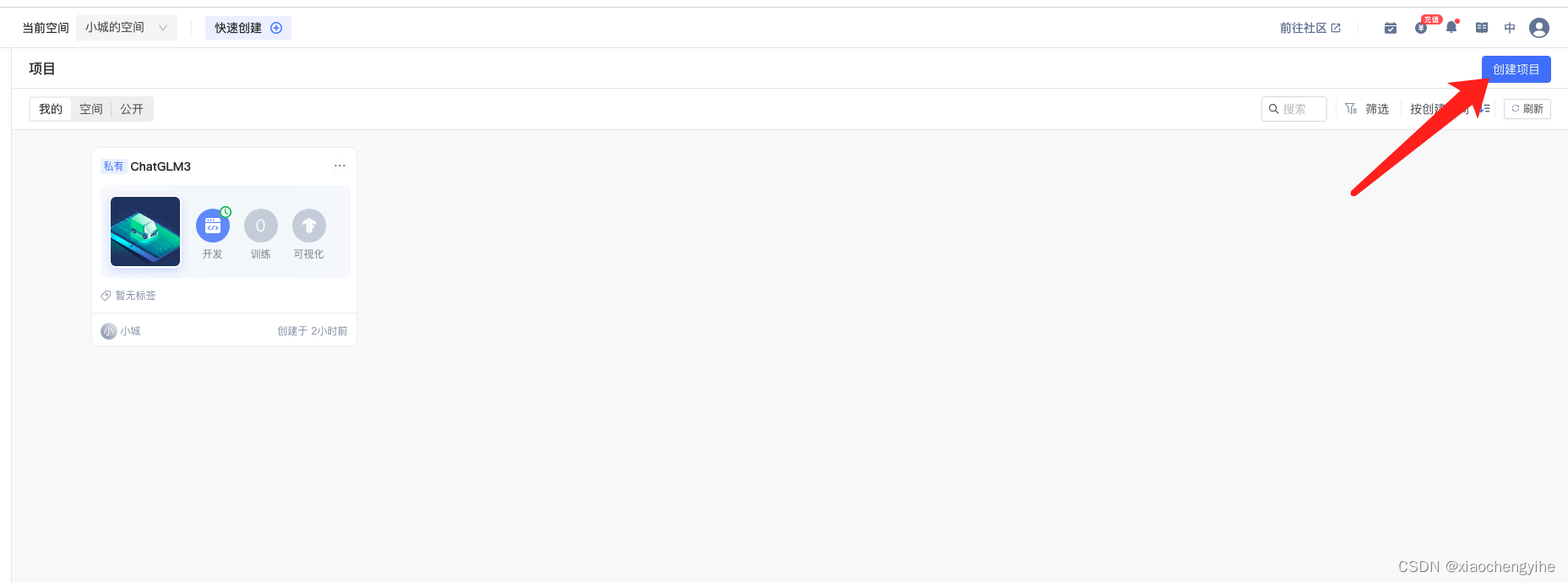

创建好账号之后,进入自己的空间,点击右上角的创建项目。

-

-

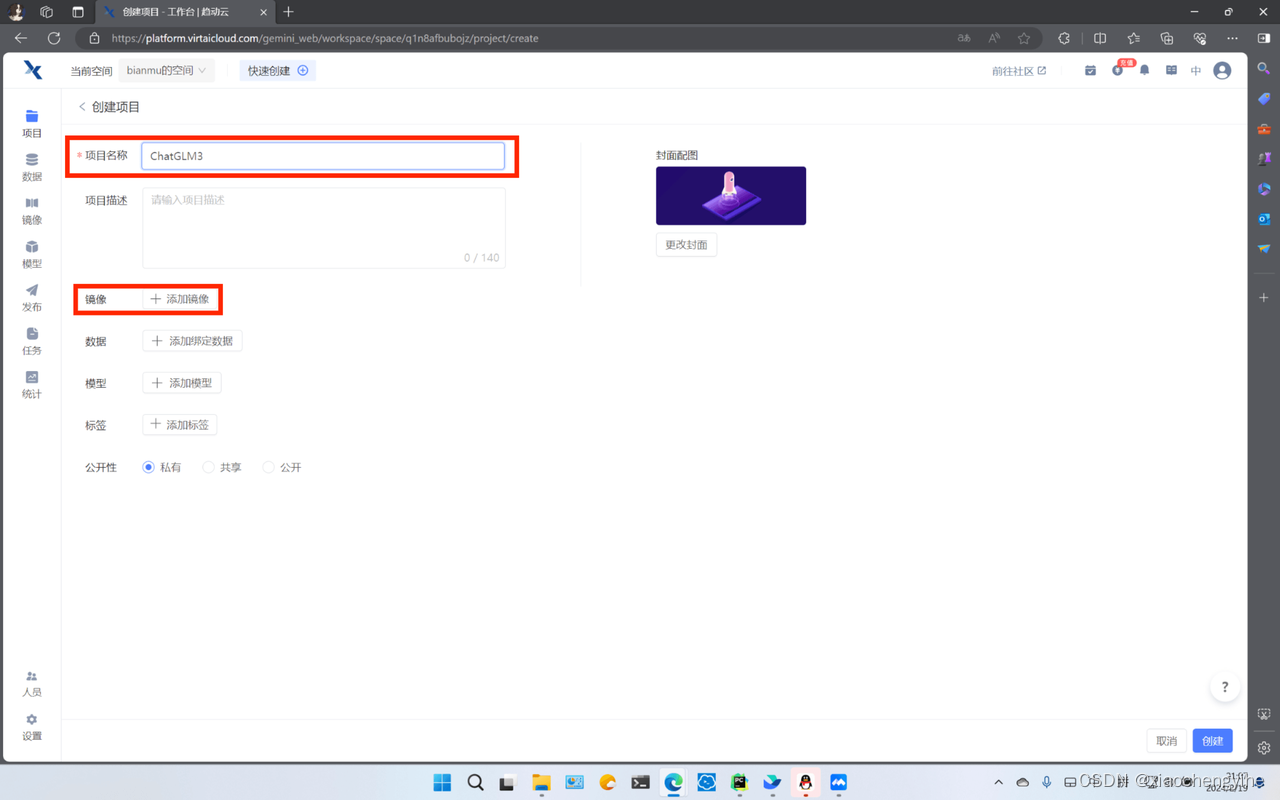

给项目起一个你喜欢的名称,选择添加镜像

-

-

镜像选择pytorch2.0.1,python3.9

-

-

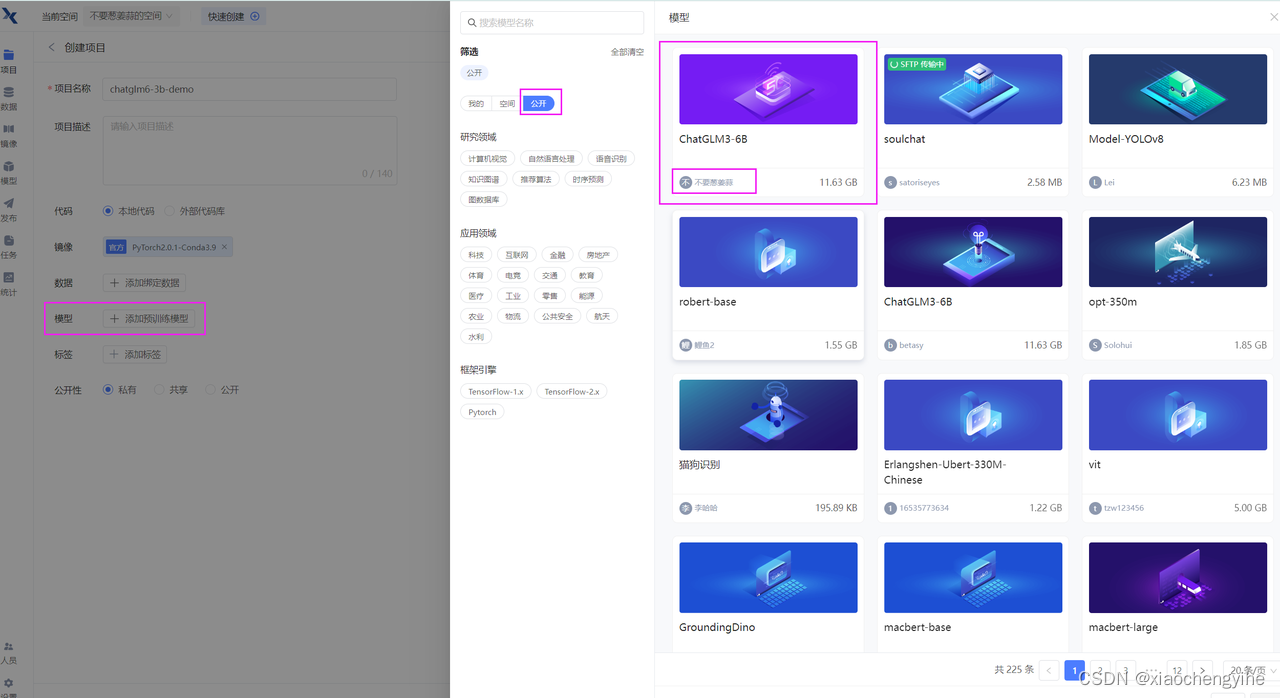

选择预训练模型,点击公开,选择不要葱姜蒜上传的这个ChtaGLM3-6B模型。

-

都选完之后,点击右下角的创建,代码选择暂不上传。待会直接clone代码。

-

-

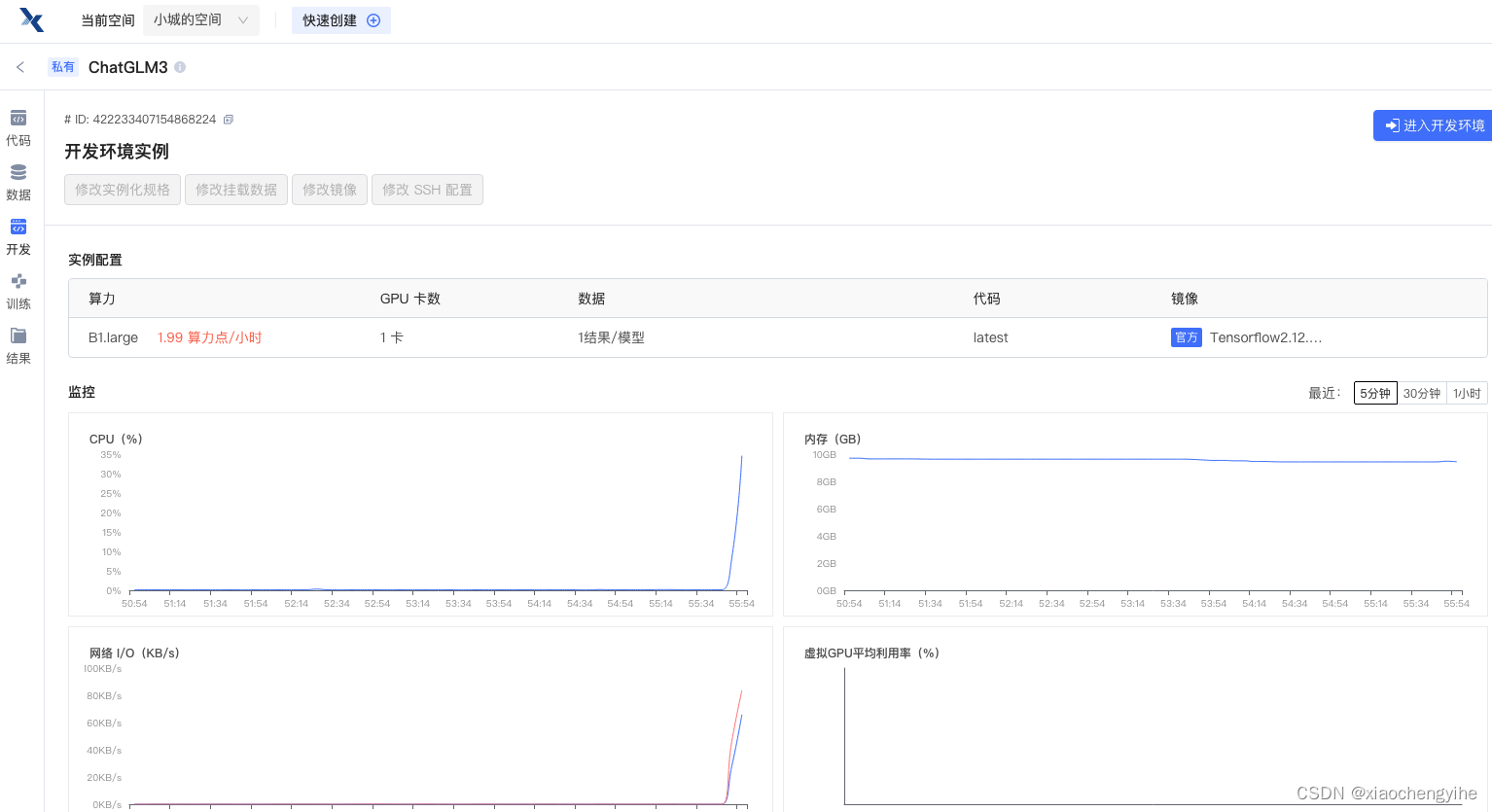

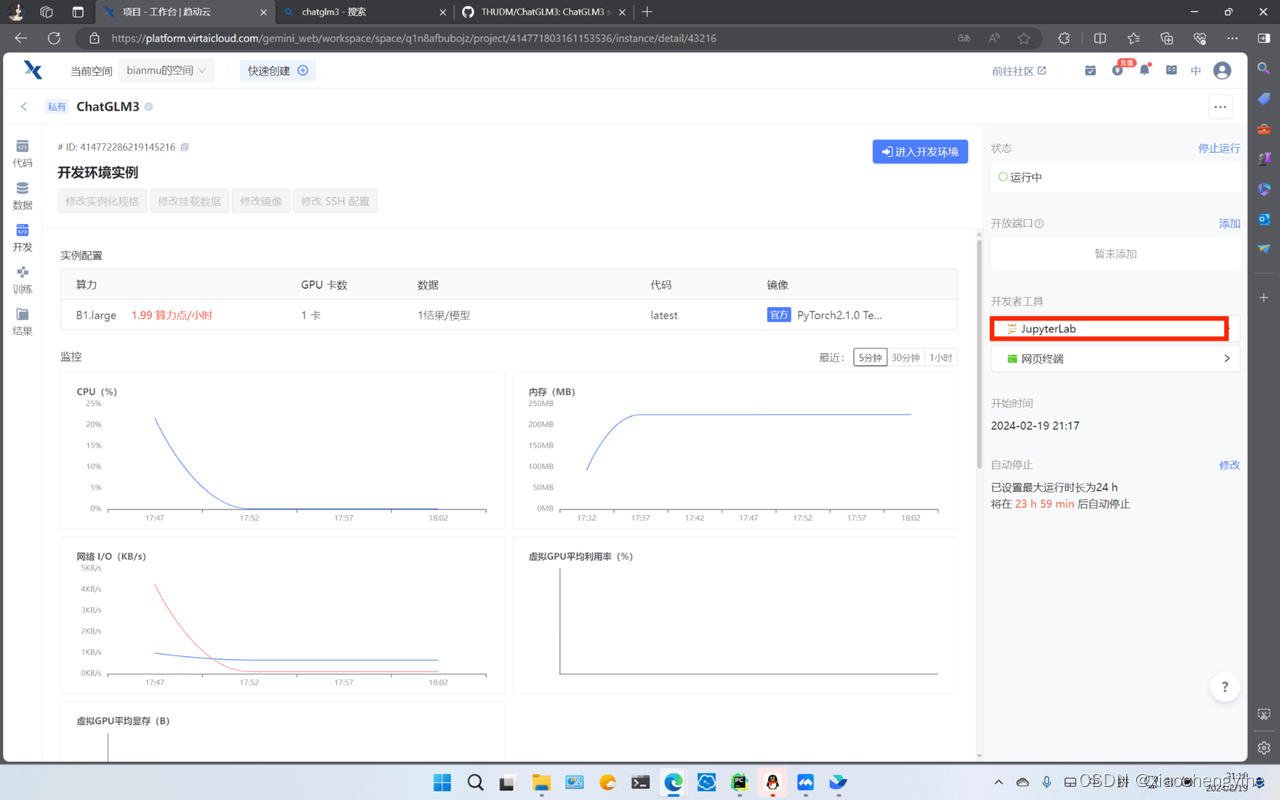

资源配置选择:B1.large, 24G的显存足够加载模型了。其他的不需要设置,然后点击右下角的开始运行。

等右边两个工具全部加载完毕之后,再点击JupyterLab进入开发环境~

-

点击terminal,进入终端。

设置镜像源、克隆项目

-

升级apt,安装unzip

apt-get update && apt-get install unzip

-

设置镜像源,升级pip

pip config set global.index-url https://pypi.virtaicloud.com/repository/pypi/simple

python3 -m pip install --upgrade pip-

克隆项目,并进入项目目录

git clone https://github.com/THUDM/ChatGLM3.git cd ChatGLM3

修改requirements

-

双击左侧的requirements.txt文件,把其中的torch删掉,因为我们的环境中已经有torch了,避免重复下载浪费时间。

-

-

点击左上选项卡,重新返回终端,安装依赖,依赖安装完毕后还需要安装peft

pip install -r requirements.txt

pip install peft

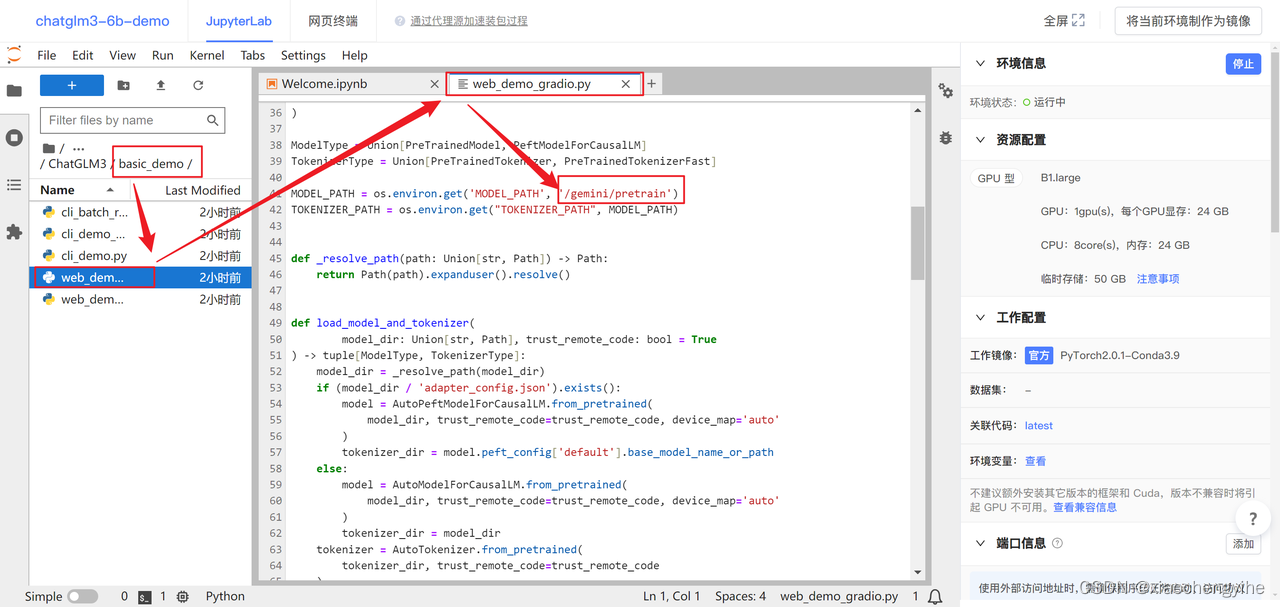

Step.3 修改web_demo_gradio.py代码

1、修改模型目录

-

双击

basic_demo编辑web_demo_gradio.py,将加载模型的路径修改为:/gemini/pretrain,如下图所示~

2、修改启动代码

-

接下来还需要修改一段启动代码,将滚动条拉到最后一行,启动代码修改为如下~

demo.queue().launch(share=False, server_name="0.0.0.0",server_port=7000)

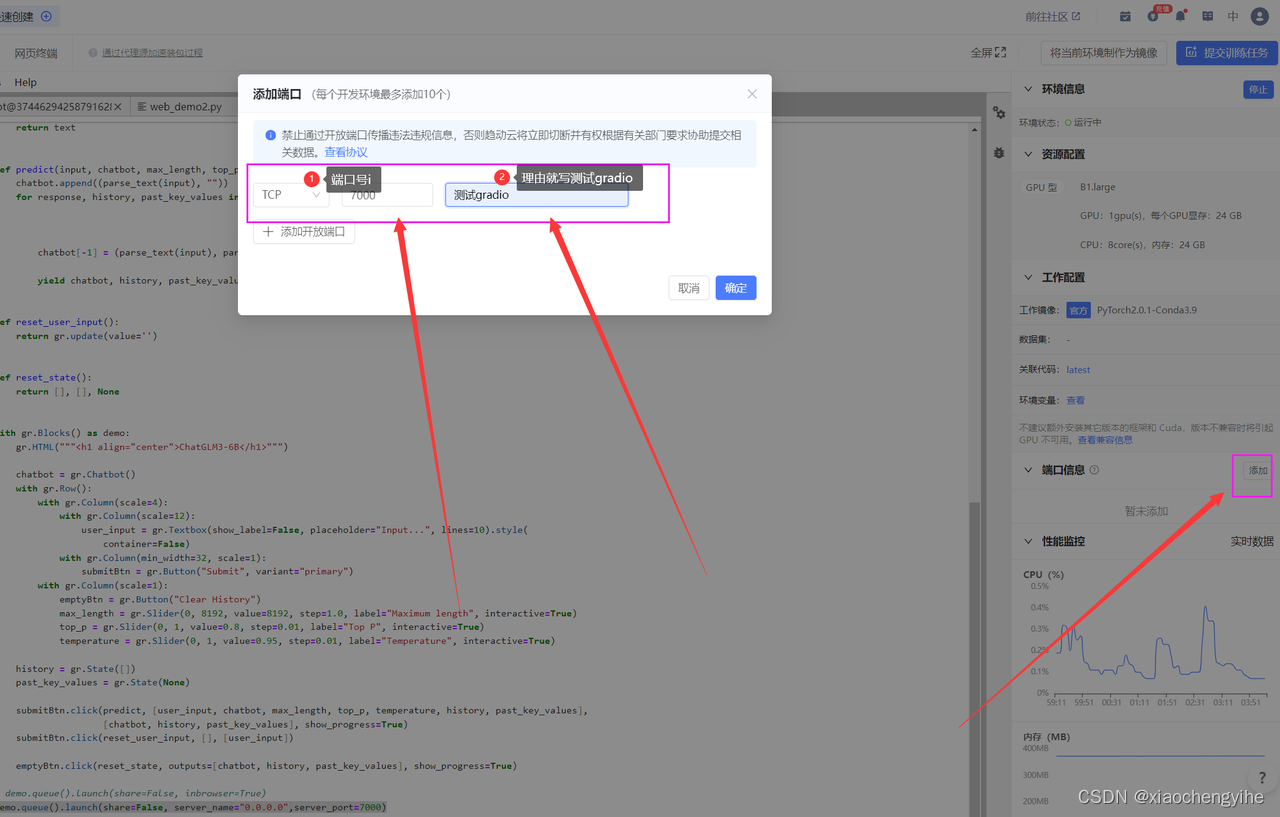

3、添加外部端口映射

-

在界面的右边添加外部端口:7000

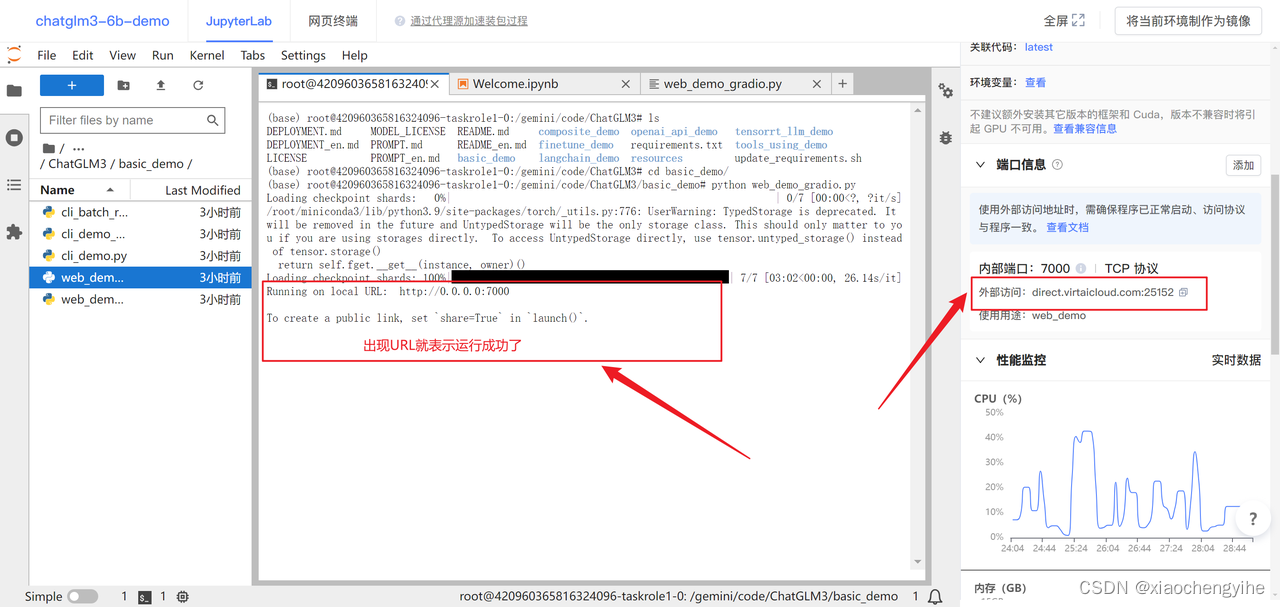

4、运行gradio界面

-

点击左上选项卡,重新返回终端,运行web_demo_gradio.py

-

cd basic_demo -

python web_demo_gradio.py

-

等待模型慢慢加载完毕,可能需要个五六分钟

5、访问gradio页面

-

加载完毕之后,复制外部访问的连接,到浏览器打打开

那么就可以聊天了

本文详细介绍了如何在云端创建项目,配置资源,升级包,克隆并修改ChatGLM3项目,最终通过Gradio实现聊天功能的步骤,包括设置镜像源、安装依赖和修改代码等。

本文详细介绍了如何在云端创建项目,配置资源,升级包,克隆并修改ChatGLM3项目,最终通过Gradio实现聊天功能的步骤,包括设置镜像源、安装依赖和修改代码等。

8910

8910

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?