论文 : Adversarial Multi-task Learning for Text Classification

最近决定每周读一篇GAN的论文。一方面,提升自己的阅读理解能力。另一方面,拓展自己的思路。作为GAN的初学者,有很多表述不当的地方欢迎大家批评指正!

标题:对抗多任务学习用于文本分类。所谓多任务学习(MTL)就是指学习某一类任务的通用知识(focus on learning the shared layers to extract the common and task-invariant features)。比如学习AlexNet,VGG的卷积部分(不含全连接层)。这样学习出来的卷积特征通常表示一些通用的特征表示(类似于SIFT,HOG)。而利用全连接层,就可以学的一些可以针对某个具体任务的特征,比如分类,分割,检测等。详细可以看这篇关于多任务学习文章。

Abstract

作者提出利用GAN进行多任务学习,可以缓解多任务学习中学习的shared knowledge存在task-specific features问题。

Introduction

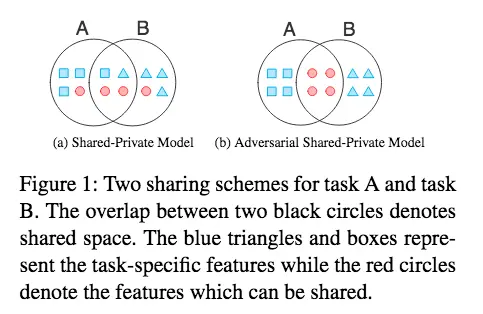

作者为解决目前多任务学习中存在的问题,设计了一个shared-private learning framework. 其主要关键点就是引入了对抗训练以及正交约束,这样可以阻止 shared and private latent features from interfering with each other。说白了,作者就是要将task-specific features 以及 task-dependent features分开来,示意图如下:

该论文提出了一种对抗多任务学习框架,旨在解决多任务学习中任务特有特征干扰共享知识的问题。通过引入对抗训练和正交约束,确保共享特征空间只包含通用特征,而私有特征空间则不含冗余。实验表明这种方法在文本分类任务中表现出色。

该论文提出了一种对抗多任务学习框架,旨在解决多任务学习中任务特有特征干扰共享知识的问题。通过引入对抗训练和正交约束,确保共享特征空间只包含通用特征,而私有特征空间则不含冗余。实验表明这种方法在文本分类任务中表现出色。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

422

422

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?