之前和大家介绍过阿里的EMO,用户只需要提供一张照片和一段任意音频文件,EMO即可生成会说话唱歌的AI视频。最长时间可达1分30秒左右。感兴趣的小伙伴可以点击下面链接阅读。

近日,复旦发布了一个开源版本的 EMO。

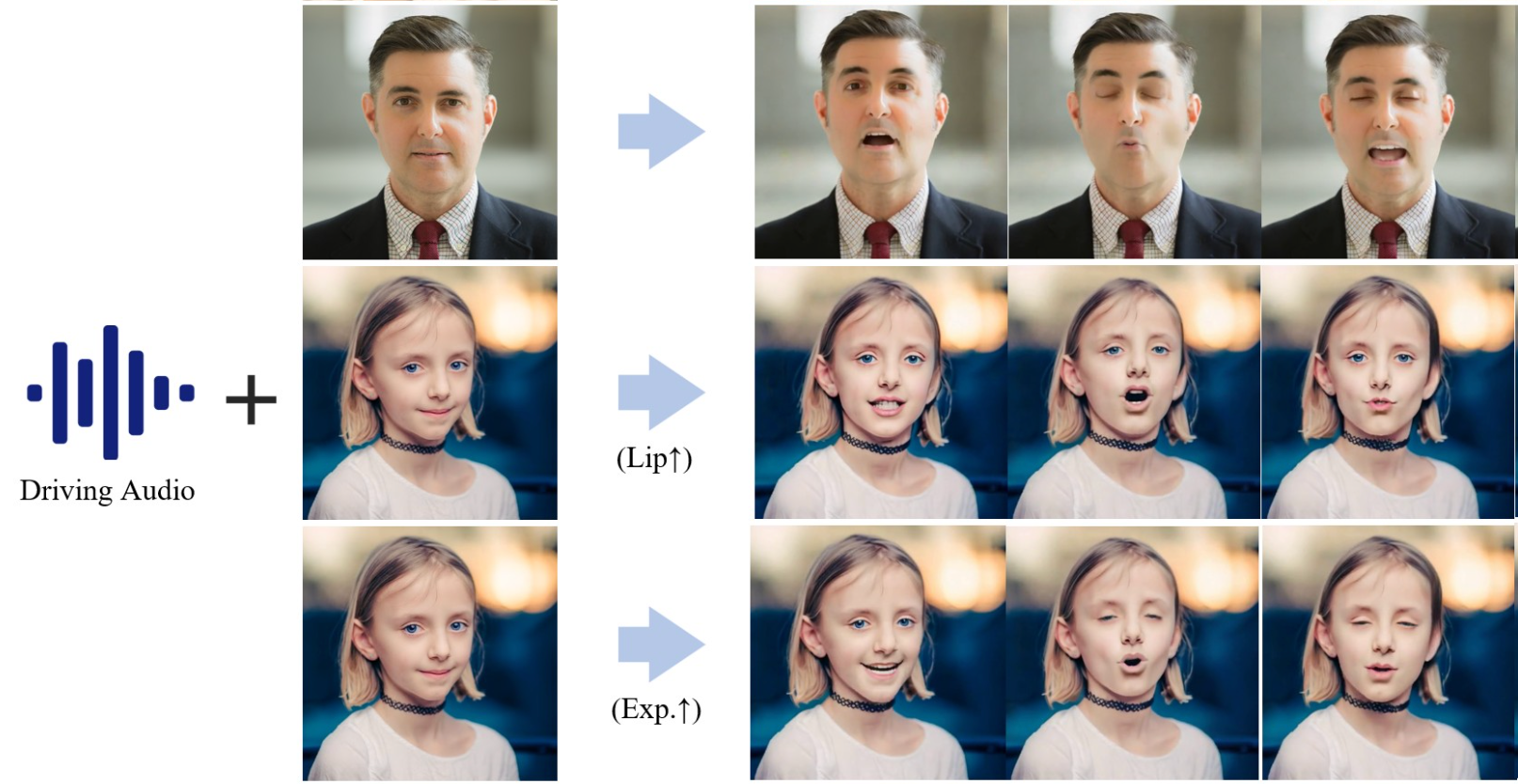

通过输入音频让面部照片开始说话,并且有对于的表情。看起来效果很自然。

采用端到端的扩散范式,引入了分层的音频驱动视觉合成模块,以提高音频输入与视觉输出之间的对齐精度,包括唇部、表情和姿势的运动。

分层音频驱动的视觉合成模块提供了对表情和姿势多样性的自适应控制,更有效地实现了针对不同身份的个性化定制。

相关链接

论文地址:https://arxiv.org/pdf/2406.08801

代码地址:https://github.com/fudan-generative-vision/hallo

试用链接:https://huggingface.co/fudan-generative-ai/hallo

论文阅读

Hallo:用于肖像图像动画的分层音频驱动视觉合成

摘要

由语音音频输入驱动的肖像图像动画领域在生成逼真的动态肖像方面取得了重大进展。这项研究深入研究了在基于扩散的方法框架内同步面部运动和创建视觉吸引力、时间一致的动画的复杂性。我们的创新方法摆脱了依赖参数模型进行中间面部表征的传统范式,采用了端到端扩散范式,并引入了分层音频驱动的视觉合成模块,以提高音频输入和视觉输出之间的对齐精度,包括嘴唇、表情和姿势运动。我们提出的网络架构无缝集成了基于扩散的生成模型、基于 UNet 的降噪器、时间对齐技术和参考网络。所提出的分层音频驱动的视觉合成提供了对表情和姿势多样性的自适应控制,从而能够针对不同身份进行更有效的个性化。通过结合定性和定量分析的综合评估,我们的方法在图像和视频质量、嘴唇同步精度和运动多样性方面表现出明显的增强。

方法

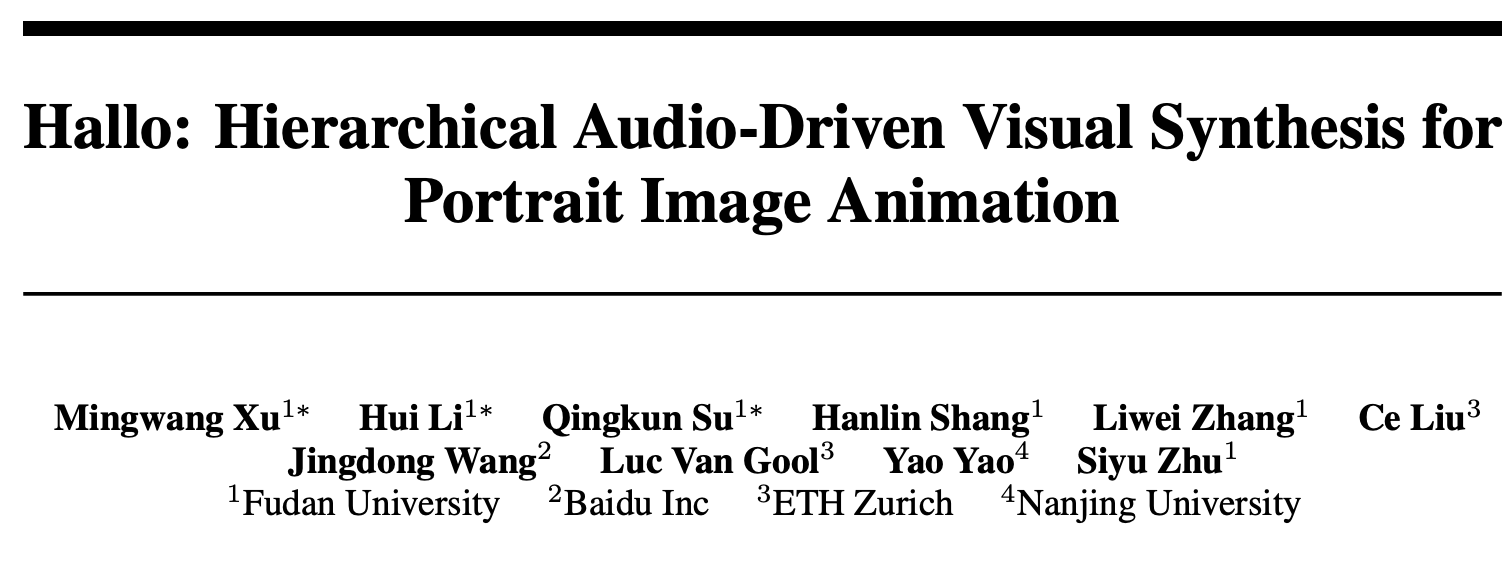

方法概述。具体来说,我们集成了一个参考图像 包含具有相应音频输入的肖像以驱动肖像动画。可选的视觉合成重量可以用来平衡嘴唇,表情和姿势的重量。ReferenceNet编码全局视觉纹理信息一致和可控的角色动画。人脸和音频编码器生成高保真肖像身份特征,并将音频编码为运动信息。层次化视听合成模块建立关系在视听之间。

可视化的层次化听觉驱动视觉合成与对比分析, 对视听交叉注意在原全法和我们提出的分层法之间进行了比较。

效果

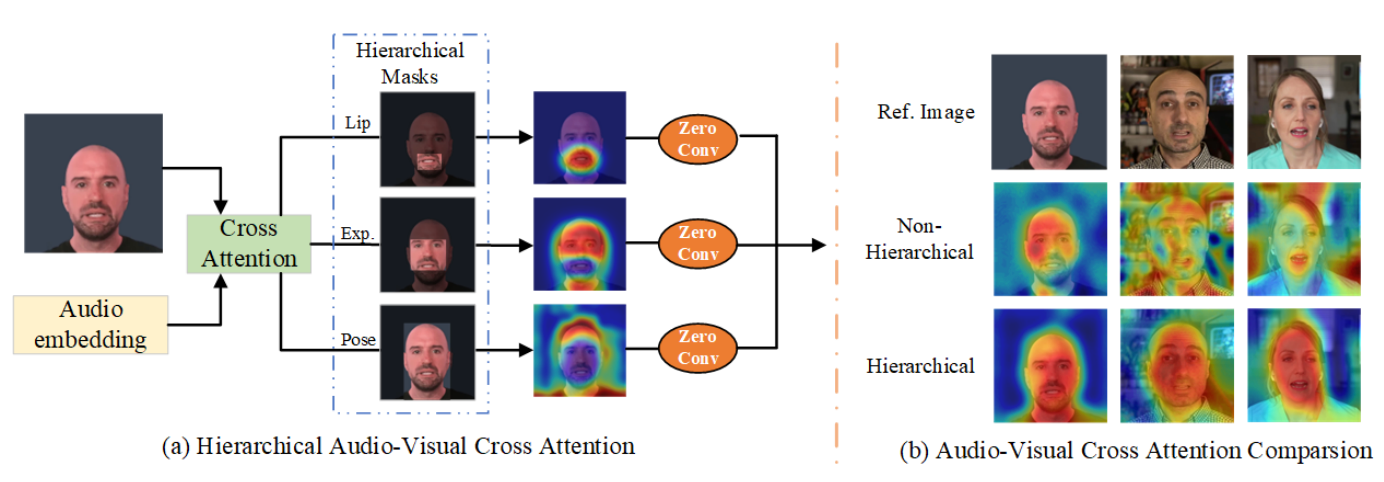

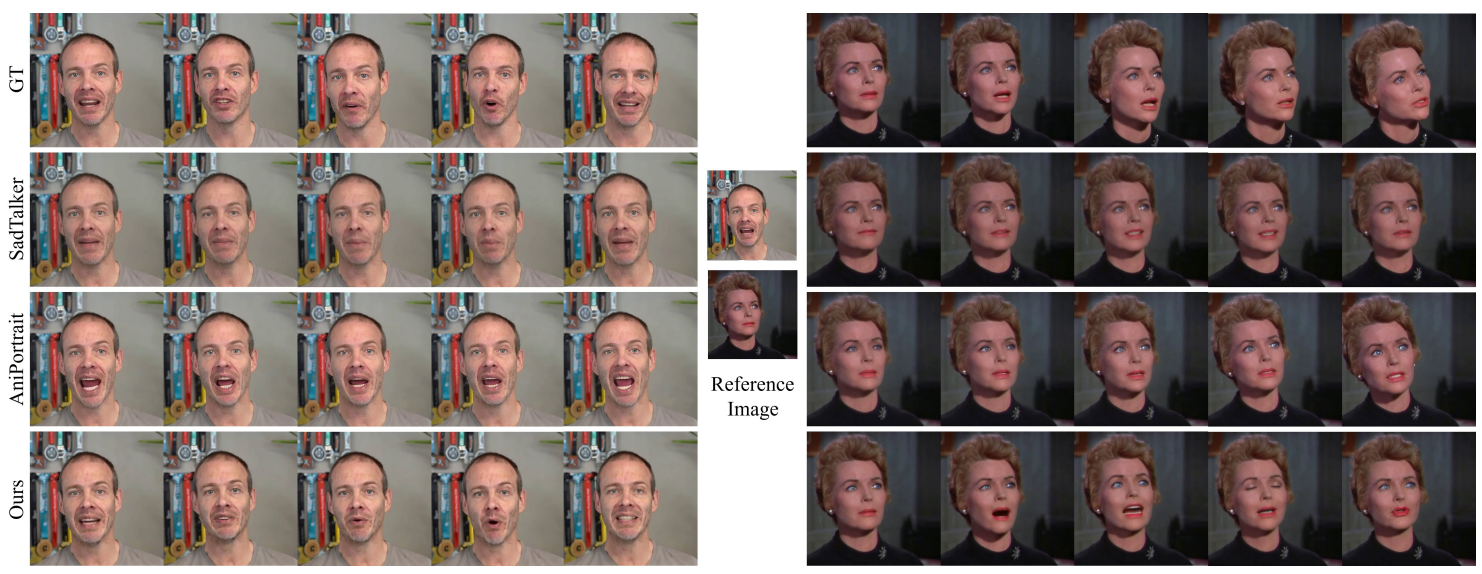

与现有方法在HDTF数据集上的定性比较。

在CelebV数据集上与现有方法的定性比较。

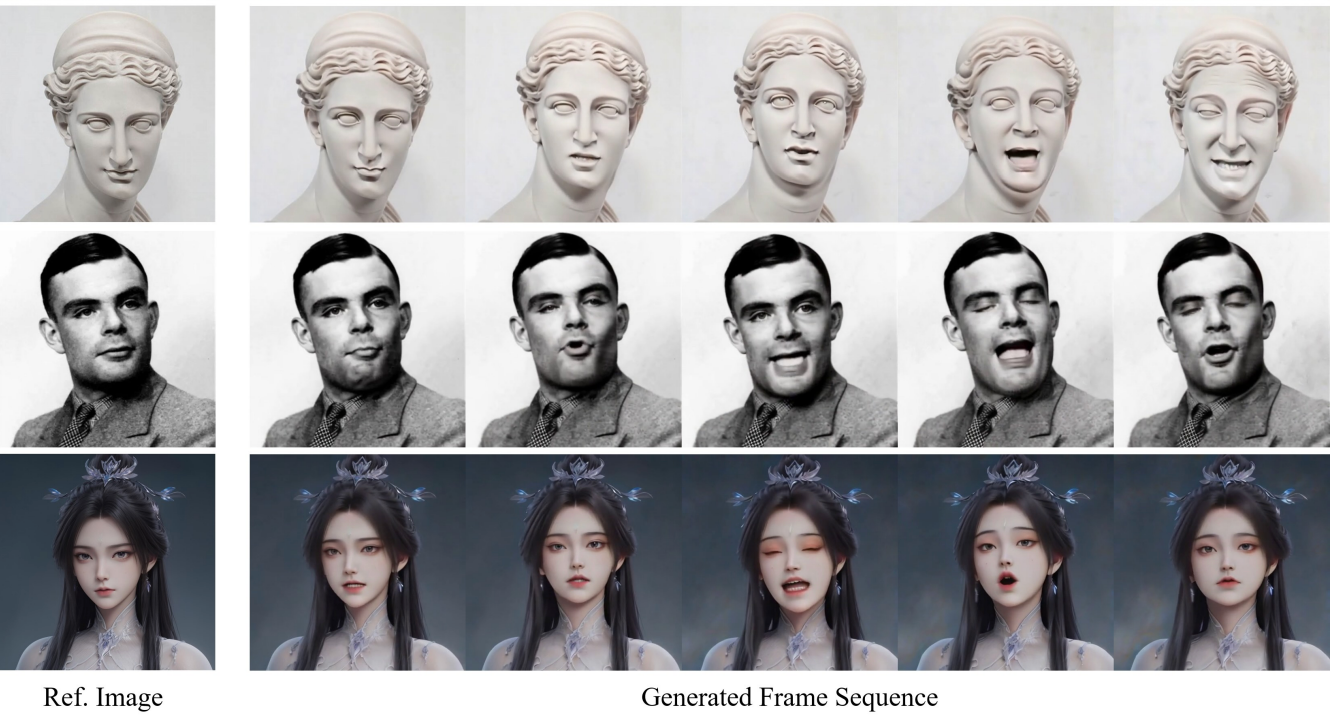

在不同的肖像风格下,提出的方法的视频生成结果。

给出不同音频风格的视频生成结果。

结论

本文介绍了一种使用端到端扩散模型进行肖像图像动画的新方法,解决了音频驱动面部动态同步和具有时间一致性的高质量动画生成方面的挑战。所提出的分层音频驱动视觉合成模块通过交叉注意机制和自适应加权增强了视听对齐。通过集成基于扩散的生成建模、UNet 去噪、时间对齐和 ReferenceNet,该方法提高了动画质量和真实感。实验评估证明了卓越的图像和视频质量、增强的唇部同步和增加的运动多样性,并通过卓越的 FID 和 FVD 指标进行了验证。该方法允许灵活控制表达和姿势多样性,以适应不同的视觉身份。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?