大家还在抱怨FLUX模型的生态支持慢吗?终于支持FLUX模型的ControlNet-Inpainting来了。Alimama Creative团队的研究人员发布的FLUX.1-dev模型提供了Inpainting ControlNet检查点。ComfyUI 现在也已经支持Flux-ControlNet-Inpainting 的推理。工作流程可以从本文链接下载。目前开放的知识训练过程中的alpha版本,即将发布更新版本。当然这也不影响我们去使用。ok,我们先来模型推理的效果~

相关链接

模型下载:https://huggingface.co/alimama-creative/FLUX.1-dev-Controlnet-Inpainting-Alpha

ComfyUI工作流下载:https://huggingface.co/alimama-creative/FLUX.1-dev-Controlnet-Inpainting-Alpha/resolve/main/images/alimama-flux-controlnet-inpaint.json

ComfyUI使用提示:

-

使用t5xxl-FP16和flux1-dev-fp8模型进行28步推理,GPU显存占用为27GB。使用时的推理时间cfg=3.5为 27 秒,不使用时的推理时间cfg=1为 15 秒。Hyper-FLUX-lora可用于加速推理。

-

control-strength您可以尝试调整(降低)参数control-end-percent,cfg以达到更好的效果。

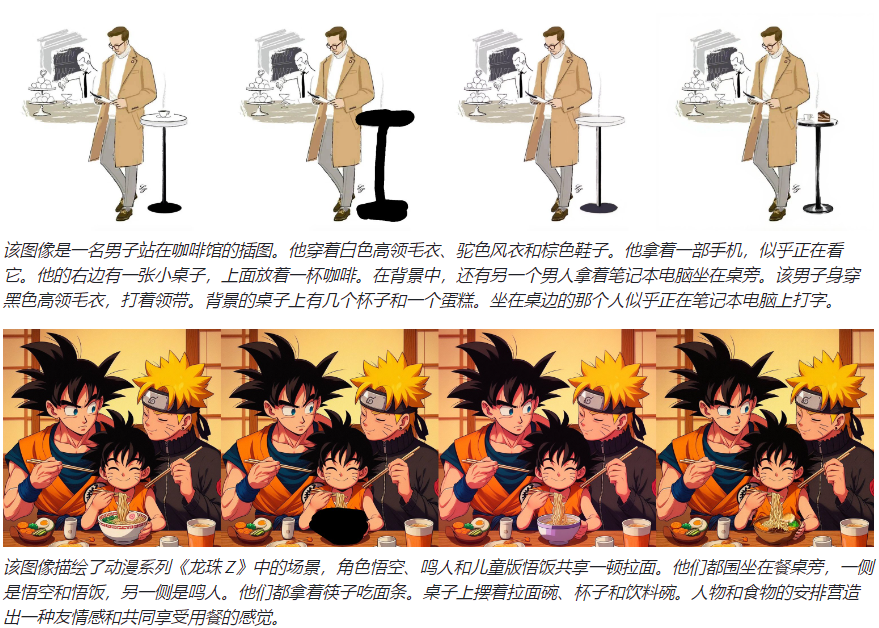

以下示例使用control-strength= 0.9 & control-end-percent= 1.0 & cfg= 3.5

模型介绍

-

该模型在 12M laion2B 和分辨率为 768x768 的内部源图像上进行训练。推理在此大小下表现最佳,而其他大小则产生次优结果。

-

建议的 controlnet_conditioning_scale 为 0.9 - 0.95。

注意:这只是训练过程中的alpha版本,即将发布更新版本。

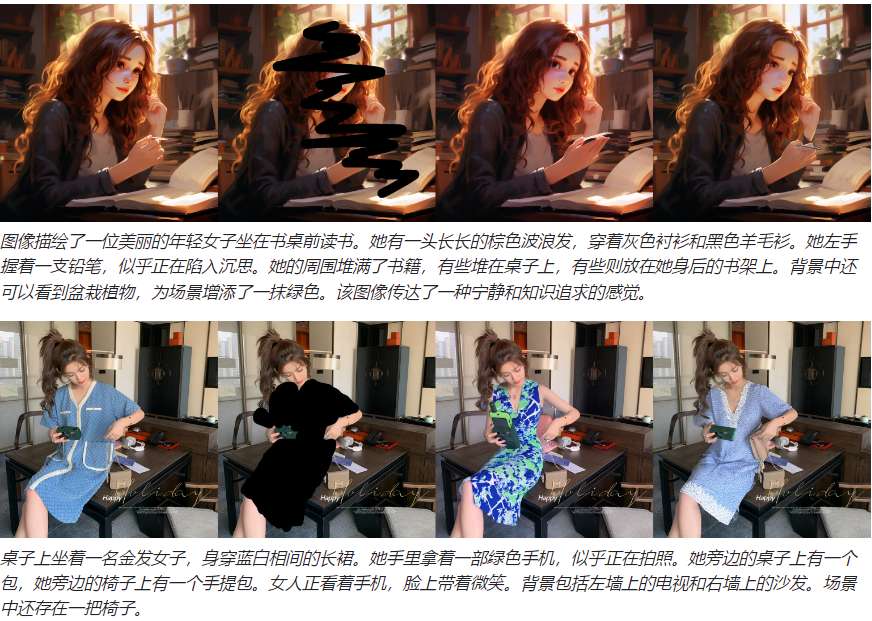

效果演示

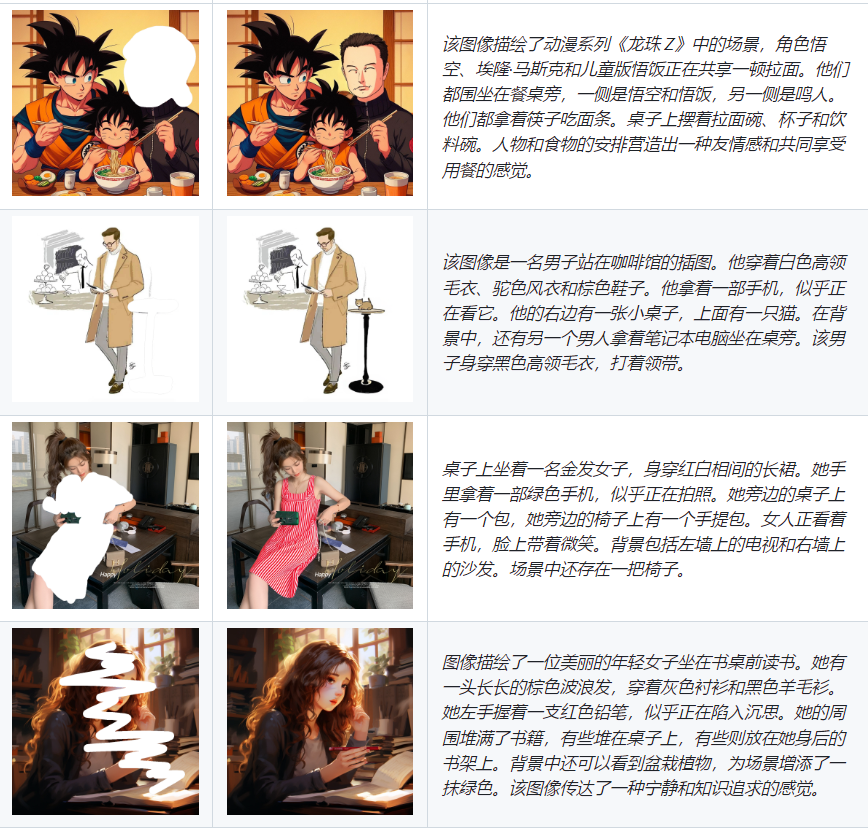

与 SDXL-Inpainting 的比较

与SDXL-Inpainting相比,从左到右分别为输入图像 | 蒙版图像 | SDXL 修复 | 本文方法。

与Diffusers一起使用

步骤1:安装扩散器

pip install diffusers==0.30.2

步骤2:从github克隆repo

git clone https://github.com/alimama-creative/FLUX-Controlnet-Inpainting.git 步骤3:修改image_path、mask_path,提示并运行.

python main.py

2707

2707

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?