字节最近发布两款视频生成模型:豆包视频生成-「PixelDance」和豆包视频生成-「Seaweed」。这是字节继公开发布「Dreamina/即梦」之后,再次推出视频生成模型。支持文生/图生视频,主打多主体交互、酷炫运镜、一致性多镜头及多风格比例,已开启企业用户邀请测试,将逐步开放给所有用户。从PixelDance流出的的测评片段可以看出效果非常的惊艳。

早在去年11月,字节团队已经发布了一篇名为《Make Pixels Dance: High-Dynamic Video Generation》的论文,介绍这款名为PixelDance的视频生成模型。

OK,今天我们来学习一下这篇文章前文章,一起探索PixelDance背后的细节。

相关链接

-

申请路径:https://console.volcengine.com/ark

-

论文地址:https://arxiv.org/abs/2311.10982

-

官网地址:https://makepixelsdance.github.io

论文阅读

介绍

创建高动态视频(例如动作丰富的动作和复杂的视觉效果)对人工智能领域提出了重大挑战。不幸的是,当前最先进的视频生成方法主要侧重于文本到视频的生成,尽管保持了高保真度,但往往会生成具有最小动作的视频剪辑。我们认为,仅依靠文本指令对于视频生成来说是不够的,也不是最佳的。

本文介绍的PixelDance是一种基于扩散模型的新方法,它将第一帧和最后一帧的图像指令与文本指令结合起来用于视频生成。综合实验结果表明,使用公共数据训练的 PixelDance 在合成具有复杂场景和复杂动作的视频方面表现出明显更好的熟练程度,为视频生成树立了新标准。

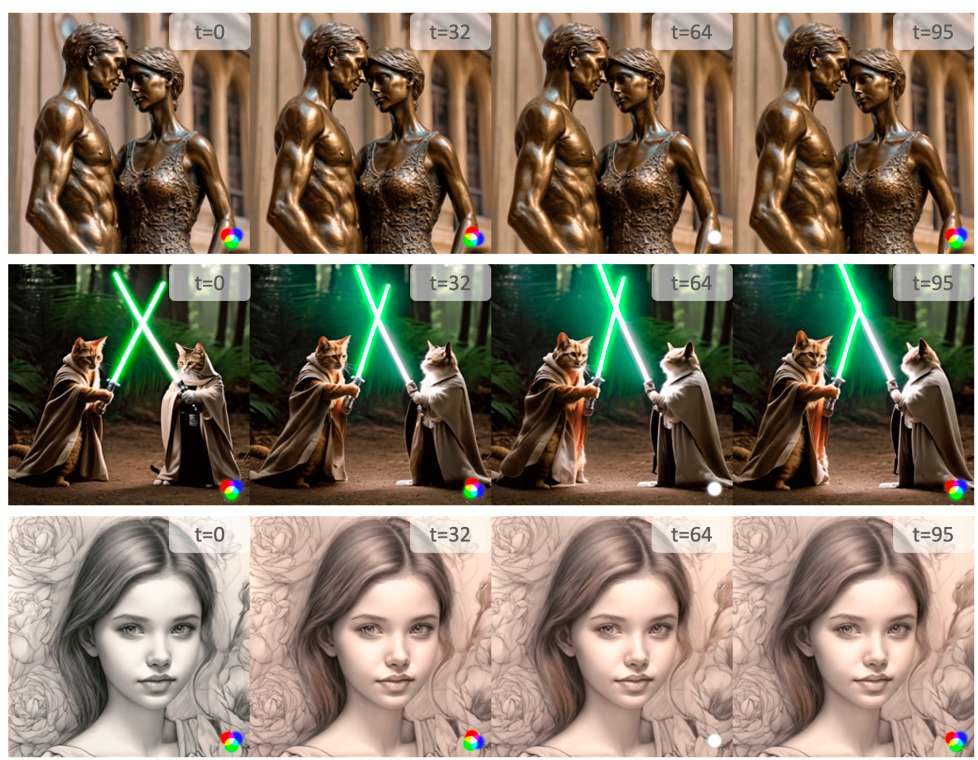

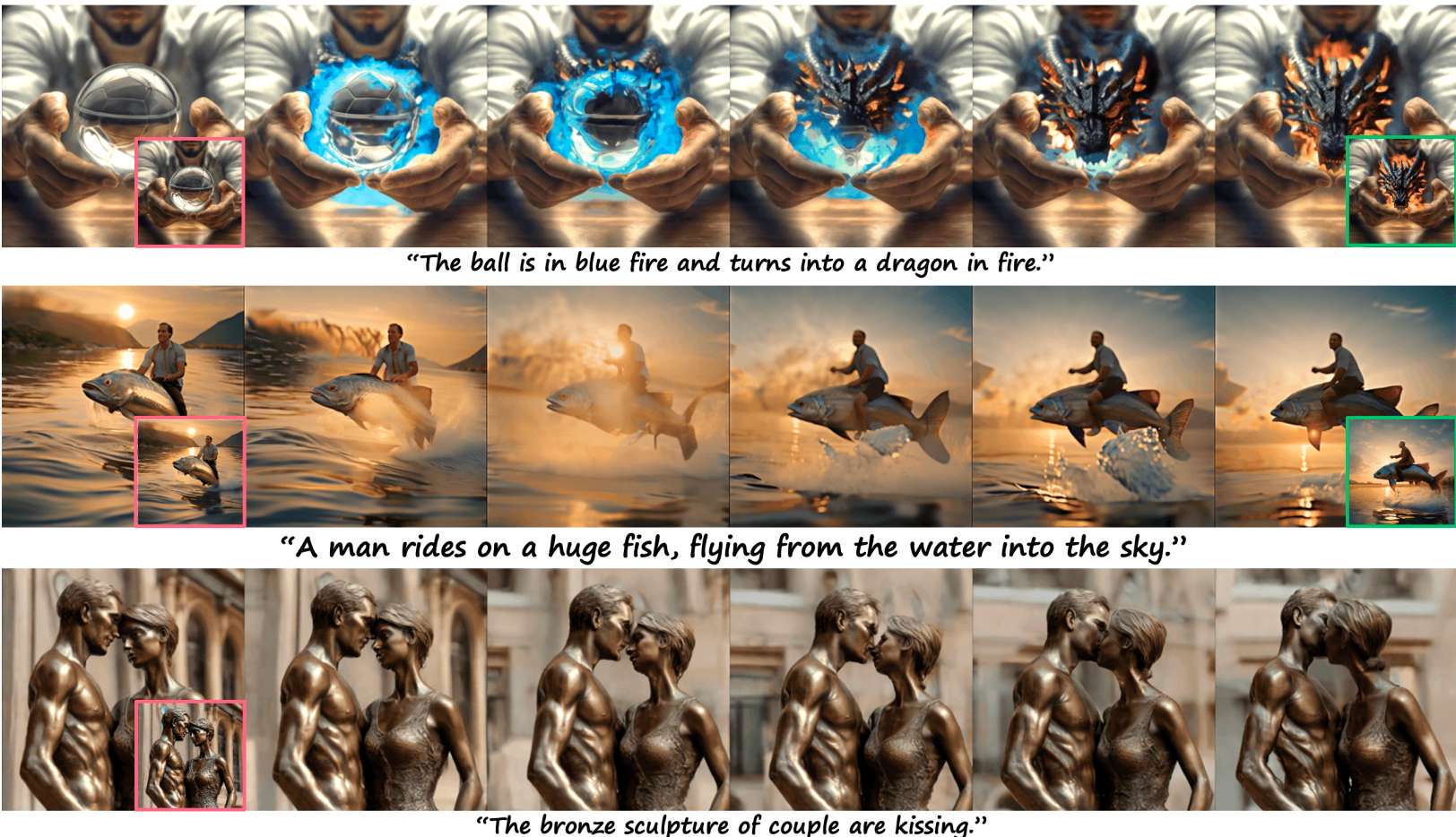

上图为采用最先进的视频生成模型生成的视频,与我们在图1和图4中给出的相同文本提示和图像条件下的结果进行了比较。

主要贡献:

-

我们提出了一种基于扩散模型的新型视频生成方法 PixelDance,该方法结合了第一帧和最后一帧的图像指令和文本指令。

-

我们为 PixelDance 开发了训练和推理技术,不仅有效地提高了生成的视频质量,还为用户提供了对视频生成过程的更多控制。

-

我们在公共数据上训练的模型在具有复杂场景和动作的高动态视频生成中表现出色,为视频生成树立了新标准。

方法

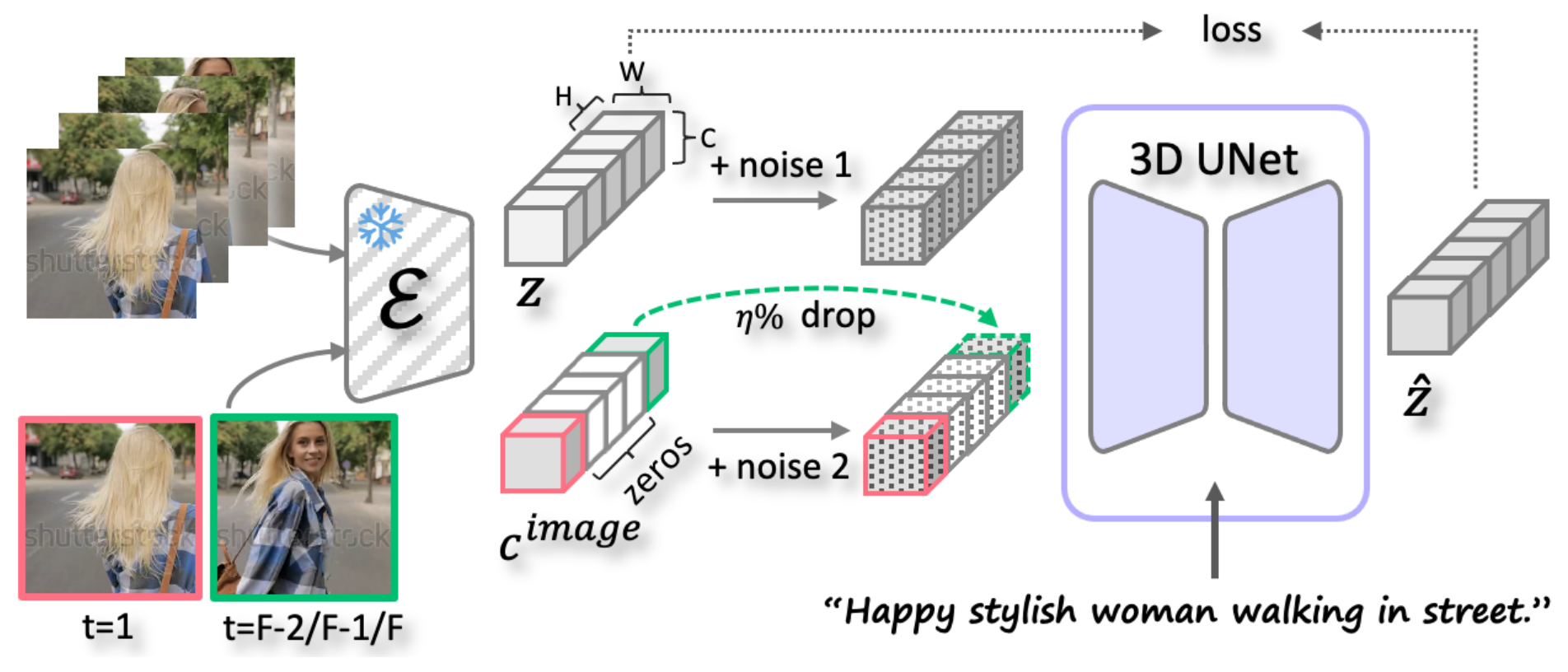

PixelDance训练过程说明。 原始视频片段和图像指令(红色和绿色框中)被编码为 z 和 c_image,然后在受到不同噪声干扰后沿通道维度连接起来。

对于首帧指令,在训练中采用真实首帧,确保模型在推理过程中严格遵循首帧指令。相比之下,我们有意避免让模型完全复制末帧指令。在推理过程中,由于无法提前获取真实末帧,模型需要适应用户提供的粗略草稿以生成时间一致的视频。为此,我们引入了三项技术。

-

我们从片段的最后三帧中随机选择一帧作为训练中的末帧指令。

-

为了提高模型的鲁棒性,我们对图像指令 cimage进行噪声扰动。

-

在训练过程中,我们以一定概率 η 随机丢弃末帧指令,用零替换相应的潜变量。

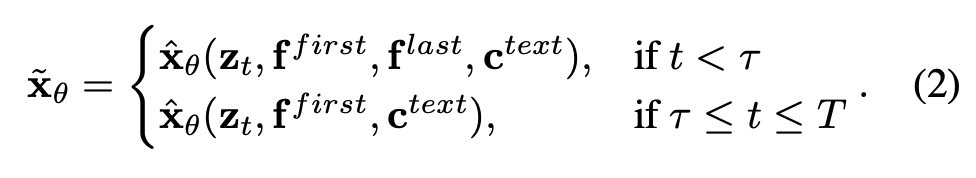

相应地,我们提出了一种简单但有效的推理技术。在推理过程中,在总去噪步骤 T 的前 τ 步中,使用末帧指令引导视频生成朝向期望的结束状态,并在后续步骤中丢弃该指令,以生成更连贯且时间一致的视频:

τ 决定了模型对末帧指令的依赖强度,通过调整 τ 可以实现各种应用。例如,我们的模型可以在没有末帧指令的情况下生成高动态视频(即 τ = 0)。此外,我们在推理中应用了分类器自由指导,它将条件于文本提示和不带文本提示的模型得分估计混合在一起。

实验

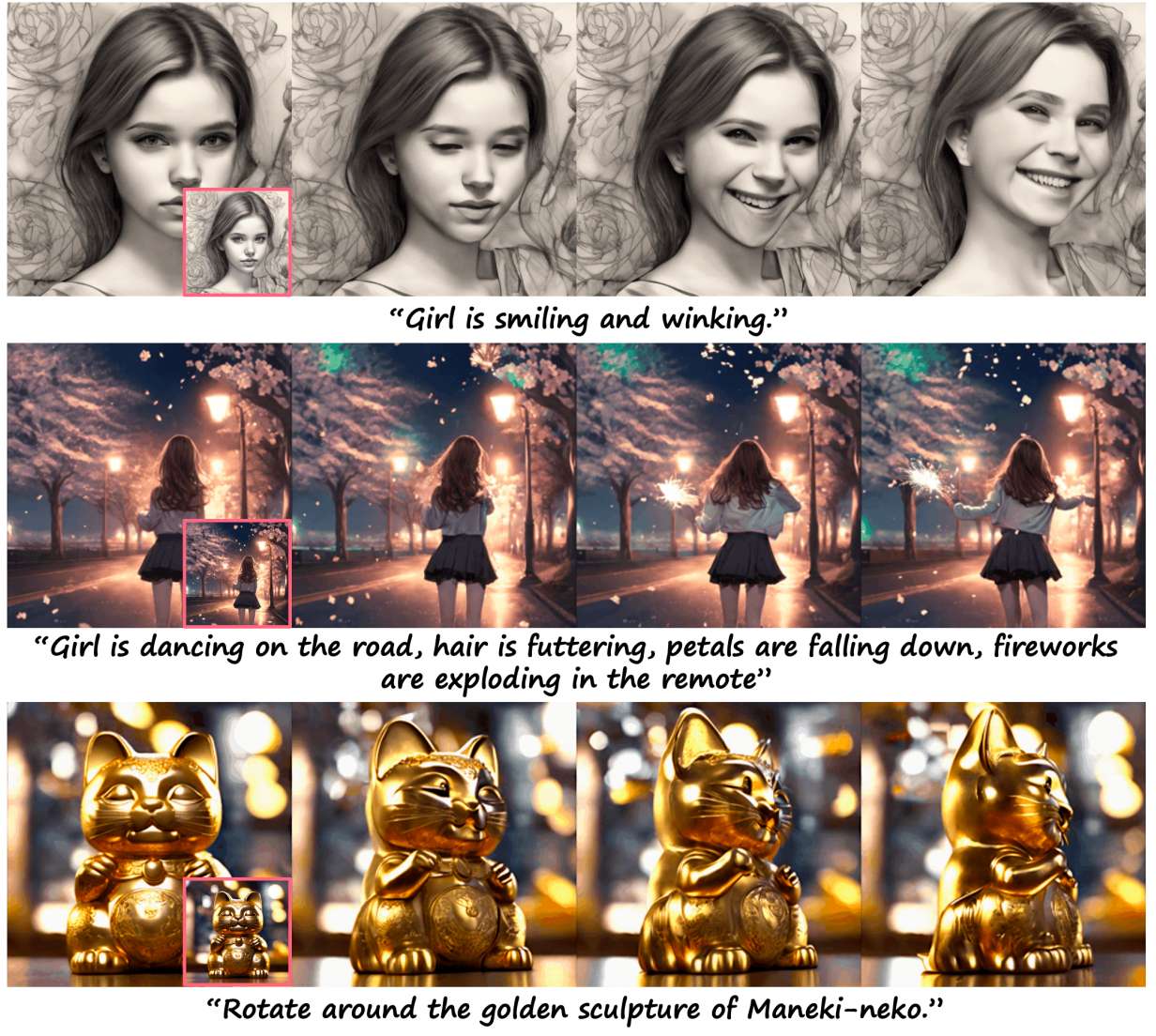

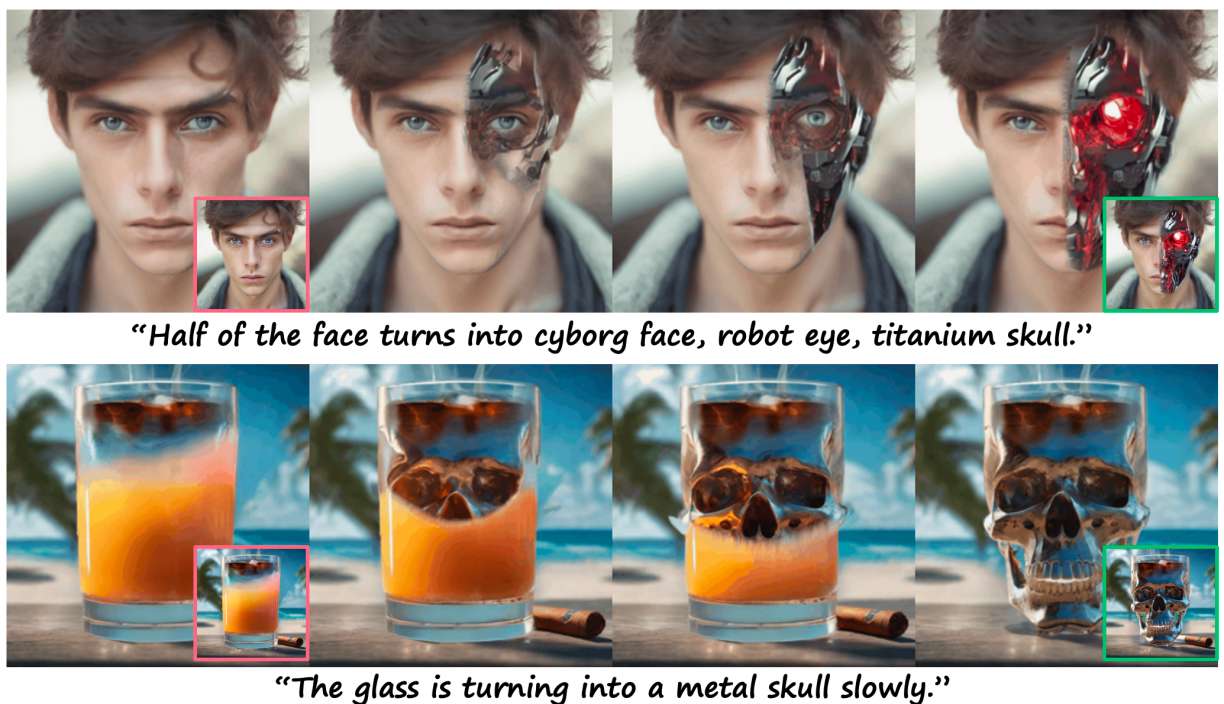

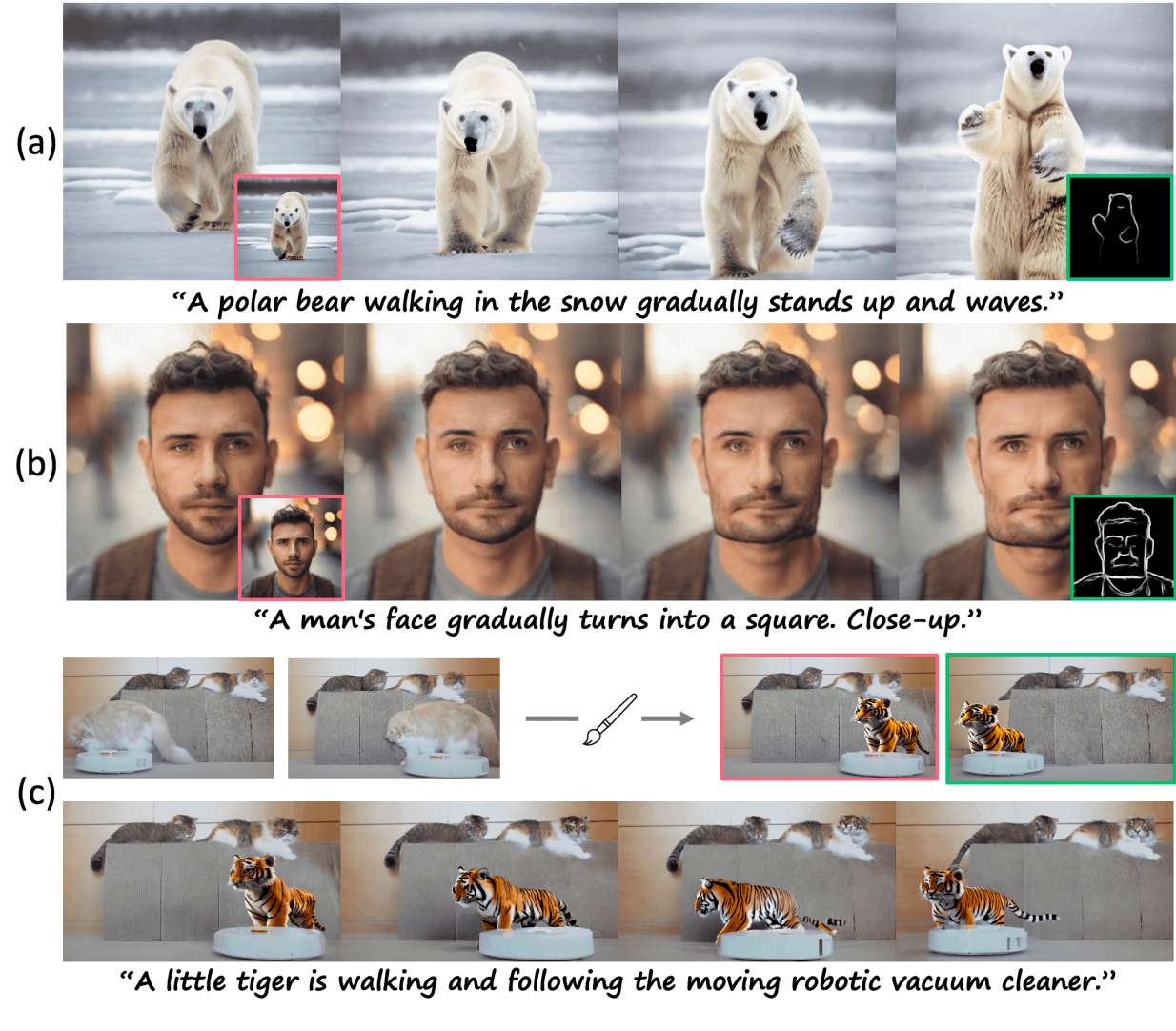

PixelDance给定文本的生成结果,第一帧指令用红色框突出显示(最后一帧指令用绿色框突出显示)。显示从16帧剪辑中采样的6帧。本文采用文本-图像模型对人脸进行合成。

基于文本和第一帧指令的视频生成示例。

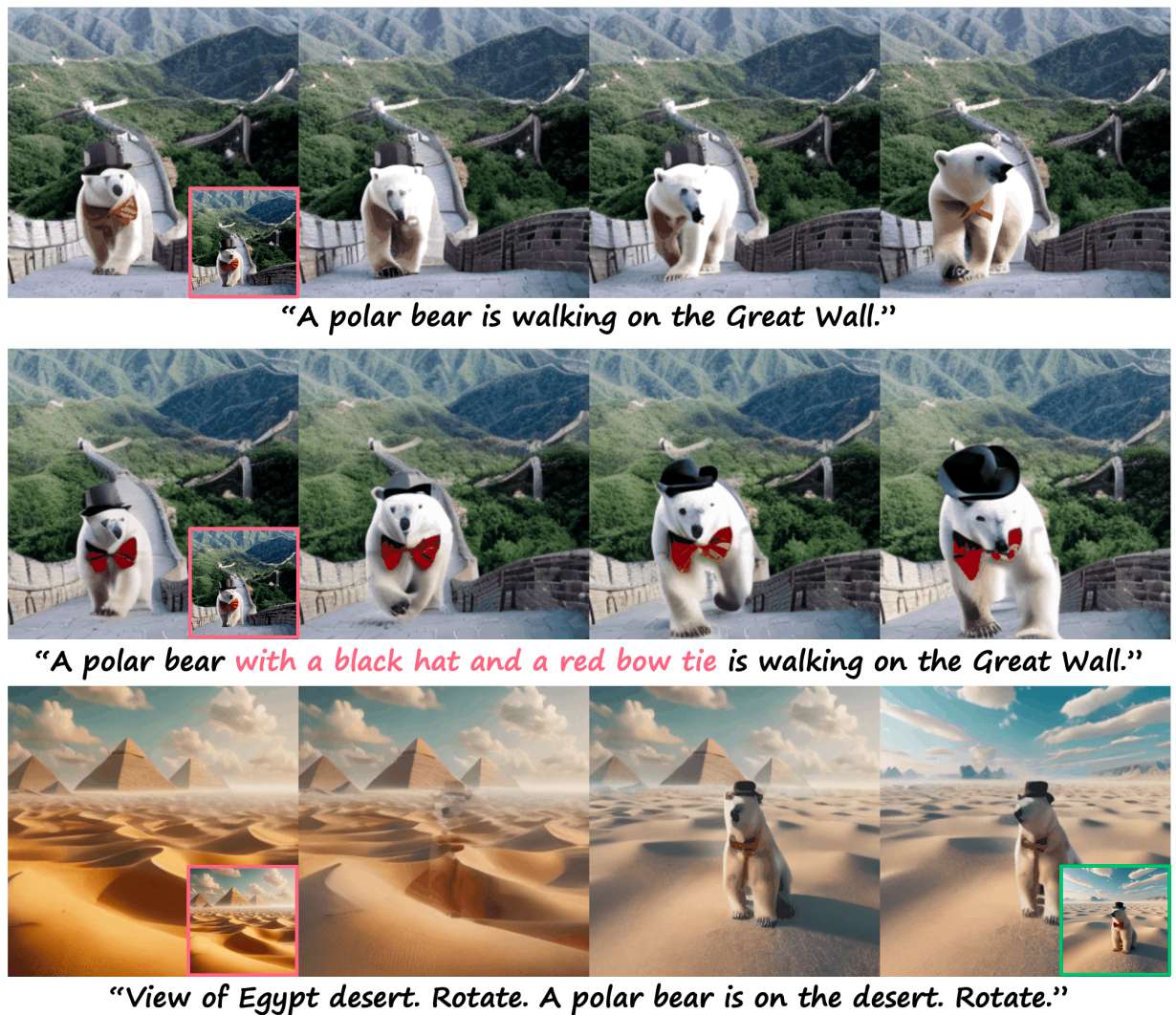

基于文本、第一帧和最后一帧指令的复杂视频生成的图示。

前两行:文字说明有助于增强北极熊的黑帽子和红领结等关键元素的跨帧一致性。最后一行:自然的镜头过渡。

说明所提出的技术(τ = 25)的有效性,避免重复最后一帧指令。

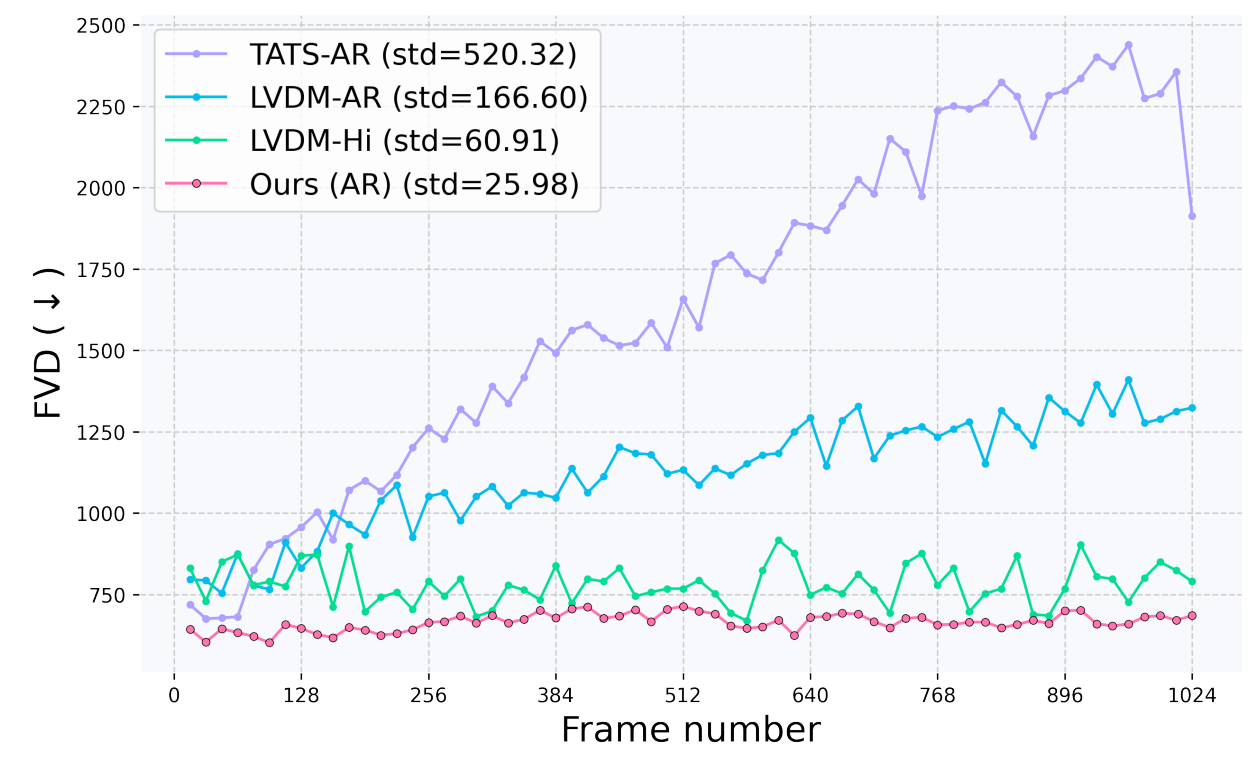

UCF-101 上长视频生成(1024 帧)的 FVD 比较。AR:自回归。Hi:分层。使用 PixelDance 构建长视频采用自回归方式。

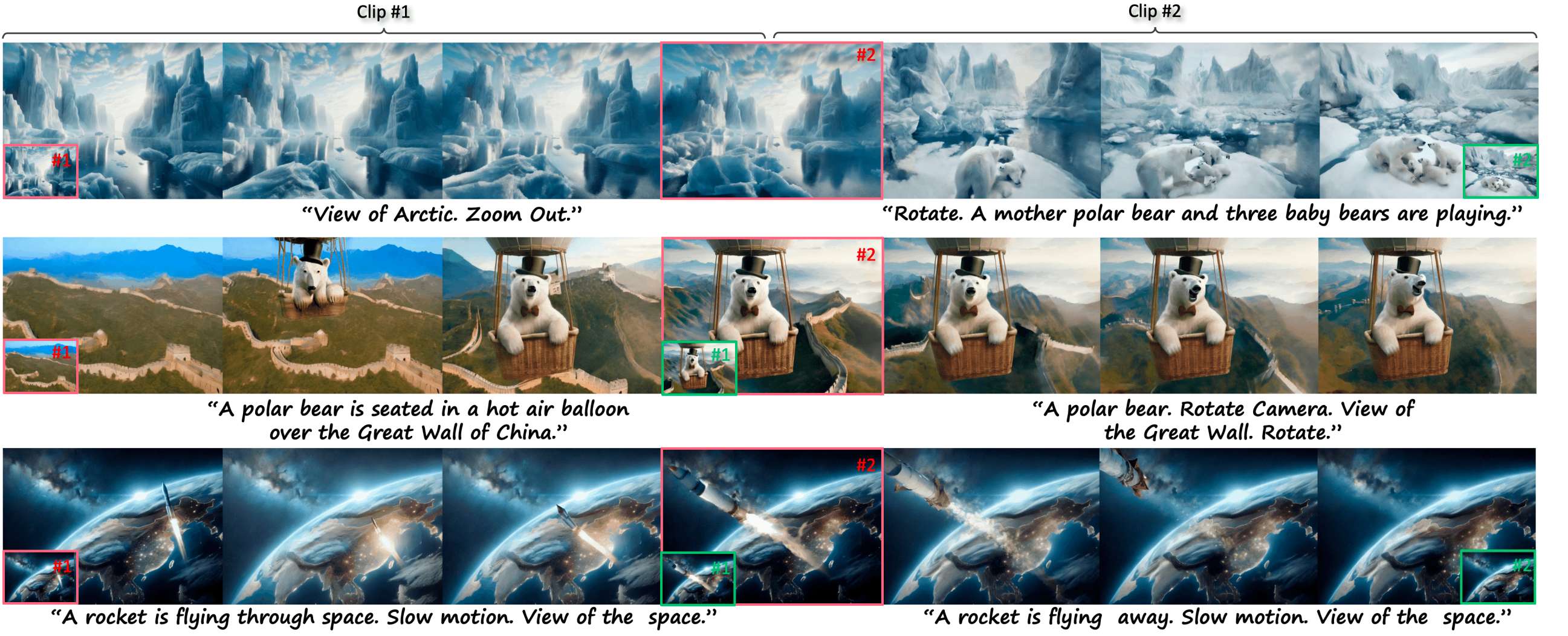

PixelDance 处理由两个连续视频剪辑组成的复杂镜头合成的说明,在这种情况下,剪辑 #1 的最后一帧作为剪辑 #2 的第一帧指令。

以草图图像为例的视频生成说明。 最后一帧指令(前两个例子),和PixelDance for零镜头视频编辑(c)。

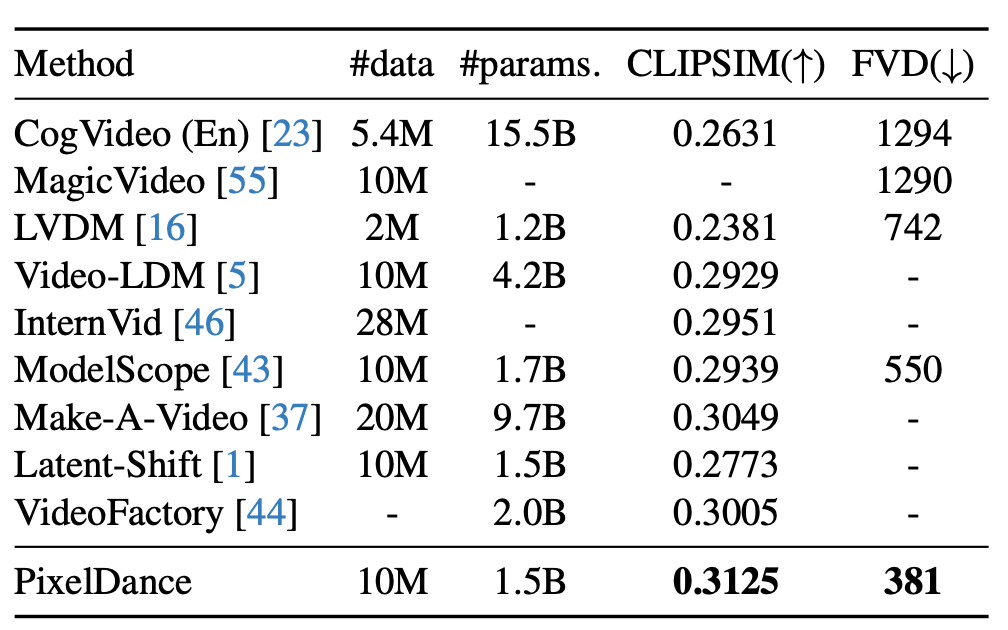

MSR-VTT 上的零样本 T2V 性能比较。 所有方法均生成空间分辨率为 256×256 的视频。最佳方法以粗体显示。

UCF-101 上的零样本 T2V 性能比较。 所有方法均生成空间分辨率为 256×256 的视频。 最佳方法以粗体显示。

结论

在本文中,我们提出了一种基于扩散模型的新型视频生成方法 PixelDance,该方法结合了第一帧和最后一帧的图像指令和文本指令。我们开发了专门针对此方法的训练和推理技术。主要在 WebVid-10M 上训练的 PixelDance 在合成具有复杂场景和动作的视频方面表现出色,为视频生成树立了新标准。

虽然我们的方法取得了显著的成果,但仍有进一步发展的潜力。首先,该模型可以从使用高质量开放域视频数据进行训练中受益。其次,在特定领域内微调模型可以进一步增强其功能。第三,结合带注释的文本来概述视频的关键元素和动作可以提高与用户指令的一致性。最后,PixelDance 目前仅包含 1.5B 个参数,为未来的扩展提供了机会。我们将在未来的工作中进一步研究这些方面。

1308

1308

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?