写这篇文章原因下载 qwen 110B 模型发现不同量化占的内存差异很大,就想搞明白到底量化会着重影响哪方面的推理能力

“

Qwen1.5-110B-Chat的显存全精度部署(32 精度)占用220GB;8bit量化部署Qwen1.5-110B需要113GB显存;4bit量化部署Qwen1.5-110B,需要62GB显存

大型语言模型(LLMs)的量化是减小其大小和内存使用的关键策略,同时努力保持其质量。这种压缩技术对于在计算能力有限的设备上部署高级模型至关重要

2 种量化方式

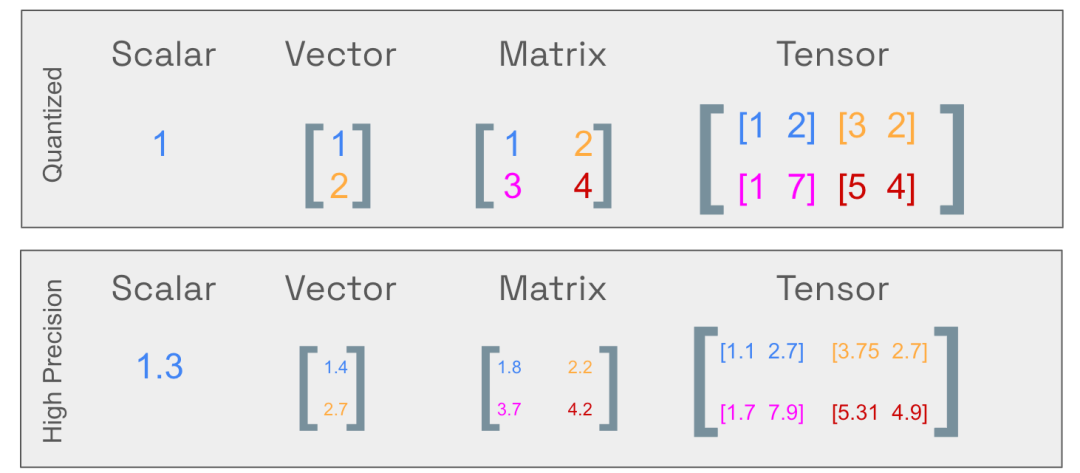

量化是指将连续的无限值映射到较小的离散有限值集合的过程。在大型语言模型(LLMs)的背景下,量化是指将模型的权重从高精度数据类型转换为低精度数据类型的过程。

在量化语言模型(LLM)的技术中,可以分为两种主要的方法:

- 训练后量化 (Post-Training Quantization, PTQ):

PTQ 是指将已经训练好,微调好的模型权重转换为较低精度,而无需进行重新训练。这种方法简单易行,但由于权重值的精度降低,可能会稍微影响模型的性能。

简单理解:想象你有一个已经写好的程序,现在你想让它在更简单的计算机上运行,你可以把程序中的数字变得更简单。但是,这可能会让程序稍微变得没那么好用

下图就是把 1.3 变成 1

大多数 LLM用 Auto-GPTQ(hugging face 库里就有)来量化,包括 llama,qwen

pip install auto-gptq optimum 有的不想要官方量化版本的,就自己下载全参数的,用 Auto-GPTQ自己量化

GPTQ其实也是PTQ的一种,但它有一些特别之处。它使用一种混合的量化方案,将模型的权重量化为4位整数(int4),而保留激活值activation为16位浮点数(float16)。在推理(模型使用)时,权重会被动态地转换回浮点数,然后进行实际计算。这种方法带来了接近4倍的内存节省和可能的速度提升,因为权重使用了更低的带宽

而之所以要保留 activation值是 float16,是因为 activation 4 bit 量化后的效果会很糟糕, 而权重 4 bit 量化对质量影响小

- 量化感知训练 (Quantization-Aware Training, QAT):

与 PTQ 不同,QAT 在训练阶段或者在训练后的微调阶段 fine-tuning就进行权重转换。这通常会带来更好的模型性能,但需要更多的计算资源。一种广泛使用的 QAT 技术是 QLoRA。

简单理解: 想象你在写程序的时候,就想着怎么让它在更简单的计算机上运行。这需要你花更多时间和精力,但最后程序可能会更好用

在用 QAT量化大型语言模型(LLMs)时,面临主要挑战:保持零样本泛化能力zero-shot

LLMs在预训练时表现出很强的零样本泛化能力zero-shot,这意味着它们能在没有见过的任务上也能表现不错。为了在量化后保持这种能力,选择合适的微调数据集很重要。如果QAT数据集的领域太窄或与原始预训练数据分布差异太大,可能会影响模型性能

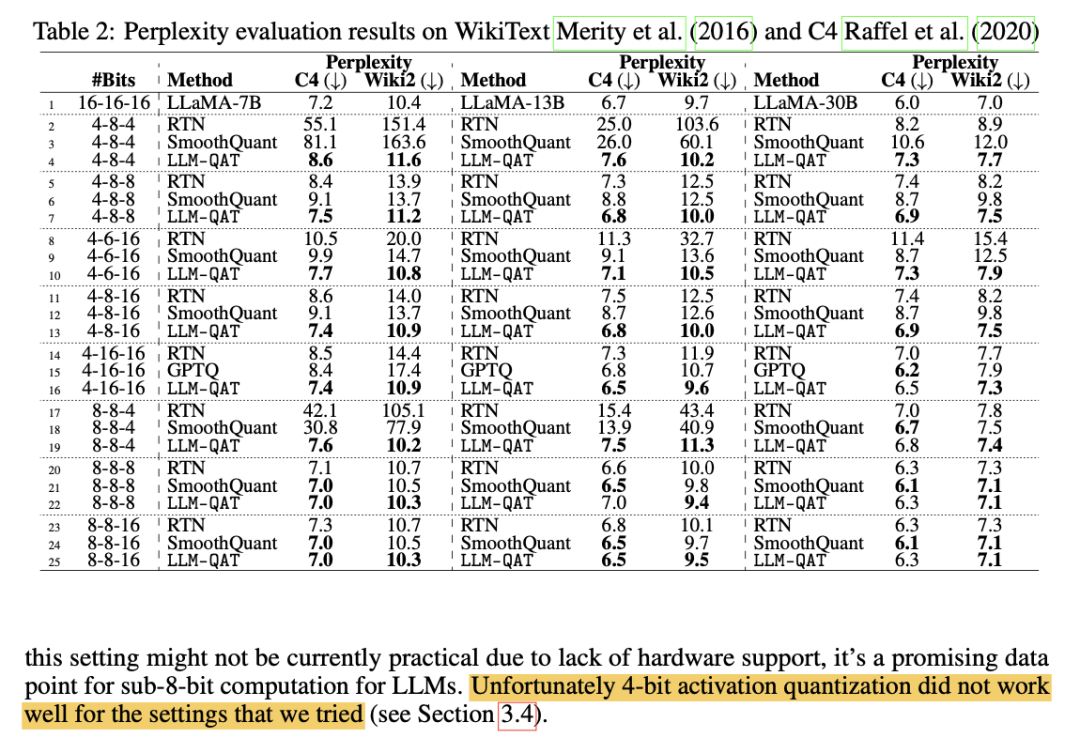

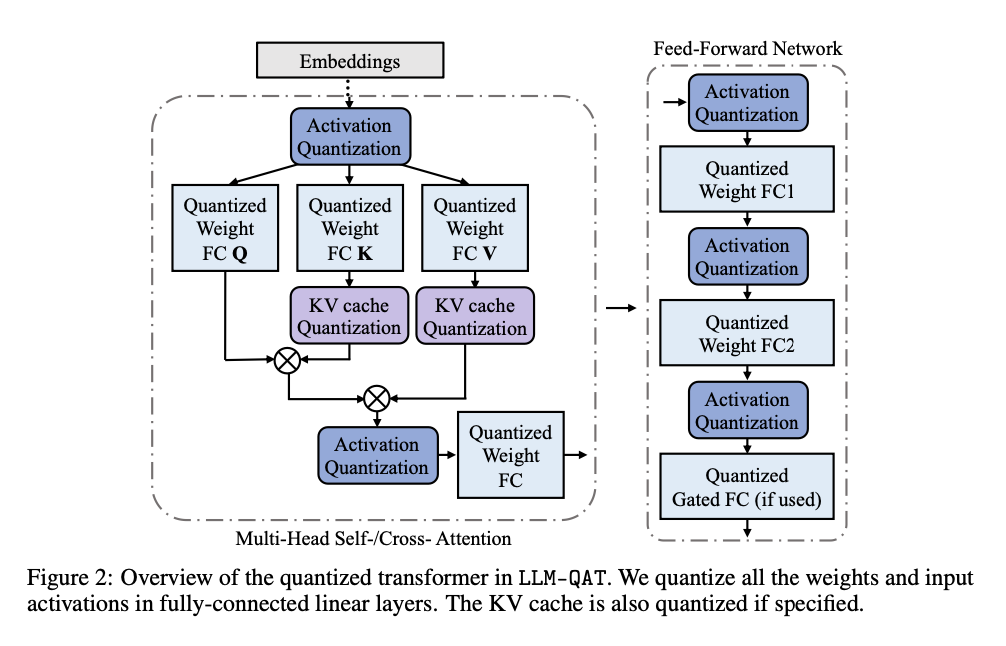

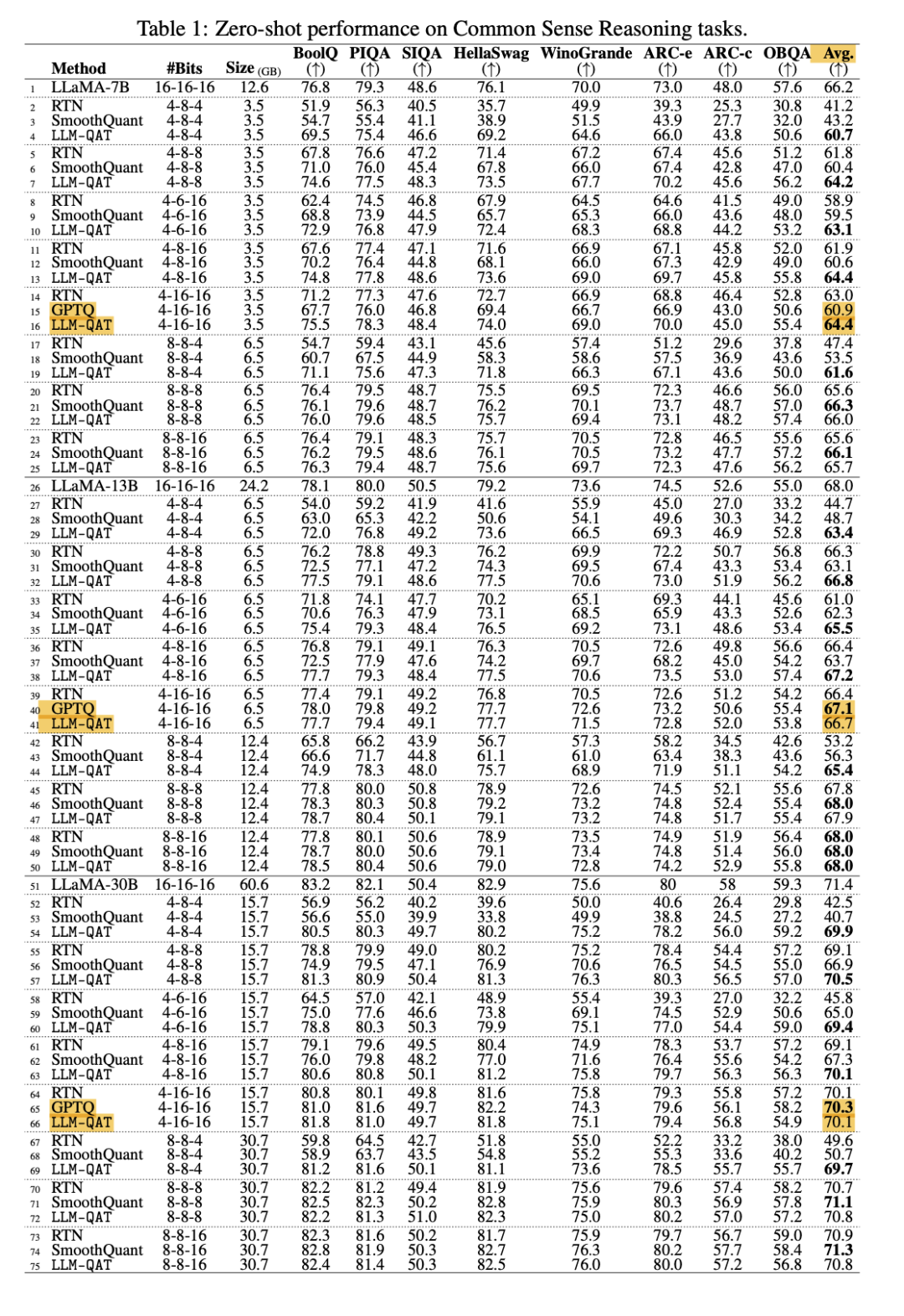

在<LLM-QAT: Data-Free Quantization Aware Training for Large Language Models>这篇论文中主要引入了一种“无数据量化感知训练”(data-free QAT)方法,以 LLaMA models (7B, 13B, and 30B)为例,这种方法使用模型自己生成的数据来进行训练。这样做可以更好地保持原始模型的输出分布,即使不使用原始训练数据也能取得很好的效果,尤其实在较低位数的量化中

LLM-QAT 量化了权重,激活值和 KV 缓存

我在看这篇论文时,根据提供的图表, PTQ 和 QAT 差别也不大

量化模型4 个评估标准

-

perplexity:作为评估语言模型性能的常用指标,用于衡量模型预测下一个词的不确定性。

-

BLEURT:基于BERT架构的学习型评估指标,专注于预测文本与参考材料之间的语义相似度。

-

ChrF:用于评估文本生成系统质量的自动评估指标,特别适用于机器翻译任务。

-

Frugalscore:提供快速评估文本质量的评估指标,适用于计算资源有限的环境。

-

METEOR:用于自然语言处理中评估机器翻译系统产生的文本质量的评估指标

-

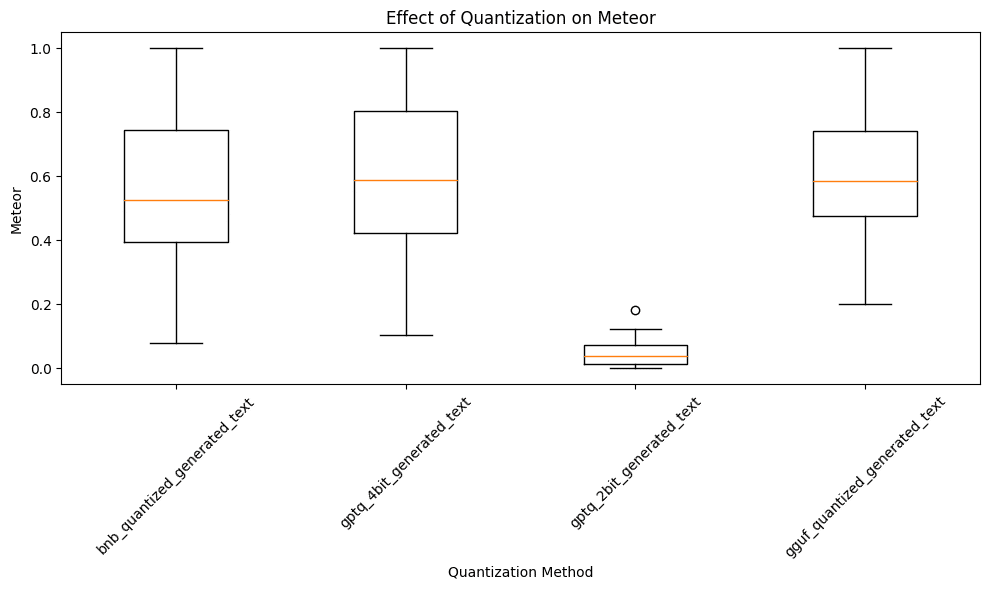

困惑度:不同LLM量化方法的平均困惑度值与未量化模型相比没有显著偏差,但2位GPTQ量化方法显示出较高的困惑度,表明可能会降低预测性能

-

BLEURT:量化模型在保持语义质量方面表现不一,有些量化版本与未量化模型的输出非常接近,而其他则显示出明显的下降,特别是GPTQ 2-bit方法导致负BLEURT分数,表明与未量化模型输出的显著偏差。

-

ChrF:除了GPTQ 2-bit外,所有量化方法的模型都达到了约60%的ChrF分数,表明与未量化模型输出有很强的相似性。

-

Frugalscore:三种量化方法(Bitsandbytes、GPTQ 4-bit和GGUF)在保持语义质量方面表现良好,而GPTQ 2-bit方法的MoverScore显著降低,表明文本质量和连贯性的显著减少。

-

METEOR:除了GPTQ-2bit外,其他三种量化方法在保持语义丰富性和句法准确性方面表现良好,而GPTQ-2bit的METEOR分数接近零,表明显著的质量下降

根据上面记录,2-bit量化严重影响了文本连贯性,怪不得最低都是 4 位量化

为了进一步分析上述结果并确定哪种LLM量化方法影响最小,考虑进行Kruskal-Wallis H检验。这种非参数检验不需要假设数据来自特定的分布,可以比较不同量化方法的影响。如果出现显著差异,则进行后续测试,如Dunn’s测试,以明确模型之间的具体对比。这一统计方法将阐明LLM量化如何影响每个模型,从而指导选择最佳保留模型质量的方法。

具体来说,Kruskal-Wallis H检验是一种非参数检验方法,用于比较三组或以上样本之间是否存在显著差异。它使用秩代替实际数据,不需要假设数据来自正态分布。如果在Kruskal-Wallis H检验中发现显著差异,可以使用Dunn’s测试进行后续的两两比较。Dunn’s测试通过将总体α水平除以比较次数来进行校正,以控制多重比较错误率。

这种统计方法的目的是通过非参数检验和后续测试,明确不同LLM量化方法对模型性能的影响,从而选择最佳的量化方法,以保持模型的质量

4 bit量化

最常见的量化就是从 16 位浮点数 float 量化成 4 位的整数integer, 4 位量化是被认为在获得较好的生成质量.又把占用内存最小化的最佳量化位数

再小,像上面说的2 bit 量化会极大影响模型推理质量,再大,总还有些内存还可以再压缩

尤其对于 70B 以上的大参数模型来说, 参数越大的模型,4 bit 量化损失会越少; 反而是越小的模型,需要8 bit 量化

绝大数模型 8 位量化的效果表现都很不错,无论是哪种量化方式,而到了更低位数的 4 位就有一些挑战性

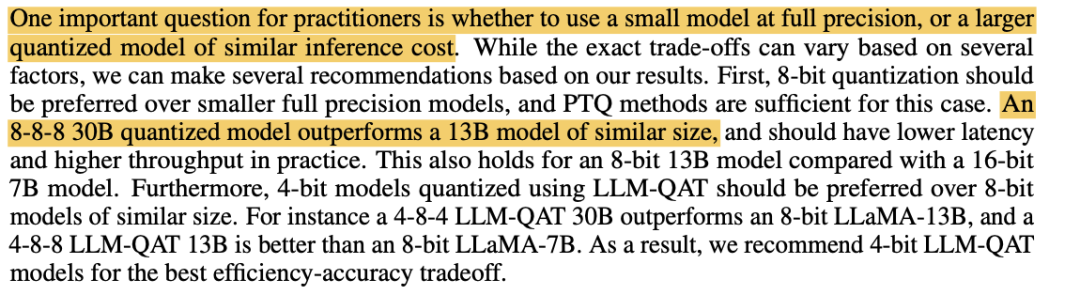

同样内存,选大模型的量化版还是小模型

还是根据LLM-QAT: Data-Free Quantization Aware Training for Large Language Models这篇论文, 根据他们的研究,发现同样内存占用,大模型的地位量化版本比小模型的高位量化版本的生成质量高

一个8-8-8 30B量化模型的表现优于类似大小的13B模型,并且在实际使用中应该具有更低的延迟和更高的吞吐量。这对于8位的13B模型与16位的7B模型也同样适用

量化工具

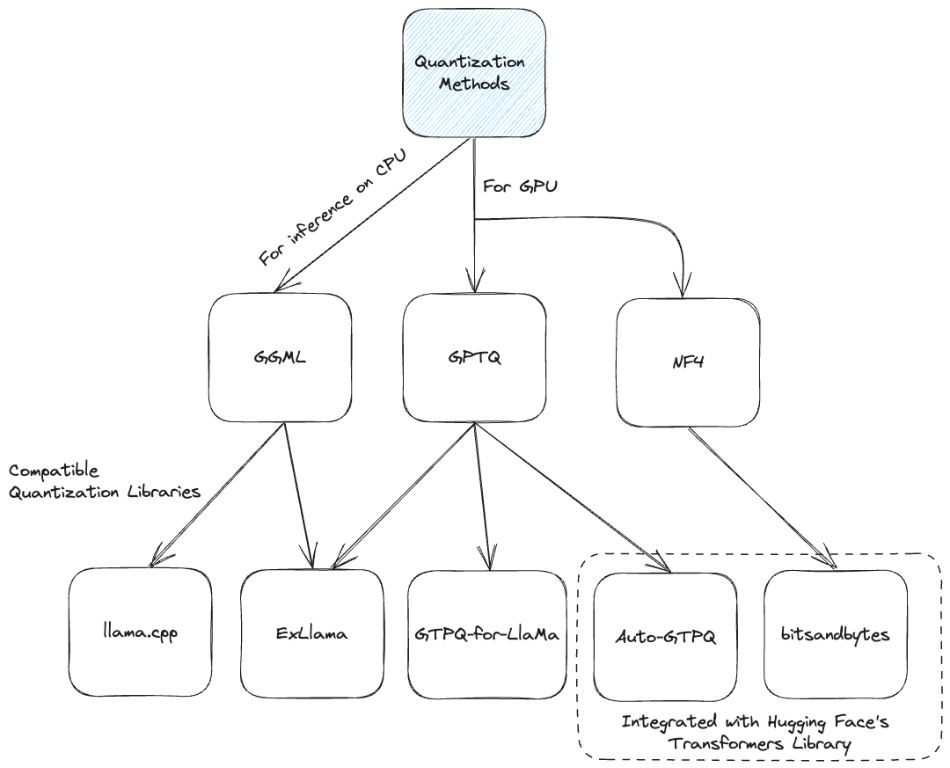

这张图解释了不同的量化方法,按照 GPU 和 CPU主要分为用于CPU推理的GGML和用于GPU的GPTQ和NF4

同时,图中还展示了与这些量化方法兼容的不同库

具体各个工具怎么量化就不再细化说明, 这篇主要对量化进行技术概念性介绍

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

观看零基础学习书籍和视频,看书籍和视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

436

436

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?