1 CART算法

CART 是在给定输入X条件下输出随机变量Y的条件概率分布的学习方法。CART二分每个特征(包括标签特征以及连续特征),经过最优二分特征及其最优二分特征值的选择、切分,二叉树生成,剪枝来实现CART算法。对于回归CART树选择误差平方和准则、对于分类CART树选择基尼系数准则进行特征选择,并递归调用构建二叉树过程生成CART树。

决策树的经典算法包括ID3、C4.5、CART算法,其应用领域及所使用的准则,如下图所示。

2 CART生成算法

- 最小二乘回归树生成算法

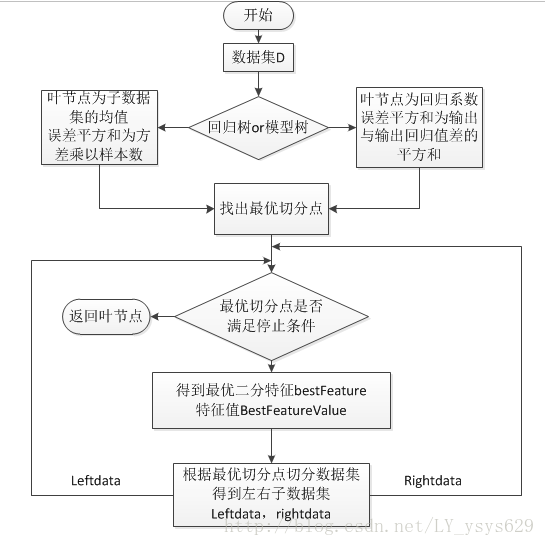

之所以称为最小二乘回归树,是因为,回归树以误差平方和为准则选择最优二分切点,该生成算法在训练数据集上所在的输入空间中,递归的将每个区域划分为两个子区域并决定每个子区域的输出值,在这里分为两种情况,一是输出值为子区域输出值的均值该种情况下为回归树,二是输出值为子区域输入与输出的线性回归,输出值为回归系数,该种情况下为模型树。

算法实现步骤:

1)选择最优切分特征J与切分点s,按照如下原则:

minj,s[minc1∑(yi−c1)+minc2∑(yi−c2)]

c1,c2 分别为左右子区域输出的均值(模型树时是输出变量的回归值),可通过遍历每个变量的每个可能取值来切分数据集找出最优切分点。

2)用切分点划分区域并决定相应的输出值

3)递归调用1)2)直到满足停止条件

4)利用字典,递归调用创建二叉树,生成决策树 - CART生成算法(分类树)

在这里需要提一下基尼系数:

在分类问题中,假设有 K 类,样本点属于第 k 类的概率为 pk ,则概率分布的基尼指数定义为:

Gini(p)=∑Kk=1pk(1−pk)=(p1+p2+...+pK)−∑Kk=1p2k=1−∑Kk=1p2k

对于分类问题:设 Ck 为 D 中属于第 k 类的样本子集,则基尼指数为:

Gini(D)=1−∑Kk=1(|Ck||D|)2

设条件 A 将样本 D 切分为 D1 和 D2 两个数据子集,则在条件 A 下的样本 D 的基尼指数为:

Gini(D,A)=|D1|DGini(D1)+|D2|DGini(D2)

注意:基尼指数也表示样本的不确定性,基尼指数值越大,样本集合的不确定性越大。

算法实现步骤:

1)计算现有样本 D 的基尼指数,之后利用样本中每一个特征 A ,及 A 的每一个可能取值 a ,根据 A>=a 与 A<a 将样本分为两部分,并计算 Gini(D,A) 值

2)找出对应基尼指数最小 Gini(D,A) 的最优切分特征及取值,并判断是否切分停止条件,否,则输出最优切分点

3)递归调用1)2)

4)生成CART决策树

- 最小二乘回归树的python实现流程图

592

592

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?