【医学影像 AI】深度工业图像异常检测调查

0. 论文简介

0.1 基本信息

2024年 3月,University of Surrey 金耀初教授、南方科技大学郑锋教授等在 Machine Intelligence Research 发表综述 “深度工业图像异常检测:综述(Deep Industrial Image Anomaly Detection: A Survey)”,该 github 仓库已经1.9kStarred。

本文从神经网络架构、监督级别、损失函数、评价指标和数据集的角度全面审视了基于深度学习的图像异常检测技术,回顾了该技术在工业制造中可适用的场景及可用的 IAD 方法,指出了图像异常检测技术当前面临的若干挑战。

论文下载: springer, mi-research

引用格式:

Jiaqi Liu, Guoyang Xie, Jinbao Wang, Shangnian Li, Chengjie Wang, Feng Zheng, Yaochu Jin. Deep Industrial Image Anomaly Detection: A Survey[J]. Machine Intelligence Research, 2024, 21(1): 104-135. DOI: 10.1007/s11633-023-1459-z

Github 仓库: Github-M-3LAB

0.2 摘要

深度学习的快速发展为工业图像异常检测(IAD)领域树立了一个重要的里程碑。本文从神经网络架构、监督水平、损失函数、评价指标和数据集等多个角度,对基于深度学习的图像异常检测技术进行了全面综述。此外,我们从工业制造中提取了具有前景的应用场景,并在该场景下回顾了当前的IAD方法。同时,我们强调了图像异常检测领域面临的若干开放性挑战,并探讨了不同监督条件下代表性网络架构的优势与局限性。最后,本文总结了研究成果,并指出了未来的研究方向。更多资源可在 https://github.com/M-3LAB/awesome-industrial-anomaly-detection 获取。

关键词:图像异常检测,缺陷检测,工业制造,深度学习,计算机视觉。

1. 引言

本文综述了基于深度学习的图像异常检测的最新进展,因为深度学习的快速发展使得图像异常检测能力得以在工厂中实现。在现代制造业中,图像异常检测(IAD)通常是在制造过程的最后阶段进行,旨在识别产品缺陷。缺陷的严重程度会显著影响产品的价格。此外,如果缺陷达到某个阈值,产品将被丢弃。

历史上,大多数异常检测任务是由人类完成的,但这种方式存在许多缺陷:

- 无法避免人类疲劳,导致误判现象(即真实情况为异常,而人类的判断为正常)。

- 长时间高强度的异常检测工作可能导致健康问题,例如视力损害。

- 定位异常需要大量员工,从而增加了运营成本。

因此,IAD算法的目标是减少人力劳动,提高生产效率和产品质量。在深度学习之前,IAD的性能无法满足工业制造的需求。如今,深度学习方法已取得了良好的效果,并且大多数方法的准确率超过97%。然而,IAD在实际应用中仍存在许多问题。为了全面探讨当前方法的有效性和适用场景,我们在此综述中对IAD进行更细致的分析是非常必要且有意义的。

表1 清楚地展示了本综述在数据集、评价指标、神经网络架构、监督水平以及工业制造应用场景方面的优势。作为一篇侧重于传统方法的代表性综述,Czimmermann等人[1]对深度学习方法的讨论较少,而本综述则对深度学习进行了更深入的探讨。首先,本研究使用的IAD数据集数量是Tao等人[2]的两倍。其次,我们使用最全面的图像级和像素级指标分析了IAD的性能。然而,Cui等人[3]和Tao等人[2]仅采用了图像级指标,忽略了IAD的异常定位性能。第三,本研究根据不同监督水平的神经网络架构设计提出了一种分类方法。最后,为了弥合学术研究与实际工业需求之间的差距,我们在工业制造场景下回顾了当前的IAD算法。

作为一个新兴领域,工业异常检测(IAD)的研究必须充分考虑工业制造的需求。以下是需要研究的具有挑战性问题的总结:

-

IAD数据集应从实际生产线而非实验室中收集。由于隐私问题,公众无法访问真实世界的异常数据集。大多数开源的IAD数据集是从无异常产品中生成异常的。换句话说,开源IAD数据集中的异常可能不会在实际生产线中发生,这使得在工业制造中部署IAD非常具有挑战性。

-

在缺乏多领域IAD数据集的情况下,创建统一的IAD模型具有挑战性。最近,You等人[4]提出了一种适用于多类对象的统一IAD模型。然而,他们忽略了同一工厂生产的商品应为同一类型的观点。例如,汽车制造商生产多种类型的工件,但不生产水果。当前流行的IAD数据集,如MVTec AD[5]和MVTec LOCO[6],包含多个类别但不涉及多个领域。为了模拟真实的制造过程,我们必须创建一个从多个领域收集的新IAD数据集。

-

迫切需要为IAD性能的图像级和像素级评估建立统一标准。大多数IAD指标将异常掩码(ground truth)缩小到特征图的大小进行评估,这不可避免地降低了评估的精度。此外,我们发现某些IAD方法在图像AUROC上表现良好,但在像素AP上表现较差,反之亦然。因此,开发一个统一的指标来评估图像和像素级别的IAD性能至关重要。

-

应设计一种更高效的损失函数,能够同时利用标注数据的指导和未标注数据的探索。在实际制造场景中,可用的异常样本数量有限。然而,大多数无监督IAD方法优于半监督IAD方法。通过观察半监督IAD的失败,我们呼吁更多关注特征提取和损失函数的设计,以有效利用标注数据的指导和未标注数据的探索。针对上述关键问题,改进异常样本的特征提取并重新设计偏差损失函数,可以充分利用标注的异常样本,并将异常样本的特征空间与正常样本的特征空间区分开来。

本文对各种方法进行了分类,并清晰分析了各种范式的优缺点。它使读者能够快速了解最新技术,并为实际应用中选择所需算法提供了可靠的指导。更重要的是,我们分析了不同范式的缺点和当前的主要挑战。后续研究人员可以快速找到推动该领域发展的方向。

1.1 贡献

本综述的主要贡献可总结如下:

- 我们通过考虑不同监督水平的神经网络架构设计,提供了对图像异常检测的深度回顾。

- 在不同设置下对当前IAD算法进行了全面回顾,以弥合学术研究与实际工业制造之间的差距。

- 总结了IAD领域的主要问题和潜在挑战,并为未来的研究方向提供了基础。

本文的其余部分组织如图1所示。在第2和第3部分中,我们根据不同监督水平的神经网络架构对IAD进行了回顾。接着,在第4部分中,我们在工业制造场景下提出的设置中回顾了IAD的最新进展。第5部分介绍了流行的数据集,并对评价指标进行了回顾。之后,我们在第6部分中分析了当前IAD方法在各种数据集上的性能。最后,第7部分为IAD的未来研究方向提供了建议。

2. 无监督异常检测

当前大多数研究集中在无监督异常检测上,其假设是收集异常样本会耗费大量的人力和财力成本。这意味着训练集中只包含正常样本,而测试集中同时包含异常样本和正常样本。工业图像中的异常检测是分布外(OOD)问题的一个子集。在深度学习兴起之前,差分检测和滤波方法经常被用于检测工业图像中的异常。随着MVTec AD[5]数据集的发布,工业图像中的异常检测方法可以分为两类:基于特征嵌入的方法和基于重构的方法。目前,更多的异常检测技术基于特征嵌入。

2.1 基于特征嵌入的方法

2.1.1 教师-学生架构(Teacher-student architecture)

这些方法的性能非常出色,但它们依赖于预训练模型,如ResNet[7]、VGG[8]和EfficientNet[9]。选择理想的教师模型至关重要。表2总结了这种教学策略。网络结构和蒸馏方法是不同技术之间的主要区别。

说明:教师-学生网络架构是一种经典的无监督异常检测方法。教师模型通常是一个在大规模数据集上预训练的主干网络(如ResNet、VGG等),其参数在训练过程中固定不变。学生模型则通过学习教师模型的特征表示来检测异常。

表2

图2 所示的师生网络架构是检测工业图像异常的最标准技术。该方法通常选择在大型数据集上预训练的主干网络的部分层作为固定参数的教师模型。在训练过程中,教师模型向学生模型传授提取正常样本特征的知识。在推理过程中,教师网络和学生网络从测试集中提取的正常图像特征具有可比性,而从测试集中提取的异常图像特征则存在显著差异。通过比较两个网络生成的特征图,可以生成相同大小的异常得分图。随后,将异常得分图放大至与输入图像相同的比例,即可获得输入图像各个位置的异常得分。基于该模型的原理,可以判断测试图像是否存在异常。

图2

Bergmann等人[10]是第一个将教师-学生架构用于异常检测的研究团队。该模型简单且有效,显著优于其他基准方法。虽然STPM[12]和MKD[11]都使用了不同网络层下的多尺度特征进行蒸馏,但它们的方式不同。在这种情况下,学生网络提取的正常样本特征与教师网络提取的特征更相似,而异常样本特征则差异更大。此外,MKD发现,较轻的学生网络结构比与教师网络结构相同的学生网络表现更好。基于STPM,RSTPM[13, 17]增加了一对教师-学生网络。在推理过程中,新的教师网络被放置在原始教师-学生网络之后,负责重新生成特征。当输入异常图像时,学生网络通常会重建与教师网络特征可区分的正常特征。RSTPM还引入了一种机制,用于将教师网络的特征传递到学生网络,以促进特征重建。RD4AD[14]和RSTPM在学习过程中有某些相似之处。RSTPM使用两对教师-学生网络进行特征重建,而RD4AD仅使用一对教师-学生网络。RD4AD提出了多尺度特征融合(MFF)块和单类瓶颈(OCB)来形成嵌入,用于消除多尺度冗余特征,从而使单对教师-学生网络能够有效地执行特征重建。在推理过程中,RD4AD的教师-学生网络提取的异常图像特征差异显著。AST[16]指出,具有相同结构的教师-学生模型提取的异常图像特征非常相似,因此他们提出了一种非对称教师-学生架构来解决这一问题。AST还引入了归一化流(normalized flow)来避免这一问题,并防止由于两个网络结构不一致导致的估计偏差。以往的教师-学生架构异常检测方法由于神经网络容量与知识量之间的不一致性而容易出现过拟合。通过引入上下文相似性损失(CSL)和自适应难样本挖掘(AHSM)模块,信息蒸馏(IKD)[15]希望减少过拟合。CSL可以帮助学生网络理解包含上下文的数据流形结构,而AHSM可以专注于包含大量信息的难样本。

2.1.2 单类别分类(One-Class Classification)

单类分类技术更依赖于异常样本。如果生成的异常样本质量较差,方法的性能将受到严重影响。如表3所示,除了MemSeg[18]之外,其他方法的训练依赖于支持向量数据描述(SVDD)和交叉熵损失。因此,绝大多数方法的性能略显不足。

说明:单类分类(OCC)是一种异常检测方法,其目标是通过学习正常样本的特征分布来检测异常。由于训练集中通常不包含异常样本,OCC方法需要找到一个能够区分正常样本和异常样本的边界(如超球面)。

异常检测也可以被视为单类分类(OCC)问题,这激发了一些研究。如图3所示,该方法在训练过程中找到一个超球面,以区分正常样本特征和异常样本特征。在推理过程中,该方法根据测试样本特征与超球面的相对位置来判断样本是否异常。由于训练集中不包含异常样本,一些方法通过人工生成异常样本来提高超球面的准确性。

SVDD[34]是OCC问题中的经典算法,PatchSVDD[19]、DSPSVDD[20]和SE-SVDD[21]对其进行了改进,以适用于工业图像异常检测。PatchSVDD[19]将图像划分为均匀的块并送入模型进行训练,显著增强了模型检测异常的能力。DSPSVDD[20]为深度SVDD模型设计了一个改进的综合优化目标,同时考虑超球面体积最小化和网络重建误差最小化,以更有效地提取深层数据特征。SE-SVDD提出了语义相关模块(SCB),通过提取多级特征来改善异常语义的表示和异常定位的准确性。

MOCCA[22]使用多层特征进行异常检测。与SE-SVDD不同,MOCCA使用自编码器提取特征,并在每一层定位正常特征的边界位置。Sauter等人[23]尝试使用Xception网络进行分类,并获得了与SVDD相当的结果。FCDD[35]采用全卷积神经网络进行单类分类。由于卷积过程中每层图像特征的相对位置不变,FCDD比其他方法产生更具可解释性的结果。

PANDA[25]研究了预训练特征的迁移方法,并将早停机制引入OCC问题。此外,Reiss和Hoshen[36]研究了PANDA中的灾难性遗忘问题。他们提出了一种新的损失函数,能够克服中心损失和对比损失方法的失败模式,并用置信度不变的角度中心损失替代欧几里得距离进行预测。

DisAug CLR[27]提出了一个两阶段异常检测框架,其中第一阶段通过一种新颖的分布增强对比学习来阻碍对比表示的一致性。经过对比学习后,异常样本和正常样本的表示更容易区分。而第二阶段则使用第一阶段学习到的表示构建单类分类器。Yao等人[32]提出了一种新颖的动态局部增强方法,从正常训练数据集中生成负样本对,这对异常检测非常有效。de Haan等人[33]利用对比预测编码(CPC)[37]模型进行异常检测和分割,使用逐块对比损失作为异常分数来定位异常。

此外,受显著性目标检测[38–40]的启发,许多方法将显著性检测应用于异常检测。Bai等人[28]提出使用傅里叶变换检测图像的显著区域,并将显著区域与模板进行比较以检测异常。Niu等人[29]使用显著性目标检测方法获取目标轮廓,从而辅助异常检测。Qiu等人[30]提出了一种多尺度显著性检测(MSSD)方法,通过分离前景和背景来获取粗略的异常区域,并在此基础上细化检测结果。此外,GradCAM[41]作为一种获取显著性图的常用方法,也被用于各种异常检测算法中。CutPaste[31]和CAVGA[42]都将异常检测视为分类问题,而GradCAM用于像素级异常定位。

CutPaste[31]是数据增强单类分类方法的代表性示例。它通过剪切和粘贴正常图像的部分区域生成异常图像,使网络能够区分异常图像。此外,基于分割的方法也非常有用。这种方法更注重像素级异常定位。当流已知时,Iquebal和Bukkapatnam[43]证明图像标签的最大后验估计可以表述为连续最大流问题。然后,通过在图像域上使用一种新颖的马尔可夫随机场迭代获取流,完成异常分割。该技术在金属增材制造异常检测数据集[44]上展示了其适应性。MemSeg[18]将正常图像的特征存储在记忆库中,以提高分割网络区分异常区域的能力。为了防止背景因素的影响,MemSeg仅在前景中引入外部数据集的异常,这也是其表现出色的另一个原因。

表3

图3

2.1.3 分布图(Distribution Map)

基于分布图的方法需要一个合适的映射目标进行训练,而映射方法的选择会影响模型性能。如表4所示,基于归一化流(Normalizing Flows, NF)的方法占主导地位。作为一种生成模型,NF具有很强的映射能力,并且在异常检测任务中也表现出良好的性能。

基于分布图的方法与基于单类分类(OCC)的方法非常相似,不同之处在于,基于OCC的方法专注于寻找特征边界,而基于映射的方法则试图将特征映射到期望的分布中。这类方法的常见框架如图4所示。这种期望分布通常是多元高斯(MVG)分布。该方法首先使用一个强大的预训练网络提取正常图像的特征,然后通过映射模块将提取的特征映射到高斯分布中。在评估过程中,异常图像的特征会偏离这种分布。基于偏离程度,可以计算出异常概率。

表4

图4

Tailanian等人[45]提出了一种基于对比的框架,该框架将统计分析应用于由Patch PCA和ResNet生成的特征图,以检测图像中的异常。该方法在皮革样本上表现良好。Rippel等人[46]通过将预训练网络的特征表示拟合为多元高斯分布,建立了一个正常性模型。然而,灾难性遗忘问题仍未解决。基于生成模型和判别模型之间的关系,Rippel等人[47]为正常类别生成了多元高斯分布,并在深度SVDD和FCDD上证明了这一概念的有效性,从而缓解了先前研究中观察到的灾难性遗忘问题。PEDENet[48]框架由补丁嵌入(PE)网络、密度估计(DE)网络和位置预测(LP)网络组成。首先,PE模块用于减小预训练网络提取的特征的尺寸。然后,利用受高斯混合模型启发的DE模块和LP模块,模型可以预测补丁嵌入的相对位置,并根据推理过程中预测结果与实际结果之间的差异判断图像是否异常。预训练特征映射(PFM)[49]提出了双向和多层次双向预训练特征映射,以增强普通特征映射的性能。此外,Wan等人[50]在PFM框架中加入了位置编码,并提出了一种新颖的位置编码增强特征映射(PEFM)[50],以进一步增强PFM。FYD[51]首次将配准技术引入工业图像异常检测。FYD提出了一种从粗到细的对齐方法,首先在图像级别对齐对象的前景。接下来,在细化对齐阶段,使用非对比学习来增加批次中所有对应位置特征之间的相似性。

归一化流(NF)[59]是一种通过一系列可逆映射变换概率密度来构建复杂分布的技术。NF方法从预训练模型(如ResNet[7]或Swin Transformer[60])中提取正常图像的特征,并在训练阶段将特征分布转换为高斯分布。在测试阶段,经过NF处理后,异常图像的特征将偏离训练阶段的高斯分布,这是分类异常的最重要原则。DifferNet[52]是第一个使用NF解决工业图像异常检测问题的研究。通过在归一化流中引入跨卷积块来分配概率,CS-Flow[53]利用多尺度特征图内部和上下文之间的关系改进了DifferNet。CFlow-AD[54]在条件归一化流框架中加入了位置编码,以实现更优的结果。

此外,CFlow-AD[54]深入分析了为什么多元高斯假设在早期模型中是合理的先验条件,以及为什么更通用的NF框架旨在以更少的计算量收敛到类似的结果。FastFlow[57]在NF模块中引入了大小卷积核的交替堆叠,以高效地建模全局和局部分布。CAINNFlow[55]通过将注意力机制CBAM[61]引入NF模块来提升模型性能。在FastFlow和CFlow-AD等技术中,特征分布中心不为0,且其性能不稳定。Kim等人[62]提出了一种简单的解决方案AltUB[58],通过交替训练更新归一化流的基础分布以进行异常检测,从而解决了这一问题。AltUB验证了使用AltUB的CFlow-AD和FastFlow的效果。

2.1.4 记忆库(Memory Bank)

如表5所示,基于记忆库的方法通常不需要损失函数进行训练,并且模型的构建速度较快。其性能由强大的预训练网络和额外的存储空间保证,这类方法目前在工业图像异常检测任务中表现最为出色。

表5

图5

基于记忆库的方法与基于单类分类(OCC)方法的主要区别在于,前者需要额外的存储空间来存储图像特征。如图5所示,这些方法仅需要最少的网络训练,并在推理过程中仅需对采集的正常图像特征进行采样或映射。在推理过程中,将测试图像的特征与记忆库中的特征进行比较。测试图像的异常概率等于其与记忆库中正常特征的空间距离。

K近邻算法(KNN)[72]是一种广泛用于无监督异常检测的算法,但它仅能在样本级别进行操作。语义金字塔异常检测(SPADE)[63]受KNN启发,利用基于多分辨率特征金字塔的对应关系,获得像素级异常分割结果。PaDim[73]采用多元高斯分布构建正常类别的概率表示,因此记忆库的大小仅由图像分辨率决定,而与训练集的大小无关。PaDim需要对多维协方差张量进行批量逆运算,这使得在特征规模增加时难以扩展至更大型的卷积神经网络(CNN)。为了将逆运算的计算成本降低至三分之一,Kim等人[62]将随机特征选择推广到半正交嵌入中。

同时,自组织映射异常检测(SOMAD)[64]和GCPF[65]增强了正常特征的存储能力。SOMAD通过基于多尺度特征的拓扑记忆来保留正常特征,而GCPF则将标准特征转化为多个独立的多元高斯聚类。

PatchCore[68]是工业图像异常检测领域的重要进展,显著提升了MVTec AD数据集的性能。PatchCore有两个独特之处:首先,其记忆库通过核心集子采样确保了较低的推理成本,同时最大化性能;其次,PatchCore根据测试样本与其记忆库中最近邻特征之间的距离来确定测试样本是否异常。这一重加权过程使PatchCore更具鲁棒性。自PatchCore提出以来,基于其改进的方法层出不穷。

Lee等人[69]提出了基于耦合超球体的特征适配(CFA),以获得目标导向的特征。记忆库中超球体的中心和表面通过迁移学习获得,测试特征与耦合超球体之间的位置关系可用于判断其是否异常。FAPM[70]由位于不同位置的许多补丁式和分层式存储体组成。FAPM在推理过程中独立计算不同存储体中的特征,显著加快了推理速度。Npad[74]通过使用相邻像素和目标像素特征估计每像素的标称分布,允许出现边缘错位的可能性。此外,使用目标像素之间的马氏距离和欧几里德距离以及估计的分布来推断异常分数。类似地,Bae等人[ 71 ]将位置信息作为条件概率对累积直方图进行建模,利用邻域信息建立正态特征分布。此外,本文在异常检测和定位问题中引入了第一种改进方法,使用合成的异常图像来改进基于输入图像的异常图,以及使用邻域和位置信息来估计分布。

通过在学习过程中嵌入位置信息,并在推理阶段将提取的特征与正常嵌入进行比较,Tsai等人[66]提出了一种增强网络数据表示能力的方法。该方法同样基于自监督学习的理念。Zou等人[67]利用对比学习训练骨干网络,并提出了一种名为SPD的新数据增强方法,以推动网络区分具有细微差异的两种图像。此外,他们通过使用PatchCore[68]展示了骨干网络的表示能力。

2.2 基于重建的方法

基于重建的方法主要通过自训练编码器和解码器来重建图像以进行异常检测,这使得它们对预训练模型的依赖减少,并提高了检测异常的能力。然而,由于无法提取高层次语义特征,其图像分类能力较差。

如表6所示,各种方法的损失函数具有可比性。然而,由于重建模型范式不同以及异常样本构建方法的差异,其性能存在显著差异。图6展示了基于重建技术的结构。在训练过程中,正常或异常图像被送入重建网络,并通过重建损失函数指导重建网络的训练。最终,重建网络能够以类似于原始正常图像的方式还原重建图像。在推理阶段,比较模型通过对比原始图像与重建图像生成预测结果。与特征嵌入方法的多样性不同,大多数基于重建的方法仅在于重建网络的构建方式上存在差异。基于重建的方法在像素级别上优于特征嵌入方法,因为它们能够通过像素级比较来识别异常。此外,大多数基于重建的方法从头开始训练,未使用强大的预训练模型,因此其在图像级特征嵌入方面性能较差。

2.2.1 自编码器 (Autoencoder)

自编码器(Autoencoder, AE)是异常检测(Anomaly Detection, AD)中最常用的重建网络。许多其他重建网络也由编码器和解码器组成。Bergmann等人[75]研究了结构相似性指数(SSIM)和损失函数对AE重建和异常分割的影响,为未来的研究提供了许多建议。

解决重建图像与原始图像之间的差异是最基本的原则。重建图像与原始图像之间通常存在风格差异,导致过度检测。Chung等人[76]提出了一种异常暴露风格蒸馏网络(OE-SDN),以保留风格转换并抑制AE的内容转换,从而避免过度检测。作为异常预测,Chung等人[76]用OE-SDN的重建图像与AE的重建图像之间的差异替换了原始图像与AE重建图像之间的差异。无监督两阶段异常检测(UTAD)[77]引入了IE-Net和Expert-Net,用于提取和利用无异常和高保真重建的特征,从而使框架具有可解释性。

基于重建的方法在利用不同尺度的特征时,几乎与特征嵌入方法一样有效。类似于师生架构,深度特征重建(DFR)[78]方法通过在特征层面进行重建来检测异常。DFR从预训练的网络中获取多个空间上下文感知表示,然后使用深度但高效的卷积AE重建特征,并通过比较原始特征与重建特征来检测异常区域。Yan等人[79]提出了一种新颖的多级图像重建(MLIR)框架,将重建过程视为不同分辨率下的图像去噪任务。因此,MLIR能够检测全局结构异常和细节异常。

修改AE的结构也可以提高其重建能力。Zhou等人[80]引入了P-Net来比较原始图像与重建图像之间的结构差异。Collin和De Vleeschouwer[81]在编码器和解码器之间添加了跳跃连接,以提高重建的清晰度。此外,他们提出通过合成噪声模型对图像进行破坏,以防止网络收敛到恒等映射,并为此引入了创新的Stain噪声模型。Tao等人[82]也在特征层面进行操作。他们采用密集特征融合模块来获取双输入的密集特征表示,以帮助在双Siamese框架中进行重建。Hou等人[83]也使用跳跃连接来提高重建质量。除了达到预期效果外,他们还在跳跃连接中添加了记忆模块。Liu等人[84]从灰度边缘重建原始RGB图像,模型中的跳跃连接保留了图像的高频信息,以更好地指导重建。渐进式自编码器(PAE)[85]通过渐进式学习和改进的CutPaste增强技术提高了自编码器的重建性能。在训练过程中,PAE通过逐渐增加输入图像的分辨率来实现渐进式学习。

掩码和修复是自监督学习的有效方法。Li等人[86]开发了超像素掩码和修复(SMAI)技术。SMAI将图像划分为多个超像素块,并训练修复模块以重建掩码内的超像素。在推理过程中,SMAI对测试图像逐个超像素进行掩码和修复,然后将重建图像与测试图像进行比较以区分异常区域。迭代图像修复异常检测(I3AD)是Nakanishi等人[88]提出的一种方法,基于异常图重建部分区域。I3AD通过仅在图像上重建修复掩码来提高重建质量,并且仅掩码高概率异常的区域。SSM[90]在概念上与I3AD相似。SSM在重建网络中添加了跳跃连接,并将掩码区域预测为训练目标。RIAD[87]在训练集图像的补丁级别随机掩码一部分,并使用U-Net编码器-解码器网络[92]进行重建。在推理过程中,RIAD结合多个随机掩码和重建补丁生成重建图像,然后将其与原始图像进行比较。根据RIAD,多尺度梯度幅值相似性(MSGMS)作为异常评分优于SSIM。

DRAEM[91]是基于重建技术的代表。DRAEM通过引入外部数据集合成异常图像并将其重建为正常图像,极大地提高了重建网络的泛化能力。此外,DRAEM将原始图像和重建图像输入分割网络以预测异常区域,显著增强了模型分割异常区域的能力。然而,DRAEM在合成接近分布内异常时容易失败。受显著性检测的启发,Xing等人[93]提出了显著性增强模块(SAM),以生成比DRAEM更真实的异常图像,从而获得更好的结果。DSR[94]提出了一种基于量化特征空间表示和双解码器的架构,以规避图像级异常生成的需求。通过在特征层面对学习到的量化特征空间进行采样,以受控的方式生成接近分布内的异常。NSA[95]不使用外部数据进行数据增强,并采用更多的数据增强方法,使其优于所有之前未使用额外数据集学习的方法。与其他试图将异常图像重建为正常图像的方法不同,Bauer[89]提出重建图像的异常区域,使其偏离原始图像的外观。这种方法产生了与其他方法相当的结果。

与经典的基于重建的方法不同,Ristea等人[96]提出将基于重建的功能集成到自监督预测卷积注意力块(SSPCAB)中。SSPCAB可以集成到DRAEM和CutPaste等模型中,以增强这些模型。自监督掩码卷积变换块(SSMCTB)[97]将SSPCAB中的SE层[115]转换为通道级变换块,并取得了优异的结果。

变分自编码器(VAE)是AE的一种变体,其区别在于VAE的中间变量来自正态分布的数据。自然地,VAE具有更好的可解释性。Dehaene等人[98]使用梯度下降迭代指导重建,能量由重建损失定义,从而克服了VAE产生模糊重建的趋势,并保留了正常的高频结构。Liu等人[99]通过注意力解缠损失训练变分自编码器。在该VAE中,异常输入将在梯度反向传播和注意力生成过程中导致高斯偏离的潜在变量。这种偏离可用于定位异常。根据Matsubara等人[100]的研究,数据集通常是异质的而不是正则化的,非正则化的目标函数更适合在异质数据集上训练VAE模型。FAVAE[101]使用VAE对预训练模型提取的特征分布进行建模,隐式模拟更丰富的异常并增强模型的泛化能力。Wang等人[102]使用VQ-VAE创建离散的潜在空间,对偏离正态分布的离散潜在代码进行重新采样,并使用重新采样的潜在代码重建图像。VQ-VAE重建的图像更接近训练集中的正常图像。

2.2.2 生成性对抗网络(Generative adversarial networks)

基于生成对抗网络(GAN)的重建模型的稳定性不如AE,但判别网络在以下描述的一些场景中具有更好的效果。

在训练过程中,基于语义上下文的异常检测网络(SCADN)[103]屏蔽了图像的一部分,并使用GAN对其进行重建。随后,SCADN通过将输入图像与重建图像进行比较来检测异常以进行推断。除了掩蔽图像外,AnoSeg[104]还利用硬数据增强(hard augmentation)、对抗学习和通道拼接等方法来生成异常样本。AnoSeg然后训练GAN生成正常样本。AnoSeg与AE重建模型的不同之处在于,它的目标函数同时考虑了重建损失和对抗损失。

OCR-GAN[105] 利用频率解耦(Frequency Decoupling, FD)模块将图像分解为不同频率的信息组合,然后分别对这些不同频率的信息进行重建和融合,最终得到重建图像。在推理阶段,该模型能够识别正常图像与异常图像之间在频率分布上的显著差异。

2.2.3 Transformer

Transformer 因其更高的全局信息表示能力,有望超越自编码器(AE),成为异常检测中新的重建网络基础。Mishra 等人[106]提出了一种基于Transformer的框架,以在图像块级别进行图像重建,并采用高斯混合密度网络定位异常区域。You 等人[107]提出了ADTR,用于重建预训练特征。他们认为,Transformer的使用可以防止异常区域被良好重建,从而在重建失败时更容易识别异常。Lee 和 Kang[108]引入了一种基于视觉Transformer的编码器-解码器模型(AnoViT),并声称在异常检测问题上,AnoViT优于基于CNN的-CAE。HaloAE[109]将Transformer应用于HaloNet[116],通过重建特征促进图像重建,从而在MVTec AD数据集上取得了有竞争力的结果。重建型异常检测中常见的一种自监督学习方法是掩码图像的重建。然而,传统的卷积神经网络(CNN)难以提取全局上下文信息。为此,Pirnay 和 Chai[110]提出了修复Transformer(InTra),其能够整合输入图像更大区域的信息。InTra代表了从头开始训练的方法。掩码Swin Transformer Unet(MSTUnet)[111]与InTra类似,但在模拟异常时,MSTUnet采用了额外的增强技术[117],从而取得了更优异的性能。De Nardin 等人[112]通过使用相邻图像块重建掩码区域,也实现了强大的重建能力。

2.2.4 扩散模型 (Diffusion model)

扩散模型[118]是近年来流行的一种生成模型,同样可以用于基于重建的异常检测。据我们所知,AnoDDPM[113]是首个将扩散模型应用于工业图像异常检测的研究。与基于生成对抗网络(GAN)的方法相比,带有单纯噪声的AnoDDPM无需大规模数据集即可捕捉大范围异常区域。Teng 等人[114]在将扩散模型应用于异常检测时主要进行了两项改进:一是采用与时间相关的正常数据分布梯度值作为重建损失的替代度量,用于检测缺陷;二是提出了一种新颖的T尺度方法,以减少所需的迭代次数并加速推理过程。

3. 有监督异常检测

尽管异常数据具有多样性且难以收集,但在实际场景中仍然有可能获取异常样本。因此,部分研究专注于如何利用少量异常样本和大量正常样本训练异常检测模型。

Chu和Kitani[119]提出了一种在数据严重不平衡情况下检测异常的半监督框架。他们假设训练过程中损失值的变化可用于识别异常数据的特征。为此,他们训练了一种基于强化学习的神经批次采样器,以放大异常区域与非异常区域之间损失曲线的差异。FCDD[35]是一种无监督方法,通过合成异常样本来训练单类分类(OCC)模型。这一概念可推广至其他OCC方法。Venkataramanan等人[42]提出了一种带引导注意力的卷积对抗变分自编码器(CAVGA),可同等适用于有异常图像和无异常图像的案例。在无监督设置中,CAVGA通过注意力扩展损失引导其关注图像的所有正常区域。在弱监督设置中,CAVGA使用互补的引导注意力损失,在聚焦正常区域的同时最小化与图像异常区域对应的注意力图。Božič等人[120]在同一种深度学习框架下,研究了图像级监督信息、混合监督信息以及像素级监督信息对表面缺陷检测任务的影响。Božič等人[120]发现,少量像素级注释即可帮助模型达到与完全监督相当的性能。DevNet[121]通过少量异常样本实现了细粒度的端到端可微分学习。Wan等人[122]提出了一种用于不平衡数据分布训练的对数诱导损失(LIS)以及用于表征异常特征的异常捕获模块(ACM),以有效利用少量异常信息。DRA[123]提出了一种框架,通过学习可见异常、伪异常和潜在残差异常的解耦表示,以同时检测可见和不可见异常。

此外,许多研究未能考虑正常样本和异常样本分布不均衡的问题,主要依赖异常样本进行有监督训练。Sindagi和Srivastava[124]研究了不同设置下数据集的领域迁移问题,用于异常检测。Qiu等人[125]提出了一种基于双重加权主成分分析(DWPCA)的算法,用于图像配准和表面缺陷检测。Bhattacharya等人[126]提出了一种交错的深度伪影感知注意力机制(iDAAM),用于对异常图像中的多目标和多类别缺陷进行分类。Zeng等人[127]将异常检测视为目标检测的一个子集,设计了一种基于参考的缺陷检测网络(RDDN),利用模板参考和上下文参考检测异常。Song等人[128]将异常部分视为图像的显著区域,并提出了一种有效的显著性传播算法用于异常检测。Long等人[129]研究了触觉图像中的缺陷检测,这对RGB图像中的织物结构缺陷检测具有明显优势。此外,还有一些方法借鉴了语义分割的概念。为了检测红外热体数据中的缺陷,Hu等人[130]提出了一种混合多维空间和时间分割模型。Ferguson等人[131]使用了基于掩码区域的CNN架构,同时检测和分割X射线图像中的缺陷。还有许多基于全监督自然图像目标检测和语义分割模型的改进方法用于异常检测[132–134]。此外,还有许多适用于异常检测的弱监督目标检测方法[135–138],这里不逐一讨论。

4. 工业制造场景

本节介绍更适合工业场景的分类标准或应用设置,即少样本异常检测、噪声异常检测、异常合成和三维异常检测。

4.1 少样本异常检测

少样本学习对数据收集和标注具有重要现实意义。一方面,通过研究少样本学习,可以降低工业产品数据收集和标注的成本;另一方面,可以从数据角度出发,研究何种数据对工业图像异常检测最有价值。少样本异常检测(FSAD)[139, 140]仍处于起步阶段。目前存在两种设置:第一种是基于元学习[141],即需要大量图像作为元训练数据集。Wu等人[139]提出了一种称为MetaFormer的新型架构,利用元学习参数实现高模型适应能力,并通过实例感知注意力定位异常区域。RegAD[141]训练了一种类别无关的异常检测模型,在测试阶段通过比较测试图像与其对应正常图像的注册特征来识别异常。第二种设置基于经典的少样本图像学习。PatchCore[68]、SPADE[63]和PaDim[73]在16个正常训练样本上进行了消融实验,但均未专门针对少样本异常检测任务。因此,开发专注于少样本异常检测任务的新算法十分必要。

最近,研究者们将零样本异常检测(ZSAD)扩展到了FSAD之外。ZSAD的目标是利用大模型的泛化能力解决无需训练的异常检测问题,从而完全消除数据收集和标注的成本。MAEDAY[142]使用预训练的掩码自编码器(MAE)[143]解决该问题。MAEDAY随机遮蔽图像部分区域并利用MAE进行重建,若重建区域与遮蔽前区域存在差异,则认为该区域异常。WinCLIP[144]利用另一种大模型CLIP[145]实现ZSAD。WinCLIP使用CLIP的图像编码器提取图像特征,基于“受损物体的照片”等文本描述,利用CLIP的文本编码器提取这些描述的特征,并计算文本特征与图像特征的相似性。若相似性高,则图像为“受损物体的照片”,否则图像正常。MAEDAY和WinCLIP表明,零样本异常检测是一个有前景的研究方向。

4.2 噪声异常检测

噪声学习是异常检测中的经典问题。通过研究噪声学习下的异常检测,可以避免标注错误导致的性能损失,并减少异常检测中的误检。Tan等人[146]采用一种新型信任区域记忆更新方案,将噪声特征点远离记忆库。Yoon等人[147]使用数据精炼方法提高单类分类模型的鲁棒性。Qiu等人[148]提出了一种在未标注异常数据存在下训练异常检测器的策略,该策略与多种模型兼容。他们通过合成异常数据,并结合正常数据与合成异常数据联合优化损失函数。Chen等人[149]引入了一种插值高斯描述符,通过对抗性插值训练样本学习单类高斯异常分类器。然而,上述方法大多未在真实工业图像数据集上验证,其有效性可能不适合工业制造场景。

4.3 3D异常检测

3D异常检测能够利用更多的空间信息,从而检测到RGB图像中无法包含的一些信息。在一些特殊的光照环境下或对于那些对颜色信息不敏感的异常,3D异常检测可以展现出其显著优势。这一研究方向目前在学术界受到了广泛关注。

自MVTec 3D-AD[6]数据集发布以来,多篇论文专注于3D工业图像中的异常检测。Bergmann和Sattlegger[150]引入了一种用于3D异常检测的师生模型,其中教师网络通过重建局部感受野来获得通用的局部几何描述符,而学生网络则被训练以匹配预训练教师网络的局部3D描述符。Horwitz和Hoshen[151]提出了BTF方法,该方法将手工制作的3D表示(FPFH[152])与2D特征表示方法(PatchCore[68])相结合。Reiss等人[153]指出,在3D异常检测中,自监督学习的表示能力暂时仍不及手工特征,但如果可获得大规模3D异常检测数据集,自监督表征仍具有巨大潜力。AST[16]利用带有深度信息的RGB图像来提升异常检测性能。

然而,大多数3D IAD方法专注于RGB-D图像,而现实工业制造中的3D数据集由点云构成,这意味着当前的3D IAD方法无法直接应用于工业制造。因此,3D IAD仍有很大的发展空间。

4.4 异常合成

通过人工合成异常样本,我们可以在数据有限的情况下提升模型性能。这一研究方向与少样本学习相辅相成。少样本学习研究在数据固定的情况下如何改进模型,而异常合成研究则在模型固定的情况下如何通过人工增加可信数据来提升模型性能。两者均能有效降低数据收集与标注的成本。

许多无监督异常检测方法通过数据增强技术合成异常图像,并显著提升了模型性能。例如,CutPaste[31]、DRAEM[91]、MemSeg[18]等都是代表性方法。

此外,一些有监督方法利用有限的异常样本合成更多异常样本用于训练。Liu 等人[154]提出了一种模型,旨在无缺陷织物图像上生成缺陷用于语义分割训练。而 Rippel 等人[155]则使用以ResNet/U-Net 为生成器的 CycleGAN[156]作为基础架构,将缺陷从一种织物转移到另一种织物上。通过改进风格迁移网络, SDGAN[157]取得了优于 CycleGAN 的效果。Wei 等人[158]提出了一种名为DST的模型来模拟缺陷样本。首先,DST在无缺陷图像上生成一个空白掩码区域,然后使用掩码直方图匹配模块使空白掩码区域的颜色与图像整体颜色一致,最后使用 U-NET进行风格迁移以使生成的图像更加逼真。Wei 等人[159]提出了一种名为 DSS的模型,该模型使用常规GAN在无缺陷样本的指定区域重建缺陷结构,然后使用DST进行风格迁移以将模拟缺陷融入背景中。Jain 等人[160]尝试使用DCGAN、ACGCN和 InfoGAN 通过添加噪声来生成缺陷图像,从而提高了分类精度。 Wang 等人[161]提出了基于 StarGANv2 的DTGAN,该模型增加了前背景解耦,实现了一定程度的风格控制,并使用弗雷谢初始距离(FID[162])和核初始距离(KID[163])来评估图像生成质量。DefectGAN[164]也认为缺陷与正常背景可以分层,且缺陷为前景。 DefectGAN以风格迁移的形式生成缺陷前景及其空间分布。尽管该领域已有相当数量的研究,但与其他已经形成明确研究方向的领域相比,仍然具有巨大的发展潜力。

5. 数据集与评价指标

5.1 数据集

数据是机器学习,尤其是深度学习的重要驱动力。然而,获取工业图像的难度限制了工业视觉中图像异常检测的发展。

表7显示,工业异常检测数据集的数量和规模正在逐步增加,但大多数数据集并非来自真实生产线。一个有前景的替代方法是充分利用工业模拟器生成异常图像,这可能会缩小学术研究与工业制造需求之间的差距。

5.2 评价指标

表8全面回顾了工业图像异常检测领域的评价指标。第一列是指标名称,第二列是评价方向。换言之,如果评价方向为“越大越好”,则指标值越大,性能越好;如果评价方向为“越小越好”,则指标值越低,性能越好。第三列详细说明了每个指标,特别是其如何准确反映图像异常检测的性能。

从表8中可以看出,大多数新指标都是自然图像分割和检测指标的变体,如F1分数、AU-ROC或AU-PR。然而,这些指标可能无法准确对应工业异常检测(IAD)的性能,因为异常区域的微小尺寸需要比无异常区域更大的权重。因此,这些指标在IAD中的有效性仍有待进一步探索。

6. 总体性能分析

表9和表10展示了当前IAD方法在MVTec AD数据集上的统计结果。

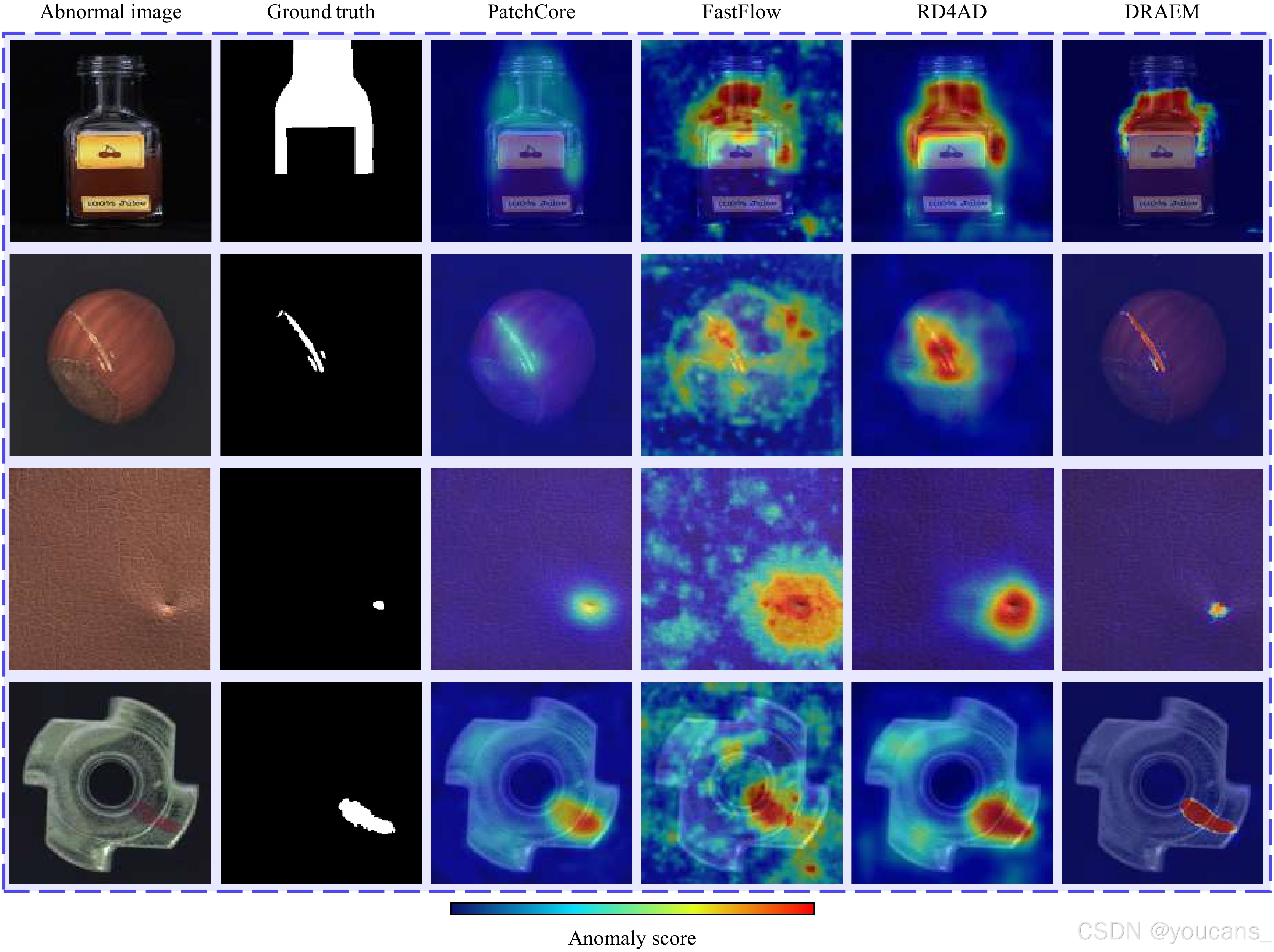

图7支持了表9的结论:即使不同方法在图像分类任务中表现相似,它们在像素级分割任务上的差异仍然显著。我们对当前IAD方法的性能进行了深入分析,并得出以下有价值的见解:

- 在图像级异常检测任务中,基于内存库的方法是最有效的神经网络设计。然而,它们在检测像素级异常方面表现不足。

- 集成学习可以显著提升现有最先进异常检测方法的性能。

- SSPCAB[96]可以无缝集成到前沿方法中,并显著增强基于重建方法的性能。

- 少样本IAD与传统IAD之间的差距正在缩小。换句话说,我们可以利用数据蒸馏算法来减少异常检测所需的数据集规模。

- 在不使用集成学习的情况下,MemSeg[18]在图像级异常分类任务中取得了最先进的结果,这主要归功于U-Net[92]框架的使用。DRAEM[91]也使用U-Net在像素级异常分割任务中优于其他方法。MemSeg和DRAEM的有效性证明了分割模块在异常检测中的优越性。人工监督通常不如真实监督有效,使用人工监督训练的分割模型往往表现较差。然而,即使使用人工生成的异常作为监督信息,这些带有分割模块的方法在分类和分割任务中仍优于不包含分割模块的方法。我们可以得出结论,分割模块对异常检测任务是有益的。

- 在分割任务中,AU-PR比AU-ROC更有价值[67]。如表10所示,基于重建的方法在像素级AU-PR指标上优于其他方法。至于图7,DRAEM的检测结果最接近真实值,边缘更清晰,误检区域更少。我们从统计数据和可视化结果中可以推断,基于重建的方法更适合分割任务。

图7。代表性方法结果的可视化。请注意,可视化结果来自开源代码的复制。

7. 未来的方向

我们概况了几个引人注目的未来研究方向如下:

-

构建多模态工业异常检测(IAD)数据集。在实际的生产线上,仅凭RGB图像不足以检测异常。因此,我们可以利用额外的模态信息,如X射线和超声波,以增强异常检测的性能。

-

提升推理速度。鉴于测试样本在生产线上是连续流动的,大多数IAD方法无法在新测试样本到达时立即做出预测。在工业制造中,除了准确性外,IAD的推理速度也需要得到重视。采用多目标进化神经架构搜索算法来找到最优的权衡架构是一种有前景的方法。

-

构建工业图像预训练模型。大多数IAD方法使用ImageNet预训练模型从工业图像中提取特征,这不可避免地导致特征漂移问题。因此,迫切需要为工业图像构建专门的预训练模型。

-

推动有监督异常检测方法的发展。大多数异常检测方法侧重于无监督设置。虽然这种设置可以降低数据标注的成本,但它极大地限制了基于分割的方法的发展。无监督方法和有监督方法应相辅相成,而有监督方法近年来发展缓慢的主要原因是缺乏大量标注数据集。因此,未来有必要提出一个具有像素级标注的全监督异常检测数据集。

-

异常样本合成的进一步研究。以往我们主要关注正常图像的数据增强方法,但在通过数据增强合成异常样本方面投入的精力较少。在工业制造中,由于大多数生产线无故障,收集大量异常样本非常困难。因此,未来应更多地关注异常样本合成方法,如CutPaste[31]、DRAEM[91]和MemSeg[18]。

-

设计轻量高效的异常检测模型。当前的异常检测算法通常关注检测精度,而忽略了模型的存储大小和效率。这导致计算成本高,限制了异常检测在企业生产端的应用。因此,有必要设计轻量但高效的异常检测模型。

-

统一工业与医学图像异常检测任务。目前,图像异常检测算法主要分为两类任务:工业图像异常检测和医学图像异常检测。尽管医学图像比工业图像具有更多的模态[185–189],但这两类任务在数据和实验设置方面有许多相似之处。然而,很少有研究探索如何统一这两类任务。原因之一是医学和工业图像数据集之间的领域差异,另一个原因是缺乏良好的基线和基准进行比较。在数据或方法层面建立一个统一的框架来同时处理工业和医学图像异常检测将非常有意义。

8. 结论

本文对工业制造中的图像异常检测进行了文献综述,重点讨论了监督水平、神经网络架构设计、数据集的类型和属性以及评价指标。特别是,我们从工业制造的角度描述了有前景的设置,并在我们提出的设置中回顾了当前的IAD算法。此外,我们深入探讨了哪些网络架构设计可以显著提高异常检测性能。最后,我们强调了图像异常检测未来几个令人兴奋的研究方向。

参考文献

[1] T. Czimmermann, G. Ciuti, M. Milazzo, M. Chiurazzi, S. Roccella, C. M. Oddo, P. Dario. Visual-based defect detection and classification approaches for industrial applications – A survey. Sensors, vol. 20, no. 5, Article number 1459, 2020. DOI: 10.3390/s20051459.

[2] X. Tao, X. Y. Gong, X. Zhang, S. H. Yan, C. Adak. Deep learning for unsupervised anomaly localization in industrial images: A survey. IEEE Transactions on Instrumentation and Measurement, vol. 71, Article number 5018021, 2022. DOI: 10.1109/TIM.2022.3196436.

[3] Y. J. Cui, Z. X. Liu, S. G. Lian. A survey on unsupervised industrial anomaly detection algorithms, [Online], Available: https://arxiv.org/abs/2204.11161, 2022.

[4] Z. Y. You, L. Cui, Y. J. Shen, K. Yang, X. Lu, Y. Zheng, X. Y. Le. A unified model for multi-class anomaly detection. In Proceedings of the 36th International Conference on Neural Information Processing Systems, New Orleans, USA, 2022.

[5] P. Bergmann, M. Fauser, D. Sattlegger, C. Steger. MVTec ad — a comprehensive real-world dataset for unsupervised anomaly detection. In Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition, Long Beach, USA, pp. 9584–9592, 2019. DOI: 10.1109/CVPR.2019.00982.

[6] P. Bergmann, K. Batzner, M. Fauser, D. Sattlegger, C. Steger. Beyond dents and scratches: Logical constraints in unsupervised anomaly detection and localization. International Journal of Computer Vision, vol. 130, no. 4, pp. 947–969, 2022. DOI: 10.1007/s11263-022-01578-9.

[7] K. M. He, X. Y. Zhang, S. Q. Ren, J. Sun. Deep residual learning for image recognition. In Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, USA, pp. 770–778, 2016. DOI: 10.1109/CVPR.2016.90.

[8] K. Simonyan. A. Zisserman. Very deep convolutional networks for large-scale image recognition. In Proceedings of the 3rd International Conference on Learning Representations, San Diego, USA, 2015. DOI: 10.48550/arXiv.1409.1556.

[9] M. X. Tan, Q. Le. EfficientNet: Rethinking model scaling for convolutional neural networks. In Proceedings of the 36th International conference on machine learning, Long Beach, USA, pp. 6105–6114, 2019.

[10] P. Bergmann, M. Fauser, D. Sattlegger, C. Steger. Uninformed students: Student-teacher anomaly detection with discriminative latent embeddings. In Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition, Seattle, USA, pp. 4182–4191, 2020. DOI: 10.1109/CVPR42600.2020.00424.

[11] M. Salehi, N. Sadjadi, S. Baselizadeh, M. H. Rohban, H. R. Rabiee. Multiresolution knowledge distillation for anomaly detection. In Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition, Nashville, USA, pp. 14897–14907, 2021. DOI: 10.1109/CVPR46437.2021.01466.

[12] G. D. Wang, S. M. Han, E. R. Ding, D. Huang. Student-teacher feature pyramid matching for anomaly detection. In Proceedings of 32nd British Machine Vision Conference 2021, 2021.

[13] S. Yamada, K. Hotta. Reconstruction student with attention for student-teacher pyramid matching, [Online], Available: https://arxiv.org/abs/2111.15376, 2021.

[14] H. Q. Deng, X. Y. Li. Anomaly detection via reverse distillation from one-class embedding. In Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition, New Orleans, USA, pp. 9727–9736, 2022. DOI: 10.1109/CVPR52688.2022.00951.

[15] Y. K. Cao, Q. Wan, W. M. Shen, L. Gao. Informative knowledge distillation for image anomaly segmentation. Knowledge-based Systems, vol. 248, Article number 108846, 2022. DOI: 10.1016/j.knosys.2022.108846.

[16] M. Rudolph, T. Wehrbein, B. Rosenhahn, B. Wandt. Asymmetric student-teacher networks for industrial anomaly detection. In Proceedings of IEEE/CVF Winter Conference on Applications of Computer Vision, Waikoloa, USA, pp. 2591–2601, 2023. DOI: 10.1109/WACV56688.2023.00262.

[17] S. Yamada, S. Kamiya, K. Hotta. Reconstructed student-teacher and discriminative networks for anomaly detection. In Proceedings of IEEE/RSJ International Conference on Intelligent Robots and Systems, Kyoto, Japan, pp. 2725–2732, 2022. DOI: 10.1109/IROS47612.2022.9981509.

[18] M. H. Yang, P. Wu, J. Liu, H. Feng. MemSeg: A semi-supervised method for image surface defect detection using differences and commonalities, [Online], Available: https://arxiv.org/abs/2205.00908, 2022.

[19] J. H. Yi, S. Yoon. Patch SVDD: Patch-level svdd for anomaly detection and segmentation. In Proceedings of the 15th Asian Conference on Computer Vision, Kyoto, Japan, pp. 375–390, 2021. DOI: 10.1007/978-3-030-69544-6_23.

[20] Z. Zhang, X. G. Deng. Anomaly detection using improved deep SVDD model with data structure preservation. Pattern Recognition Letters, vol. 148, pp. 1–6, 2021. DOI: 10.1016/j.patrec.2021.04.020.

[21] C. F. Hu, K. Chen, H. Shao. A semantic-enhanced method based on deep SVDD for pixel-wise anomaly detection. In Proceedings of IEEE International Conference on Multimedia and Expo, Shenzhen, China, 2021. DOI: 10.1109/ICME51207.2021.9428370.

[22] F. V. Massoli, F. Falchi, A. Kantarci, Ş. Akti, H. K. Ekenel, G. Amato. MOCCA: Multilayer one-class classification for anomaly detection. IEEE Transactions on Neural Networks and Learning Systems, vol. 33, no. 6, pp. 2313–2323, 2022. DOI: 10.1109/TNNLS.2021.3130074.

[23] D. Sauter, A. Schmitz, F. Dikici, H. Baumgartl, R. Buettner. Defect detection of metal nuts applying convolutional neural networks. In Proceedings of the 45th IEEE Annual Computers, Software, and Applications Conference, Madrid, Spain, pp. 248–257, 2021. DOI: 10.1109/COMPSAC51774.2021.00043.

[24] F. Chollet. Xception: Deep learning with depthwise separable convolutions. In Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, USA, pp. 1800–1807, 2017. DOI: 10.1109/CVPR.2017.195.

[25] T. Reiss, N. Cohen, L. Bergman, Y. Hoshen. PANDA: Adapting pretrained features for anomaly detection and segmentation. In Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition, Nashville, USA, pp. 2805–2813, 2021. DOI: 10.1109/CVPR46437.2021.00283.

[26] L. Bergman, N. Cohen, Y. Hoshen. Deep nearest neighbor anomaly detection, [Online], Available: https://arxiv.org/abs/2002.10445, 2020.

[27] K. Sohn, C. L. Li, J. Yoon, M. Jin, T. Pfister. Learning and evaluating representations for deep one-class classification. In Proceedings of the 9th International Conference on Learning Representations, 2021.

[28] X. L. Bai, Y. M. Fang, W. S. Lin, L. P. Wang, B. F. Ju. Saliency-based defect detection in industrial images by using phase spectrum. IEEE Transactions on Industrial Informatics, vol. 10, no. 4, pp. 2135–2145, 2014. DOI: 10.1109/TII.2014.2359416.

[29] M. H. Niu, K. C. Song, L. M. Huang, Q. Wang, Y. H. Yan, Q. G. Meng. Unsupervised saliency detection of rail surface defects using stereoscopic images. IEEE Transactions on Industrial Informatics, vol. 17, no. 3, pp. 2271–2281, 2021. DOI: 10.1109/TII.2020.3004397.

[30] Y. H. Qiu, L. X. Tang, B. Li, S. L. Niu, T. Z. Niu. Uneven illumination surface defects inspection based on saliency detection and intrinsic image decomposition. IEEE Access, vol. 8, pp. 190663–190676, 2020. DOI: 10.1109/ACCESS.2020.3032108.

[31] C. L. Li, K. Sohn, J. Yoon, T. Pfister. CutPaste: Self-supervised learning for anomaly detection and localization. In Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition, Nashville, USA, pp. 9659–9669, 2021. DOI: 10.1109/CVPR46437.2021.00954.

[32] S. Yoa, S. Lee, C. Kim, H. J. Kim. Self-supervised learning for anomaly detection with dynamic local augmentation. IEEE Access, vol. 9, pp. 147201–147211, 2021. DOI: 10.1109/ACCESS.2021.3124525.

[33] P. de Haan, S. Löwe. Contrastive predictive coding for anomaly detection, [Online], Available: https://arxiv.org/abs/2107.07820, 2021.

[34] D. M. J. Tax, R. P. W. Duin. Support vector data description. Machine Learning, vol. 54, no. 1, pp. 45–66, 2004. DOI: 10.1023/B:MACH.0000008084.60811.49.

[35] P. Liznerski, L. Ruff, R. A. Vandermeulen, B. J. Franks, M. Kloft, K. R. Muller. Explainable deep one-class classification. In Proceedings of the 9th International Conference on Learning Representations, 2021.

[36] T. Reiss, Y. Hoshen. Mean-shifted contrastive loss for anomaly detection, [Online], Available: https://arxiv.org/abs/2106.03844, 2021.

[37] A. van den Oord, Y. Z. Li, O. Vinyals. Representation learning with contrastive predictive coding, [Online], Available: https://arxiv.org/abs/1807.03748, 2018.

[38] D. W. Zhang, J. W. Han, Y. Zhang, D. Xu. Synthesizing supervision for learning deep saliency network without human annotation. IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 42, no. 7, pp. 1755–1769, 2020. DOI: 10.1109/TPAMI.2019.2900649.

[39] M. C. Zhuge, D. P. Fan, N. Liu, D. W. Zhang, D. Xu, L. Shao. Salient object detection via integrity learning. IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 45, no. 3, pp. 3738–3752, 2023. DOI: 10.1109/TPAMI.2022.3179526.

[40] C. W. Fang, H. B. Tian, D. W. Zhang, Q. Zhang, J. G. Han, J. W. Han. Densely nested top-down flows for salient object detection. Science China Information Sciences, vol. 65, no. 8, Article number 182103, 2022. DOI: 10.1007/s11432-021-3384-y.

[41] R. R. Selvaraju, M. Cogswell, A. Das, R. Vedantam, D. Parikh, D. Batra. Grad-CAM: Visual explanations from deep networks via gradient-based localization. In Proceedings of IEEE International Conference on Computer Vision, Venice, Italy, pp. 618–626, 2017. DOI: 10.1109/ICCV.2017.74.

[42] S. Venkataramanan, K. C. Peng, R. V. Singh. A. Mahalanobis. Attention guided anomaly localization in images. In Proceedings of the 16th European Conference on Computer Vision, Springer, Glasgow, UK, pp. 485–503, 2020. DOI: 10.1007/978-3-030-58520-4_29.

[43] A. S. Iquebal, S. T. Bukkapatnam. Consistent estimation of the max-flow problem: Towards unsupervised image segmentation. IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 44, no. 5, pp. 2346–2357, 2022. DOI: 10.1109/TPAMI.2020.3039745.

[44] H. Attar, M. Calin, L. C. Zhang, S. Scudino, J. Eckert. Manufacture by selective laser melting and mechanical behavior of commercially pure titanium. Materials Science and Engineering:A, vol. 593, pp. 170–177, 2014. DOI: 10.1016/j.msea.2013.11.038.

[45] M. Tailanian, P. Musé, Á. Pardo. A multi-scale a contrario method for unsupervised image anomaly detection. In Proceedings of the 20th IEEE International Conference on Machine Learning and Applications, Pasadena, USA, pp. 179–184, 2021. DOI: 10.1109/ICMLA52953.2021.00035.

[46] O. Rippel, P. Mertens, D. Merhof. Modeling the distribution of normal data in pre-trained deep features for anomaly detection. In Proceedings of the 25th International Conference on Pattern Recognition, Milan, Italy, pp. 6726–6733, 2021. DOI: 10.1109/ICPR48806.2021.9412109.

[47] O. Rippel, A. Chavan, C. C. Lei, D. Merhof. Transfer learning gaussian anomaly detection by fine-tuning representations. In Proceedings of the 2nd International Conference on Image Processing and Vision Engineering, pp. 45–56, 2022. DOI: 10.5220/0011063900003209.

[48] K. T. Zhang, B. Wang, C. C. J. Kuo. PEDENet: Image anomaly localization via patch embedding and density estimation. Pattern Recognition Letters, vol. 153, pp. 144–150, 2022. DOI: 10.1016/j.patrec.2021.11.030.

[49] Q. Wan, L. Gao, X. Y. Li, L. Wen. Unsupervised image anomaly detection and segmentation based on pretrained feature mapping. IEEE Transactions on Industrial Informatics, vol. 19, no. 3, pp. 2330–2339, 2023. DOI: 10.1109/TII.2022.3182385.

[50] Q. Wan, Y. K. Cao, L. Gao, W. M. Shen, X. Y. Li. Position encoding enhanced feature mapping for image anomaly detection. In Proceedings of the 18th IEEE International Conference on Automation Science and Engineering, Mexico City, Mexico, pp. 876–881, 2022. DOI: 10.1109/CASE49997.2022.9926547.

[51] Y. Zheng, X. Wang, R. Deng, T. P. Bao, R. Zhao, L. W. Wu. Focus your distribution: Coarse-to-fine non-contrastive learning for anomaly detection and localization. In Proceedings of IEEE International Conference on Multimedia and Expo, Taipei, China, pp. 1–6, 2022. DOI: 10.1109/ICME52920.2022.9859925.

[52] M. Rudolph, B. Wandt, B. Rosenhahn. Same same but DifferNet: Semi-supervised defect detection with normalizing flows. In Proceedings of IEEE Winter Conference on Applications of Computer Vision, Waikoloa, USA, pp. 1906–1915, 2021. DOI: 10.1109/WACV48630.2021.00195.

[53] M. Rudolph, T. Wehrbein, B. Rosenhahn, B. Wandt. Fully convolutional cross-scale-flows for image-based defect detection. In Proceedings of IEEE/CVF Winter Conference on Applications of Computer Vision, Waikoloa, USA, pp. 1829–1838, 2022. DOI: 10.1109/WACV51458.2022.00189.

[54] D. Gudovskiy, S. Ishizaka, K. Kozuka. CFLOW-AD: Real-time unsupervised anomaly detection with localization via conditional normalizing flows. In Proceedings of IEEE/CVF Winter Conference on Applications of Computer Vision, Waikoloa, USA, pp. 1819–1828, 2022. DOI: 10.1109/WACV51458.2022.00188.

[55] R. Q. Yan, F. Zhang, M. Y. Huang, W. Liu, D. Y. Hu, J. F. Li, Q. Liu, J. R. Jiang, Q. J. Guo, L. H. Zheng. CAINNFlow: Convolutional block attention modules and invertible neural networks flow for anomaly detection and localization tasks, [Online], Available: https://arxiv.org/abs/2206.01992, 2022.

[56] A. Dosovitskiy, L. Beyer, A. Kolesnikov, D. Weissenborn, X. H. Zhai, T. Unterthiner, M. Dehghani, M. Minderer, G. Heigold, S. Gelly, J. Uszkoreit, N. Houlsby. An image is worth 16×16 words: Transformers for image recognition at scale. In Proceedings of the 9th International Conference on Learning Representations, 2020.

[57] J. W. Yu, Y. Zheng, X. Wang, W. Li, Y. S. Wu, R. Zhao, L. W. Wu. FastFlow: Unsupervised anomaly detection and localization via 2D normalizing flows, [Online], Available: https://arxiv.org/abs/2111.07677, 2021.

[58] Y. Kim, H. Jang, D. Lee, H. J. Choi. AltUB: Alternating training method to update base distribution of normalizing flow for anomaly detection, [Online], Available: https://arxiv.org/abs/2210.14913, 2022.

[59] D. J. Rezende, S. Mohamed. Variational inference with normalizing flows. In Proceedings of the 32nd International Conference on Machine Learning, Lille, France, pp. 1530–1538, 2015.

[60] Z. Liu, Y. T. Lin, Y. Cao, H. Hu, Y. X. Wei, Z. Zhang, S. Lin, B. N. Guo. Swin Transformer: Hierarchical vision transformer using shifted windows. In Proceedings of IEEE/CVF International Conference on Computer Vision, Montreal, Canada, pp. 9992–10002, 2021. DOI: 10.1109/ICCV48922.2021.00986.

[61] S. Woo, J. Park, J. Y. Lee, I. S. Kweon. CBAM: Convolutional block Attention module. In Proceedings of the 15th European Conference on Computer Vision, Springer, Munich, Germany, pp. 3–19, 2018. DOI: 10.1007/978-3-030-01234-2_1.

[62] J. H. Kim, D. H. Kim, S. Yi, T. Lee. Semi-orthogonal embedding for efficient unsupervised anomaly segmentation, [Online], Available: https://arxiv.org/abs/2105.14737, 2021.

[63] N. Cohen, Y. Hoshen. Sub-image anomaly detection with deep pyramid correspondences, [Online], Available: https://arxiv.org/abs/2005.02357, 2020.

[64] N. Li, K. T. Jiang, Z. H. Ma, X. Wei, X. P. Hong, Y. H. Gong. Anomaly detection via self-organizing map. In Proceedings of the IEEE International Conference on Image Processing, Anchorage, USA, pp. 974–978, 2021. DOI: 10.1109/ICIP42928.2021.9506433.

[65] Q. Wan, L. Gao, X. Y. Li, L. Wen. Industrial image anomaly localization based on gaussian clustering of pretrained feature. IEEE Transactions on Industrial Electronics, vol. 69, no. 6, pp. 6182–6192, 2022. DOI: 10.1109/TIE.2021.3094452.

[66] C. C. Tsai, T. H. Wu, S. H. Lai. Multi-scale patch-based representation learning for image anomaly detection and segmentation. In Proceedings of IEEE/CVF Winter Conference on Applications of Computer Vision, Waikoloa, USA, pp. 3065–3073, 2022. DOI: 10.1109/WACV51458.2022.00312.

[67] Y. Zou, J. Jeong, L. Pemula, D. Q. Zhang, O. Dabeer. SPot-the-difference self-supervised pre-training for anomaly detection and segmentation. In Proceedings of the 17th European Conference on Computer Vision, Springer, Tel Aviv, Israel, pp. 392–408, 2022. DOI: 10.1007/978-3-031-20056-4_23.

[68] K. Roth, L. Pemula, J. Zepeda, B. Schölkopf, T. Brox, P. Gehler. Towards total recall in industrial anomaly detection. In Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition, New Orleans, USA, pp. 14298–14308, 2022. DOI: 10.1109/CVPR52688.2022.01392.

[69] S. Lee, S. Lee, B. C. Song. CFA: Coupled-hypersphere-based feature adaptation for target-oriented anomaly localization. IEEE Access, vol. 10, pp. 78446–78454, 2022. DOI: 10.1109/ACCESS.2022.3193699.

[70] D. Kim, C. Park, S. Cho, S. Lee. FAPM: Fast adaptive patch memory for real-time industrial anomaly detection, [Online], Available: https://arxiv.org/abs/2211.07381, 2022.

[71] J. Bae, J. H. Lee, S. Kim. Image anomaly detection and localization with position and neighborhood information, [Online], Available: https://arxiv.org/abs/2211.12634, 2022.

[72] E. Eskin, A. Arnold, M. Prerau, L. Portnoy, S. Stolfo. Applications of Data Mining in Computer Security, D. Barbará, S. Jajodia, Eds., New York, USA: Springer, pp. 77–101, 2002. DOI: 10.1007/978-1-4615-0953-0_4.

[73] T. Defard, A. Setkov, A. Loesch, R. Audigier. PaDiM: A patch distribution modeling framework for anomaly detection and localization. In Proceedings of Intemational Conference on Pattern Recognition – ICPR International Workshops and Challenges, Springer, Milano, Italy, pp. 475–489, 2021. DOI: 10.1007/978-3-030-68799-1_35.

[74] J. Jang, E. Hwang, S. H. Park. N-pad: Neighboring pixel-based industrial anomaly detection, [Online], Available: https://arxiv.org/abs/2210.08768, 2022.

[75] P. Bergmann, S. Löwe, M. Fauser, D. Sattlegger, C. Steger. Improving unsupervised defect segmentation by applying structural similarity to autoencoders. In Proceedings of the 14th International Joint Conference on Computer Vision, Imaging and Computer Graphics Theory and Applications, Funchal, Portugal, pp. 372–380, 2018. DOI: 10.5220/0007364503720380.

[76] H. Chung, J. Park, J. Keum, H. Ki, S. Kang. Unsupervised anomaly detection using style distillation. IEEE Access, vol. 8, pp. 221494–221502, 2020. DOI: 10.1109/ACCESS.2020.3043473.

[77] Y. F. Liu, C. Q. Zhuang, F. Lu. Unsupervised two-stage anomaly detection, [Online], Available: https://arxiv.org/abs/2103.11671, 2021.

[78] J. Yang, Y. Shi, Z. Q. Qi. DFR: Deep feature reconstruction for unsupervised anomaly segmentation, [Online], Available: https://arxiv.org/abs/2012.07122, 2020.

[79] Y. Yan, D. M. Wang, G. L. Zhou, Q. J. Chen. Unsupervised anomaly segmentation via multilevel image reconstruction and adaptive attention-level transition. IEEE Transactions on Instrumentation and Measurement, vol. 70, Article number 5015712, 2021. DOI: 10.1109/TIM.2021.3107586.

[80] K. Zhou, Y. T. Xiao, J. L. Yang, J. Cheng, W. Liu, W. X. Luo, Z. W. Gu, J. Liu, S. H. Gao. Encoding structure-texture relation with p-net for anomaly detection in retinal images. In Proceedings of the 16th European Conference on Computer Vision, Springer, Glasgow, UK, pp. 360–377, 2020. DOI: 10.1007/978-3-030-58565-5_22.

[81] A. S. Collin, C. De Vleeschouwer. Improved anomaly detection by training an autoencoder with skip connections on images corrupted with stain-shaped noise. In Proceedings of the 25th International Conference on Pattern Recognition, Milan, Italy, pp. 7915–7922, 2021. DOI: 10.1109/ICPR48806.2021.9412842.

[82] X. Tao, D. P. Zhang, W. Z. Ma, Z. X. Hou, Z. F. Lu, C. Adak. Unsupervised anomaly detection for surface defects with dual-siamese network. IEEE Transactions on Industrial Informatics, vol. 18, no. 11, pp. 7707–7717, 2022. DOI: 10.1109/TII.2022.3142326.

[83] J. L. Hou, Y. Y. Zhang, Q. Y. Zhong, D. Xie, S. L. Pu, H. Zhou. Divide-and-assemble: Learning block-wise memory for unsupervised anomaly detection. In Proceedings of IEEE/CVF International Conference on Computer Vision, Montreal, Canada, pp. 8771–8780, 2021. DOI: 10.1109/ICCV48922.2021.00867.

[84] T. K. Liu, B. Li, Z. Zhao, X. Du, B. K. Jiang, L. Q. Geng. Reconstruction from edge image combined with color and gradient difference for industrial surface anomaly detection, [Online], Available: https://arxiv.org/abs/2210.14485, 2022.

[85] D. Kim, D. Jeong, H. Kim, K. Chong, S. Kim, H. Cho. Spatial contrastive learning for anomaly detection and localization. IEEE Access, vol. 10, pp. 17366–17376, 2022. DOI: 10.1109/ACCESS.2022.3149130.

[86] Z. Y. Li, N. Li, K. T. Jiang, Z. H. Ma, X. Wei, X. P. Hong, Y. H. Gong. Superpixel masking and inpainting for self-supervised anomaly detection. In Proceedings of the 31st British Machine Vision Conference 2020, BMVC, 2020.

[87] V. Zavrtanik, M. Kristan, D. Skočaj. Reconstruction by inpainting for visual anomaly detection. Pattern Recognition, vol. 112, Article number 107706, 2021. DOI: 10.1016/j.patcog.2020.107706.

[88] H. Nakanishi, M. Suzuki, Y. Matsuo. Iterative image inpainting with structural similarity mask for anomaly detection. In Proceedings of the 9th International Conference on Learning Representations, 2021.

[89] A. Bauer. Self-supervised training with autoencoders for visual anomaly detection, [Online], Available: https://arxiv.org/abs/2206.11723, 2022.

[90] C. Q. Huang, Q. W. Xu, Y. F. Wang, Y. Wang, Y. Zhang. Self-supervised masking for unsupervised anomaly detection and localization. IEEE Transactions on Multimedia, to be published.

[91] V. Zavrtanik, M. Kristan, D. Skočaj. DRAEM – a discriminatively trained reconstruction embedding for surface anomaly detection. In Proceedings of IEEE/CVF International Conference on Computer Vision, Montreal, Canada, pp. 8310–8319, 2021. DOI: 10.1109/ICCV48922.2021.00822.

[92] O. Ronneberger, P. Fischer, T. Brox. U-net: Convolutional networks for biomedical image segmentation. In Proceedings of the 18th International Conference on Medical Image Computing and Computer-Assisted Intervention, Springer, Munich, Germany, pp. 234–241, 2015. DOI: 10.1007/978-3-319-24574-4_28.

[93] P. Xing, Y. P. Sun, Z. C. Li. Self-supervised guided segmentation framework for unsupervised anomaly detection, [Online], Available: https://arxiv.org/abs/2209.12440, 2022.

[94] V. Zavrtanik, M. Kristan, D. Skočaj. DSR – A dual subspace re-projection network for surface anomaly detection. In Proceedings of the 17th European Conference on Computer Vision, Springer, Tel Aviv, Israel, pp. 539–554, 2022. DOI: 10.1007/978-3-031-19821-2_31.

[95] H. M. Schlüter, J. Tan, B. Hou, B. Kainz. Natural synthetic anomalies for self-supervised anomaly detection and localization. In Proceedings of the 17th European Conference on Computer Vision, Springer, Tel Aviv, Israel, pp. 474–489, 2022. DOI: 10.1007/978-3-031-19821-2_27.

[96] N. C. Ristea, N. Madan, R. T. Ionescu, K. Nasrollahi, F. S. Khan, T. B. Moeslund, M. Shah. Self-supervised predictive convolutional attentive block for anomaly detection. In Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition, New Orleans, USA, pp. 13566–13576, 2022. DOI: 10.1109/CVPR52688.2022.01321.

[97] N. Madan, N. C. Ristea, R. T. Ionescu, K. Nasrollahi, F. S. Khan, T. B. Moeslund, M. Shah. Self-supervised masked convolutional transformer block for anomaly detection, [Online], Available: https://arxiv.org/abs/2209.12148, 2022.

[98] D. Dehaene, O. Frigo, S. Combrexelle, P. Eline. Iterative energy-based projection on a normal data manifold for anomaly localization. In Proceedings of the 8th International Conference on Learning Representations, Addis Ababa, Ethiopia, 2020.

[99] W. Q. Liu, R. Z. Li, M. Zheng, S. Karanam, Z. Y. Wu, B. Bhanu, R. J. Radke, O. Camps. Towards visually explaining variational autoencoders. In Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition, Seattle, USA, pp. 8639–8648, 2020. DOI: 10.1109/CVPR42600.2020.00867.

[100] T. Matsubara, K. Sato, K. Hama, R. Tachibana, K. Uehara. Deep generative model using unregularized score for anomaly detection with heterogeneous complexity. IEEE Transactions on Cybernetics, vol. 52, no. 6, pp. 5161–5173, 2022. DOI: 10.1109/TCYB.2020.3027724.

[101] D. Dehaene, P. Eline. Anomaly localization by modeling perceptual features, [Online], Available: https://arxiv.org/abs/2008.05369, 2020.

[102] L. Wang, D. K. Zhang, J. H. Guo, Y. X. Han. Image anomaly detection using normal data only by latent space resampling. Applied Sciences, vol. 10, no. 23, Article number 8660, 2020. DOI: 10.3390/app10238660.

[103] X. D. Yan, H. D. Zhang, X. X. Xu, X. Hu, P. A. Heng. Learning semantic context from normal samples for unsupervised anomaly detection. In Proceedings of the 35th AAAI Conference on Artificial Intelligence, pp. 3110–3118, 2021. DOI: 10.1609/aaai.v35i4.16420.

[104] J. Song, K. Kong, Y. I. Park, S. G. Kim, S. J. Kang. AnoSeg: Anomaly segmentation network using self-supervised learning, [Online], Available: https://arxiv.org/abs/2110.03396, 2021.

[105] Y. F. Liang, J. N. Zhang, S. W. Zhao, R. Z. Wu, Y. Liu, S. W. Pan. Omni-frequency channel-selection representations for unsupervised anomaly detection, [Online], Available: https://arxiv.org/abs/2203.00259, 2022.

[106] P. Mishra, R. Verk, D. Fornasier, C. Piciarelli, G. L. Foresti. VT-ADL: A vision transformer network for image anomaly detection and localization. In Proceedings of the IEEE 30th International Symposium on Industrial Electronics, Kyoto, Japan, 2021. DOI: 10.1109/ISIE45552.2021.9576231.

[107] Z. Y. You, K. Yang, W. H. Luo, L. Cui, Y. Zheng, X. Y. Le. ADTR: Anomaly detection transformer with feature reconstruction. In Proceedings of the 29th International Conference on Neural Information Processing, Springer, pp. 298–310, 2023. DOI: 10.1007/978-3-031-30111-7_26.

[108] Y. Lee, P. Kang. AnoViT: Unsupervised anomaly detection and localization with vision transformer-based encoder-decoder. IEEE Access, vol. 10, pp. 46717–46724, 2022. DOI: 10.1109/ACCESS.2022.3171559.

[109] E. Mathian, H. Liu, L. Fernandez-Cuesta, D. Samaras, M. Foll, L. Chen. HaloAE: An HaloNet based local transformer auto-encoder for anomaly detection and localization, [Online], Available: https://arxiv.org/abs/2208.03486, 2022.

[110] J. Pirnay, K. Chai. Inpainting transformer for anomaly detection. In Proceedings of the 21st International Conference on Image Analysis and Processing, Springer, Lecce, Italy, pp. 394–406, 2022. DOI: 10.1007/978-3-031-06430-2_33.

[111] J. L. Jiang, J. L. Zhu, M. Bilal, Y. Cui, N. Kumar, R. H. Dou, F. Su, X. L. Xu. Masked Swin Transformer Unet for industrial anomaly detection. IEEE Transactions on Industrial Informatics, vol. 19, no. 2, pp. 2200–2209, 2023. DOI: 10.1109/TII.2022.3199228.

[112] A. De Nardin, P. Mishra, G. L. Foresti, C. Piciarelli. Masked transformer for image anomaly localization. International Journal of Neural Systems, vol. 32, no. 7, Article number 2250030, 2022. DOI: 10.1142/S0129065722500307.

[113] J. Wyatt, A. Leach, S. M. Schmon, C. G. Willcocks. AnoDDPM: Anomaly detection with denoising diffusion probabilistic models using simplex noise. In Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition, New Orleans, USA, pp. 649–655, 2022. DOI: 10.1109/CVPRW56347.2022.00080.

[114] Y. P. Teng, H. Y. Li, F. Z. Cai, M. Shao, S. Y. Xia. Unsupervised visual defect detection with score-based generative model, [Online], Available: https://arxiv.org/abs/2211.16092, 2022.

[115] J. Hu, L. Shen, G. Sun. Squeeze-and-excitation networks. In Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition, Salt Lake City, USA, pp. 7132–7141, 2018. DOI: 10.1109/CVPR.2018.00745.

[116] A. Vaswani, P. Ramachandran, A. Srinivas, N. Parmar, B. Hechtman, J. Shlens. Scaling local self-attention for parameter efficient visual backbones. In Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition, Nashville, USA, pp. 12889–12899, 2021. DOI: 10.1109/CVPR46437.2021.01270.

[117] K. Perlin. An image synthesizer. ACM SIGGRAPH Computer Graphics, vol. 19, no. 3, pp. 287–296, 1985. DOI: 10.1145/325165.325247.

[118] J. Ho, A. Jain. P. Abbeel, Denoising diffusion probabilistic models. In Proceedings of the 34th International Conference on Neural Information Processing Systems, Vancouver, Canada, pp. 574, 2020.

[119] W. H. Chu, K. M. Kitani. Neural batch sampling with reinforcement learning for semi-supervised anomaly detection. In Proceedings of the 16th European Conference on Computer Vision, Springer, Glasgow, UK, pp. 751–766, 2020. DOI: 10.1007/978-3-030-58574-7_45.

[120] J. Božič, D. Tabernik, D. Skočaj. Mixed supervision for surface-defect detection: From weakly to fully supervised learning. Computers in Industry, vol. 129, Article number 103459, 2021. DOI: 10.1016/j.compind.2021.103459.

[121] G. S. Pang, C. B. Ding, C. H. Shen, A. van den Hengel. Explainable deep few-shot anomaly detection with deviation networks, [Online], Available: https://arxiv.org/abs/2108.00462, 2021.

[122] Q. Wan, L. Gao, X. Y. Li. Logit inducing with abnormality capturing for semi-supervised image anomaly detection. IEEE Transactions on Instrumentation and Measurement, vol. 71, Article number 3523412, 2022. DOI: 10.1109/TIM.2022.3205674.

[123] C. B. Ding, G. S. Pang, C. H. Shen. Catching both gray and black swans: Open-set supervised anomaly detection. In Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition, New Orleans, USA, pp. 7378–7388, 2022. DOI: 10.1109/CVPR52688.2022.00724.

[124] V. A. Sindagi, S. Srivastava. Domain adaptation for automatic OLED panel defect detection using adaptive support vector data description. International Journal of Computer Vision, vol. 122, no. 2, pp. 193–211, 2017. DOI: 10.1007/s11263-016-0953-y.

[125] K. P. Qiu, L. Tian, P. Wang. An effective framework of automated visual surface defect detection for metal parts. IEEE Sensors Journal, vol. 21, no. 18, pp. 20412–20420, 2021. DOI: 10.1109/JSEN.2021.3095410.

[126] G. Bhattacharya, B. Mandal, N. B. Puhan. Interleaved deep artifacts-aware attention mechanism for concrete structural defect classification. IEEE Transactions on Image Processing, vol. 30, pp. 6957–6969, 2021. DOI: 10.1109/TIP.2021.3100556.

[127] Z. Y. Zeng, B. Liu, J. L. Fu, H. Y. Chao. Reference-based defect detection network. IEEE Transactions on Image Processing, vol. 30, pp. 6637–6647, 2021. DOI: 10.1109/TIP.2021.3096067.

[128] G. R. Song, K. C. Song, Y. H. Yan. Saliency detection for strip steel surface defects using multiple constraints and improved texture features. Optics and Lasers in Engineering, vol. 128, Article number 106000, 2020. DOI: 10.1016/j.optlaseng.2019.106000.

[129] X. M. Long, B. Fang, Y. F. Zhang, G. Y. Luo, F. C. Sun. Fabric defect detection using tactile information. In Proceedings of IEEE International Conference on Robotics and Automation, Xi′an, China, pp. 11169–11174, 2021. DOI: 10.1109/ICRA48506.2021.9561092.

[130] B. Z. Hu, B. Gao, W. L. Woo, L. F. Ruan, J. K. Jin, Y. Yang, Y. J. Yu. A lightweight spatial and temporal multi-feature fusion network for defect detection. IEEE Transactions on Image Processing, vol. 30, pp. 472–486, 2021. DOI: 10.1109/TIP.2020.3036770.

[131] M. Ferguson, R. Ak, Y. T. T. Lee, K. H. Law. Detection and segmentation of manufacturing defects with convolutional neural networks and transfer learning, [Online], Available: https://arxiv.org/abs/1808.02518, 2018.

[132] X. Tao, D. P. Zhang, W. Z. Ma, X. L. Liu, D. Xu. Automatic metallic surface defect detection and recognition with convolutional neural networks. Applied Sciences, vol. 8, no. 9, Article number 1575, 2018. DOI: 10.3390/app8091575.

[133] J. Y. Li, Z. F. Su, J. H. Geng, Y. X. Yin. Real-time detection of steel strip surface defects based on improved YOLO detection network. IFAC-PapersOnLine, vol. 51, no. 21, pp. 76–81, 2018. DOI: 10.1016/j.ifacol.2018.09.412.

[134] D. Tabernik, S. Šela, J. Skvarč, D. Skočaj. Segmentation-based deep-learning approach for surface-defect detection. Journal of Intelligent Manufacturing, vol. 31, no. 3, pp. 759–776, 2020. DOI: 10.1007/s10845-019-01476-x.

[135] D. W. Zhang, G. Y. Guo, W. Y. Zeng, L. Li, J. W. Han. Generalized weakly supervised object localization. IEEE Transactions on Neural Networks and Learning Systems, to be published.

[136] D. W. Zhang, W. Y. Zeng, J. R. Yao, J. W. Han. Weakly supervised object detection using proposal- and semantic-level relationships. IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 44, no. 6, pp. 3349–3363, 2022. DOI: 10.1109/TPAMI.2020.3046647.

[137] P. L. Huang, J. W. Han, N. Liu, J. Ren, D. W. Zhang. Scribble-supervised video object segmentation. IEEE/CAA Journal of Automatica Sinica, vol. 9, no. 2, pp. 339–353, 2022. DOI: 10.1109/JAS.2021.1004210.

[138] Y. Xi, K. Zhou, L. W. Meng, B. Chen, H. M. Chen, J. Y. Zhang. Transmission Line Insulator Defect Detection Based on Swin Transformer and Context. Machine Intelligence Research, vol. 20, no. 5, pp. 729–740, 2023. DOI: 10.1007/s11633-022-1355-y.

[139] J. C. Wu, D. J. Chen, C. S. Fuh, T. L. Liu. Learning unsupervised metaformer for anomaly detection. In Proceedings of IEEE/CVF International Conference on Computer Vision, Montreal, Canada, pp. 4349–4358, 2021. DOI: 10.1109/ICCV48922.2021.00433.

[140] A. M. Kamoona, A. K. Gostar, A. Bab-Hadiashar, R. Hoseinnezhad. Anomaly detection of defect using energy of point pattern features within random finite set framework, [Online], Available: https://arxiv.org/abs/2108.12159, 2021.

[141] C. Q. Huang, H. Y. Guan, A. F. Jiang, Y. Zhang, M. Spratling, Y. F. Wang. Registration based few-shot anomaly detection. In Proceedings of the 17th European Conference on Computer Vision, Springer, Tel Aviv, Israel, pp. 303–319, 2022. DOI: 10.1007/978-3-031-20053-3_18.

[142] E. Schwartz, A. Arbelle, L. Karlinsky, S. Harary, F. Scheidegger, S. Doveh, R. Giryes. MAEDAY: MAE for few and zero shot AnomalY-detection, [Online], Available: https://arxiv.org/abs/2211.14307, 2022.

[143] K. M. He, X. L. Chen, S. N. Xie, Y. H. Li, P. Dollár, R. Girshick. Masked autoencoders are scalable vision learners. In Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition, New Orleans, USA, pp. 15979–15988, 2022. DOI: 10.1109/CVPR52688.2022.01553.

[144] J. Jeong, Y. Zou, T. Kim, D. Q. Zhang, A. Ravichandran, O. Dabeer. WinCLIP: Zero-/few-shot anomaly classification and segmentation, [Online], Available: https://arxiv.org/abs/2303.14814, 2023.

[145] A. Radford, J. W. Kim, C. Hallacy, A. Ramesh, G. Goh, S. Agarwal, G. Sastry, A. Askell, P. Mishkin, J. Clark, G. Krueger, I. Sutskever. Learning transferable visual models from natural language supervision. In Proceedings of the 38th International Conference on Machine Learning, pp. 8748–8763, 2021.

[146] D. S. Tan, Y. C. Chen, T. P. C. Chen, W. C. Chen. TrustMAE: A noise-resilient defect classification framework using memory-augmented auto-encoders with trust regions. In Proceedings of IEEE Winter Conference on Applications of Computer Vision, Waikoloa, USA, pp. 276–285, 2021. DOI: 10.1109/WACV48630.2021.00032.

[147] J. Yoon, K. Sohn, C. L. Li, S. Ö. Arik, C. Y. Lee, T. Pfister. Self-supervise, refine, repeat: Improving unsupervised anomaly detection. Transactions on Machine Learning Research, to be published.

[148] C. Qiu, A. D. Li, M. Kloft, M. Rudolph, S. Mandt. Latent outlier exposure for anomaly detection with contaminated data. In Proceedings of the 39th International Conference on Machine Learning, Baltimore, USA, pp. 18153–18167, 2022.

[149] Y. H. Chen, Y. Tian, G. S. Pang, G. Carneiro. Deep one-class classification via interpolated gaussian descriptor. In Proceedings of the AAAI Conference on Artificial Intelligence, pp. 383–392, 2022. DOI: 10.1609/aaai.v36i1.19915.

[150] P. Bergmann, D. Sattlegger. Anomaly detection in 3D point clouds using deep geometric descriptors. In Proceedings of IEEE/CVF Winter Conference on Applications of Computer Vision, Waikoloa, USA, pp. 2612–2622, 2023. DOI: 10.1109/WACV56688.2023.00264.

[151] E. Horwitz, Y. Hoshen. Back to the feature: Classical 3D features are (almost) all you need for 3D anomaly detection. In Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops, Vancouver, Canada, pp. 2967–2976, 2023.

[152] R. B. Rusu, N. Blodow, M. Beetz. Fast point feature histograms (FPFH) for 3D registration. In Proceedings of IEEE International Conference on Robotics and Automation, Kobe, Japan, pp. 3212–3217, 2009. DOI: 10.1109/ROBOT.2009.5152473.

[153] T. Reiss, N. Cohen, E. Horwitz, R. Abutbul, Y. Hoshen. Anomaly detection requires better representations. In Proceedings of Computer Vision – 2022 Workshops, Springer, Tel Aviv, Israel, pp. 56–68, 2023. DOI: 10.1007/978-3-031-25069-9_4.

[154] J. H. Liu, C. Y. Wang, H. Su, B. Du, D. C. Tao. Multistage GAN for fabric defect detection. IEEE Transactions on Image Processing, vol. 29, pp. 3388–3400, 2020. DOI: 10.1109/TIP.2019.2959741.

[155] O. Rippel, M. Müller, D. Merhof, GAN-based defect synthesis for anomaly detection in fabrics. In Proceedings of the 25th IEEE International Conference on Emerging Technologies and Factory Automation, Vienna, Austria, pp. 534–540, 2020. DOI: 10.1109/ETFA46521.2020.9212099.

[156] J. Y. Zhu, T. Park, P. Isola, A. A. Efros. Unpaired image-to-image translation using cycle-consistent adversarial networks. In Proceedings of IEEE International Conference on Computer Vision, Venice, Italy, pp. 2242–2251, 2017. DOI: 10.1109/ICCV.2017.244.

[157] S. L. Niu, B. Li, X. G. Wang, H. Lin. Defect image sample generation with GAN for improving defect recognition. IEEE Transactions on Automation Science and Engineering, vol. 17, no. 3, pp. 1611–1622, 2020. DOI: 10.1109/tase.2020.2967415.

[158] T. R. Wei, D. H. Cao, X. R. Jiang, C. Y. Zheng, L. Z. Liu. Defective samples simulation through neural style transfer for automatic surface defect segment. In Proceedings of International Conference on Optical Instruments and Technology: Optoelectronic Measurement Technology and Systems, Beijing, China, pp. 1143904, 2020. DOI: 10.1117/12.2540464.

[159] T. R. Wei, D. H. Cao, C. Y. Zheng, Q. Yang. A simulation-based few samples learning method for surface defect segmentation. Neurocomputing, vol. 412, pp. 461–476, 2020. DOI: 10.1016/j.neucom.2020.06.090.

[160] S. Jain, G. Seth, A. Paruthi, U. Soni, G. Kumar. Synthetic data augmentation for surface defect detection and classification using deep learning. Journal of Intelligent Manufacturing, vol. 33, no. 4, pp. 1007–1020, 2022. DOI: 10.1007/s10845-020-01710-x.

[161] R. Y. Wang, S. Hoppe, E. Monari, M. F. Huber. Defect transfer GAN: Diverse defect synthesis for data augmentation. In Proceedings of the 33rd British Machine Vision Conference 2022, London, UK, pp. 445, 2021.

[162] M. Heusel, H. Ramsauer, T. Unterthiner, B. Nessler, S. Hochreiter. GANs trained by a two time-scale update rule converge to a local Nash equilibrium. In Proceedings of the 31st International Conference on Neural Information Processing Systems, Long Beach, USA, pp. 6629–6640, 2017.

[163] M. Bińkowski, D. J. Sutherland, M. Arbel, A. Gretton. Demystifying MMD GANs. In Proceedings of the 6th International Conference on Learning Representations, Vancouver, Canada, 2018.

[164] G. J. Zhang, K. W. Cui, T. Y. Hung, S. J. Lu. Defect-GAN: High-fidelity defect synthesis for automated defect inspection. In Proceedings of IEEE Winter Conference on Applications of Computer Vision, Waikoloa, USA, pp. 2523–2533, 2021. DOI: 10.1109/WACV48630.2021.00257.

[165] J. Silvestre-Blanes, T. Albero-Albero, I. Miralles, R. Pérez-Llorens, J. MoreA public fabric database for defect detection methods and results. Autex Research Journal, vol. 19, no. 4, pp. 363–374, 2019. DOI: 10.2478/aut-2019-0035.

[166] M. Wieler, T. Hahn. Weakly supervised learning for industrial optical inspection. DAGM Symposium, 2007.

[167] S. L. Tang, F. He, X. L. Huang, J. Yang. Online PCB defect detector on a new PCB defect dataset, [Online], Available: https://arxiv.org/abs/1902.06197, 2019.

[168] L. Bonfiglioli, M. Toschi, D. Silvestri, N. Fioraio, D. De Gregorio. The eyecandies dataset for unsupervised multimodal anomaly detection and localization. In Proceedings of the 16th Asian Conference on Computer Vision, Springer, Macao, China, pp. 459–475, 2022. DOI: 10.1007/978-3-031-26348-4_27.

[169] C. S. C. Tsang, H. Y. T. Ngan, G. K. H. Pang. Fabric inspection based on the elo rating method. Pattern Recognition, vol. 51, pp. 378–394, 2016. DOI: 10.1016/j.patcog.2015.09.022.

[170] D. Mery, V. Riffo, U. Zscherpel, G. Mondragón, I. Lillo, I. Zuccar, H. Lobel, M. Carrasco. Gdxray: The database of X-ray images for nondestructive testing. Journal of Nondestructive Evaluation, vol. 34, no. 4, Article number 42, 2015. DOI: 10.1007/s10921-015-0315-7.

[171] T. P. Bao, J. D. Chen, W. Li, X. Wang, J. J. Fei, L. W. Wu, R. Zhao, Y. Zheng. MIAD: A maintenance inspection dataset for unsupervised anomaly detection, [Online], Available: https://arxiv.org/abs/2211.13968, 2022.

[172] S. Jezek, M. Jonak, R. Burget, P. Dvorak, M. Skotak. Deep learning-based defect detection of metal parts: Evaluating current methods in complex conditions. In Proceedings of the 13th International Congress on Ultra Modern Telecommunications and Control Systems and Workshops, Brno, Czech Republic, pp. 66–71, 2021. DOI: 10.1109/ICUMT54235.2021.9631567.

[173] Y. B. Huang, C. Y. Qiu, K. Yuan. Surface defect saliency of magnetic tile. The Visual Computer, vol. 36, no. 1, pp. 85–96, 2020. DOI: 10.1007/s00371-018-1588-5.

[174] P. Bergmann, X. Jin, D. Sattlegger, C. Steger. The MVTec 3D-AD dataset for unsupervised 3D anomaly detection and localization. In Proceedings of the 17th International Joint Conference on Computer Vision, Imaging and Computer Graphics Theory and Applications, pp. 202–213, 2021. DOI: 10.5220/0010865000003124.

[175] D. Carrera, F. Manganini, G. Boracchi, E. Lanzarone. Defect detection in SEM images of nanofibrous materials. IEEE Transactions on Industrial Informatics, vol. 13, no. 2, pp. 551–561, 2017. DOI: 10.1109/tii.2016.2641472.

[176] K. C. Song, Y. H. Yan. A noise robust method based on completed local binary patterns for hot-rolled steel strip surface defects. Applied Surface Science, vol. 285, pp. 858–864, 2013. DOI: 10.1016/j.apsusc.2013.09.002.

[177] J. R. Gan, Q. Y. Li, J. Z. Wang, H. M. Yu. A hierarchical extractor-based visual rail surface inspection system. IEEE Sensors Journal, vol. 17, no. 23, pp. 7935–7944, 2017. DOI: 10.1109/JSEN.2017.2761858.

[178] Kaggle. Severstal: Steel defect detection, [Online], Available: https://www.kaggle.com/c/severstal-steel-defect-detection, 2019.

[179] D. M. Yang, Y. R. Cui, Z. Y. Yu, H. Q. Yuan. Deep learning based steel pipe weld defect detection. Applied Artificial Intelligence, vol. 35, no. 15, pp. 1237–1249, 2021. DOI: 10.1080/08839514.2021.1975391.

[180] P. Bergmann, K. Batzner, M. Fauser, D. Sattlegger, C. Steger. The mvtec anomaly detection dataset: A comprehensive real-world dataset for unsupervised anomaly detection. International Journal of Computer Vision, vol. 129, no. 4, pp. 1038–1059, 2021. DOI: 10.1007/s11263-020-01400-4.

[181] M. A. Rahman, Y. Wang. Optimizing intersection-over-union in deep neural networks for image segmentation. In Proceedings of the 12th International Symposium on Advances in Visual Computing, Springer, Las Vegas, USA, pp. 234–244, 2016. DOI: 10.1007/978-3-319-50835-1_22.

[182] S. Sheynin, S. Benaim, L. Wolf. A hierarchical transformation-discriminating generative model for few shot anomaly detection. In Proceedings of IEEE/CVF International Conference on Computer Vision, Montreal, Canada, pp. 8475–8484, 2021. DOI: 10.1109/ICCV48922.2021.00838.

[183] X. Jiang, J. L. Liu, J. B. Wang, Q. Nie, K. Wu, Y. Liu, C. J. Wang, F. Zheng. SoftPatch: Unsupervised anomaly detection with noisy data. In Proceedings of the 36th International Conference on Neural Information Processing Systems, New Orleans, USA, 2022.

[184] G. Y. Xie, J. B. Wang, J. Q. Liu, J. Y. Lyu, Y. Liu, C. J. Wang, F. Zheng, Y. C. Jin. IM-IAD: Industrial image anomaly detection benchmark in manufacturing, [Online], Available: https://arxiv.org/abs/2301.13359, 2023.

[185] D. W. Zhang, G. H. Huang, Q. Zhang, J. G. Han, J. W. Han, Y. Z. Wang, Y. Z. Yu. Exploring task structure for brain tumor segmentation from multi-modality MR images. IEEE Transactions on Image Processing, vol. 29, pp. 9032–9043, 2020. DOI: 10.1109/TIP.2020.3023609.

[186] D. W. Zhang, G. H. Huang, Q. Zhang, J. G. Han, J. W. Han, Y. Z. Yu. Cross-modality deep feature learning for brain tumor segmentation. Pattern Recognition, vol. 110, Article number 107562, 2021. DOI: 10.1016/j.patcog.2020.107562.

[187] C. W. Fang, Q. Wang, L. C. Cheng, Z. F. Gao, C. W. Pan, Z. Cao, Z. H. Zheng, D. W. Zhang. Reliable mutual distillation for medical image segmentation under imperfect annotations. IEEE Transactions on Medical Imaging, vol. 42, no. 6, pp. 1720–1734, 2023. DOI: 10.1109/TMI.2023.3237183.

[188] W. C. Wang, E. Ahn, D. Feng, J. Kim. A Review of Predictive and Contrastive Self-supervised Learning for Medical Images. Machine Intelligence Research, vol. 20, no. 4, pp. 483–513, 2023. DOI: 10.1007/s11633-022-1406-4.

[189] T. Shyamalee, D. Meedeniya. Glaucoma Detection with Retinal Fundus Images Using Segmentation and Classification. Machine Intelligence Research, vol. 19, no. 6, pp. 563–580, 2022. DOI: 10.1007/s11633-022-1354-z.

版权说明:

本文由 youcans@xidian 对论文 Deep Industrial Image Anomaly Detection: A Survey 进行摘编和翻译。该论文版权属于原文期刊和作者,本译文只供研究学习使用。

youcans@xidian 作品,转载必须标注原文链接:

【异常检测】深度工业图像异常检测调查(https://youcans.blog.csdn.net/article/details/146215402)

Crated:2025-03

1208

1208

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?