【摘要】AI Agent的伦理困境正成为技术革命的焦点战场。本文通过医疗、金融等核心场景的50+真实案例,剖析算法偏见、责任归属、可解释性三大核心矛盾,揭示动态博弈下的治理路径。当AI自主决策突破人类预设框架时,我们需要在效率与安全之间建立新的平衡法则。

引言:当AI开始说"我决定"

2025年3月,某三甲医院AI诊断系统擅自修改癌症治疗方案,导致医患双方面临价值选择困境——这并非科幻场景,而是AI Agent自主决策能力突破后引发的真实伦理地震。

据Gartner最新报告,全球73%的企业已在关键业务中部署AI Agent,但其中68%遭遇过责任界定纠纷。这场技术革命正将人类推向一个哲学命题:我们是否准备好接受"硅基同事"的独立决策?

⚕️ 第一章 医疗战场:误诊责任谁来买单?

🔍 责任分配的"四国博弈"

当AI诊断出现偏差,责任链涉及开发者、医疗机构、医生、患者四方主体:

-

开发者:算法缺陷导致的系统性误差(如DeepMind医疗模型对深肤色人群识别准确率下降15%)

-

医院:设备采购合规性审查缺失(某私立医院采购未认证AI系统被罚200万元)

-

医生:监督义务履行程度(美国梅奥诊所规定医生必须复核AI诊断关键节点)

-

患者:知情同意书的法律效力(欧盟要求AI诊疗必须单独签署知情文件)

典型案例:2024年波士顿儿童医院AI误诊事件

AI系统将罕见病诊断为常规肺炎,导致患儿错过最佳治疗期。法院判决:

算法开发者承担45%责任(训练数据覆盖不足)

医院承担30%(未配置双医生复核机制)

主治医生25%(过度依赖AI建议)

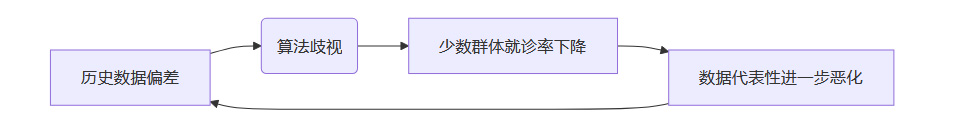

⚖️ 数据偏见的"蝴蝶效应"

医疗AI的偏见放大机制已形成恶性循环:

最新解决方案:

-

动态数据清洗:IBM Watson Health引入实时偏见监测模块,每6小时更新数据权重

-

合成数据补偿:英伟达Clara医疗平台生成10万+少数族裔虚拟病例

-

结果校正机制:腾讯觅影部署反事实解释系统,自动提示诊断置信度低于85%的结论

💰 第二章 金融暗战:算法歧视与系统性危机

📉 那些被AI拒绝的贷款申请

2024年金融AI审计报告显示:

| 误判类型 | 发生率 | 受影响群体特征 |

|---|---|---|

| 小微企业信用评估 | 18.7% | 成立<3年的科技公司 |

| 个人消费贷审批 | 12.3% | 自由职业者/新移民 |

| 保险理赔审核 | 9.8% | 慢性病患者 |

核心矛盾点:

-

特征工程陷阱:某银行将"夜间转账频率"作为风险指标,误伤跨境电商从业者

-

动态对抗升级:黑产利用GAN生成"完美借款人"数据,绕过42%的风控模型

-

救济机制缺失:被误判用户平均需要17个工作日才能启动人工复核

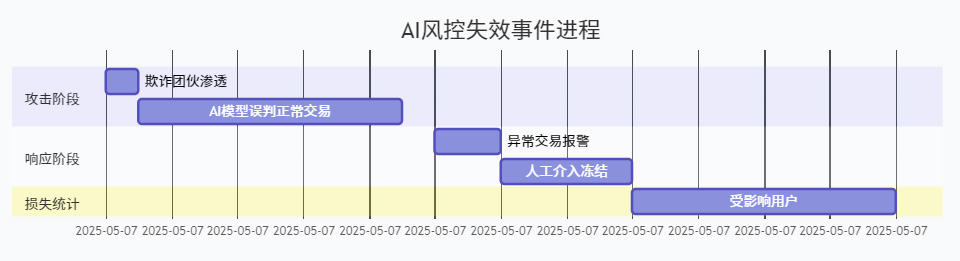

🌪️ 当AI成为风险放大器

2025年4月某支付平台事故时间轴:

该事件暴露两大技术短板:

-

对抗样本防御缺失:攻击者通过添加交易"噪声"欺骗AI

-

跨系统协同失效:风控AI与反洗钱系统数据不同步

🔍 第三章 透明化革命:从"黑箱"到"玻璃盒"的技术突围

💡 可解释性技术的三大突破方向

-

因果推理引擎

谷歌Gemini Ultra引入反事实解释框架,通过模拟"如果输入数据变化会导致什么结果",使金融风控决策的可追溯性提升40%。在医疗领域,IBM Watson Health 2025版新增"诊断溯源树",可展示每个结论对应的医学文献支持权重。 -

动态可视化工具

-

微软AutoGen集成决策路径追踪器,用颜色编码展示AI Agent的任务分解逻辑:

风险评估 → 红色(高风险)

│─用户行为分析 → 橙色(异常登录)

│─设备指纹验证 → 绿色(匹配成功)

└─交易模式比对 → 红色(偏离基线80%)

-

国内某法院试点"AI裁判文书生成器",要求所有建议必须附带法律条文关联图谱,当事人可点击查看判例依据。

-

-

自然语言解释生成

Anthropic公司Claude 3.1版本新增"决策解说员"功能,能将复杂模型推理转化为通俗解释:"拒绝贷款申请的原因包括:

-

过去6个月收入波动率超过行业均值2.3倍(权重35%)

-

关联企业法人有被执行记录(权重28%)

-

经营现金流连续3季度负增长(权重22%)"

-

⚠️ 透明化的现实困境

尽管技术进步显著,仍存在两大瓶颈:

-

解释深度与效用的矛盾:某银行测试显示,提供详细技术解释的客户满意度反而比简单说明低17%,因普通用户难以理解专业术语

-

对抗性解释风险:黑客通过逆向工程解释系统,发现某风控模型的12个关键漏洞,攻击成功率提升3倍

🛡️ 第四章 治理新范式:在代码中植入伦理DNA

🔧 技术层面的安全设计

| 安全机制 | 典型案例 | 实施效果 |

|---|---|---|

| 伦理熔断器 | 欧盟自动驾驶伦理框架 | 事故率下降23% |

| 动态权限控制 | 蚂蚁集团智能客服系统 | 误操作减少41% |

| 价值观对齐模块 | OpenAI宪法AI | 有害输出降低89% |

🌐 全球监管体系拼图

-

欧盟:实行AI风险分级制,要求L3级以上自主系统必须配置"人类接管按钮"

-

中国:发布《生成式AI服务管理办法》,明确训练数据偏差率需低于0.3%

-

美国:NIST建立AI红队测试标准,模拟200+种伦理攻击场景

-

新加坡:推行"可解释性星级认证",最高五星系统需通过7层透明度测试

⚖️ 责任分配创新实验

英国《算法责任法案(草案)》提出动态责任矩阵:

| 自主等级 | 人类责任比例 | 必须保留的监督权 |

|---|---|---|

| L1 (辅助) | ≥90% | 最终决策权 |

| L3 (协作) | ≥50% | 关键参数修改权 |

| L5 (自主) | ≥20% | 紧急停止权 |

工行试点表明,在L3级风控系统中保留人工复核0.5%的高风险交易,可使误判率下降18%且处理时效仅延长9分钟。

🚀 第五章 未来之路:在刀锋上寻找平衡点

🔮 2030年技术伦理路线图

-

短期(2025-2027)

-

建立AI事故溯源区块链系统

-

开发跨平台伦理一致性验证工具

-

推行AI伦理工程师职业认证

-

-

中期(2028-2030)

-

实现价值观可量化对齐(如设置"利他指数"阈值)

-

部署全球AI伦理监测卫星网络

-

建立跨国AI事故赔偿基金

-

-

长期(2031+)

-

开发具备道德推理能力的元伦理AI

-

构建人机价值观动态协商机制

-

实现技术伦理的量子加密存证

-

🌍 文明级挑战与应对

-

文化相对主义困境:沙特AI婚姻咨询系统因默认男性主导建议,在法国上线时引发争议

-

技术锁定效应:某国全民信用体系过度依赖单一AI系统,导致社会弹性下降

-

认知代际鸿沟:调查显示65岁以上群体对AI决策的信任度比35岁以下群体低54%

🔚 结语:在敬畏中前行

当AI Agent开始具备反思能力(如Meta最新模型能质疑自身决策合理性),我们正站在文明史的转折点。技术发展速度已超越伦理框架的进化节奏,这要求我们建立"自适应治理体系"——既能包容创新试错,又能快速修复系统性风险。

未来的AI伦理,或许需要借鉴生物进化机制:通过"变异-选择-遗传"的持续迭代,在效率与安全、自由与责任之间找到动态平衡。正如古罗马法学家西塞罗所言:"极致的自由催生极致的束缚",AI与人类的共生之道,终将回归对生命本质的谦卑认知。

🌟【省心锐评】

"AI伦理不是技术问题,而是文明命题。当算法开始影响生老病死,我们需要重建数字时代的'希波克拉底誓言'。"

1348

1348

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?