1 简介

本文根据1986年Hinton等人写的《Learning representations by back-propagating errors》翻译总结的。

对于神经网络,我们描述了一个新的学习过程,反向传播(back-propagation)。其不同于感知机的方法。

如果输入单元直接与输出单元相连,它是相对容易找到一个学习规则,即迭代调整连接的相关参数,以达到不断减少网络输出与预期输出之间的差距。但当我们引入隐藏单元时,学习将变得有趣但非常困难,因为这些隐藏单元的实际状态或者预期状态并不是为任务特定的。

在感知机中,输入与输出之间的特征分析并不是真正的隐藏单元,因为这些特征分析的输入连接是手工指定的,所以他们的状态完全由输入决定,他们不学习。正常的学习过程是必须决定在什么状况下隐藏单元应该被激活,从而有助于完成输入与输出的预期行为。这也意味着这些隐藏单元应该表示些什么。

2 公式

2.1 Forward pass

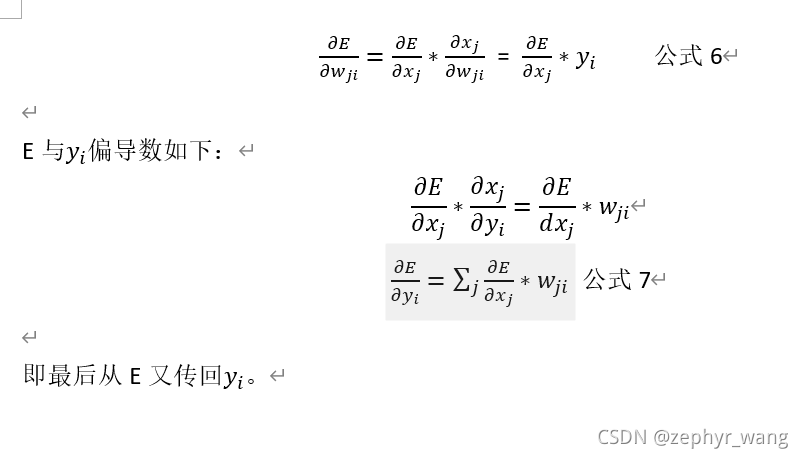

通过梯度下降最小化E,就需要计算E的偏导数。对于一个给定样本,对于每一个权重下E的偏导数通过两个途径计算。Forward途径和backward途径。其中forward就是采用上面的公式1、2,每层单元的状态由来自下层的输入决定.

2.2 Backward pass

1451

1451

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?