什么是LLM Agent它如何运作?

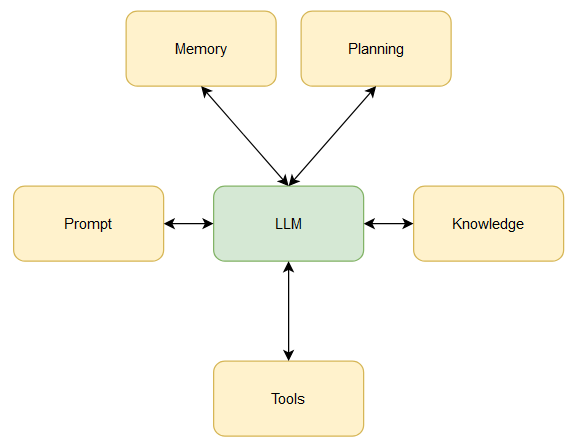

代理背后的主要直觉是一个模型,使用大型语言模型作为其中央计算引擎来推理问题、计划解决问题并使用一组工具来解决问题。

现实世界中的实际任务没有一步解决方案。它们通常需要多个相关和独立的步骤才能完成。对于“A 公司 2023 年的收入是多少?”这样的问题,可以通过简单的查找来得到答案。 然而,诸如“2023 财年第二季度收益的三个要点是什么?”这样的问题专注于公司正在构建的技术护城河”并不是那么容易解决的。为了找到这样的问题的答案,我们需要有关财务分析的知识,计划将问题分解为更简单的子部分,需要记忆来记住前面的步骤,最后需要工具来完成简单的任务。

让我们分解一下 LLM 代理的组成部分,以更好地了解它们的运作方式。

LLM代理的组成部分

1. 大语言模型(LLM)

LLM 代理的核心计算引擎是一个大型语言模型。法学硕士接受海量数据集的训练,以理解文本数据并进行推理。 [3] 和 [4] 等著名著作表明,法学硕士具有推理能力,这对于智能体的工作至关重要。

2. 提示(Prompt)

general_prompt = &

LLMAgent是一种利用大型语言模型为核心计算引擎,通过提示、记忆、知识和规划等组件来处理复杂问题的智能框架。它能分解任务、利用工具和长期短期记忆,展示了解决现实世界挑战的强大潜力。

LLMAgent是一种利用大型语言模型为核心计算引擎,通过提示、记忆、知识和规划等组件来处理复杂问题的智能框架。它能分解任务、利用工具和长期短期记忆,展示了解决现实世界挑战的强大潜力。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3101

3101

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?