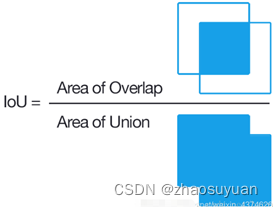

1.1 IOU(Intersection over Union)

1.2 TP TN FP FN

2. Accuracy、Precision、Recall、F1 SCORE

3. PR曲线、ROC曲线

4.1 AP (Average Precision)

4.2 mAP

4.3 mAP@0.5和mAP@0.5:0.95

5.混淆矩阵 confusion matrix

1.1 IOU(Intersection over Union)

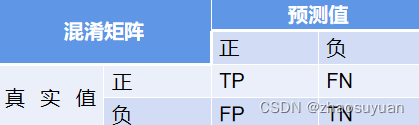

1.2 TP TN FP FN

TP(Truth Positive): 预测正类,实际正类,即预测正确

TN(Truth Negative):预测负类,实际负类,即预测正确

FP(False Positive): 预测正类,实际负类,即预测错误,和误检率有关

FN(False Negative):预测负类,实际正类,即预测错误,和漏检率有关

预测对(不管正负)即T,否则P;预测为正类即P(不管正确与否),否则负类N

2. Accuracy、Precision、Recall、F1 SCORE

Accuracy:准确率, (TP+TN)/(P+N),即正负样本正确数量/总样本。这个指标在样本比例差异较大时,容易失效,因为只要将全部预测成比例多的那种即可得到很高的准确率。

Precision:精确率,也可认为是查准率,预测的正类中对了几个TP/(TP+FP),即正确预测正类/(正确预测正类+错误预测正类)=正确预测正类/所有预测正类样本,你猜的全部正类中,查得正确的正类的数量。 误检率=1-Precision。

Recall:召回率,也可认为是查全率,全部正类中你猜对了几个TP/(TP+FN),即预测正确正类/(预测正确正类+预测错误负类)=预测正确正类/所有GT正类样本,理解成正类中召回了多少,查得多全。漏检率=1-Recall。

F1 SCORE:查全率和查准率的调和平均,1/F_1 =1/2*(1/P+1/R),综合考虑两个指标,并且受小的影响比较大。

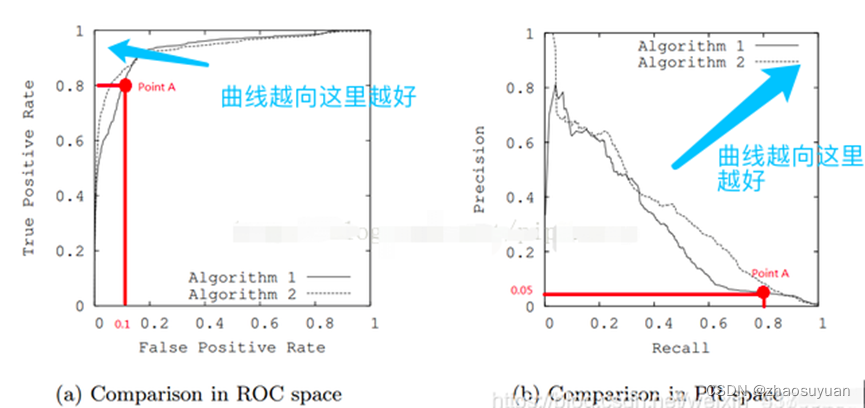

3. PR曲线、ROC曲线

P和R是两个不同维度的衡量方法。有时这两个是矛盾的,比如只检测出了一个结果,且是正确的,那么P就是100%,但是R就会很低。如果我们把所有认为可能的结果都返回,那么P可能就会很低,R就很高。

比如:

R高P低:所有汽车都被正确识别出来,但是很多卡车也被误认为是汽车

R低P高:识别出的飞机都是正确的,但还有很多飞机没被识别出来

PR曲线:就是选择不同的置信度阈值,得到的不同组合的P,R,以R为横坐标,P为纵坐标绘制而成。高度不均衡的数据集时,PR曲线能表现出更多的信息。

ROC曲线:就是选择不同的置信度阈值,以FPR=FP/(FP+FN),即错误预测正样本/所有预测负样本,为横坐标, TPR=TP/(TP+FN)=Recall为纵坐标。评估分类器的可信度。

ROC曲线,兼顾正负类,适合评估分类器整体性能,在正负类不平衡时,结果过于乐观

PR曲线,聚焦正类,不同类别分布对分类器影响,PR更能体现分类器效果。

4.1 AP (Average Precision)

AP,平均准确度,就是对PR曲线求积分

4.2 mAP

就是对不同类别的AP取平均。

4.3 mAP@0.5和mAP@0.5:0.95

mAP@0.5就是计算IOU=0.5的PR曲线与坐标轴所包围的面积

mAP@0.5:0.95就是在不同IOU(从0.5到0.95,步长0.05)(0.5、0.55、0.6、0.65、0.7、0.75、0.8、0.85、0.9、0.95)上的平均mAP。

YOLOv5中

AP^small,对应 area<32^2

AP^medium,对应 area<96^2

AP^large,对应 area>96^2

5.混淆矩阵 confusion matrix

每行是GT正负类,so每行正类之和即正样本总数,依次

每列是预测正负类

1756

1756

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?