目录

作业截图展示

基础作业

1. 使用 InternLM-Chat-7B 模型生成 300 字的小故事(截图)

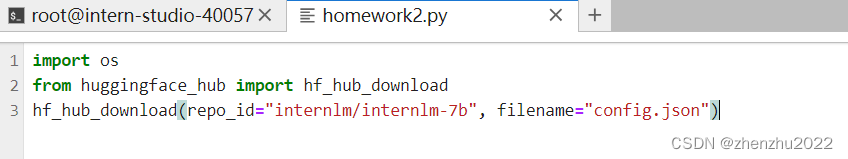

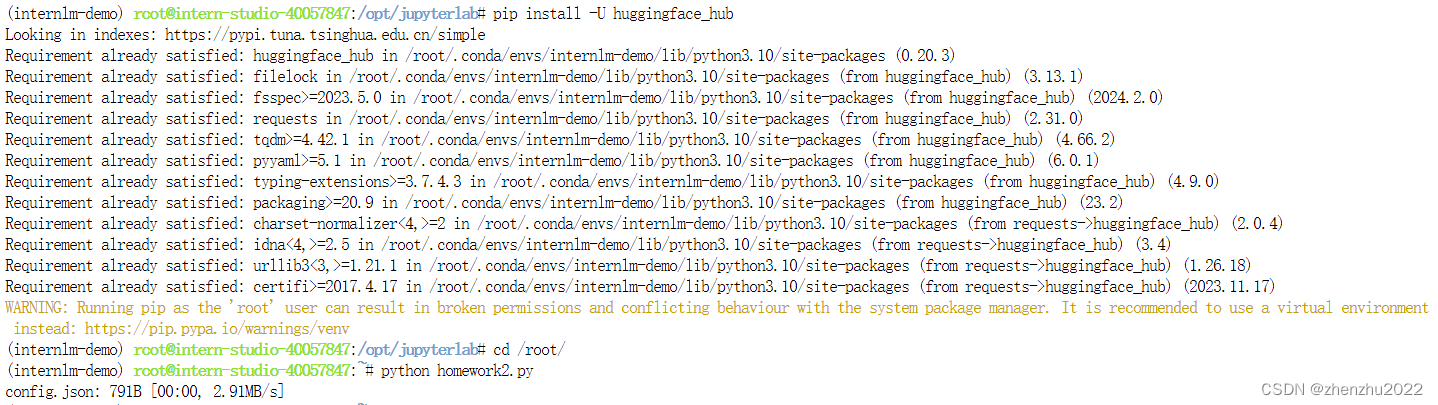

2. 熟悉 hugging face 下载功能,使用 huggingface_hub python 包,下载 InternLM-20B 的 config.json 文件到本地(截图下载过程)

进阶作业

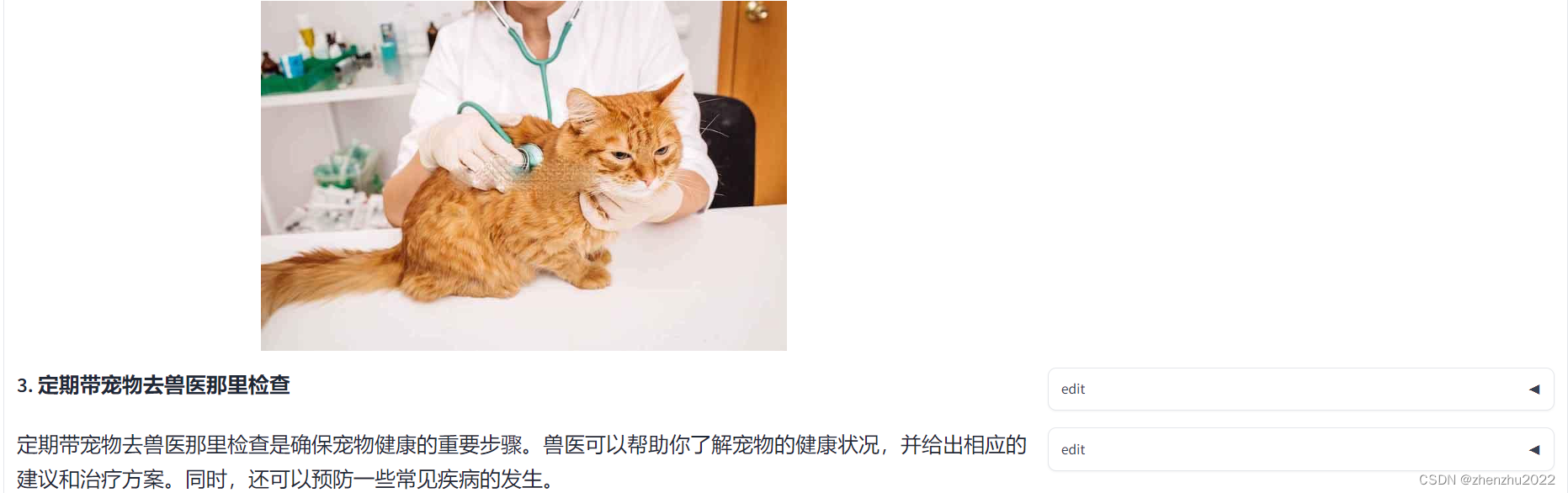

1. 完成浦语·灵笔的图文理解及创作部署(截图)

2. 完成 Lagent 工具调用 Demo 创作部署(截图)

详细操作过程

1. InternLM-Chat-7B 智能对话 Demo

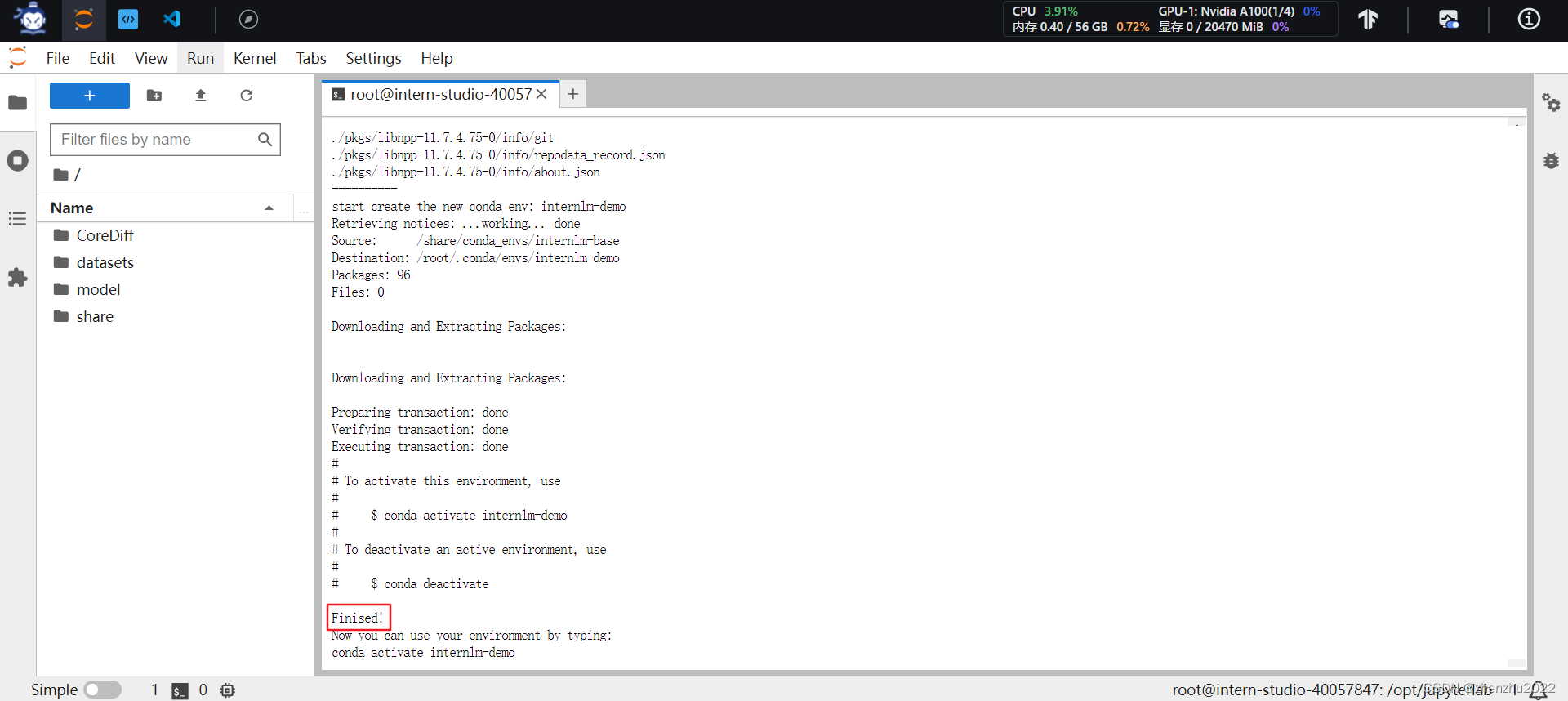

1.1 环境准备

使用 A100(1/4) 的配置,镜像选择 Cuda11.7-conda,如下图所示:

进入开发机后,在终端输入bash进入conda环境:

从本地克隆一个已有的 pytorch 2.0.1 的环境,执行以下命令:

bash /root/share/install_conda_env_internlm_base.sh internlm-demo

环境安装好后,使用conda activate internlm-demo激活,在环境中安装运行demo所需要的依赖:

# 升级pip

python -m pip install --upgrade pip

pip install modelscope==1.9.5

pip install transformers==4.35.2

pip install streamlit==1.24.0

pip install sentencepiece==0.1.99

pip install accelerate==0.24.11.2 模型下载

从share目录中下载InternLM模型:

![]()

1.3 代码准备

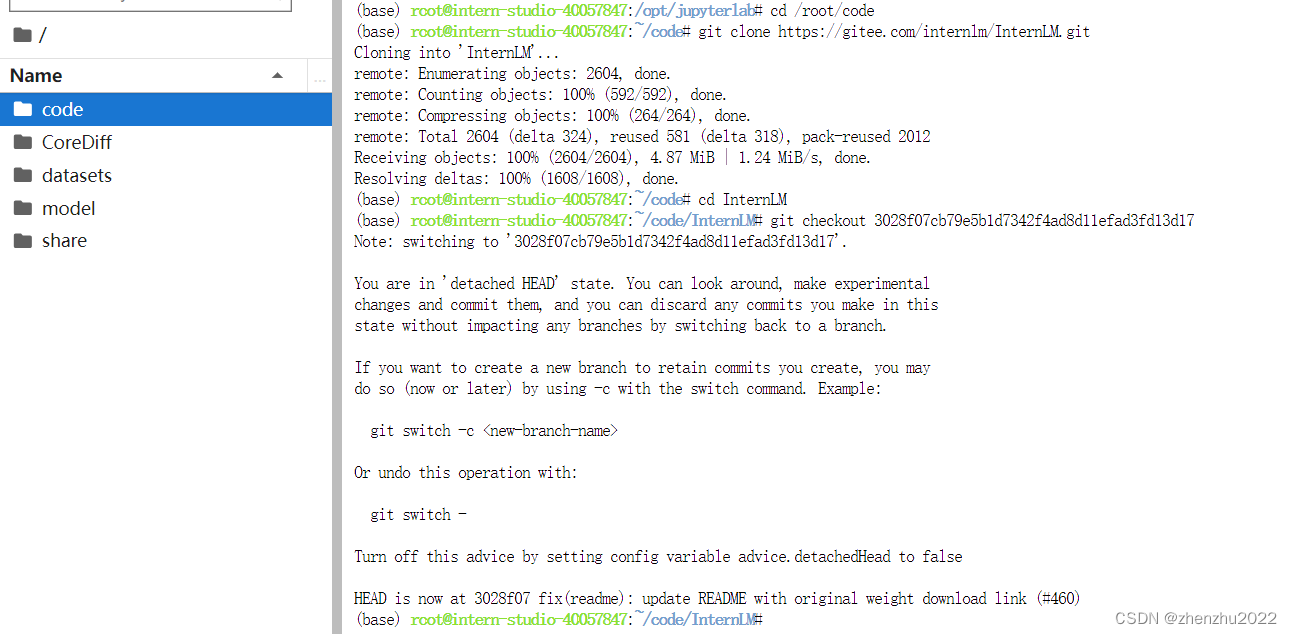

首先 clone 代码,在 /root 路径下新建 code 目录,然后切换路径, clone 代码,并切换 commit 版本:

将 /root/code/InternLM/web_demo.py 中 29 行和 33 行的模型更换为本地的 /root/model/Shanghai_AI_Laboratory/internlm-chat-7b

1.4 终端运行

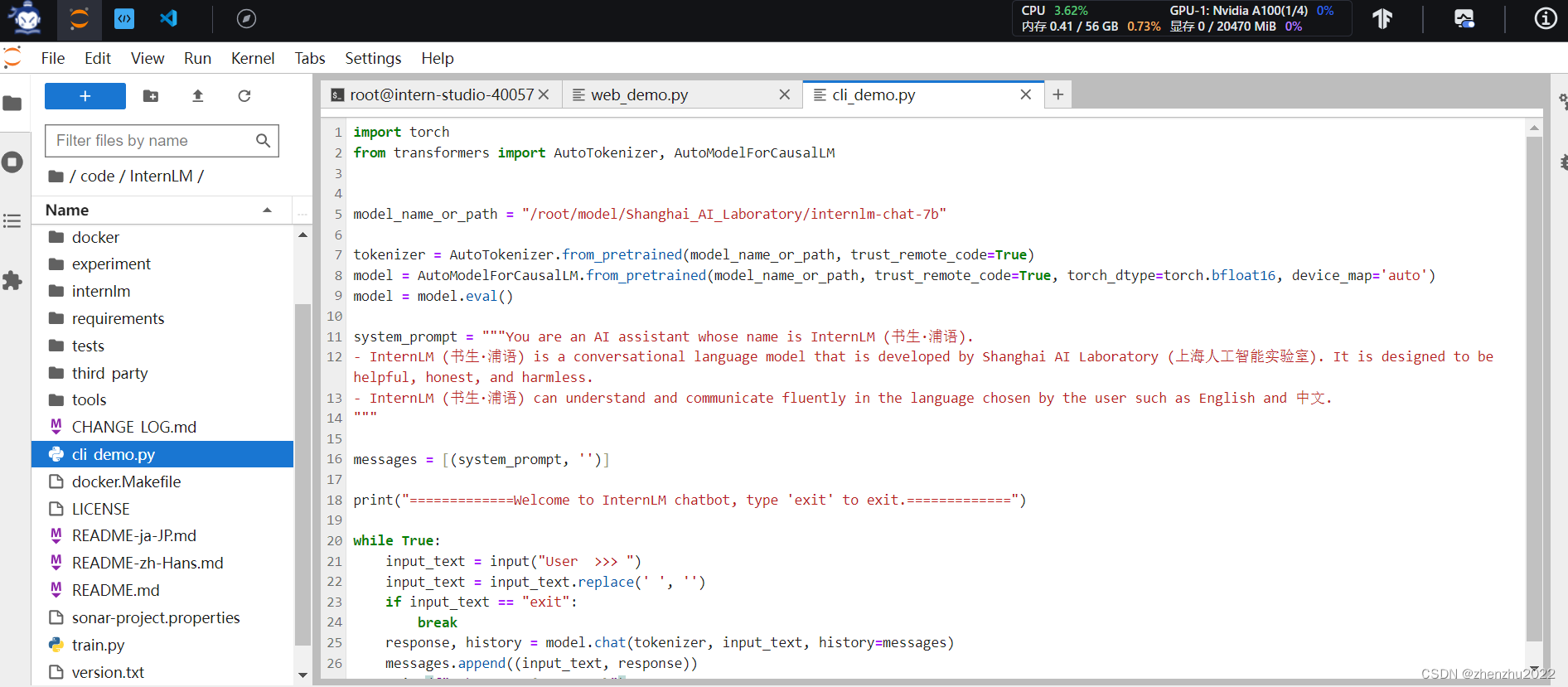

在 /root/code/InternLM 目录下新建一个 cli_demo.py 文件,填入以下代码:

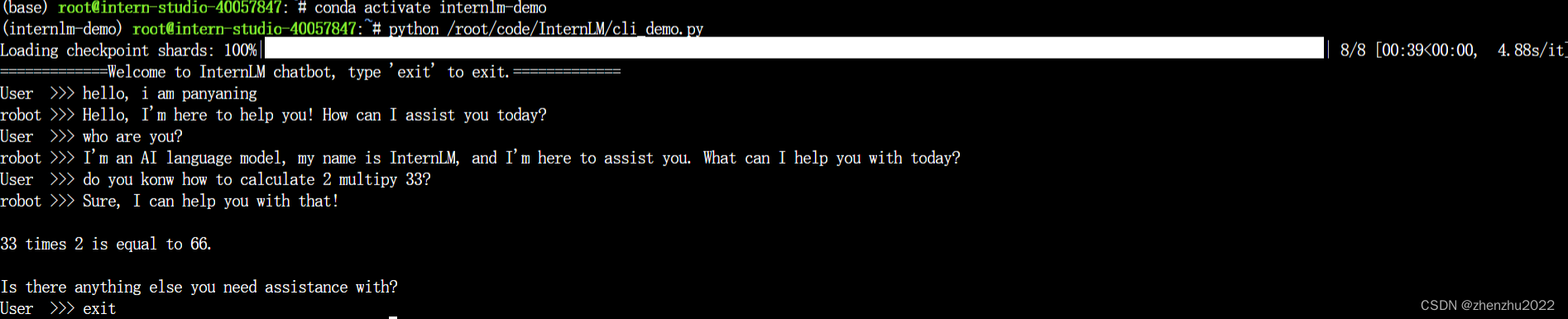

然后在终端运行命令python /root/code/InternLM/cli_demo.py,即可体验 InternLM-Chat-7B 模型的对话能力。对话效果如下所示:

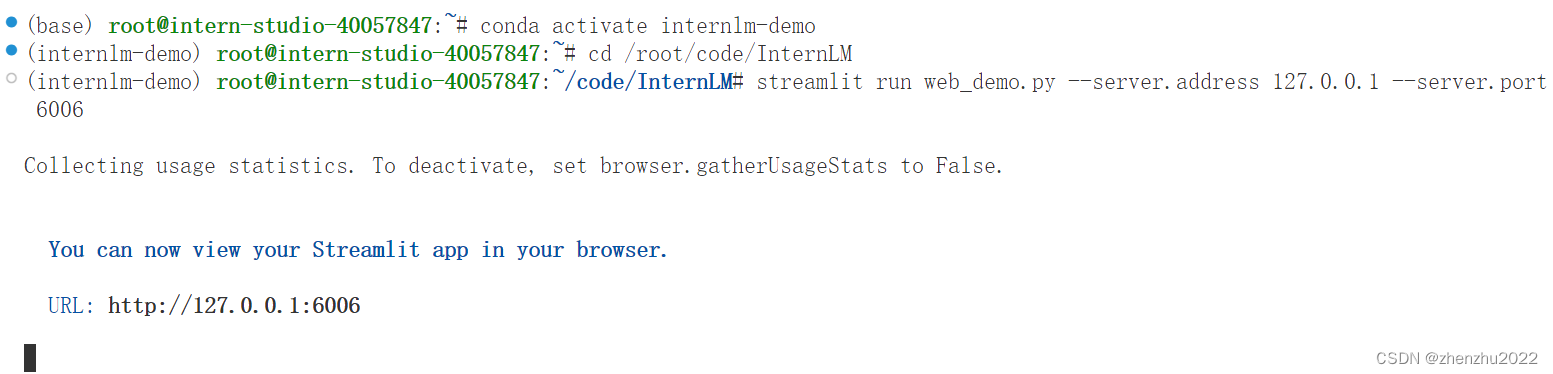

1.5 web demo 运行

切换到 VScode 中,运行 /root/code/InternLM 目录下的 web_demo.py 文件,输入以下命令后,将端口映射到本地。在本地浏览器输入 http://127.0.0.1:6006 即可。

本地端口映射命令

ssh -CNg -L 6006:127.0.0.1:6006 root@ssh.intern-ai.org.cn -p xxxxx

2. Lagent 智能体工具调用 Demo

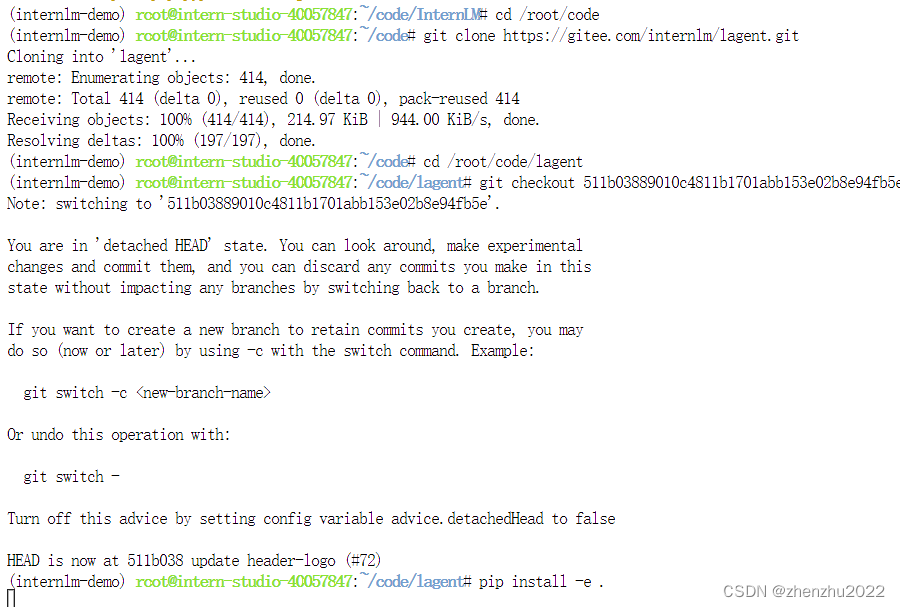

2.1 Lagent 安装

首先切换路径到 /root/code 克隆 lagent 仓库,并通过 pip install -e . 源码安装 Lagent

2.2 修改代码

修改/root/code/lagent/examples/react_web_demo.py

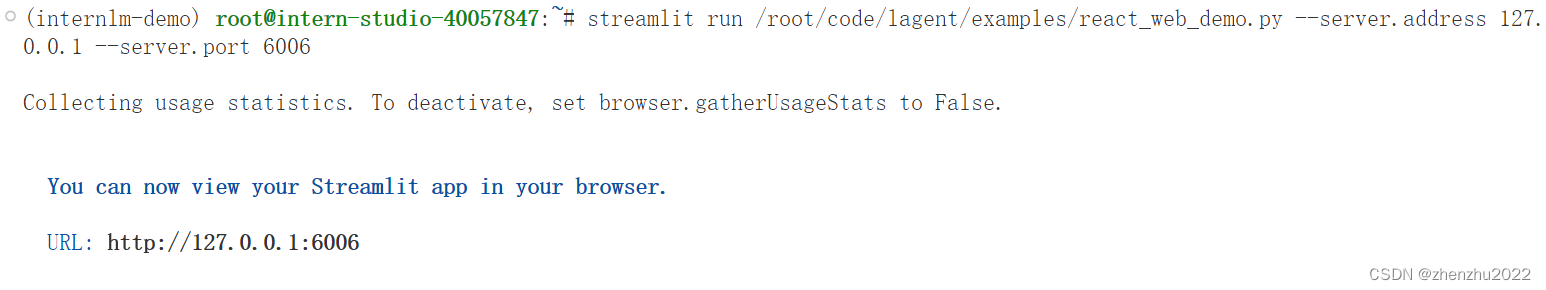

2.3 demo运行

3. 浦语·灵笔图文理解创作 Demo

3.1 环境准备

安装依赖包:

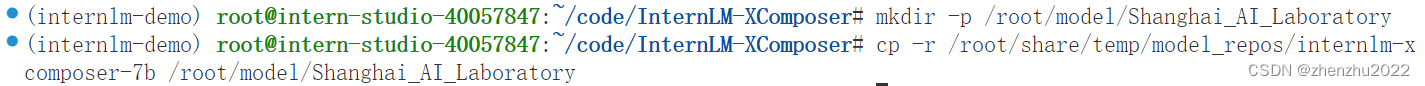

pip install transformers==4.33.1 timm==0.4.12 sentencepiece==0.1.99 gradio==3.44.4 markdown2==2.4.10 xlsxwriter==3.1.2 einops accelerate3.2 模型下载

3.3 代码准备

在 /root/code git clone InternLM-XComposer 仓库的代码

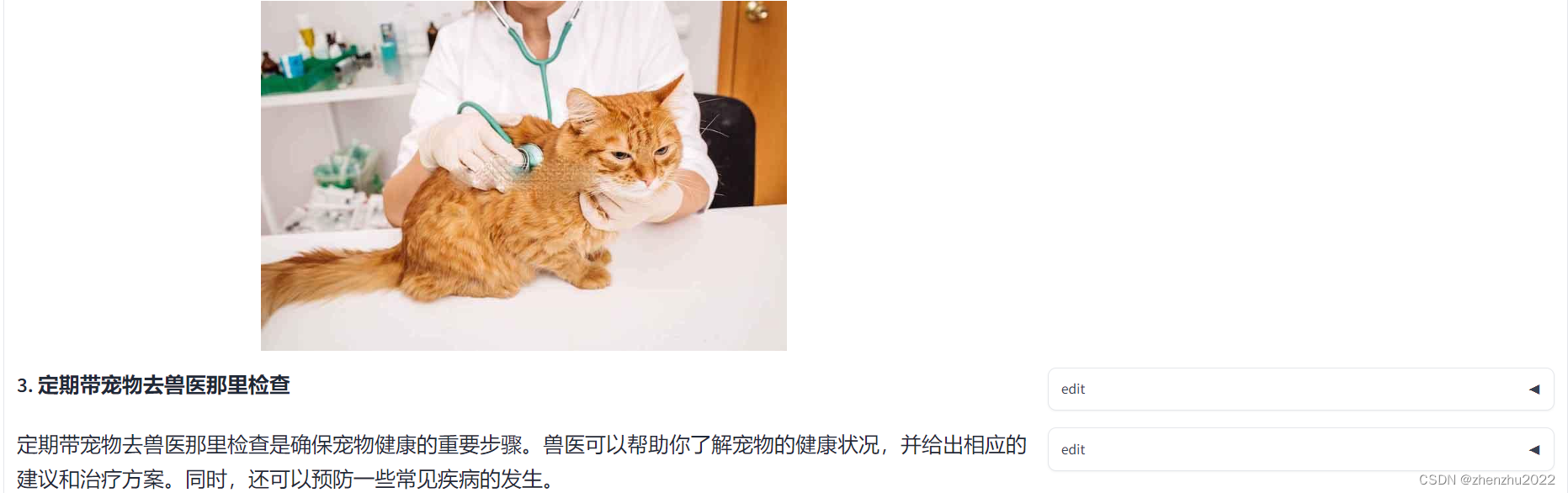

3.4 demo运行

在终端运行以下代码:

python examples/web_demo.py \

--folder /root/model/Shanghai_AI_Laboratory/internlm-xcomposer-7b \

--num_gpus 1 \

--port 6006

702

702

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?