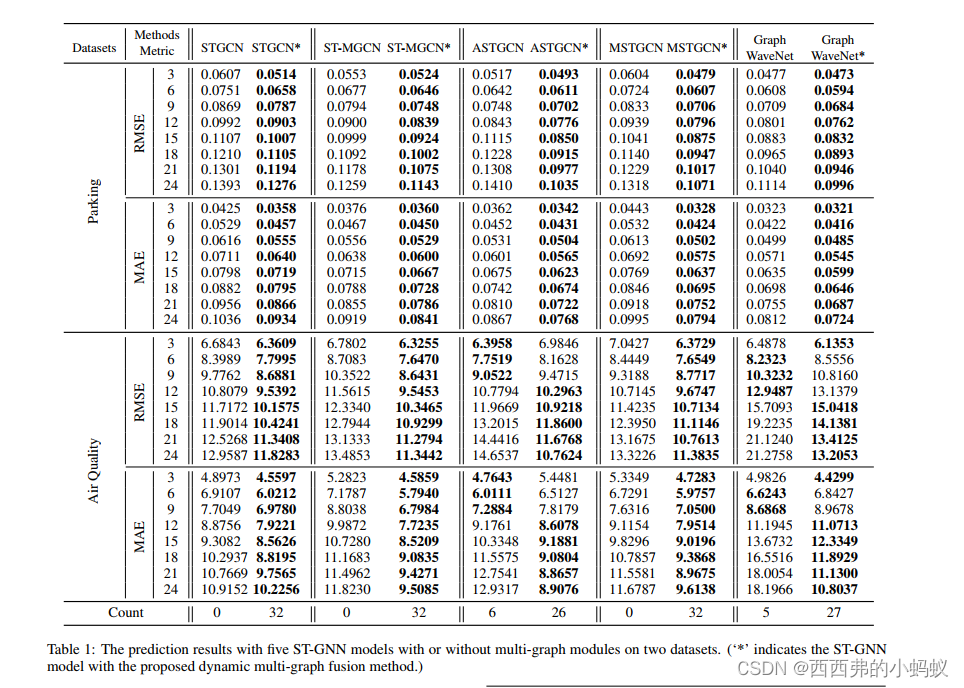

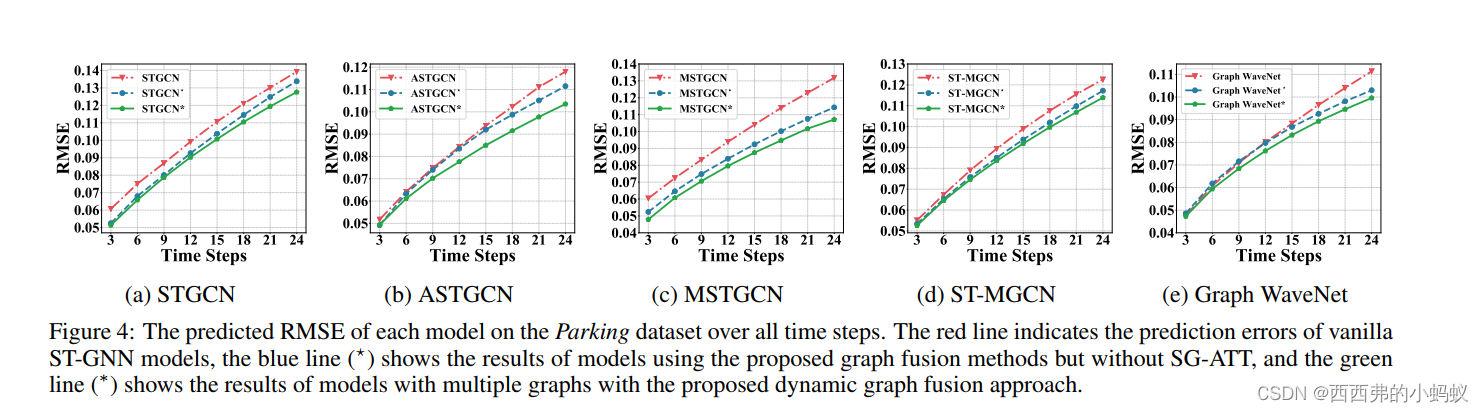

许多现实世界中无处不在的应用,如停车建议和空气污染监测,都从精确的长期时空预测(LSTF)中获益良多。LSTF利用了空间和时间域、上下文信息和数据中的固有模式之间的长期依赖关系。近年来的研究表明,多图神经网络(MGNNs)具有提高预测性能的潜力。然而,现有的MGNN方法普遍存在通用性不强、对上下文信息利用不足、图融合方法不平衡等问题,无法直接应用于LSTF。为了解决这些问题,我们构建了新的图模型来表示每个节点的上下文信息和长期的时空数据依赖结构。为了融合多图信息,我们提出了一种新的动态多图融合模块,通过空间注意和图注意机制来描述图内节点和跨图节点之间的相关性。此外,我们引入一个可训练的权值张量来表示不同图中每个节点的重要性。在两个大型数据集上的大量实验表明,我们提出的方法显著提高了现有图神经网络模型在LSTF预测任务中的性能。

背景:

LSTF的一个主要挑战是有效地捕获长期的时空依赖性和提取上下文信息

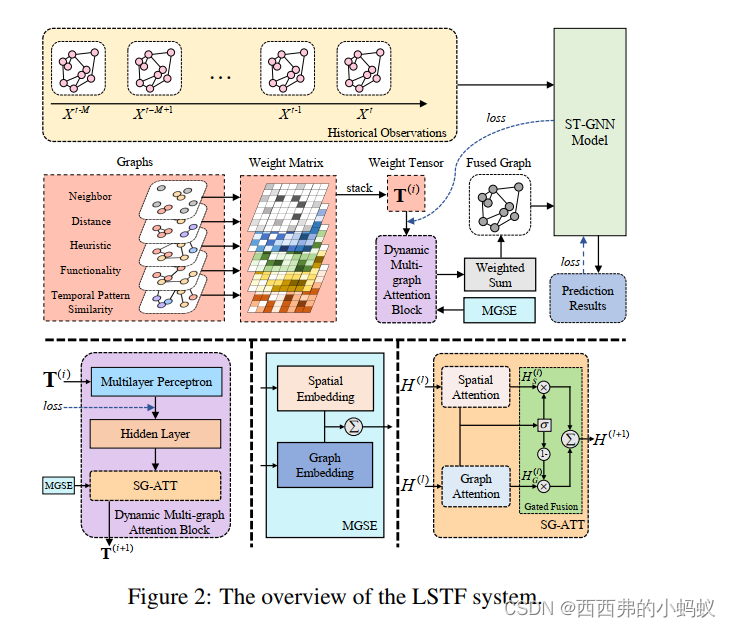

the proposed framework consists of three major components: the graph construction module, the

the proposed framework consists of three major components: the graph construction module, the

dynamic multi-graph fusion module, and the spatio-temporal graph neural network (ST-GNN).

|

Graph Construction Distance Graph 。。。。。。。。。。 |

| Dynamic Multi-graph Fusion |

本文提出了一种动态图融合方法;该方法的整个过程如图2和算法1所示。我们构造了一个可训练的权值张量作为动态多图注意块(DMGAB)的输入。此外,我们将空间信息和图信息融合到多图空间嵌入(MGSE)中。将此嵌入加入DMGAB。为了便于剩余连接,DMGAB各层产生D维的输出,块可以表示为DMGAB

Multi-graph Spatial Embedding

为了表示不同图中节点之间的关系,我们进一步提出了图嵌入来编码5个图

Dynamic Multi-graph Attention Block

图中的任何节点都会受到其他具有不同级别的节点的影响。当作用于多个图表时,这些影响会被放大。为了对内部节点的相关性进行建模,我们设计了一个多图注意块来自适应地捕获节点之间的相关性。

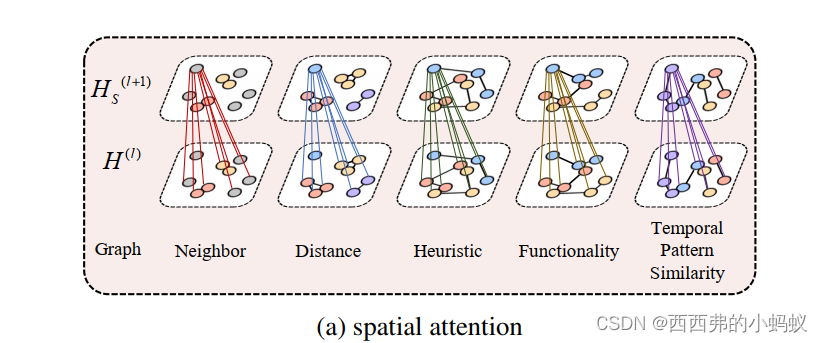

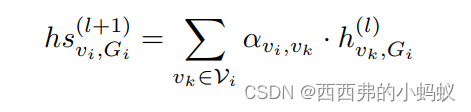

Spatial Attention

我们通过提出一种空间注意机制来捕捉节点的上下文相关性。与之前的空间注意机制作用于批处理时间数据的隐藏状态不同,我们的方法作用于权值张量的隐藏状态。

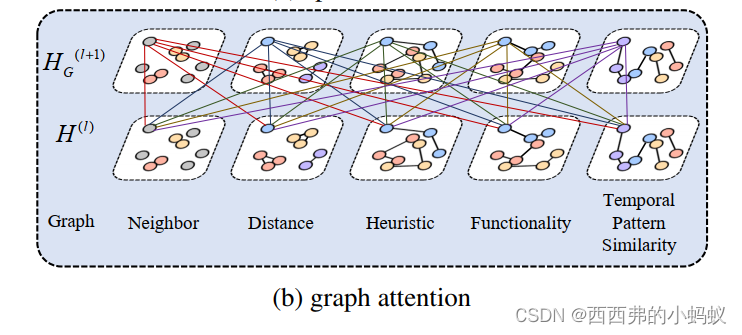

Graph Attention

我们利用图注意来获得不同图中一个节点的自相关

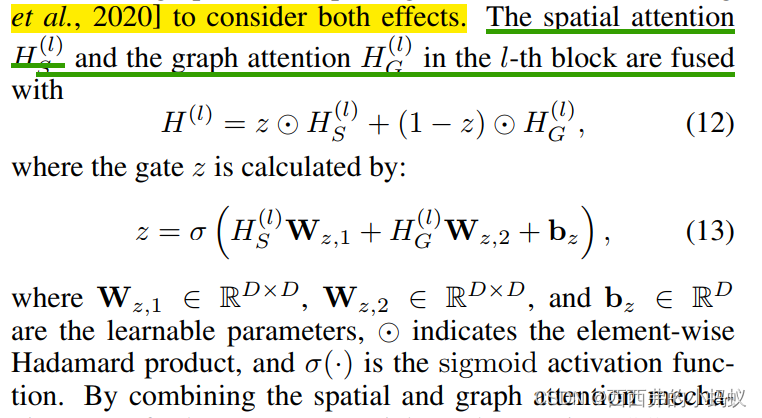

Gated Fusion

该研究针对长期时空预测(LSTF)的挑战,提出了一种新的图神经网络框架。该框架包括图构建、动态多图融合和时空图神经网络三个组件。通过构建距离图、邻居图和功能图来捕获上下文信息,使用动态多图融合模块结合空间和图注意机制描述节点间相关性,并通过可训练的权值张量表示节点重要性。实验表明,这种方法在LSTF任务中显著提升了预测性能。

该研究针对长期时空预测(LSTF)的挑战,提出了一种新的图神经网络框架。该框架包括图构建、动态多图融合和时空图神经网络三个组件。通过构建距离图、邻居图和功能图来捕获上下文信息,使用动态多图融合模块结合空间和图注意机制描述节点间相关性,并通过可训练的权值张量表示节点重要性。实验表明,这种方法在LSTF任务中显著提升了预测性能。

647

647

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?