高维时间序列中的异常检测通常使用基于重构或基于预测的算法来解决,因为它们分别能够学习压缩数据表示和建模时间依赖性。然而,大多数现有方法忽略了特征之间的关系,这些信息在纳入模型时非常有用。本文提出融合稀疏自编码器和图网络(FuSAGNet),联合优化重构和预测,同时显式地对多元时间序列中的关系进行建模。该方法结合了稀疏自编码器和图神经网络,后者从前者学习到的稀疏潜表示以及通过循环特征嵌入学习到的图结构来预测未来的时间序列行为。在3个真实的信息物理融合系统数据集上的实验结果表明,所提方法提升了异常检测的整体性能,优于基线方法。此外,从高维时间序列中挖掘稀疏潜在模式提高了基于图的预测模型的鲁棒性。进行了可视分析,以研究循环特征嵌入和稀疏潜表示的可解释性。

注意:文中使用的方式:将图卷积网络和稀疏自编码器结合起来,实现异常检测。这与传统的异常检测方法:重构,没有什么差别

阅读者总结:这篇论文的创新点在于将预测与异常检测结合起来,结合点在于把异常检测过程的隐藏变量和GCN结合起来,实现联合loss。这点是很值得学习的,之前的多元时间序列异常建模中很少考虑采用图神经网络。

2)文中采用稀疏编码的原因,阅读者不太理解,为什么本文在学习隐藏变量时,采用这种方法,虽然文中给了一个解释,但是很显然没有办法体现,采用这种方法的好处。

3)至于文中使用的GCN,按照之前AAAI20上的模型构造,只是融入了重构部分的隐藏变量。

挑战:

Problem Formulation

Problem Formulation

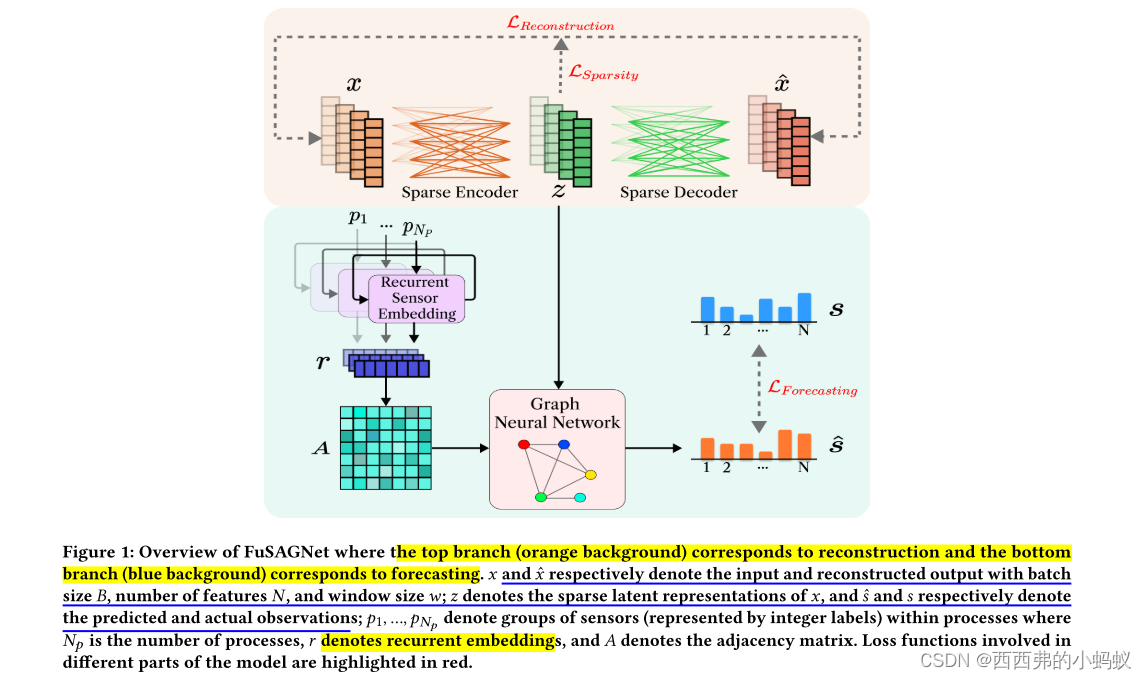

框架:

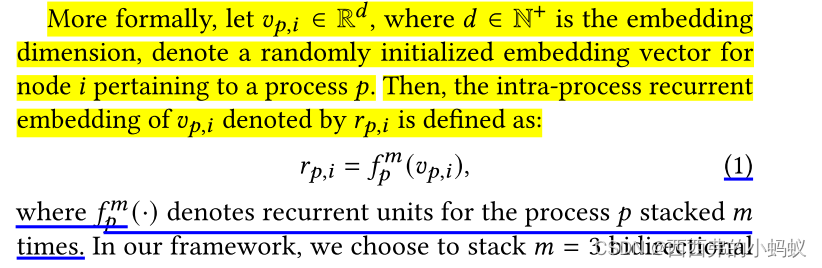

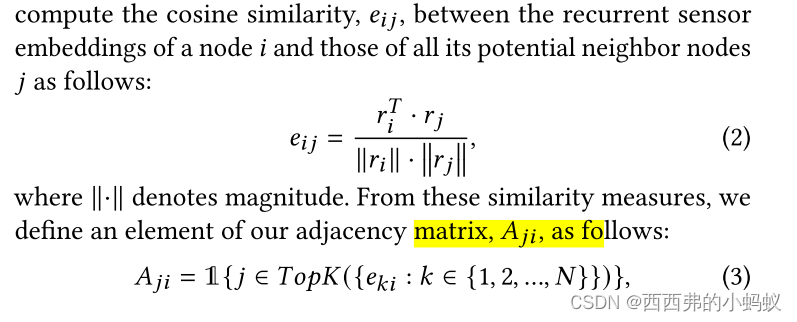

3.3 Graph Structure Learning

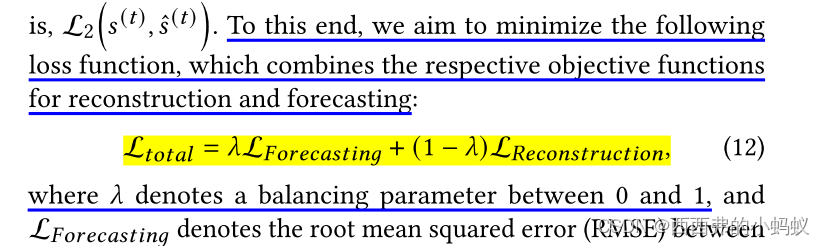

3.4 Sparsity-Constrained Joint Optimization

首先,利用SAE从高维时间序列中提取非平凡(即稀疏和潜在)特征,将其作为解码器的输入进行重建,并作为GNN的输入进行预测。

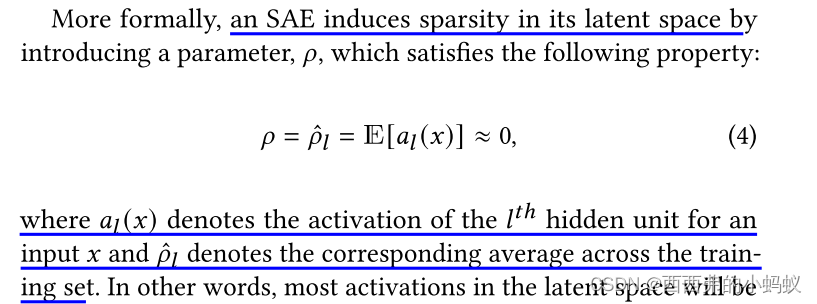

1)Sparse Autoencoder (SAE) for Sparse Latent Representation Learning.

SAEs允许隐藏空间至少与输入空间一样大,而不会影响有效的表示学习[22]。

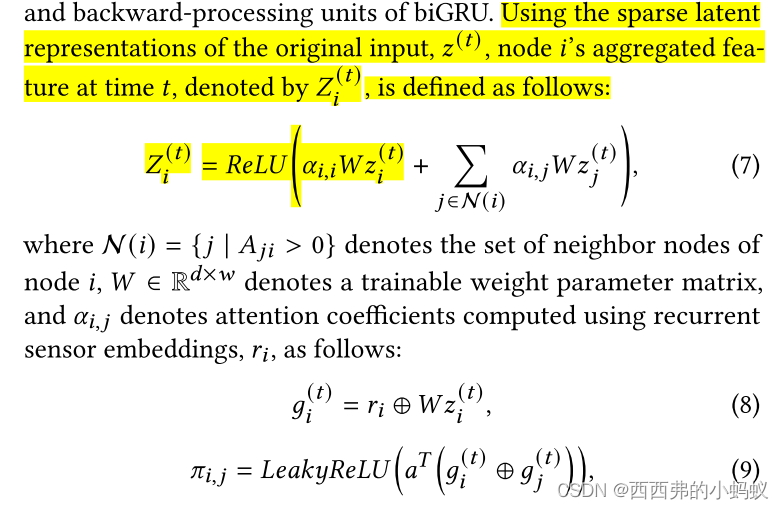

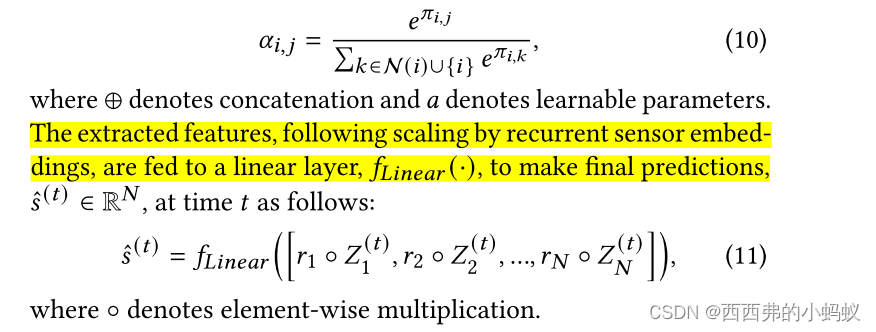

2)Graph Attention-Based Forecasting.

上面这部分是将隐藏参数和GCN结合起来。

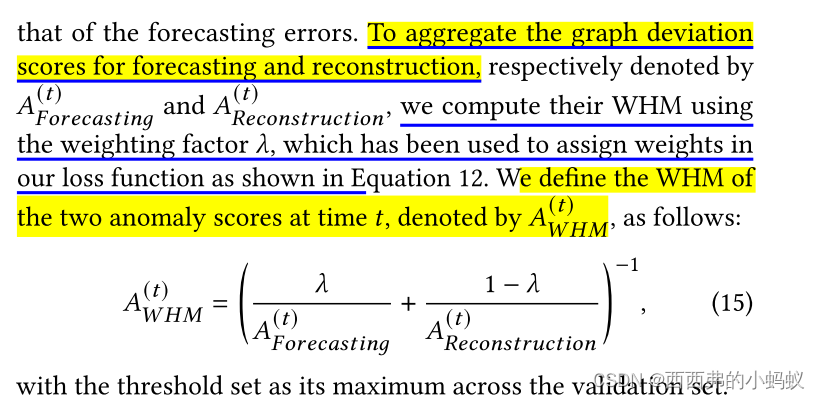

Anomaly Scoring

实验部分跳过............

699

699

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?