Search to aggregate neighborhood for graph neural network

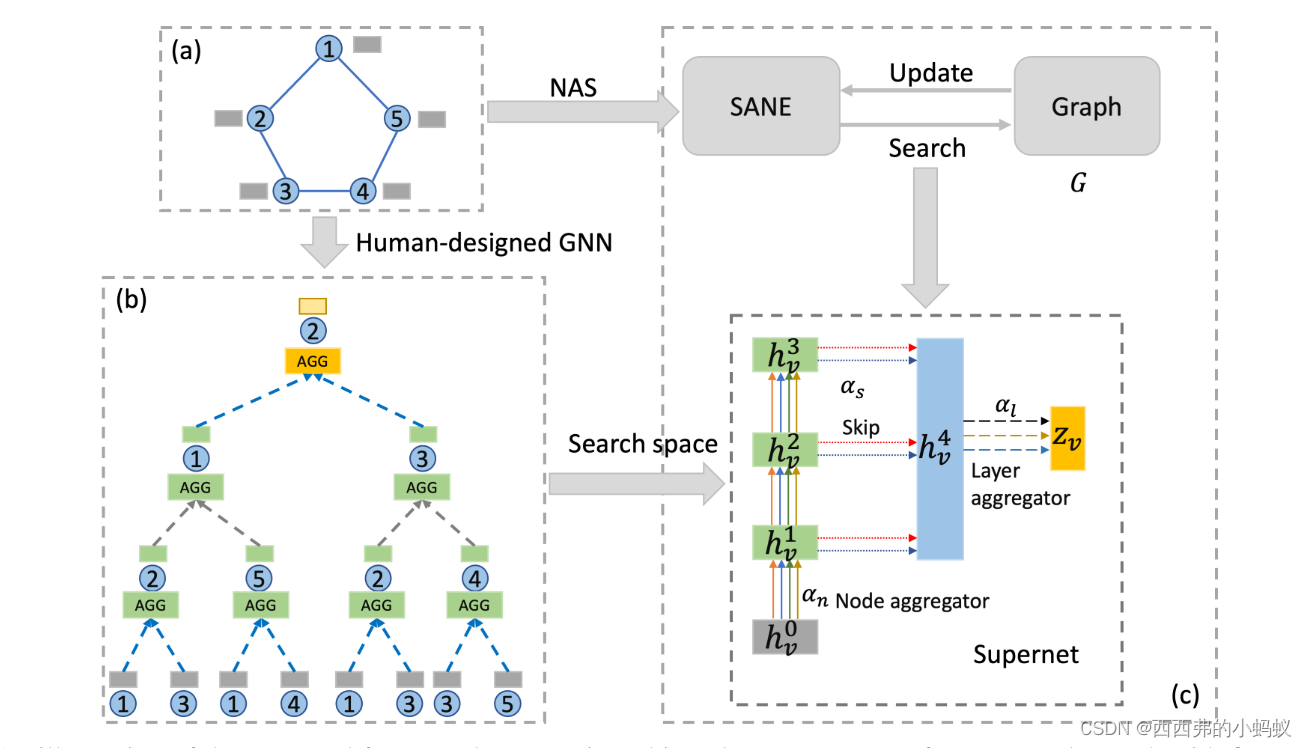

近年来,图神经网络(GNN)在各种场景中得到了普及和成功。为了获得特定于数据的GNN架构,研究人员转向了神经架构搜索(NAS),它在发现卷积神经网络中的有效架构方面取得了令人印象深刻的成功。然而,由于现有NAS方法在搜索空间设计上的挑战和昂贵的搜索成本,将NAS方法应用于GNN并非易事。本文提出一种框架,试图搜索到聚集邻域(SANE),以自动设计数据特定的GNN架构,以获得数据特定的GNN架构,并解决NAS方法面临的计算挑战。通过设计一个新颖的、富有表现力的搜索空间,提出了一种可微的搜索算法,比以往的基于强化学习的方法更高效。在4个任务和7个真实数据集上的实验结果表明,与现有的GNN模型和NAS方法相比,SANE在有效性和效率方面具有优越性。

一研究问题:

phNAS和Auto-GNN中这种简单的搜索空间设计有两个问题。第一种是没有包括各种GNN架构,例如GeniePath[18]或JK-Network[17],因此最佳性能可能不太好。第二,它通过在搜索空间中合并太多的超参数,使GraphNAS/Auto-GNN中的架构搜索过程过于昂贵。在NAS文献中,如何设计一个既具有足够的表达能力(大)又具有足够的紧凑性(小)的搜索空间,从而在精度和效率之间取得良好的平衡,仍然是一个具有挑战性的问题。

二 研究内容

为解决架构和计算挑战,本文提出一种新的NAS框架,试图搜索聚合邻域(SANE)以实现GNN中的自动架构搜索。通过重新审视广泛的GNN模型,定义了一个新的和富有表现力的搜索空间,可以模拟比现有NAS方法更多的人类设计的GNN架构,即GraphNAS和Auto-GNN。为了加速搜索过程,采用了先进的oneshot NAS范式[27],并设计了一种可微搜索算法,训练一个包含所有候选架构的超级网络,从而大大降低了计算成本。

2482

2482

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?