一.下载AnythingLLM

选择对应的Windows版本

二.前置配置

1.安装后打开

第一步他会让你选一个模型

它可以用开源的本地大模型,也可以用闭源的商用大模型

如openai的,只要填入API key就可以了

这里我们先选本地的ollama

ollama model选择自己下载的任意一个即可,下一步,下一步,

都是默认配置即可

最后输入一个任意的workspace的名称

workspace也是它的一个好处:

它把不同的知识库分隔成一个个的工作区

2.进来之后他会欢迎一下,给你发一堆引导信息

首先我们要试试我们基础的模型对话行不行:

点击那个workspkank,输入问题等待回应

再设置一下语言,方便我们操作

点击屏幕左下方的扳手

把display language改成Chinese即可

返回聊天

现在我们问他

显然回答有些落后了

三.嵌入知识库

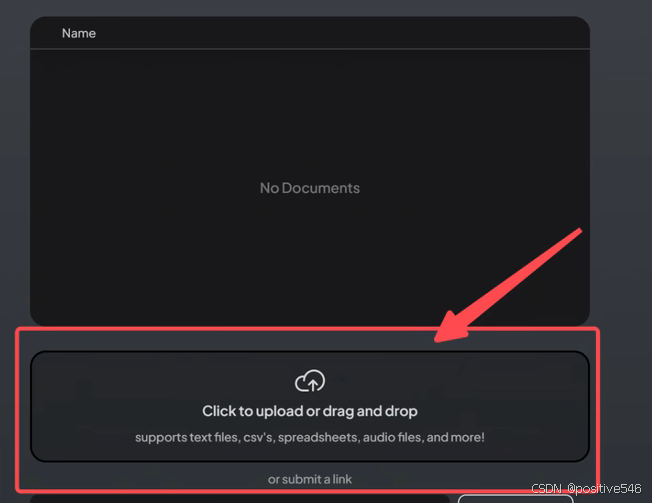

选择一个workspace,点击上传按钮

这个地方就是我们上传本地知识库的地方

1.嵌入文件

可以选择上传文件(尽量文件名不要含中文)

上传后

点击move to workspace

点击save and embed

右边即是该workspqce的知识库列表

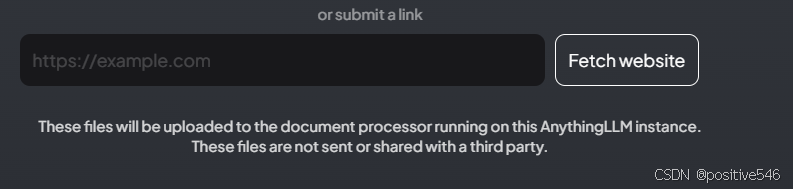

2.嵌入网站

将网址放入输入框,点击右边按钮

与上面嵌入文件类似

选择系统生成的html文件,点击move to workspace

点击save and embed

即可嵌入网站(但由于网站的内容可是很规范的文本格式,可能大模型学习效果没那么好)

这里我选择了苹果的官网Apple (中国大陆) - 官方网站

可以看到嵌入网站还是有用的

四.其他功能

1.固定文档

在右边知识库的每一项列表中可以发现一个按钮

当首次点击时会弹出窗口提示

英文的大致意思是:

文档固定(Document pinning)是什么?

在AnythingLLM(一个大型语言模型或相关平台)中,当你固定(pin)一个文档时,我们会将整个文档的内容注入到你的提示窗口(prompt window)中,以便你的大型语言模型(LLM)能够完全理解它。这种方法最适合用于大型上下文模型或对其知识库至关重要的小文件。

如果你在使用AnythingLLM时没有得到你想要的默认答案,那么固定文档是一个很好的方式,只需点击一下就能获得更高质量的答案。

感觉大概意思是当你输入问题没有得到好的回答后,固定你的知识库文档可以获得更好的答案。即点击后它更会根据你的知识库文件来进行上下文回答,经过我的尝试发现有时候确实会有用,但不是说你固定文档他就百分百按照文档来,毕竟不可能智能到这种程度

上面两个回答分别是我在上传武器.json和书籍.json文件后并把它们固定到工作区后回答的正确答案

上面两个回答分别是我在上传武器.json和书籍.json文件后并把它们固定到工作区后回答的正确答案

2.api 密钥

可以创建api key 后续应该可以调用

3.ai代理

具体可以查看官方文档AI Agent Usage ~ AnythingLLM

424

424

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?