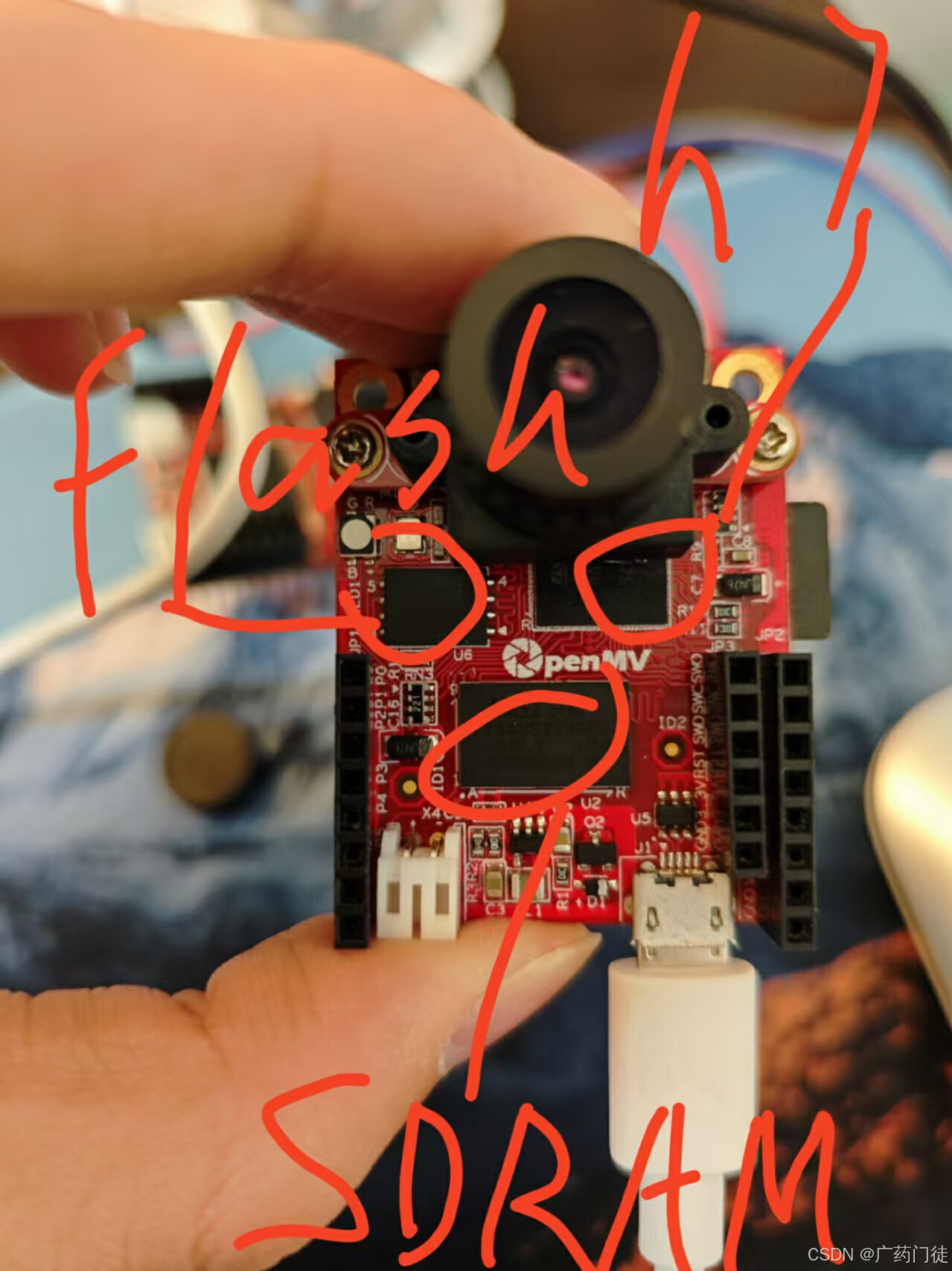

这个报错就是内存不够用了,就算你装了sd卡一样跑不了大内存模型,因为sd卡假装的是flash闪存不是内存,加之h7的芯片是vbt6本身就比plus的vit6 ram小 还没外加更运行不了了

The Plus model adds 32 MB of SDRAM and another 32 MB of flash, which is a pretty big addition to the 1 MB RAM and 2 MB flash on the non-plus version. (source: https://openmv.io/products/openmv-cam-h7-plus 49)

总的来说就是plus加了sdram 和flash 会比h7大很多

下面是h7 plus

下面是h7

因为sdram更大,plus可以跑内存更大的程序,比如600k的深度学习等模型

4738

4738

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?