强化学习在控制和决策任务展现了强大的能力,然而其存在样本利用率低、奖励函数设计难、泛化性差的问题,这些问题限制了强化学习在现实场景中的大规模应用。近年来,随着参数规模的扩大和训练数据量的增加,大语言模型(LLM,简称大模型)展现出了卓越的语义理解、推理和规划能力。将大模型与强化学习相结合,以克服强化学习所固有的挑战,正成为一个值得深入研究的前沿课题。

概念和研究背景

强化学习是一种通过与环境交互来学习最优策略的机器学习方法,广泛应用于机器人控制、游戏策略、自动驾驶等领域。然而,强化学习在实际应用中面临一些显著挑战。首先,样本利用率低是一个主要问题,强化学习算法通常需要大量的交互数据才能学到有效的策略,这在实际应用中可能导致高昂的时间和计算成本。其次,奖励函数的设计难度大,不同任务需要特定的奖励函数来引导学习过程,而设计出有效的奖励函数往往需要丰富的领域知识和大量的实验调试。最后,强化学习模型的泛化性差,在训练环境之外的实际场景中,模型的表现往往不尽如人意。

近年来,随着计算能力的提升和大规模数据的积累,大模型得到了迅速发展。大模型通过海量的训练数据和复杂的参数结构,展现出了强大的语义理解、推理和规划能力。这些模型不仅能处理自然语言处理任务,还能通过语言描述实现复杂任务的规划和执行。因此,将大模型与强化学习相结合,成为一种新的研究方向,希望通过大模型的优势来克服强化学习中的固有问题。

相关研究梳理

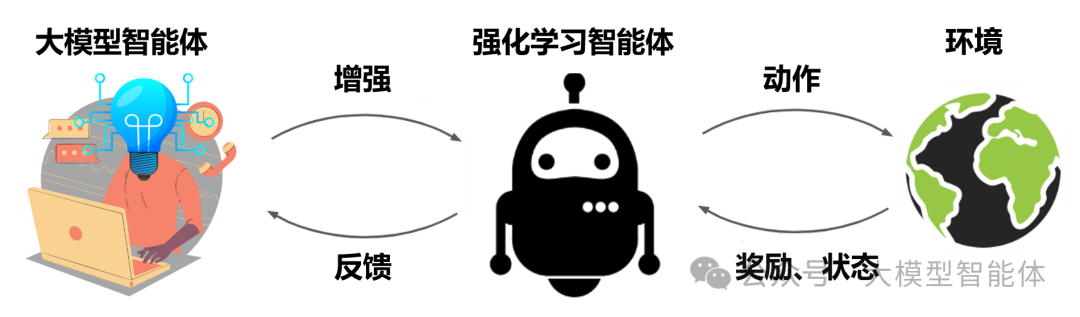

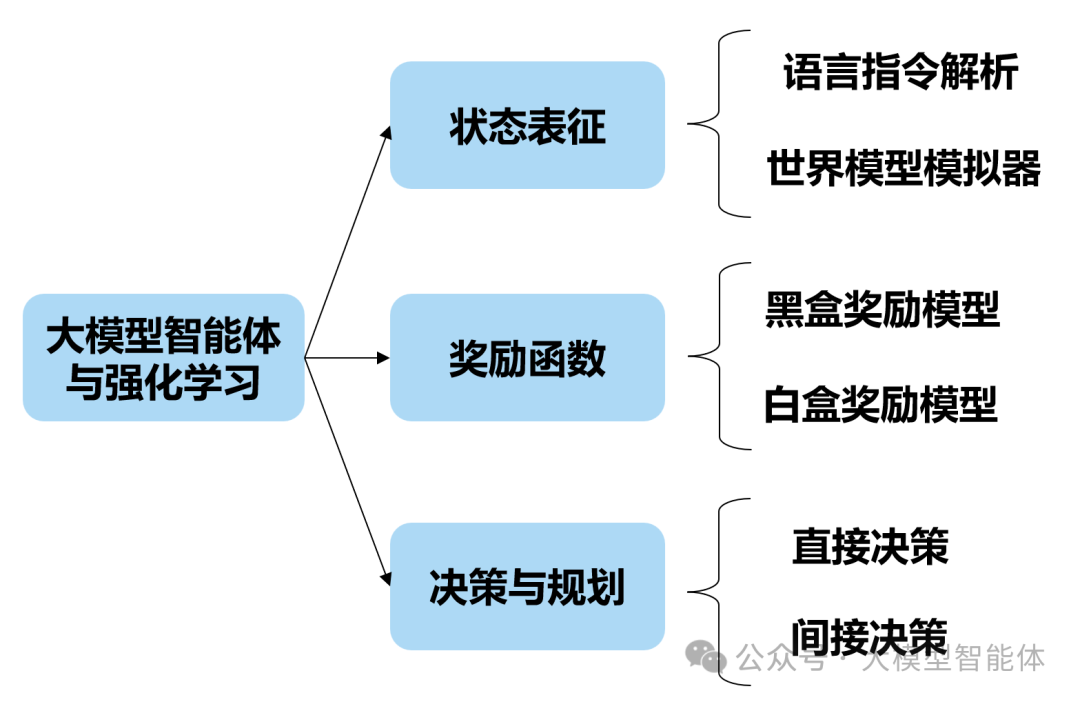

当前大模型智能体与强化学习结合的工作主要可以分为三部分。首先,大模型基于语义理解能力和预训练预料中的世界知识,增强强化学习的状态表征。其次,大模型基于其预训练知识和上下文学习能力,设计强化学习的奖励函数。最后,大模型基于其推理规划能力,帮助强化学习进行决策与规划。

图1.大模型智能体与强化学习结合的分类框架

相关文献综述参考:

[1] Cao Y, et al. Survey on large language model-enhanced reinforcement learning: Concept, taxonomy, and methods[J]. Preprint 2024.

[2] Pternea M, et al. The RL/LLM Taxonomy Tree: Reviewing Synergies Between Reinforcement Learning and Large Language Models[J]. Preprint 2024.

大模型增强状态表征

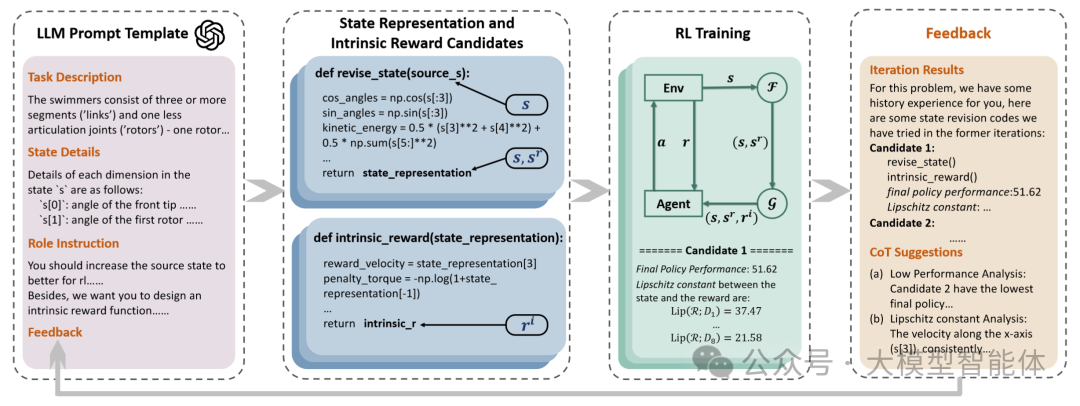

大模型增强状态表征的工作可以分为两种,一种是利用大模型的语言指令解析[3,4,5]能力,传统强化学习难以从状态中表征出任务相关的信息,大模型将任务环境信息转化为结构化的表示,提升强化学习智能体对于任务环境的理解;另一种是利用大模型强大的建模能力和世界知识,把大模型作为世界模型模拟器[6,7],预测下一个状态和奖励,从而提升强化学习的样本效率。

利用大模型语言指令解析能力的研究中,以工作[5]为例,其利用大模型的先验知识和推理能力,以任务场景描述、状态变量说明、智能体角色属性和self-refine的反馈作为大模型输入,大模型生成与任务场景和物理机制相符的状态表征代码,强化学习算法基于大模型提供的状态表征代码进行状态处理,并将训练结果反馈给大模型,大模型结合self-refine机制根据反馈调整状态表征代码的生成。

图2.大模型基于语言指令生成状态表征代码 [3]

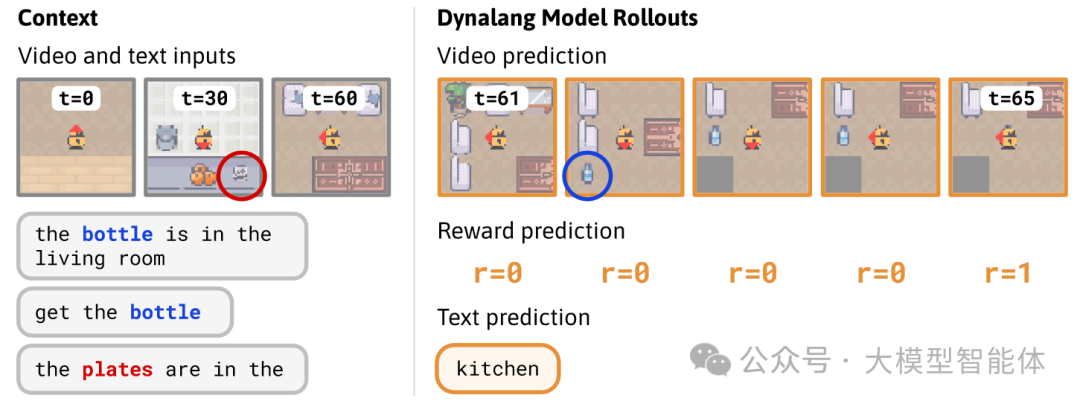

另外,一些研究把大模型作为世界模型模拟器,例如工作[6]学习多模态世界模型来预测环境中未来的文本和图像表示,强化学习智能体根据想象的未来世界表示来进行决策,从而大幅提升样本利用效率。

图3.大模型作为世界模型模拟器 [6]

[3] Pang J C, et al. Natural Language-conditioned Reinforcement Learning with Inside-out Task Language Development and Translation[J]. Preprint 2023.

[4] Basavatia S, et al. STARLING: Self-supervised Training of Text-based Reinforcement Learning Agent with Large Language Models[J]. arXiv Preprint 2024.

[5] Wang B, et al. LLM-Empowered State Representation for Reinforcement Learning[C]. ICML 2024.

[6] Jessy Lin, et al. Learning to Model the World with Language. ICML 2024.

[7] Seo, Younggyo, et al. “Masked world models for visual control.” CoRL, 2023.

大模型设计奖励函数

奖励函数对指导强化学习智能体的训练非常重要,但是,高性能的奖励函数设计是非常困难的,需要非常大量的专家知识和人力成本。大模型能够利用其预训练的知识和上下文学习能力,高效地设计RL的奖励函数。

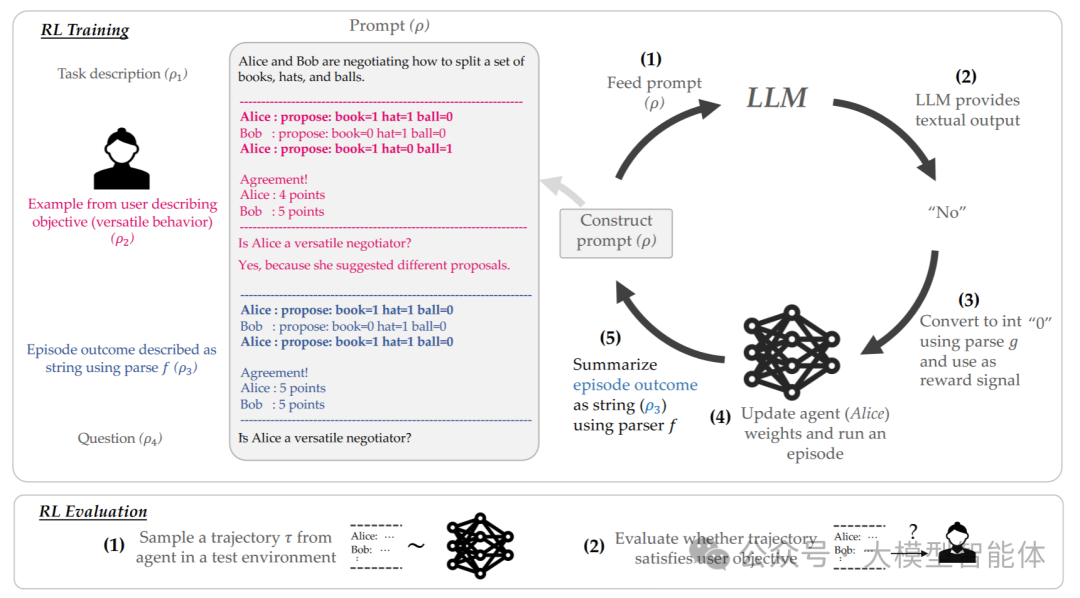

具体而言,有若干现有研究[8,9]将大模型作为黑盒形式的奖励函数模型,也就是奖励函数的具体形式是未知的。以研究[8]为例,大模型根据用户的目标需求,对强化学习智能体的轨迹打分。具体而言,大模型的输入提示词包括任务描述、用户指定目标、强化学习智能体历史轨迹,接着大模型根据其先验知识和推理能力,判断智能体轨迹是否满足用户指定目标并打分;然后强化学习将大模型的打分作为奖励函数进行训练,训练结果反馈给大模型,大模型再调整其生成的奖励函数。

图4.大语言模型作为黑盒奖励模型 [8]

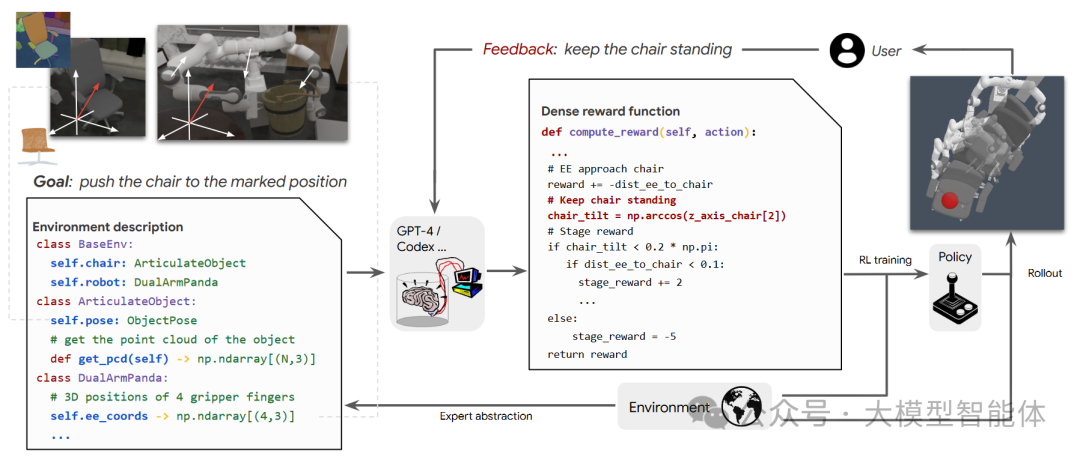

除此以外,还有若干研究[10,11]将大模型作为白盒奖励模型,利用大模型对物理机制的理解和写代码的能力,让大模型明确写出奖励函数的定义代码,更透明地供人类阅读和理解。

图4.大模型通过写代码设计奖励函数 [10]

总之,利用大模型预训练的知识和上下文学习能力,能实现自动化且比专家更有效的奖励函数设计。

[8] Kwon M, et al. Reward design with language models[J]. ICLR 2023.

[9] Wu Y, et al. Read and reap the rewards: Learning to play atari with the help of instruction manuals[J]. Neurips 2024.

[10] Xie T, et al. Text2Reward: Reward Shaping with Language Models for Reinforcement Learning[C]. ICLR 2023.

[11] Song J, et al. Self-refined large language model as automated reward function designer for deep reinforcement learning in robotics[J]. Preprint 2023.

大模型赋能决策与规划

利用大模型的预训练世界知识以及涌现的推理规划能力,可以帮助强化学习进行动作决策,一方面是直接决策,大模型可以直接作为策略生成器,直接生成强化学习的动作;另一方面是间接决策,大模型可以作为专家,生成候选动作,指导强化学习的动作选择。

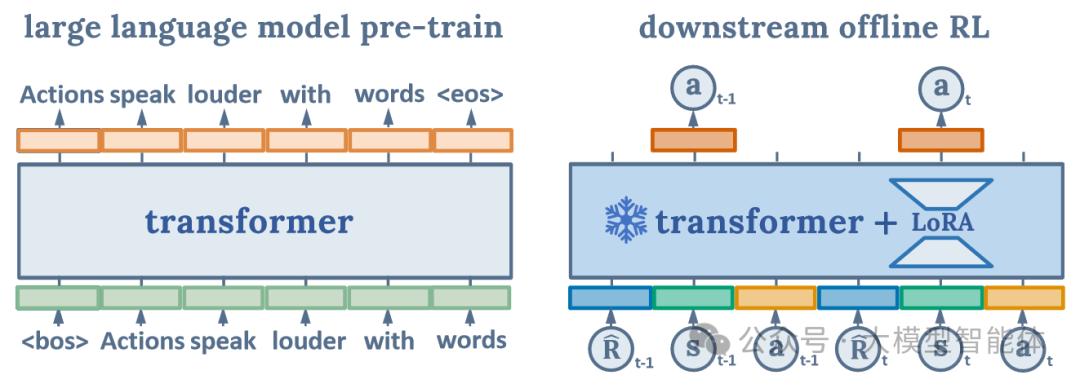

直接决策方面,一些研究[12,13,14]将大模型作为策略生成器,通过微调预训练大模型,进行离线强化的训练,利用大模型的预训练知识,提升离线强化学习的泛化性。以工作[13]为例,将大模型作为预训练模型,从而利用大模型中的预训练世界知识来弥补离线强化学习样本量不足的缺点;将离线轨迹策略拼接成序列,利用LoRA(低秩适应)来高效地微调大模型;并在训练离线强化学习的同时,进行语言的预训练辅助任务,从而避免过拟合。

图5.大模型作为策略生成器 [13]

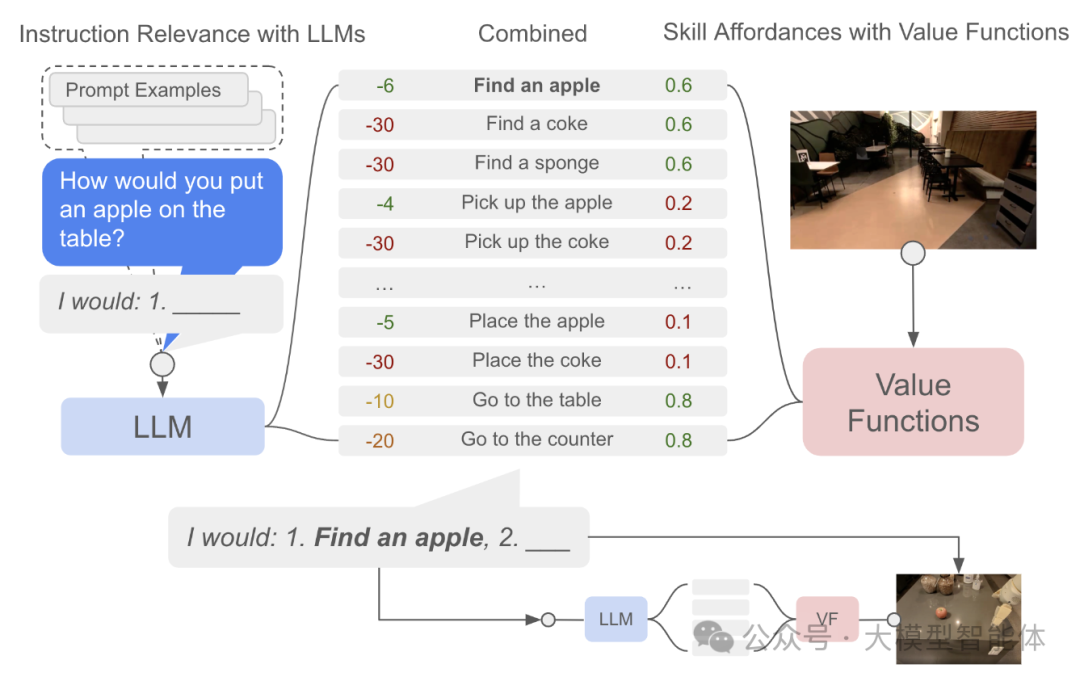

间接决策方面,相关研究[15,16,17]利用大模型的推理和规划能力,生成后续动作或者分解任务指令,减小强化学习的动作探索空间。以研究[16]为例,大模型具有丰富知识和高层次的技能,但是却难以实现低层次的与真实世界的交互,而强化学习擅长的恰恰和大模型相反,因此该工作将强化学习的低层次技能与大模型的高层次经验结合。大模型以任务指令作为输入,输出完成任务相关的技能以及相应的概率;强化学习智能体则在环境中执行这些技能动作,并利用价值函数来学习不同技能对于成功完成任务的概率。

图6.大模型作为专家指导候选动作 [16]

[12] Li S, et al. Pre-trained language models for interactive decision-making[J]. Neurips 2022.

[13] Shi R, et al. Unleashing the power of pre-trained language models for offline reinforcement learning[J]. Preprint 2023.

[14] Brohan A, et al. Rt-2: Vision-language-action models transfer web knowledge to robotic control[J]. Preprint 2023.

[15] Yao S, et al. Keep calm and explore: Language models for action generation in text-based games[J]. Preprint 2020.

[16] Ahn M, et al. Do as i can, not as i say: Grounding language in robotic affordances[J]. Preprint 2022.

[17] Dasgupta I, et al. Collaborating with language models for embodied reasoning[J]. Neurips workshop 2023.

未来展望

虽然近期的研究展现出大模型智能体能替换与增强强化学习的各个组件,但仍然有很多的研究契机和研究方向等待挖掘与实践。

首先,当前大模型增强强化学习的相关研究主要针对游戏场景和机器人控制场景,这些场景能较为容易的提取语言描述供大模型理解。但是,对于城市中的复杂调度场景,例如物流调度、网约车调度等,如何提取场景的语言信息让大模型理解,从而发挥大模型的推理和规划能力,帮助强化学习在这些场景进行任务拆分或者动作规划,是一个具有挑战性的研究方向。

其次,大模型设计奖励函数的工作主要针对单智能体强化学习,而多智能体合作的场景中,多个智能体只能得到一个共同的奖励函数,这其中存在信誉分配问题,难以区分智能体各自的贡献。能否利用大模型设计奖励函数的思路,为每个智能体设计各自的奖励函数,从而区分各个智能体的贡献,也是一个值得研究的方向。

另外,当前大模型作为世界模型的工作,也主要是基于游戏和机器人场景,对于更复杂的城市决策任务,如何纳入特定的领域知识,构造更复杂任务的世界模型,也是一个具有挑战性的方向。

最后,目前大模型智能体与强化学习结合的工作,主要是利用大模型智能体辅助强化学习决策,而如何利用强化学习来改进大模型智能体,是一个重要的未来研究方向。

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

观看零基础学习书籍和视频,看书籍和视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

1734

1734

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?