今天给大家推荐一个能发高区且不卷的思路:基于SAM做目标检测!

一方面,SAM才提出一年多,基于它做目标检测,还在蓝海阶段,创新机会很多!且在CVPR、NeurIPS等顶会上,也有不少成果供我们参考。比如性能飙升82.31%的SAM-PM;免训练的VL-SAM……

另一方面,它在提高检测准确性、泛化性等方面,具有不可替代的作用!与传统目标检测算法相比,SAM不仅能更准确、高效地分割出图像中的目标对象,还能处理复杂场景中的多个目标,这对提高检测性能大有裨益!更特别的是,它不需要事先知道目标类别,能应用于各种未知或新的目标检测任务,而无需重新训练或微调。

为让大家能够掌握领域的主流研究方法,早点发出顶会,我给大家准备了10种创新思路,原文和源码都有!

论文原文+开源代码需要的同学看文末

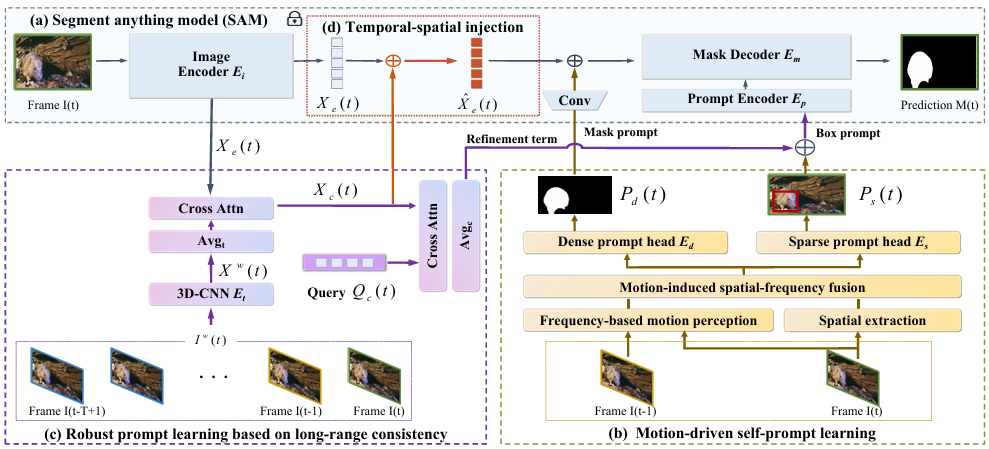

Endow SAM with Keen Eyes: Temporal-spatial Prompt Learning for Video Camouflaged Object Detection

内容:论文提出了一种名为TSP-SAM的新方法,用于视频伪装目标检测。该方法通过时间空间提示学习,赋予了SAM模型更敏锐的“视觉”,无需用户提供提示即可捕捉伪装目标的运动线索,并通过长程一致性增强自提示的鲁棒性,从而显著提高了检测精度。为了消除帧间不连续性导致的提示偏差,TSP-SAM考虑视频序列内的长程一致性,以增强自提示的鲁棒性。

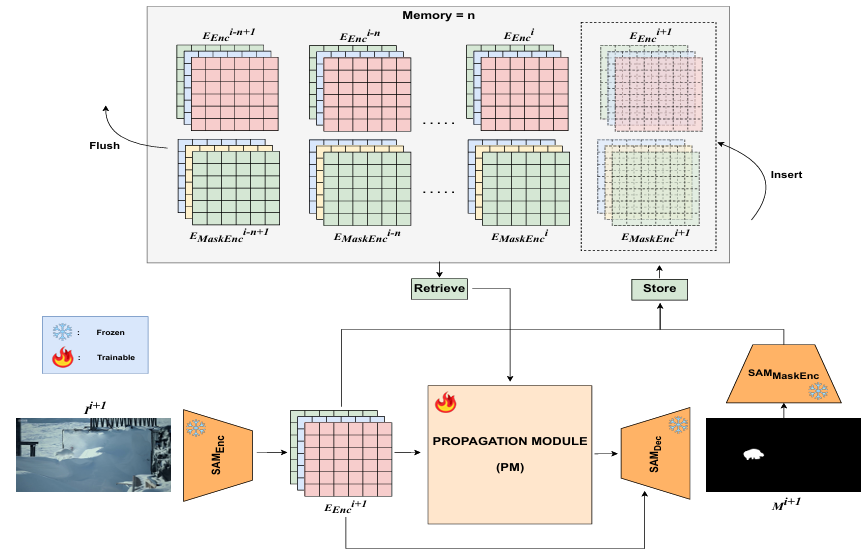

SAM-PM:Enhancing Video Camouflaged Object Detection using Spatio-Temporal Attention

内容:论文介绍了一种名为SAM-PM的方法,该方法通过利用时空注意力机制来增强视频伪装目标检测的性能。这种方法通过分析视频中的目标运动和空间特征,提高了对伪装目标的识别和分割能力。

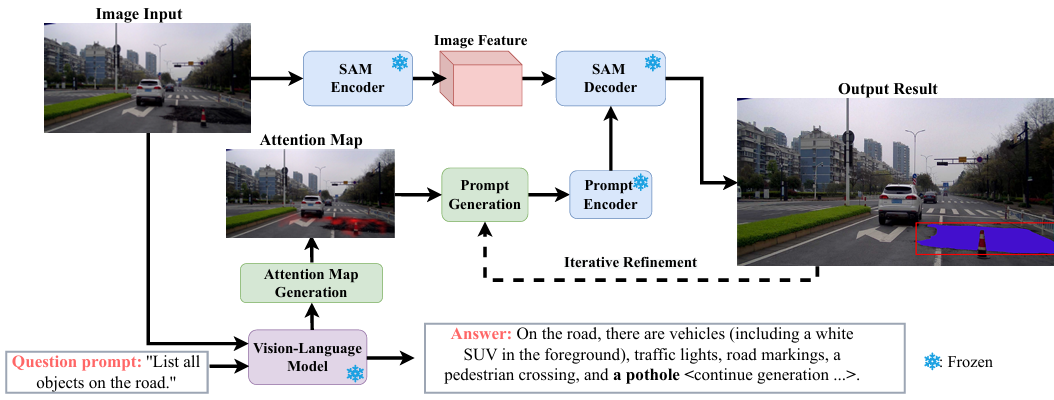

Training-Free Open-Ended Object Detection and Segmentation via Attention as Prompts

内容:论文介绍了VL-SAM,一个无需额外训练的框架,它结合了视觉语言模型(VLM)和分割任何事物模型(SAM)来解决开放性对象检测和分割任务。VL-SAM利用VLM生成的注意力图作为提示,指导SAM进行对象分割,通过头部聚合和正则化注意力流机制来聚合和传播注意力图,从而生成高质量的注意力图,并采用迭代细化策略来提高分割精度。

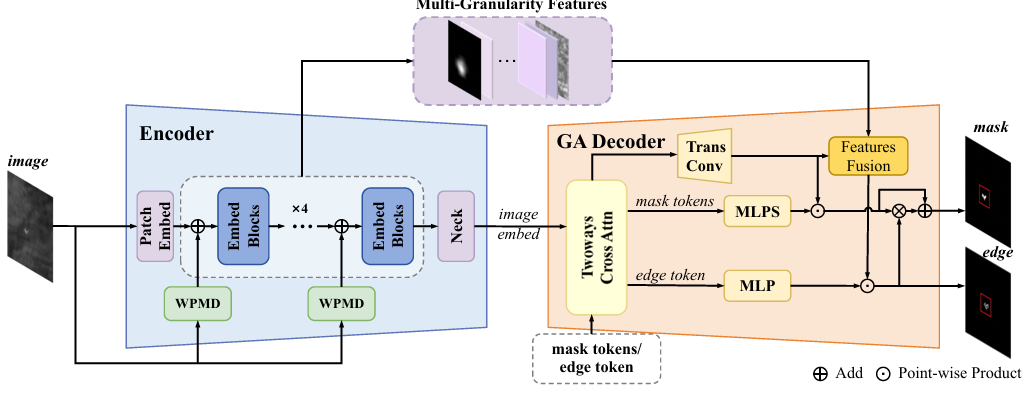

IRSAM: Advancing Segment Anything Model for Infrared Small Target Detection

内容:论文介绍了IRSAM模型,它是为了提高在红外图像中检测小目标的性能而设计的。IRSAM通过改进现有的SAM的编码器-解码器架构,增加了基于Perona-Malik扩散方程的模块和粒度感知解码器,以更好地捕捉红外小目标的特征。具体来说,IRSAM模型设计了一个基于Perona-Malik扩散的块,并将其合并到SAM编码器的多个级别中,这有助于在抑制噪声的同时捕捉基本的结构。

码字不易,欢迎大家点赞评论收藏!

关注下方《AI科研技术派》

回复【SAMO】获取完整论文

👇

813

813

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?