最近这一两周看到不少互联网公司都已经开始秋招提前批了。

不同以往的是,当前职场环境已不再是那个双向奔赴时代了。求职者在变多,HC 在变少,岗位要求还更高了。

最近,我们又陆续整理了很多大厂的面试题,帮助一些球友解惑答疑,分享技术面试中的那些弯弯绕绕。

今天分享我们一星球成员面试美团大模型面经:

一面

-

文档大模型是一个独立的模型,会整合到一个大模型还是分离式的

-

目前用的多大的模型

-

是一个什么结构,对结构的一些了解 flamingo或者blip2的结构上的对比

-

足够资源的情况下,哪个结构是最优的

-

分辨率是如何解决的,文档的分辨率比较高

-

QA对匮乏如何解决的

-

ocr的性能目前是低于多模态大模型

-

如何解决bbox感知力差的问题

-

充足的算力,数据如何获取,如何有效的清洗

-

fuyu这种结构有什么优化的空间

-

简单介绍下Transformer

-

大概讲一下Transformer的Encoder模块?

-

为什么transformer块使用LayerNorm而不是BatchNorm?

-

Transformer为何使用多头注意力机制?

算法题:手写multi-head attention;寻找两个正序数组的中位数 (LeetCode 4);只出现一次的数字 III (LeetCode 260)

二面

-

请描述BERT的微调过程及其重要性

-

解释什么是自注意力机制,以及它在BERT模型中的作用。

-

BERT与其它预训练模型(如GPT)有什么不同?

-

如何评估BERT模型在特定NLP任务上的性能?

-

如何解决BERT训练中的过拟合问题?

-

OCR文档大模型

-

Instruction tuning的决定性因素,哪些Instruction tuning策略效果更好,如何评估复杂度的性能

-

如何保证数据集的多样性和复杂度

-

分层的Instruction tuning数量的影响,数量和质量

-

不同类型数据的影响,对下游任务的影响,自动化的数据配比,自动化的指标去做类似的事情

-

专门优化的指标不再是一个好的指标

-

使用其他的指标来引导模型的优化,而不是使用下游的指标,LLM使用的loss,作为指标,而不是benchmark的分数

-

合理的评估指标是什么,openAI的压缩理论,training loss代表优化目标

-

AGI的几个阶段,deepmind发表

算法题:根据字符出现频率排序 (LeetCode 451); 只出现一次的数字 (LeetCode 136)

(完)

附上技术清单

在这里,我们想要强调的是:成功求职并不是一件难事,关键在于你是否做好了充分的准备。通过学习和掌握AI技术的相关知识和技能,了解面试中可能出现的问题和技巧,你就能够在面试中展现出自己的专业素养和实力,赢得面试官的青睐和认可。因此,让我们一起努力,用知识和技能武装自己,迎接AI时代的挑战和机遇吧!

有需要的朋友可以扫描下方二维码,免费获取更多相关资料!

最后,祝愿所有转行、求职的同学都能够在AI产品面试中取得优异的成绩,找到心仪的工作!加油!

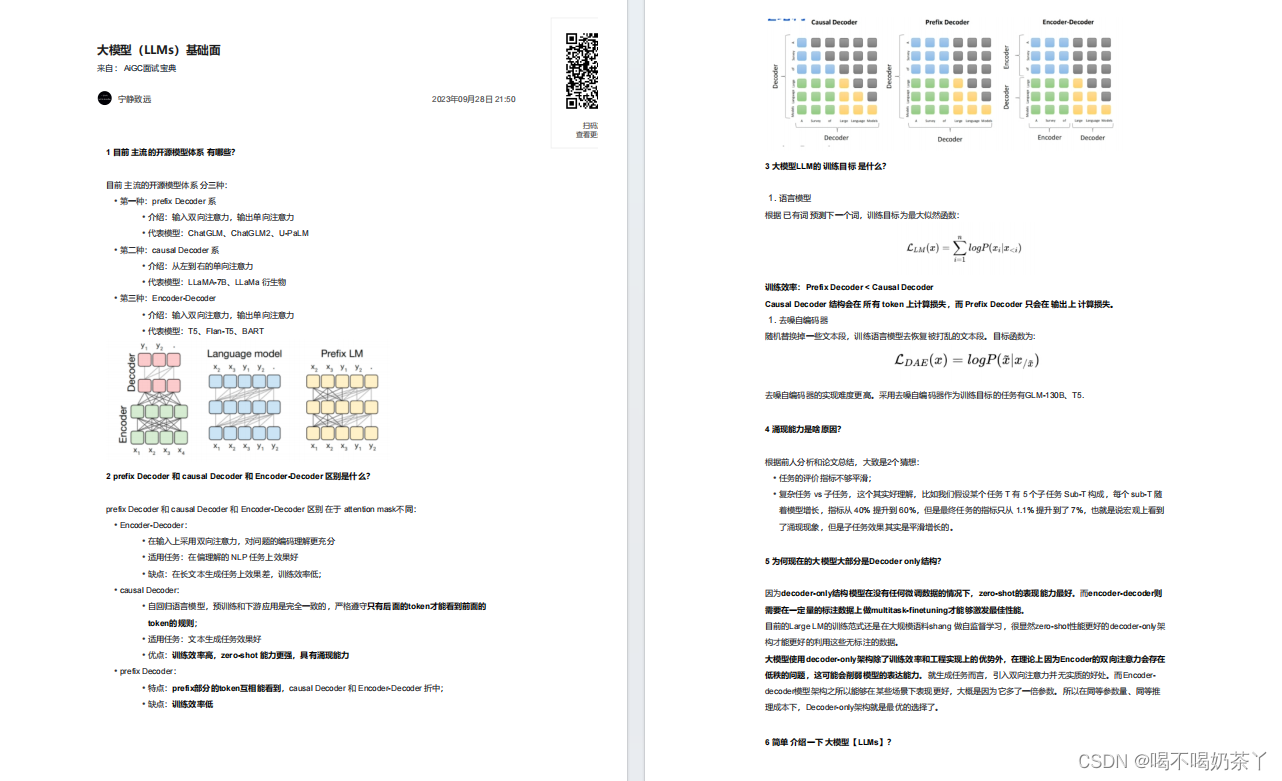

大模型基础面

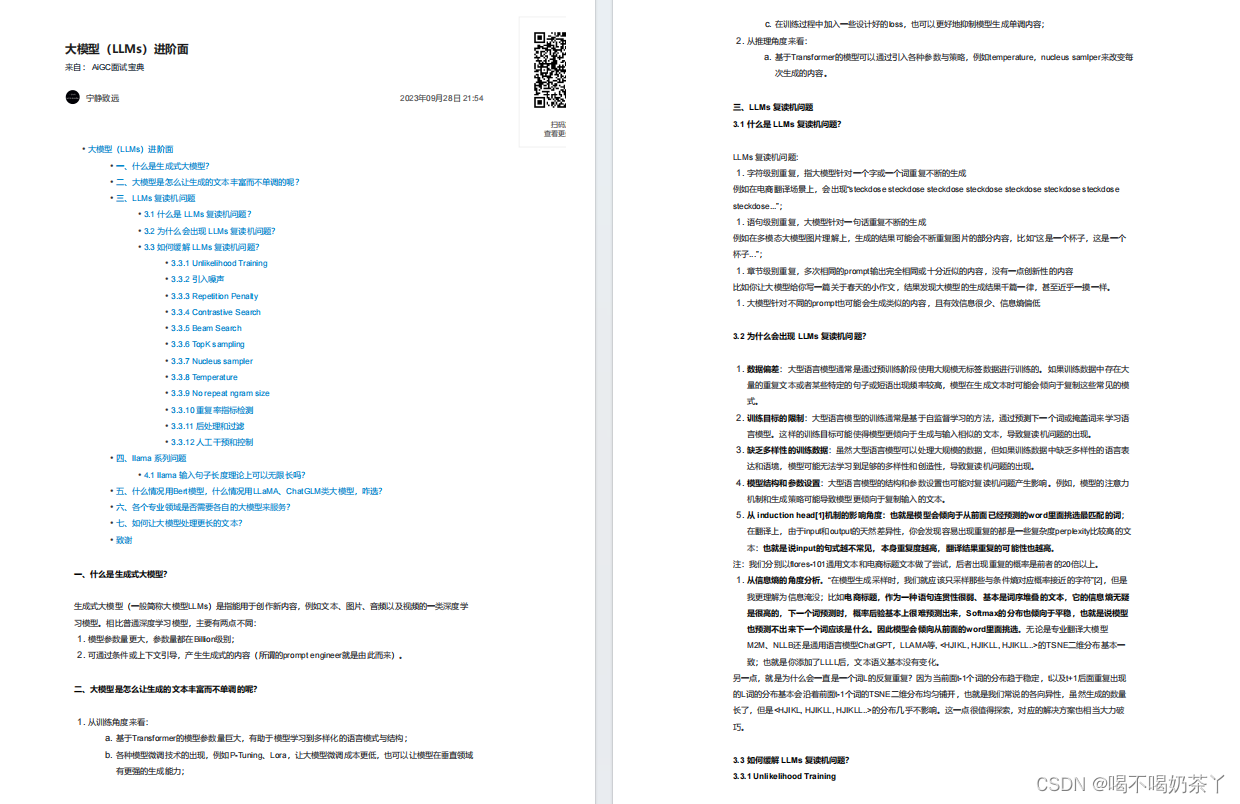

大模型进阶面

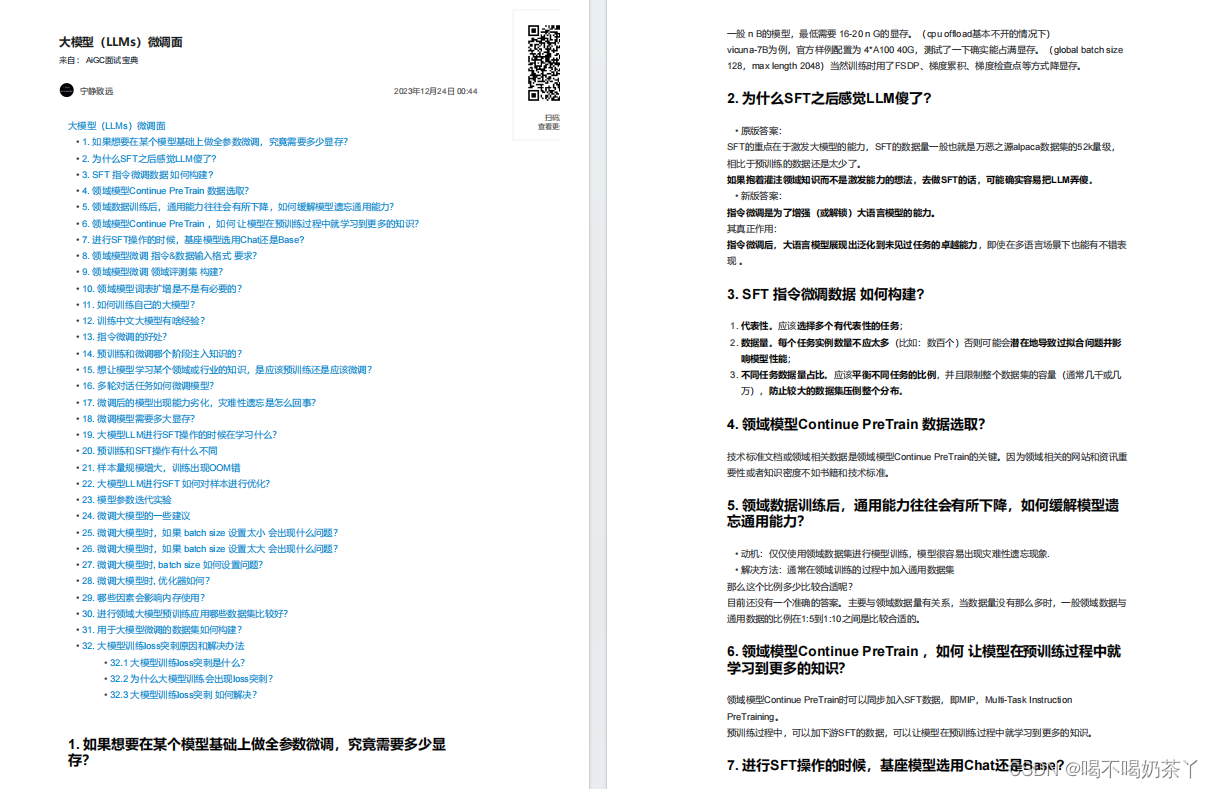

大模型微调面

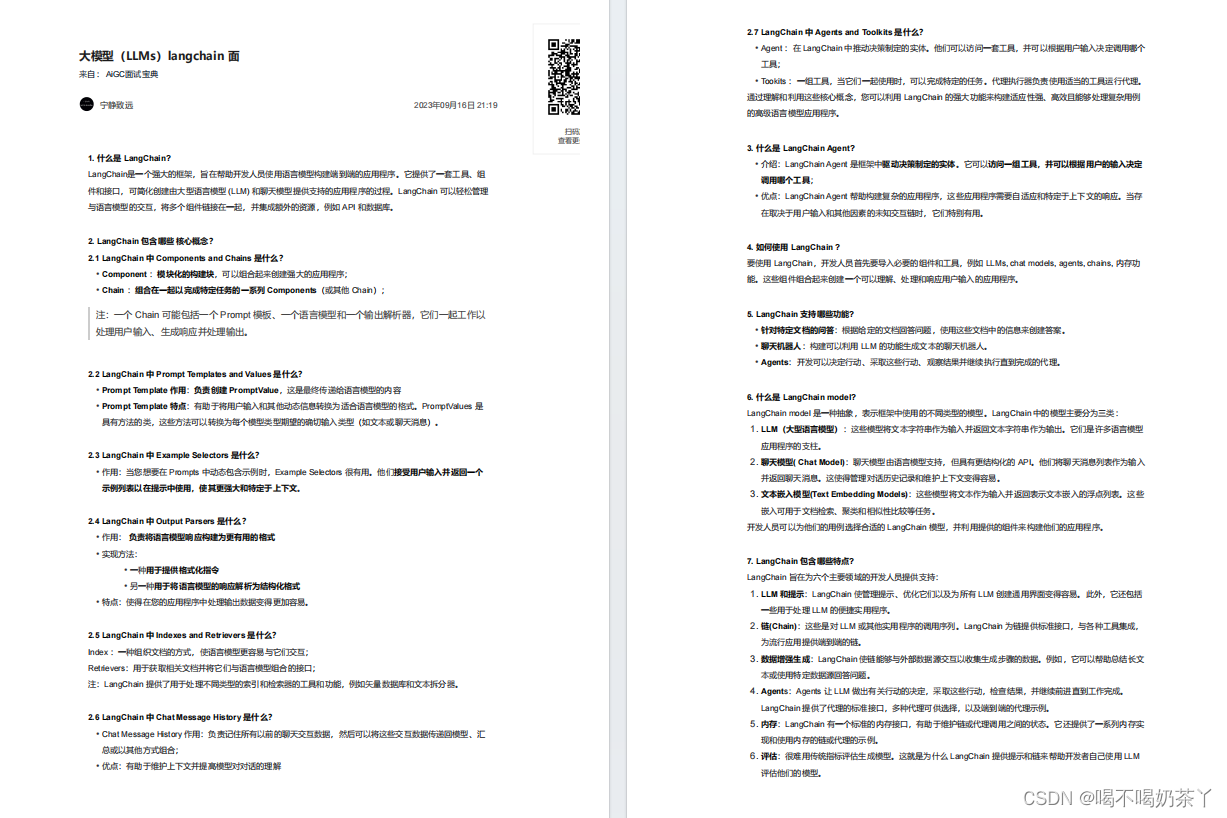

大模型langchain面

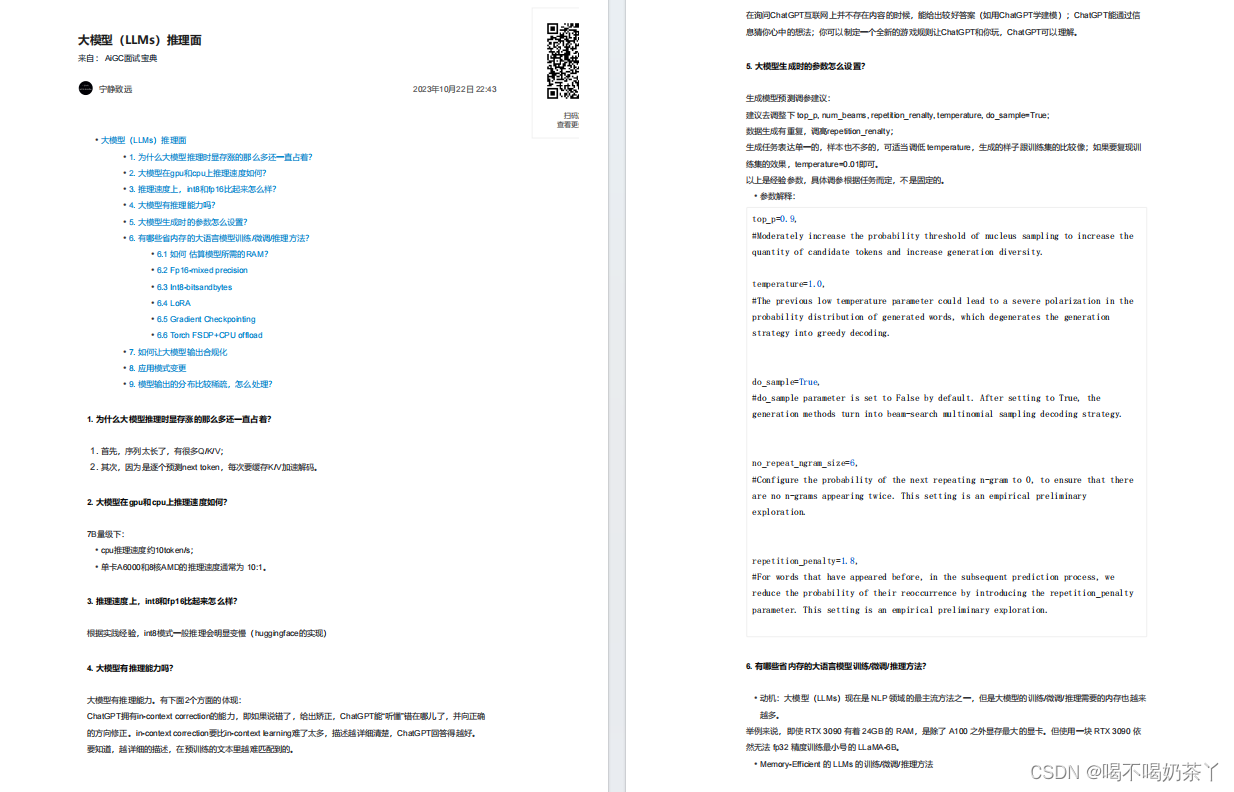

大模型推理面

更多面试题分享

998

998

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?