前言

前两天看到一位国外博主发的 图解Transformer编码器, 看完非常有启发,所以分享给大家一起学习。

这种形式可以让大家可以更直观的理解相关概念!(前提是大家需要对Transformer基础概念有一定的理解)

大家要想系统性了解 Transformer 的可以看看这篇文章

点击图片即可跳转到文章界面

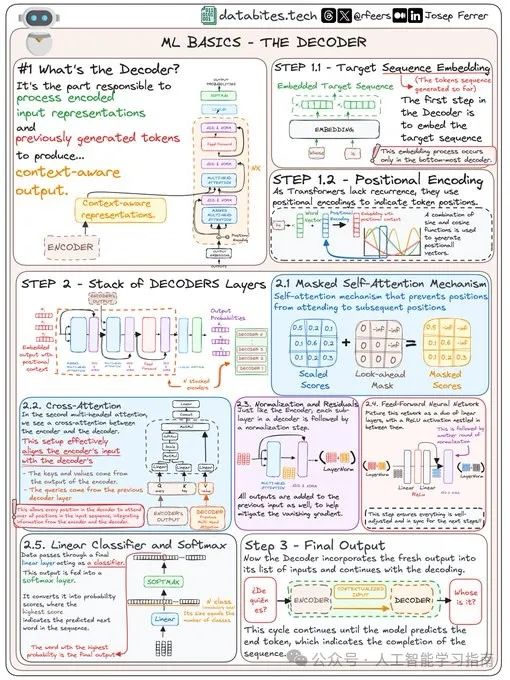

解码器是什么?

解码器是负责将编码后的输入和之前生成的标记转换为上下文感知输出的“大脑”。

想象一下,它就像是一位艺术家,根据草图绘制出最终的画面。

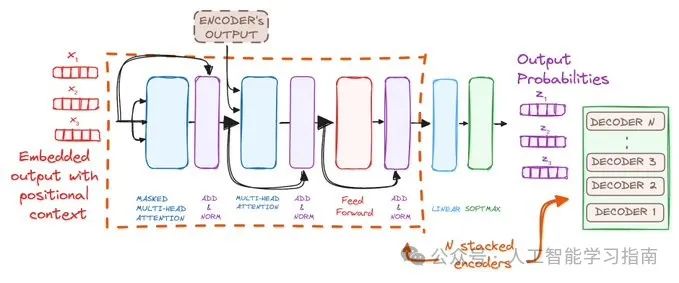

第一步 - 处理目标序列

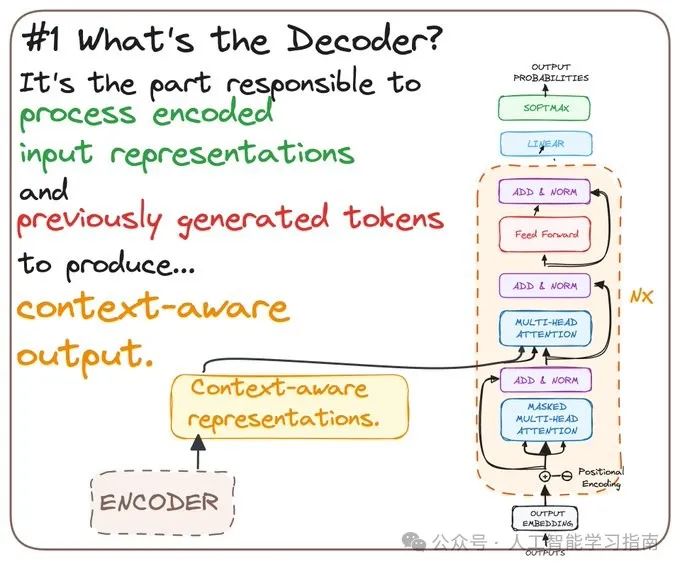

1.1 目标序列嵌入

解码器首先会将需要处理的序列进行嵌入,将原始数据转换成它能够理解的格式。

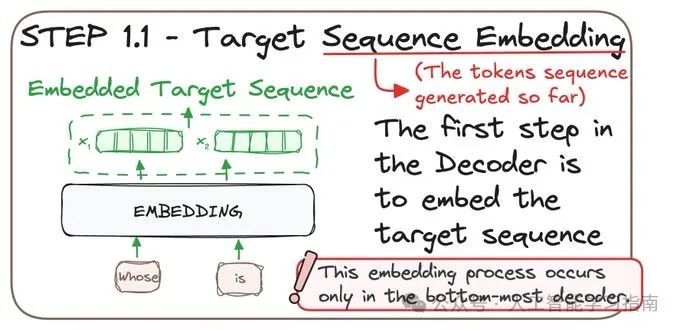

1.2 位置编码

由于Transformer不像旧模型那样依赖序列顺序,因此它使用位置编码。

这相当于在“是什么”的基础上增加了“在哪里”的信息,对于全面理解序列上下文至关重要!

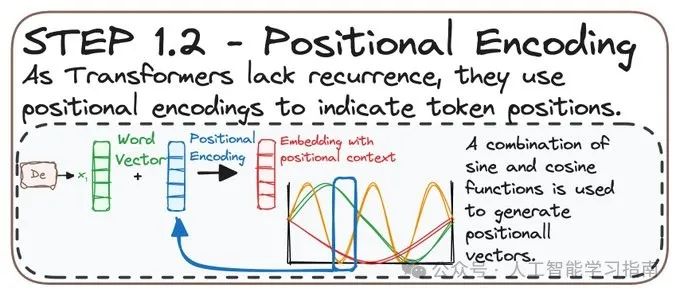

第二步 - 解码器分层处理

解码器由多个层组成,每个层都会优化输出:

-

掩码自注意力

-

交叉注意力

-

归一化和残差

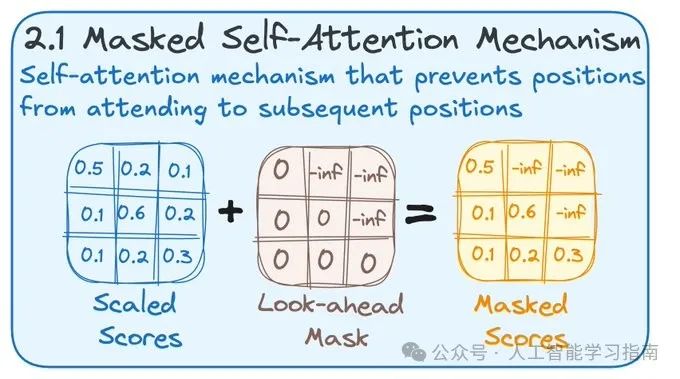

2.1 掩码自注意力

在自注意力步骤中,解码器确保不会“偷看”未来的信息。这就像解拼图时,不跳过前面的部分直接看全图。

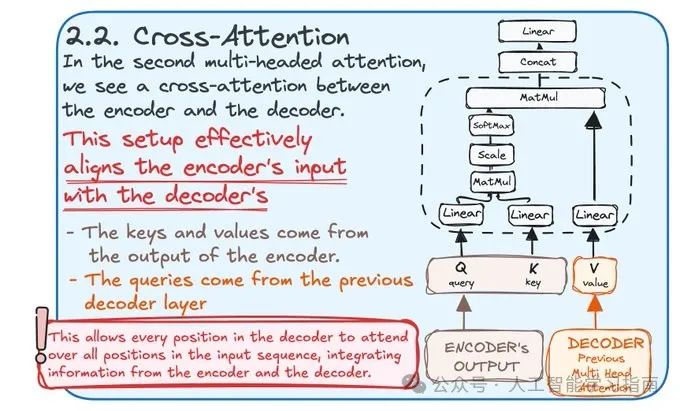

2.2 交叉注意力

在这里,解码器将编码器的输入与其处理过程对齐,确保每条信息都完美同步。

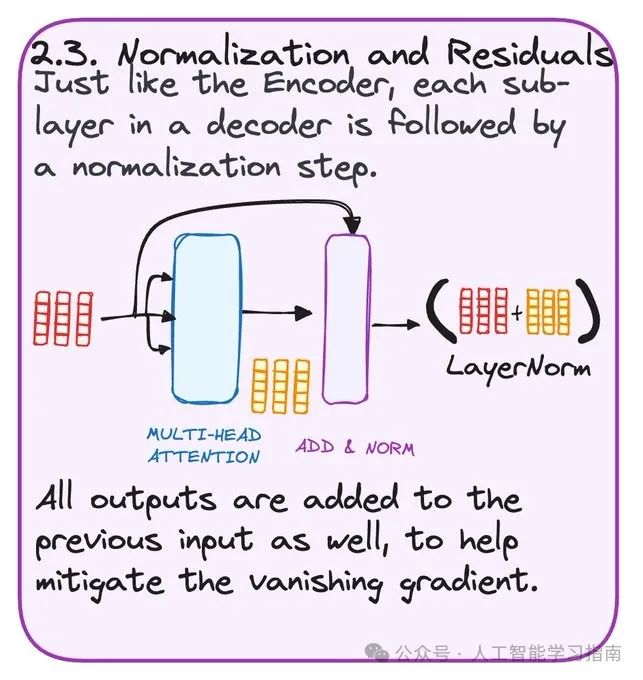

2.3 归一化和残差

归一化保持数据的平滑和统一,防止任何部分过于突出而压倒其他部分。

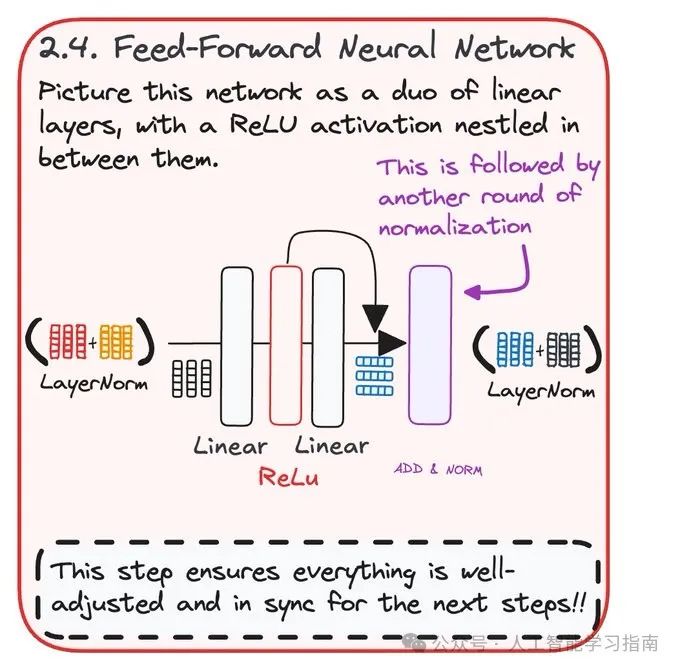

2.4 前馈神经网络

这一步使用前馈网络增强解码器的预测能力。

确保所有内容都经过调整并与后续步骤保持同步。

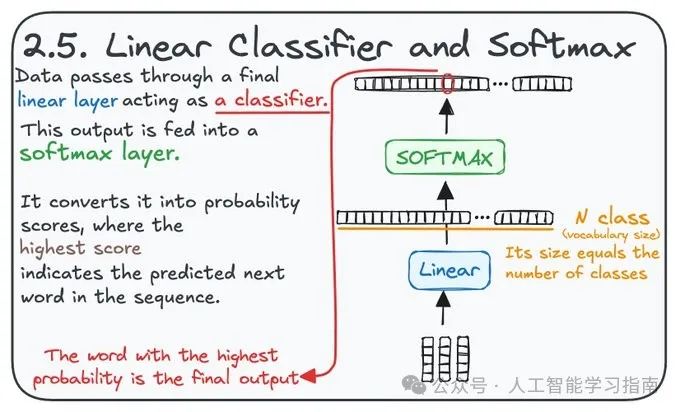

2.5 线性分类器和Softmax

将分数转换为概率,这一步决定了最可能的下一个单词。它像是一个分类器,概率最高的词就是解码器的最终输出。

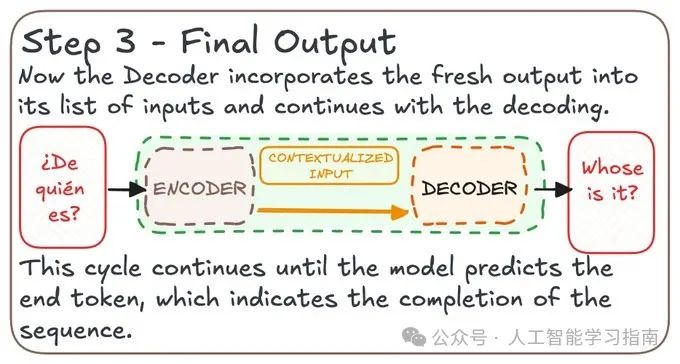

第三步 - 最终输出

解码器将所有处理过的信息编织在一起,以预测序列的下一部分。

这个过程一直持续到序列完成,生成一个完整且富含上下文的输出。

最后的最后

感谢你们的阅读和喜欢,我收藏了很多技术干货,可以共享给喜欢我文章的朋友们,如果你肯花时间沉下心去学习,它们一定能帮到你。

因为这个行业不同于其他行业,知识体系实在是过于庞大,知识更新也非常快。作为一个普通人,无法全部学完,所以我们在提升技术的时候,首先需要明确一个目标,然后制定好完整的计划,同时找到好的学习方法,这样才能更快的提升自己。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

大模型知识脑图

为了成为更好的 AI大模型 开发者,这里为大家提供了总的路线图。它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

经典书籍阅读

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

面试资料

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

4333

4333

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?