自 2023 年 3 月发布第一代语言基座模型 ChatGLM 以来,我们经过对基座模型的深入探索,在模型性能和模态上取得了显著的提升。

基于此,在KDD 2024大会上,我们发布了新一代基座模型,包括语言模型GLM-4-Plus、文生图模型CogView-3-Plus、图像/视频理解模型GLM-4V-Plus、视频生成模型 CogVideoX等,这些模型在相应领域均达到了国际第一梯队的水平。

此外,我们还在「清言APP」上线了视频通话功能,并在MaaS平台上开放了GLM-4-Flash API的免费使用。

「让机器像人一样思考」,智谱将持续前行。

主要更新:

-

语言基座模型GLM-4-Plus: 在语言理解、指令遵循、长文本处理等方面性能得到全面提升,保持了国际领先水平。

-

文生图基座模型 CogView-3-Plus: 具备与当前最优的 MJ-V6 和 FLUX 等模型接近的性能。

-

图像/视频理解基座模型 GLM-4V-Plus: 具备卓越的图像理解能力,并具备基于时间感知的视频理解能力。该模型将上线开放平台(bigmodel.cn),并成为国内首个通用视频理解模型 API。

-

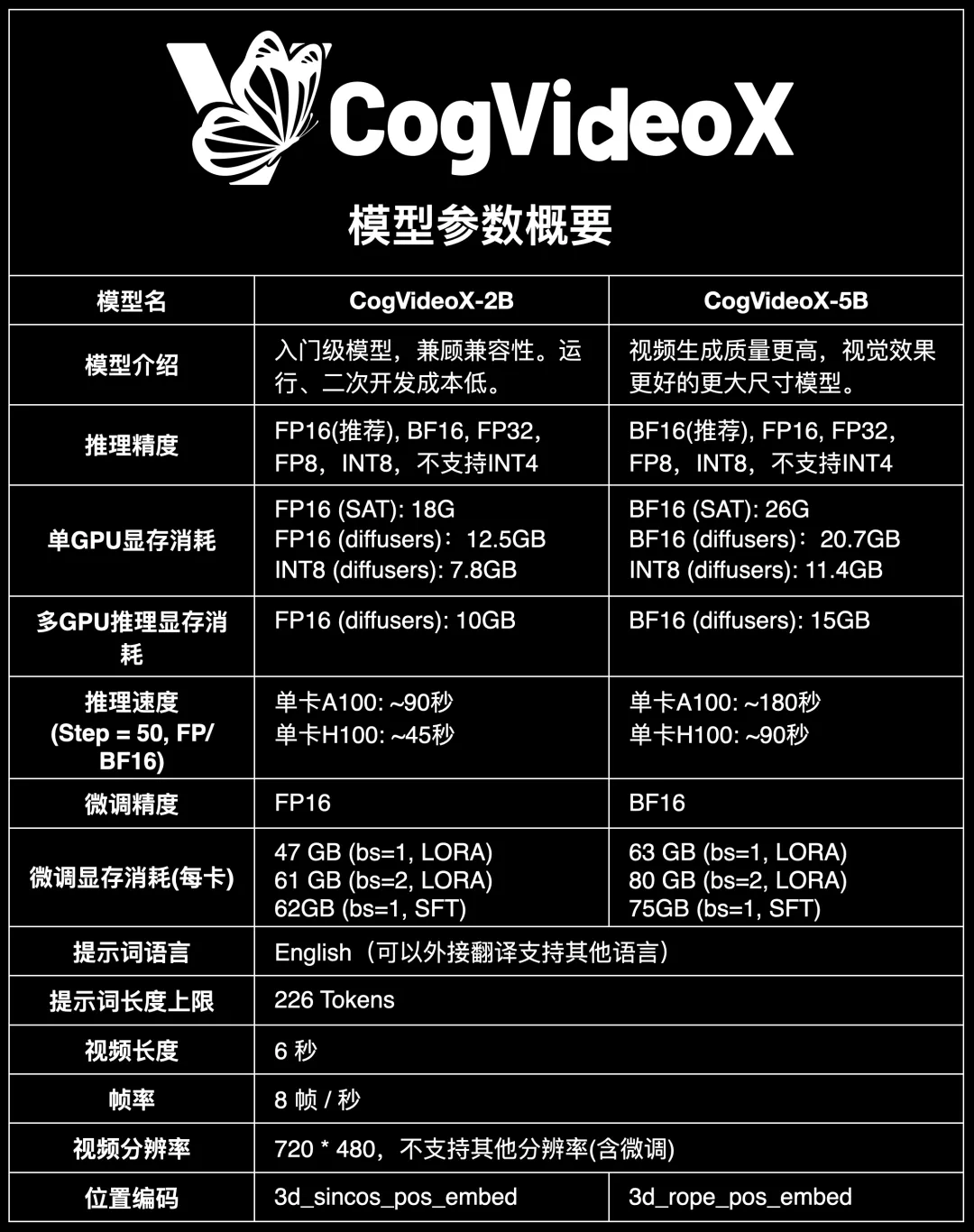

视频生成基座模型 CogVideoX: 在发布并开源 2B 版本后,5B 版本也正式开源,其性能进一步增强,是当前开源视频生成模型中的最佳选择。

-

「清言 APP」上线视频通话: 国内首个面向C端用户开放的视频通话服务,「清言 APP」的视频通话功能跨越了文本、音频和视频模态,并具备实时推理能力。

-

GLM-4-Flash API: 推理服务完全免费,并提供微调服务。

目录:

> 模型:GLM-4-Plus

> 模型:CogView-3-Plus

> 模型:GLM-4V-Plus

> 清言:视频通话

> 开源:CogVideoX

> API :GLM-4-Flash 免费

模型:GLM-4-Plus

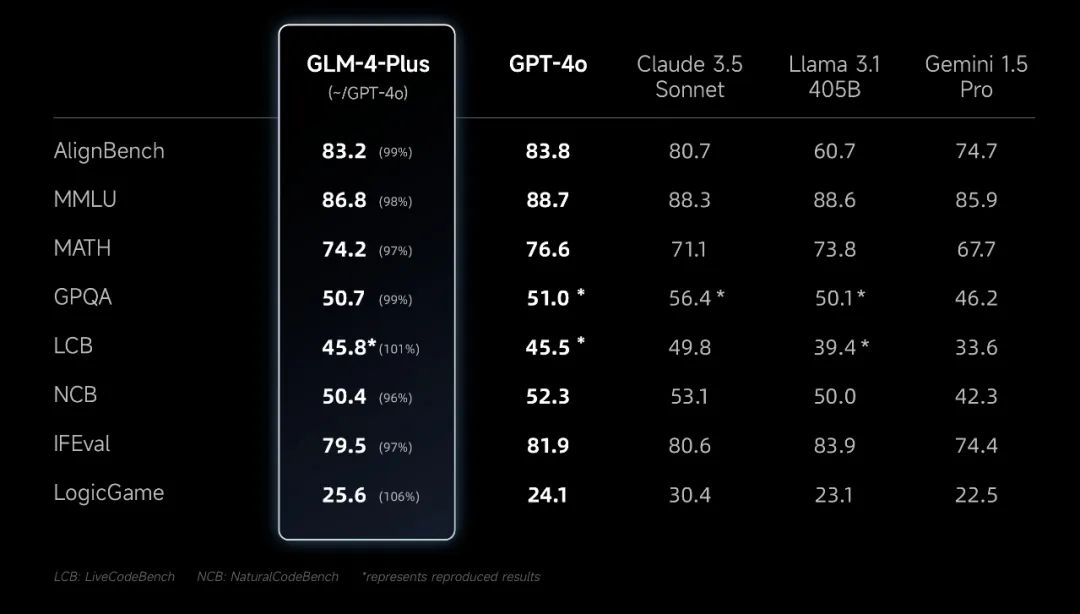

在过去的半年中,我们针对语言模型做了大量理论研究。在此基础之上,我们研发了 GLM-4-Plus 基座模型,通过多种方式构造出了海量高质量数据,并利用 PPO等多项技术,有效提升了模型推理、指令遵循等方面的表现,并能够更好地反映人类偏好。我们在各项指标上,做到与 GPT-4o 等第一梯队模型持平。

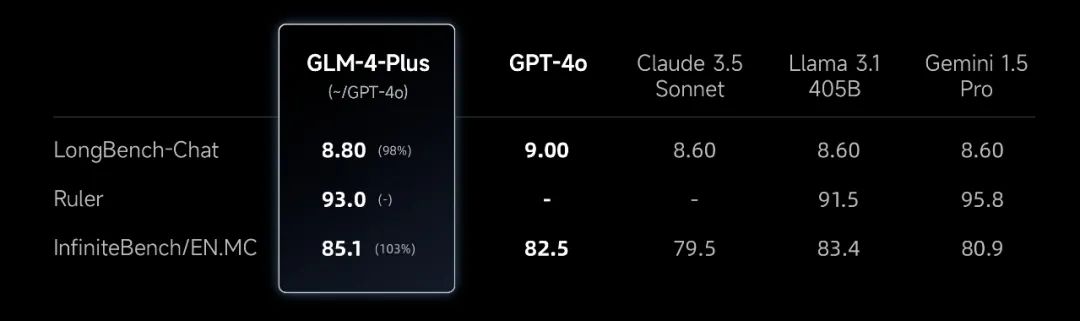

此外,在GLM-4-Plus模型的训练过程中,我们通过采用更精准的长短文本数据混合策略,显著增强了模型在长文本推理方面的表现。

目前 GLM-4-Plus 模型已经正式上线开放平台(bigmodel.cn),对外提供 API 服务;同时也即将在「清言 APP」上线体验。

模型:CogView-3-Plus

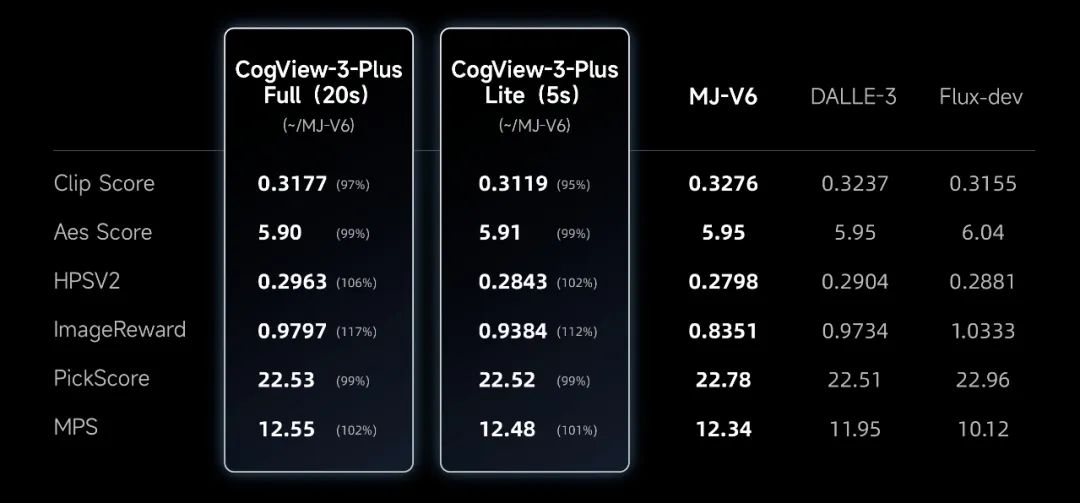

在文生图模型的研发中,我们采用Transformer架构替代了传统的UNet架构来训练扩散模型,并深入研究了扩散模型的噪声规划。在此基础上,我们显著优化了模型效果,并验证了模型参数量提升所带来的 Scale-up效益。我们还构建了高质量的图像微调数据集,使得模型在预训练所获得的广泛知识基础上,能够生成更符合指令需求且具备更高美学评分的图像结果,其效果接近目前处于一线水平的 MJ-V6 和 FLUX 等模型。

| **Prompt:**A stone in a cave with the words ‘CogView3+’ carved on it, set in a mystical and ancient environment.

目前 CogView-3-Plus 模型已经在开放平台(bigmodel.cn)对外提供 API服务,且正式上线「清言 APP」供大家使用。

模型:GLM-4V-Plus

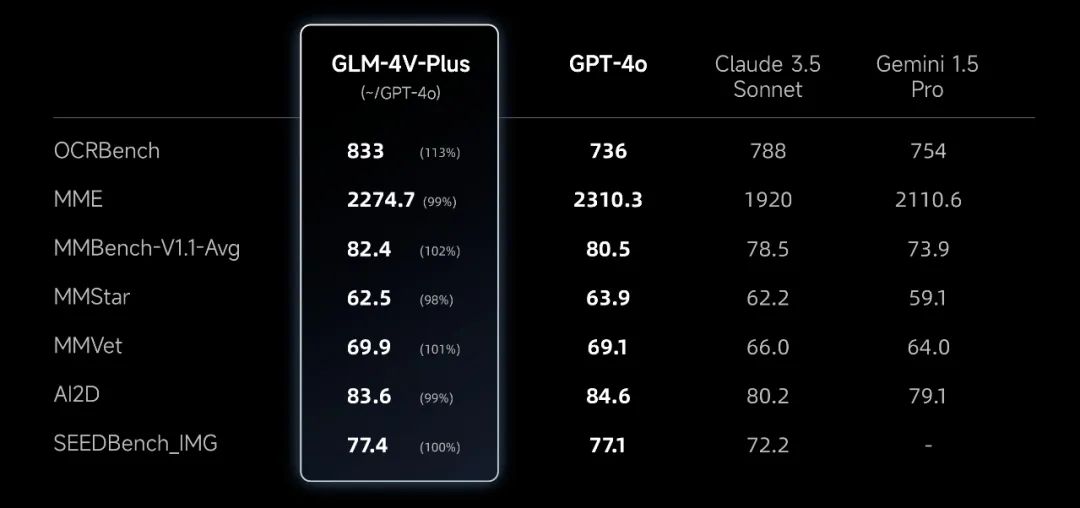

基于我们在 CogVLM系列模型上的研究经验,我们研发了同时具备高质量图像理解和视频理解能力的多模态模型 GLM-4V-Plus。

GLM-4V-Plus 除了能理解并分析复杂的视频内容外,同时还具备超强的时间感知能力。

目前该模型已经正式上线开放平台(bigmodel.cn),成为国内首个通用图像&视频理解模型 API。

开源:CogVideoX

智谱始终秉持将最先进的模型开源给广大开发者的理念,以推动大模型社区的繁荣发展。

为进一步促进AI视频生成社区的自主使用和开放式创新,我们在开源 CogVideoX-2B 版本后,再次开源了参数规模更大、性能更强的产品级视频生成模型 CogVideoX-5B。同时,将 CogVideoX-2B 的开源协议调整为更加开放的Apache 2.0协议。

开源仓库地址:https://github.com/thudm/cogvideo

随着CogVideoX等模型的相继开源,智谱在开源模型的数量和种类上均处于领先地位,累计下载量已突破2000万次。智谱以实际行动为国际开源社区做出了贡献。

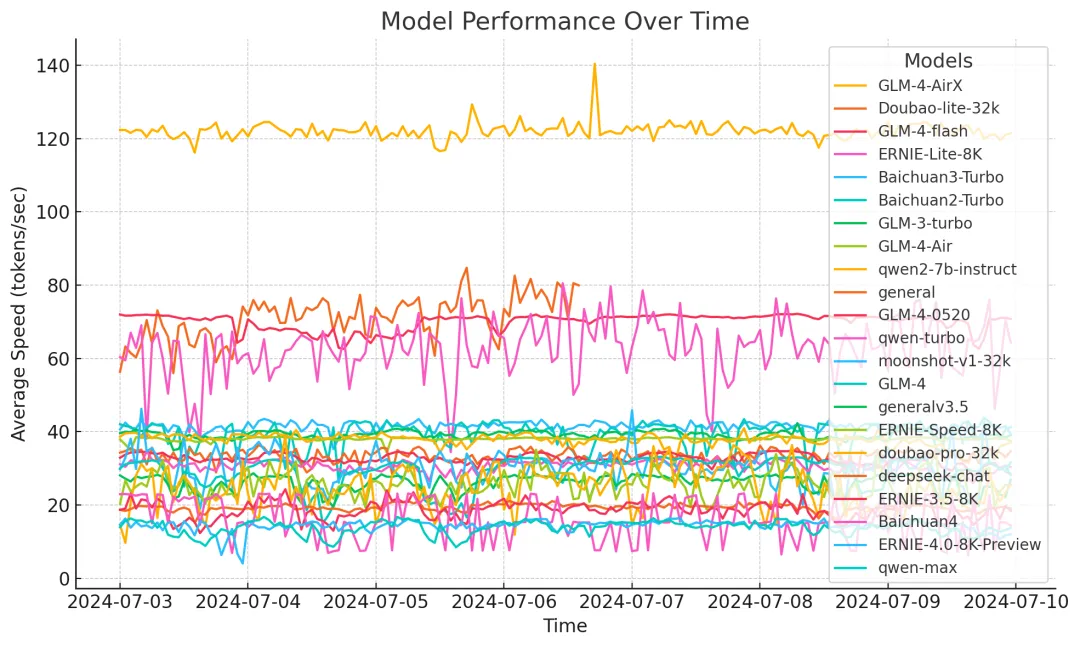

API:GLM-4-Flash 免费

在大型模型技术持续进步的背景下,MaaS 服务正逐步迈向普及化阶段。智谱坚持「运用最先进的技术,服务最广大的用户」的宗旨,将在“速度”和“性能”两方面都具有较大优势的 GLM-4-Flash API 全面免费开放。用户可以通过调用GLM-4-Flash,快速且免费地构建专属模型和应用。这也是智谱开放平台(bigmodel.cn)首个完全免费的大模型 API。

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

观看零基础学习书籍和视频,看书籍和视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

22万+

22万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?