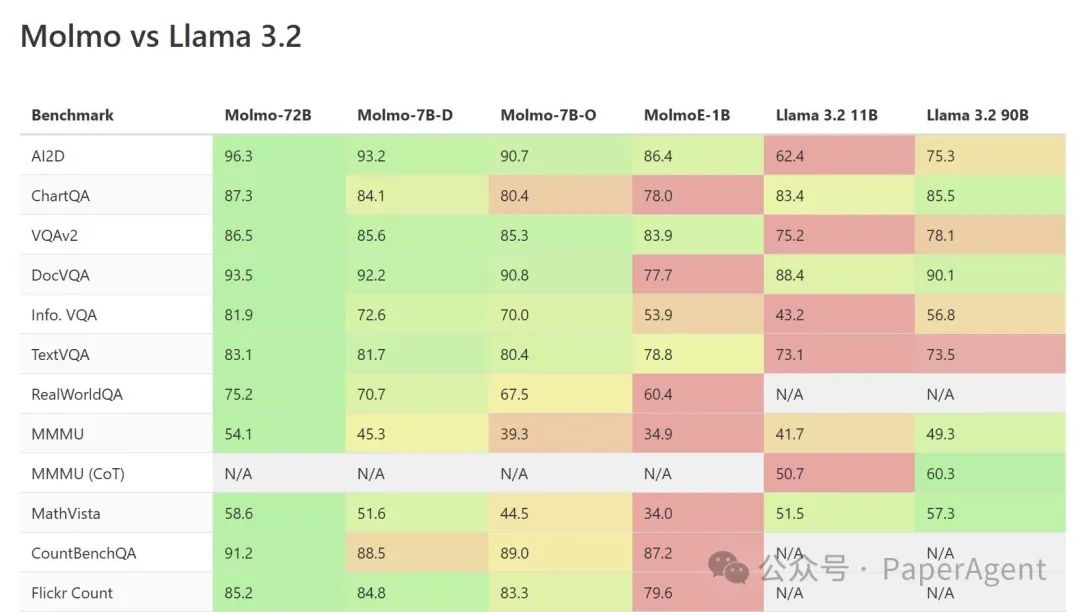

Meta此次发布的Llama 3.2一个新特性是视觉模型,包括11B和90B,作为首批支持视觉任务的Llama模型,但是allenai开源的多模态Molmo-72B,在视觉评测上全面击败Llama 3.2 90B。

两个新发布的开源LLM之间的基准测试比较:Molmo与Llama 3.2可以看出,Molmo在各个方面都相当出色!

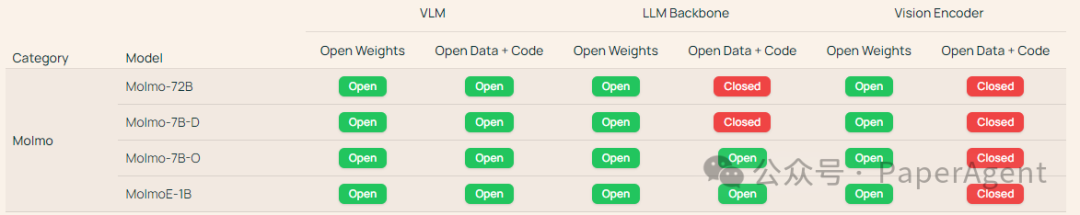

allenai的Molmo发布详情:

Molmo,采用 Apache 2.0 许可,并将发布他们的数据,创建了自定义的 ELO 评估,并且其架构比 Llama 3.2 更简单,可能与 Flash Attention 兼容。

-

有 4 个变体

-

Molmo 72B 基于 Qwen2-72B,并使用 OpenAI CLIP 作为视觉骨干

-

Molmo 7B 使用 Qwen2 7B 和 Olmo 7B 作为 LLM 骨干

-

Molmo 72B 模型在基准测试中胜过 Llama 3.2 90B、Pixtral 12B 和 Qwen 2 72B VL

-

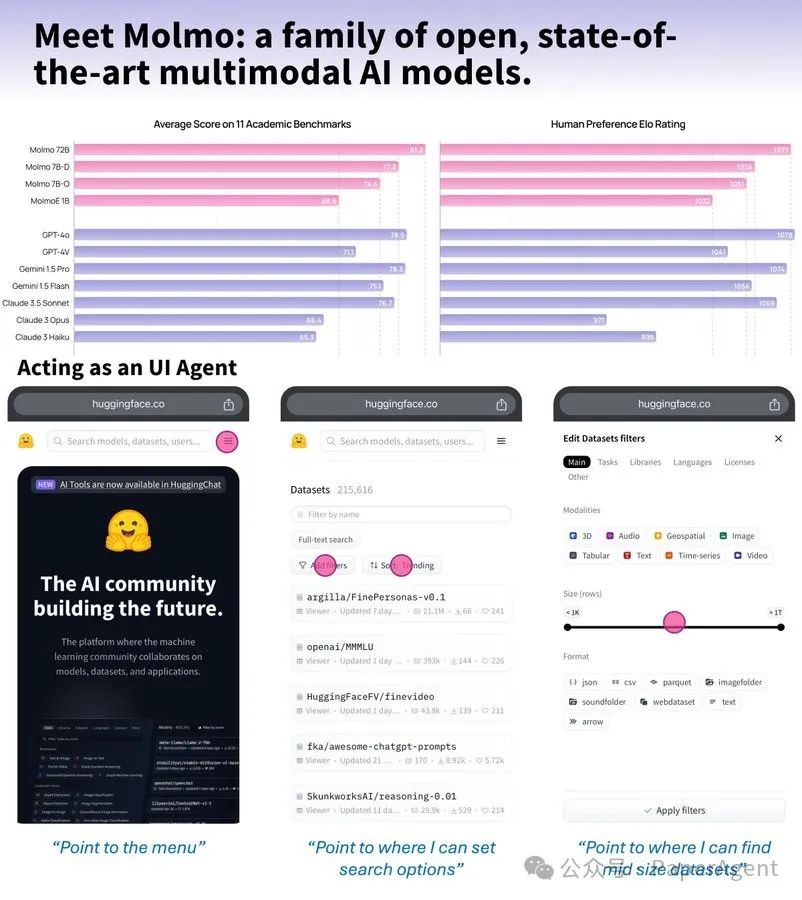

Molmo 72B 与 OpenAI 的 GPT-4o、GoogleDeepMind 的 Gemini 1.5 Pro 和 Anthropic的 Claude Sonnet 3.5 相匹配

-

Molmo 理解用户界面并且能够指向它所看到的内容

-

使用基于语音的图像描述生成高质量的训练数据

-

在 11 个学术基准和 325,231 个人类成对比较上进行了评估

-

在比竞争对手小三数量级的高质量数据集PixMo上训练

-

广泛的人类评估验证了 Molmo 的性能和用户偏好。

Blog:https://molmo.allenai.org/blogPaper:https://molmo.allenai.org/paper.pdfDemo:https://molmo.allenai.orgHF:https://huggingface.co/collections/allenai/molmo-66f379e6fe3b8ef090a8ca19

Meta Llama3.2发布详情:

📣Llama 3.2:为边缘设备设计的轻量级模型,视觉模型等等!新特性有哪些?

-

Llama 3.2 的 1B 和 3B 模型为多种设备上的用例提供了同类领先的能力

-

Llama 3.2 的 11B 和 90B 视觉模型的性能与领先的封闭模型相媲美 —— 并且可以作为 Llama 3.1 的 8B 和 70B 的直接替代品。

-

新的 Llama Guard 模型支持多模态用例和边缘部署。

-

Llama Stack 的首次官方发行版简化并加速了开发者和企业围绕 Llama 构建支持代理应用等的方式。

视觉模型

作为首批支持视觉任务的Llama模型,11B和90B模型需要支持图像推理的全新模型架构。

训练流程由多个阶段组成:

-

从预训练的Llama 3.1文本模型开始。首先,添加图像适配器和编码器,然后在大规模噪声(图像、文本)对数据上进行预训练。

-

接下来,在中等规模的高质量领域内和知识增强的(图像、文本)对数据上进行训练。

在后期训练中:

-

使用与文本模型类似的方法,在监督微调、拒绝采样和直接偏好优化方面进行多轮对齐。

-

利用 Llama 3.1 模型生成合成数据,在域内图像的基础上过滤和扩充问题和答案,并使用奖励模型对所有候选答案进行排名,以提供高质量的微调数据。

-

还添加了安全缓解数据,以生成具有高安全水平的模型,同时保留模型的有用性

最终结果是一组可以同时接收图像和文本提示并深入理解和推理两者组合的模型。

,时长00:34

轻量级模型

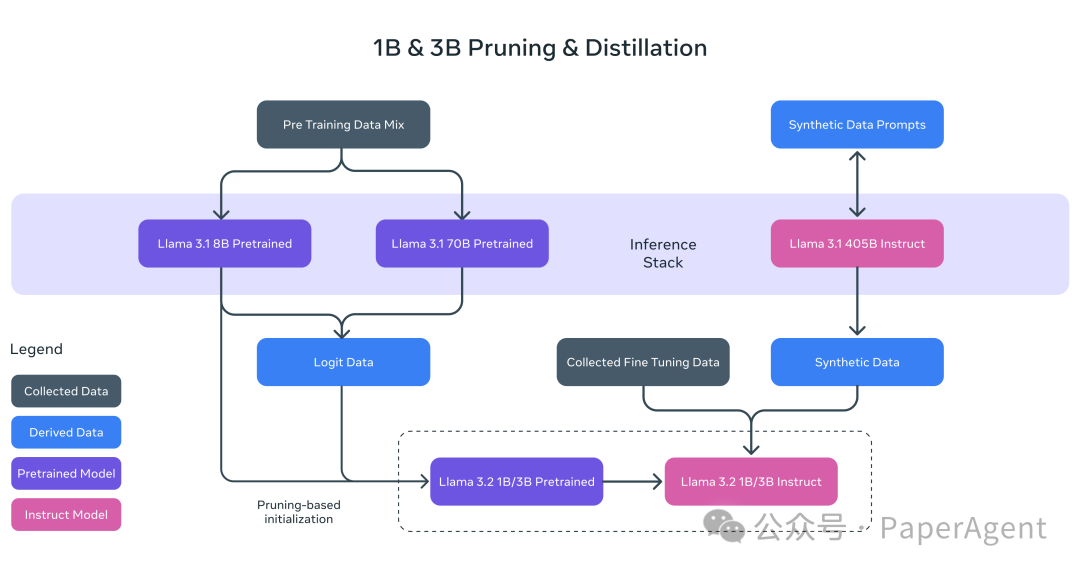

在 1B 和 3B 模型上使用了两种方法(修剪和提炼),使其成为首批能够高效适应设备的高性能轻量级 Llama 模型。

-

修剪能够缩小 Llama 群中现有模型的大小,同时尽可能多地恢复知识和性能。对于 1B 和 3B 模型,采用了从 Llama 3.1 8B 中一次性使用结构化修剪的方法。这涉及系统地移除网络的某些部分并调整权重和梯度的大小,以创建一个更小、更高效的模型,同时保留原始网络的性能。

-

知识蒸馏使用较大的网络将知识传授给较小的网络,其理念是较小的模型使用教师可以获得比从头开始更好的性能。对于 Llama 3.2 中的 1B 和 3B,将 Llama 3.1 8B 和 70B 模型的对数合并到模型开发的预训练阶段,其中这些较大模型的输出(对数)被用作 token 级目标。修剪后使用知识蒸馏来恢复性能。

,时长00:18

Blog: https://ai.meta.com/blog/llama-3-2-connect-2024-vision-edge-mobile-devices/HF: https://huggingface.co/collections/meta-llama/llama-32-66f448ffc8c32f949b04c8cf

来源 | PaperAgent

545

545

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?