本论文是kdd2016的一篇论文

主要的目的也是做node embedding。

主要的想法就是通过deep autoencode对node进行embedding,不过在在embedding的时候不仅考虑了1-hop的信息而且考虑了n-hop的信息。使其变成半监督学习的模式(其实就是对loss function改了改)

输入是一个graph的n*n的邻接矩阵S,其实可以看成有n个数据的训练集,每个数据的feature个数是n,即与图上各点的连接情况

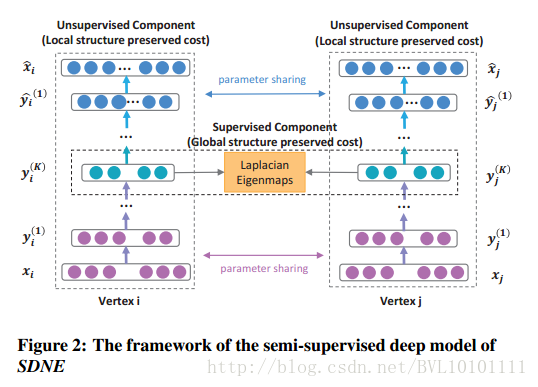

框架如下:

垂直看是正常的deep autoencode(没有稀疏项),水平看,在每个smaple(node)的最后一个encoding层,还加上了和其他smaple(node)的约束关系,其实就是邻接关系的约束。

具体看Loss function:

这篇kdd2016的论文介绍了如何使用深度自编码器进行节点嵌入,不仅考虑1-hop信息,还考虑了n-hop信息,将问题转化为半监督学习。通过邻接矩阵S作为输入,构建的框架在最后一层编码中加入邻接关系约束,损失函数结合无监督和监督学习,优化邻接节点间的相似性,同时采用L2正则化。训练过程逐个节点进行,更新权重。

这篇kdd2016的论文介绍了如何使用深度自编码器进行节点嵌入,不仅考虑1-hop信息,还考虑了n-hop信息,将问题转化为半监督学习。通过邻接矩阵S作为输入,构建的框架在最后一层编码中加入邻接关系约束,损失函数结合无监督和监督学习,优化邻接节点间的相似性,同时采用L2正则化。训练过程逐个节点进行,更新权重。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

323

323

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?