最近收到了很多正在找工作的同学和即将读研的同学关于方向选择上的问题,出现最多的一句话是 “什么方向不卷?” 几个小伙伴突然不知道咋回答了,说实话,都卷,但是仍希望大家负重前行,为坚持的自动驾驶再出一份力。

说到方向选择上,我们也给大家分享下工业界的一些岗位职责,无论是正在找工作或选择读研方向的同学,都有很大参考价值。首先说到大方向,自动驾驶这个领域堪比当年的互联网,十年投入了近3000个亿研发,虽然没有做到当时大喊的L4,但是L2++基本已经成为量产乘用车、商用车的标配,L2.99也快完成,基本接近了L3。至于L4,需要从政府层面推动法律法规的完善,还是会有一段路要走,这也代表我们还有很多事情可以做。

目前自动驾驶相关的方向主要有自动标注与数据闭环(数据层面)、感知算法、多传感器标定、多传感器融合、模型部署优化、建图定位、规划控制、自动驾驶仿真、软件开发、产品经理等,下面将会为大家一一介绍对应职责!自动驾驶之心针对这些方向也都自研了一系列的视频教程,也欢迎大家扫码学习(近10个子方向全栈学习教程以及多个系列大专栏),相信一定能帮助到大家,少走弯路少踩坑,早日选择好自己喜欢的方向。下面开始正式介绍!

扫码学习所有课程!

七月底大优惠

自动标注与数据闭环

早期听到自动标注与数据闭环还是在特斯拉的AI Day,为了解决人工标注成本高、corner case搜集难的问题,这类工作主要是与海量无标签数据为伴,如何挑选出有价值的数据优化模型?如何训练大模型去生成标签?如何用优化的模型上车继续采集数据并形成闭环?这些都是这个领域要关注的问题。国内像momenta、小鹏、蔚来等公司基本都实现了数据闭环,国外最具有代表性的公司就是Tesla!

感知算法

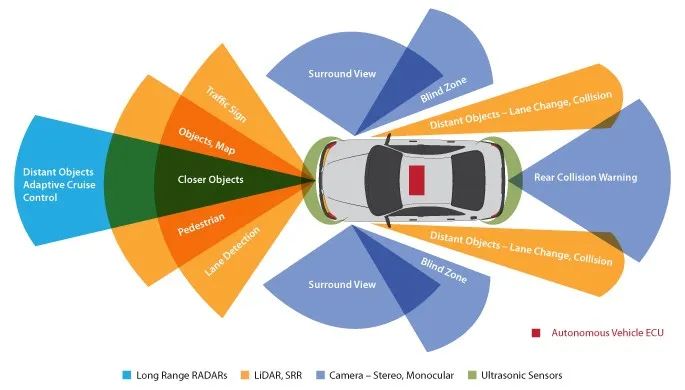

感知算法是自动驾驶中非常重要的部分,涉及2D检测、3D目标检测、BEV感知、多模态感知、语义分割、车道线、交通标志检测等,当前主流的方案为单目3D和BEV方案,重感知轻地图也已经被行业广泛采纳。感知类岗位属于非常卷的领域,需要你持续保持学习,对2D/3D数据的转换、评测方案、模型结构、数据增强、后处理有着深刻理解。能够从算法层面上优化产品问题,并能在轻量化上进行优化。除此之外,多模态感知也是非常重要的一环,大多自动驾驶公司投入巨资进行研发,希望能在性能上做进一步提升!这里也推荐自动驾驶之心的三门自研感知课程:

BEV感知系列:纯视觉+多模态方案,这门课程可以面向刚入学的小白、转行的算法工程人员、需要业务进阶的算法工程人员。

多模态3D目标检测:前融合/特针级融合/后融合,这门课程几乎将所有基于学习的融合方案涵盖,涉及前融合、特征级融合、目标级融合等,涉及算法包括PointPainting、PointAugmenting、AutoAlignV2、DeepFusion、SparseFusion、 Fast CLOCs等近20种方法!

毫米波雷达视觉融合:RV融合方案,深度学习+传统后融合,目前最主流的量产方案,被广大自动驾驶公司与主机厂采用。

多传感器标定

多传感器标定是自动驾驶感知和定位的前提,相机、IMU、激光雷达、毫米波雷达,如何标出完美的参数至关重要,直接决定感知定位的性能!标定工程师一般的工作内容负责相机内外参标定、产线标定、离线标定、在线标定、环视相机标定等,需要对常见的标定算法有着深刻的理解。一名合格的标定工程师对各大自动驾驶和机器人公司来说绝对是香饽饽!这里也推荐自动驾驶之心自研的多传感器标定课程,针对相机内参标定、标定精度优化、传感器到车体标定、多传感器之间离线标定/在线标定、鱼眼与环视相机标定等20+标定方案展开了算法讲解与代码实现:

这门课程是我非常推荐的,因为干货实在太多了,认真学完可以达到一年左右的标定工程师水平。

多传感器融合

目前领域对多传感器融合的定义有两种,一种是基于学习的方案,主要是激光雷达/毫米波雷达/相机之间的特征级融合,代表方案EPNet、Autoalign、Deepfusion、CLOCS等!这类方案需要对数据和融合方式有着深刻了解,一旦融合方式出错,或者数据不对齐(时间和空间),很有可能出现1+1<1的情况。另外一种是基于后融合的方案,主要代表做是基于状态估计和数据关联的算法,代表作卡尔曼滤波、扩展卡尔曼滤波、匈牙利匹配、DeepSORT等,需要对概率论基础和贝叶斯滤波有着深度理解。

这里也推荐自动驾驶之心的三门自研多传感器融合课程(前两门已在上面备述):

多传感器融合跟踪全栈教程,这是目前落地最多的方案,借助状态更新、数据关联、多传感器目标关联等技术完成融合跟踪,面向Camera、Lidar、Radar传感器!

模型部署

模型部署是感知任务上车的最后一环,也直接决定能否将模型应用到具体场景中。主流的芯片有Nvidia的Orin、德州仪器的TDA4、地平线的J3/J5还有寒武纪、海思研发的一些其它芯片。目前自动驾驶芯片分成两派:低算力平台和高算力平台,低阶任务大多采用TDA4这类芯片,高阶任务更多采用地平线J5和Orin这类大算力平台!模型部署岗位对cuda、C/C++要求较高,如果遇到私有算子还需要自己实现支持,碰到效率低的算子,也要有一定的优化调整能力。由于门槛高,薪资也相对较高,没有算法那么“卷”!这里也推荐自动驾驶之心自研的模型部署类课程,基于Cuda和TensorRT:

这是国内首门基于TensorRT的CNN/Transformer/检测/BEV模型四大模型部署+CUDA加速的教程,涉及到的内容之稠密,优化细节之多,实属罕见,老师也非常负责。

规划控制与轨迹预测

规划控制作为整个自动驾驶/机器人算法流程中最下游的模块,直接决定着自动驾驶的安全性及舒适度。整体来说,规划控制相比于感知对理论知识的要求较高,也是一个有积累的学科。目前企业界的主流规控算法包括PID, LQR, MPC等控制算法,以及A*、Hybrid A*、Lattice Planner,EM Planner等等规划算法。去年大多数自动驾驶公司都在抢感知相关人才,也导致了今年感知人才的饱和,PNC相关人才紧缺!这类领域的工作需要熟悉matlab、C++和python,也有上车调试的时候,问题可以直接反馈到感知等上游任务,要求其负责。这里也推荐自动驾驶之心自研的规划控制类课程:

课程从最基础的规划控制模块概要、定义开始,进而到规划算法基础知识的讲解,涉及基于搜索/采样/车辆运动学/数值优化的相关规划算法,再到决策规划框架的讲解(横纵解耦、横纵联合)、最后讲解了常用的几种控制算法(PID、LQR、MPC)并探讨了PnC面临的挑战,实战涉及Dijkstra、A*、RRT*、State Lattice Planner、QP路径优化和基于MPC的轨迹跟踪算法。

轨迹预测这两年也火起来了,轨迹预测一般位于感知模块的后端,规控的前端,为承上启下的模块。输入为感知模块提供的目标track的state信息、道路结构信息,综合考量高精地图信息、目标之间的交互信息,环境的语义信息及目标的意图信息,对感知到的各类目标做出意图预测(cut in/out、直行)以及未来一段时间的轨迹预测!轨迹预测研究的人相对较少,机会也比较多,但落地和好的idea并不简单,需要深入切入进去。

定位建图

其实自动驾驶主要面向户外大场景,SLAM的方法论和一些室内的产品应用有点不一样,主要依靠毫米波雷达、激光雷达、多传感器融合方案,视觉SLAM很少或者不用。SLAM的模块相对比较固化了,前端、后端、回环检测,许多新的方法都是围绕这三点切入,无论是深度学习方案或是传统方案。重感知,轻地图的方案也要引导大家慢慢将重心转到局部高精地图方案上,代表公司Telsa!国内理想和小鹏蔚来也都推出相关的BEV方案,在线生成高精地图,目前这类方法处于研究热点上,也是城市NOA中的重要组成部分,各大公司投入人力去做,是一个相对比较火热的方向。

自动驾驶仿真

仿真是自动驾驶上路之前的最后一公里,直接上路测试风险太大,在仿真环境中搭建类似真实的场景,让算法测试性能,确认无误后进行道路测试。仿真工程师需求量较少,日常工作主要负责静态场景和动态场景的搭建,代表框架Carla。

软件开发

自动驾驶还有一些后处理、写逻辑的工作,我们一般称之为开发工作,这类工作主要涉及各类人工规则的设定,多种结果的融合等,相对比较枯燥,加班也比较多~~~

全栈学习

为了满足更多小伙伴的进阶需求,我们也为大家准备了一系列的配套学习教程,由于存在一定难度,购买后一定要第一时间加入学习交流群和老师交流。

多传感器融合感知标定全栈大专栏,主要包括以下5门课程:

2D目标检测:YOLOv3~YOLOv8理论+实战

BEV感知:纯视觉+多模态融合方案

毫米波雷达视觉融合:目标级融合+特征级融合方案

多传感器融合跟踪:多传感器融合+多目标跟踪

多传感器标定:Lidar/Camera/IMU/Radar等20+标定方案

感知算法与模型部署全栈教程,包括以下4门课程:

2D目标检测:YOLOv3~YOLOv8理论+实战

BEV感知:纯视觉+多模态融合方案

毫米波雷达视觉融合:目标级融合+特征级融合方案

CUDA加速与Tensort模型部署:基于TensorRT下的CNN/Transformer/目标检测/BEV四大基本任务部署实战,CUDA优化加速详解

多传感器标定/融合感知/模型部署全栈课程,包括以下6门课程:

2D目标检测:YOLOv3~YOLOv8

BEV感知:纯视觉+多模态融合方案

多传感器融合跟踪:多传感器融合+多目标跟踪

毫米波雷达视觉融合:目标级融合+特征级融合方案

CUDA加速与Tensort模型部署:基于TensorRT下的CNN/Transformer/目标检测/BEV四大基本任务部署实战,CUDA优化加速详解

多传感器标定:Lidar/Camera/IMU/Radar等20+标定方案

自动驾驶全栈算法工程师系列,主要包括以下7门课程:

2D目标检测:YOLOv3~YOLOv8

BEV感知:纯视觉+多模态融合方案

多传感器融合跟踪:多传感器融合+多目标跟踪

毫米波雷达视觉融合:目标级融合+特征级融合方案

CUDA加速与Tensort模型部署:基于TensorRT下的CNN/Transformer/目标检测/BEV四大基本任务部署实战,CUDA优化加速详解

多传感器标定:Lidar/Camera/IMU/Radar等20+标定方案

规划控制:础算法讲解、横纵解耦/横纵联合框架、Dijkstra、A*、RRT*、State Lattice Planner、QP路径优化和基于MPC的轨迹跟踪多个实战。

课程链接

扫码学习所有课程!

扫码添加助理咨询课程!

(微信:AIDriver004)

753

753

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?