作者 | Vision 编辑 | 自动驾驶之心

原文链接:https://zhuanlan.zhihu.com/p/675535449

点击下方卡片,关注“自动驾驶之心”公众号

戳我-> 领取自动驾驶近15个方向学习路线

本文只做学术分享,如有侵权,联系删文

前言

按照之前Vision:大模型系列00 - 前言 规划,带来第5篇文章-大模型在自动驾驶的运用调研。由于大模型的强泛化能力,引起了其在自动驾驶领域的关注。传统自动驾驶主要聚焦模块化提升性能效果,存在的上限问题显而易见。另外一方面,原来学术界研究重点还是如何提高单模块的上限,比如感知/预测/强化学习/模仿学习(具体分模块介绍见Vision:自动驾驶系列00 - 前言系列),2023年得益于cvpr 2023 best paper uniad 开始才转向端到端在自动驾驶的运用。所以整体调研内容会涉及到大模型和大模型based的端到端工作,大多数paper集中在2023年度(文章新,大部分还在peer review中),很多是从arxiv上直接search得到,揉杂了很多参差不齐的文章也很正常。整体涉及约70篇左右,为了保证阅读质量和提升阅读效率,重复文章会舍弃,并首次增加推荐程度(高/中/低),来highlight推荐阅读的文章。

大模型在自动驾驶运用的方向(5个)

自动驾驶场景仿真数据生成

内容:这个跟上一篇图像生成博客Vision:大模型系列04 -文本图像生成有点相关,但这里更多是3d scene数据(包括动静态元素)和2d图像/2d环视图像等等的生成,会多涉及一些3d空间的概念。当然点云数据生成自然也是一个方向。基本的原理还是基于diffusion/nerf/guassian splat(还没来得及研究)等。

运用方向:仿真团队来做一些高级点的传感器仿真/交通流仿真/worldsim等方向的工作

可实施性:高

“world model“场景预测生成

内容:这个方向最近比较火,gaia最早提出,后来cvpr2023 tesla学者提了一下,后续工业界也赶紧跟上了。这个主要结合多模态信息(更主要是high-level commond,譬如左转)来生成预测接下来的图像和3d scene的信号。当然也可以输入一些文本(比如雨天等)做condtion,生成对应场景的数据。这个方向跟基于上一个方向-自动驾驶场景仿真数据生成基础上的,所以是渐进的关系。

“world model“打引号原因:目前大家习惯把通过加入一些condition信号就能生成图片或者video的基础模型成为“world model”,跟原本提出的概念不太一样(见前面“两个基础概念”阐述)。不过既然学术圈大家都达成共识这样提,我们就默认把自动驾驶领域的world model当作这样的定义。

但目前基于未来场景的预测,对planning和整个ad系统有什么确定性的改进,目前大家都没有在工作中提到,一种可能的影响是基于未来场景精确的预测,提升类似感知超视的感知结果或者推衍逻辑,来辅助现有模块化ad或者大模型reasoning架构的效果。

运用方向:仿真团队/端到端闭环测试团队

可实施性:高

感知自动标注

内容:这里更多是利用多模态领域的大模型的一些经验来帮助做一些图像/点云 open vocabulary(公开字典)的长尾问题的标注,并进一步提升云端标注结果的精度。

运用方向:感知团队/数据标注团队/数据挖掘团队(离线)

可实施性:高

利用多模态大模型能力做决策及规划或者end2end

内容:这个topic 算是目前大模型在自动驾驶领域研究的火热方向,但受限于其先进性和不确定性,更多工作集中在学术界。简要概括就是利用大模型的推理和泛化能力能直接接入感知或者原始sensor信号,然后做language的决策信号输出,并能对ad的各个模块有一定reasoning/justice/relection的能力。由于其耗时大和可部署性,很难短时间在边缘设备上运用起来。但其实这种交互方式就很自然,就像我开车跟租出车司机交流一样,不跟他说话时他自动开,跟他说话时,让他在前面路口左转他就能左转。希望模型蒸馏/减支,硬件创新等都能比较大的突破,期待早一日实现ai代驾司机的体验。当然云端继续验证肯定没错,证明其上限能力。

运用方向:规控团队/端到端自动驾驶方向

可实施性:低

端到端联合训练自动驾驶(不一定是大模型)

内容:这个方向其实是新型的端到端联合训练,各个模块通过feature直接共享,中间每个模块会输出一些结果。但整体planner做的比较学术,而且基于nuscene的开环测试参考意义不大。但工业界都能看到这是一步可以达到的棋,就看在planning这个模块,是采用传统的强化学习还是模仿学习来做,还是利用一些新的但是又不需要大模型这么重的算力方式来解决。

运用方向:规控团队/端到端自动驾驶方向

可实施性:中

参考核心综述paper list(7篇,强推荐3篇)

[推荐]End-to-end Autonomous Driving: Challenges and Frontiers

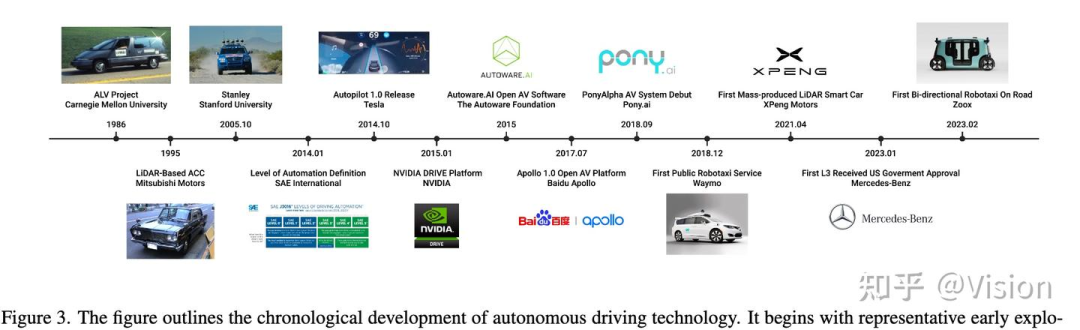

comment: 20230629李弘扬联合香港大学的部分学者发布了一篇端到端自动驾驶综述文章,大约是在uidad获得2023cvpr best paper之后的一周后放出来。这篇文章首先介绍了end2end ad的演变roadmap,从最开始1988年的alvinn到2023年的uinad;后面大概将端到端学习分别两个技术大类(模仿学习(行为克隆,反向最优控制)和强化学习),并简单进行阐述;紧接着介绍了benchmark(着重介绍闭环在线评测,离线开环检测简单罗列);后面系统介绍了端到端系统的8个挑战和相应已经做的一些工作(1. 输入模态(多模态,自然语言)2. 语义抽象 3. model-based的强化学习 4. 策略预测导向的多任务训练 5. 策略蒸馏 6. 可解释性保证(注意力可视化,可解释任务,中间结果cost学习,语言化的解释,不确定度的建模和衡量)7. 因果混淆 8. 鲁棒性(长尾问题分布,covariate shift,domain adaption));最后介绍了未来方向(zero-shot泛化,模块化的端到端planing,数据引擎,基础模型,v2x)。整体文章我感觉作为新手还算不错,特别是把端到端的一些挑战(可解释性等)重点highlight出来,并列举了一些目前解决的方案和办法。但对整个端到端技术的罗列上比较欠缺,但文章也特别说明这部分可以去参考其他综述。缺点:1. 如何在实际系统中的部署难度问题(比如时延和算力)也没有明确指出来,或许学术界就不太关注这块,毕竟效果上都还有很多问题亟待解决。2. 没有涉及到大模型方面结合的工作,但也提出了language输入等小topic,但重心还是在端到端的驾驶设计上,没有充分利用大模型在多模态上的泛化能力。

recommend level:高,挑战点集中罗列

[推荐]Vision Language Models in Autonomous Driving and Intelligent Transportation Systems

comment: 2023年10.22 慕尼黑工业大学学者上传一篇多模态在自动驾驶和智能交通上的运用综述文章。我仅关注自动驾驶方面。首先分了 5个模块(感知理解,导航规划,决策控制,端到端,数据生成)来做归纳运用;然后介绍了自动驾驶数据集和语言增强的自动驾驶数据集(15个,算是比较全的);最后讨论了部署大模型到自动驾驶的6个方面细节(自动驾驶基础模型,数据获取与格式,安全对齐,多模态adaptation,时序场景融合,算力和处理速度)

recommend level:高,总结的数据集全

A Survey of Large Language Models for Autonomous Driving

comment: 2023.11.02上海交大严骏驰团队和李弘扬团队合作共同发布了一篇大语言模型在自动驾驶上的运用综述。文章分了4个方面(规划控制,感知,问题对话,数据生成)来介绍运用,每个方面除了介绍实现方法,还单独给了一个小段落来总结评测的metric,但是感觉很多都不一样。最终介绍了8个大语言自动驾驶驾驶数据集。实现文章基本所有分析paper均在2023年黄裕发的那篇paper里都有描述;同时8个自动驾驶数据集在202310月慕尼黑工业大学那篇综述里也全部被包含(总共介绍了15个)。所以这篇paper整体质量并没有那么高,不过可能同样的文章和数据集描述的角度不同。在看具体paper时,可参考该文的具体描述。

recommend level:中

[推荐]Applications of Large Scale Foundation Models forAutonomous Diving

comment: 20231120知乎大佬黄浴在arxiv上上传了一个大模型在自动驾驶方面运用的综述文章。分了3个大方向(仿真及世界模型22篇(传感数据合成9篇;交通流数据合成4篇;世界模型11篇),自动标注7篇,决策规划和端到端21篇(大规模语言模型集成13篇;类似nlp的tokenization预测5篇;预训练基础模型3篇))。当然除了介绍运用,在前面还详细罗列了大语言模型,多模态模型,diffusion model,nerf这4大技术基础领域的进展。整个文章的技术完整度还是挺好,但缺少了数据集(可以看慕尼黑工业大学那篇综述)、评测指标(参考yanjunchi那篇综述)及目前难点问题讨论。文章的表格罗列也是很赞。整体是推荐阅读深究的。可以结合其他两篇综述,合并下每个人习惯的总结分析角度。

recommend level:高,涉及多模型运用方向全

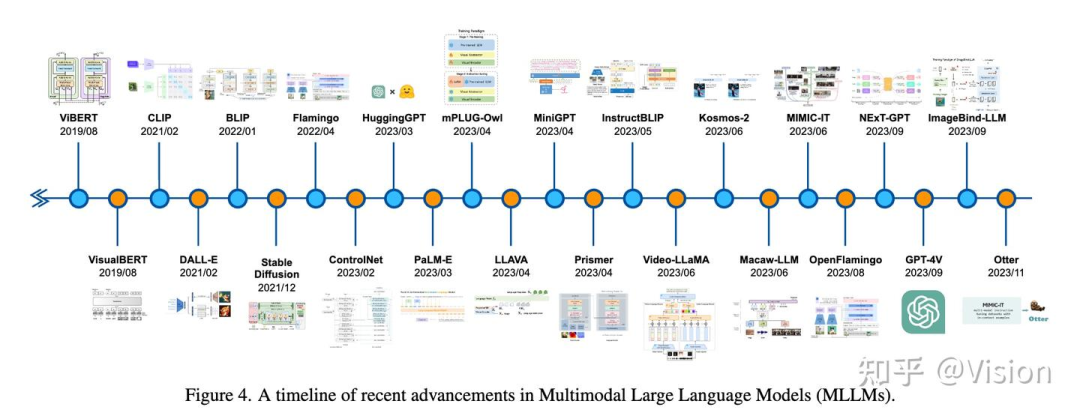

A Survey on Multimodal Large Language Models for Autonomous Driving

comment: 20231121普渡大学学者和国内腾讯等单位发表的综述(组织了WACV 2024 LLVM-AD),介绍了多模态大语言的今年来发展趋势,然后介绍其在自动驾驶的文章和数据集(比较少),另外disscuss部分罗列了几个挑战(可以阅读)。整体没有很大的信息量https://github.com/IrohXu/Awesome-Multimodal-LLM-Autonomous-Driving。

recommend level:中

Towards Knowledge-driven Autonomous Driving

comment: 上海ai实验室shitianbo团队发布的以agent-envorment交互为模式的自动驾驶,具体还未细看。项目链接 https://github.com/PJLab-ADG/awesome-knowledge-driven-AD

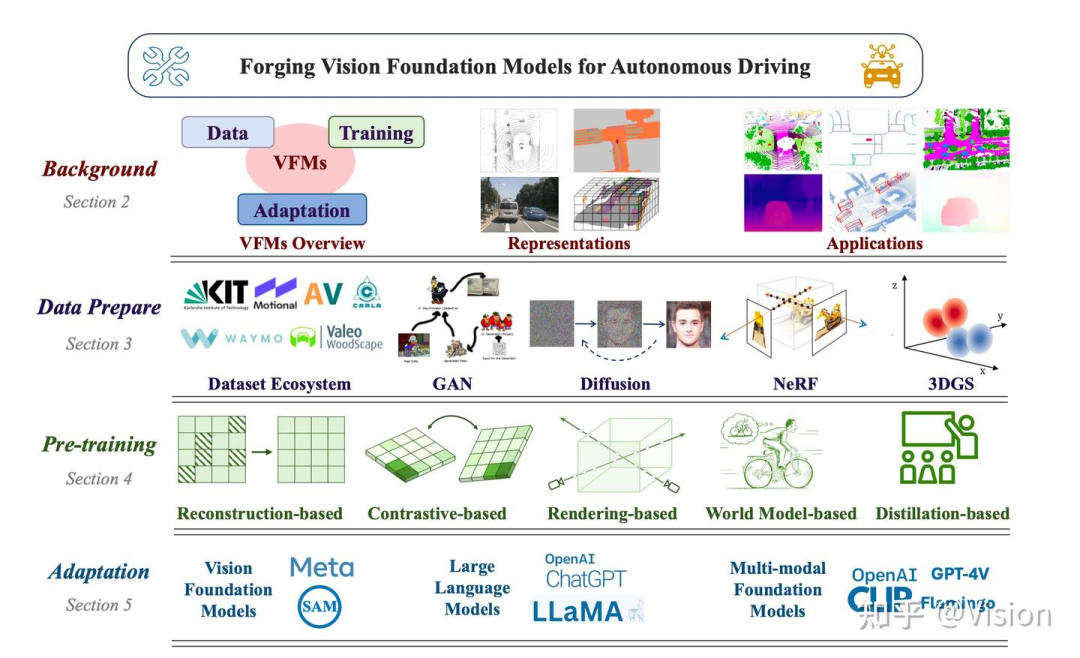

Forging Vision Foundation Models for Autonomous Driving: Challenges, Methodologies, and Opportunities

comment: 2024年1月,华为nora实验室发布关于一些自动驾驶领域的视觉模型的运用,算是比较全面的总结(不仅仅限于大模型),但还未细看。项目链接:https://github.com/zhanghm1995/Forge_VFM4AD

两个基本概念(world model/foundation model)paper

World Models

comment: 2018 google:提出了world models,利用在仿真环境中强化训练,可迁移到现实场景中。整个系统分为3部分,v/m/c。v是利用vae方法训练得到一个hiddle state z(高斯分布假设参数),M是通过一个rnn模型来encode时序和空间表达信息得到ht. c是一个简单的mlp,接受【ht,c】和当前的action_t,得到action_t+1, loss为最后c的强化学习奖励函数激励

recommend level:高,基础定义paper

On the Opportunities and Risks of Foundation Models

comment: 2021年8月stanford发布了foundation models的研究,提出foundation model的两大特性emergance and homogenization。文章很长,整体会涉及fm是什么,有什么能力,在哪些方面有运用,社会影响,以及一些report报告汇总等。但youtoube上1个半小时视频整体以ppt的方式讲解了一下,了解的算是比较全面。链接https://www.youtube.com/watch?v=ZshcPdavsdU。另外foundation model这个名词原来21年就有了,但今年2023才大活起来,还是要多看paper,看好paper。

recommend level:高,基础定义paper

前序基础知识参考paper

NeRF: Representing Scenes as Neural Radiance Fields for View Synthesis

comment: 202003 uc berkeley(2020eccv):nerf 提出一种新的2d数据合成的方法。基于神经发射场,利用mlp学习一个空间连续函数映射。(color,density)= mlp(x,y,z, θ, φ ), 利用光线积分法得到2d图像上的显示色彩,为了加速,设计corse-to-fine的积分方法,通过corse得到概率密度函数,再通过fine密集采点,整个函数训练loss为图像的误差。recommend level:高,基础定义paper

方向1.1 - 自动驾驶场景数据生成-传感器数据方向(7篇,强推荐1篇)

READ: Large-Scale Neural Scene Rendering for Autonomous Driving

comment: 202205 浙大and 陈俊波 AAAI2023 paper,提出w-net(u-net)变形,通过2d重建3d point,加3d point编辑重新生成不同相机内参2d图像的方法。

recommend level:低

[推荐]Street-View Image Generation from a Bird's-Eye View Layout

comment: 202301 ucla:bevgen,通过bev layout生成多视角图像,保证bev和2d view一致,cross-view也一致,具体会把image和bev layout都会通过vq-vae的方式量化成离散向量;然后利用内外参坐标转换到车体坐标系下,然后通过cross attentionn方式交互。整体是vae的架构,gpt-like的结构。

recommend level:高,首次生成3d/2d多相机和3d一致性图片

Generating Driving Scenes with Diffusion

comment: 202306 zoox:scene diffusion 利用diffusion结构,基于map-condition生成bev下的目标集合(好像只生成位置和朝向,没有速度),方便pnc等下游利用bev下的3d结果去做一些实验。

recommend level:低

DriveSceneGen: Generating Diverse and Realistic Driving Scenarios from Scratch

comment: 202309 新加坡国立大学:driveSceneGen, 利用diffusion生成前背景,然后对前景做预测。整体细节描述比较少,而且diffusion过程没有condition的引导,不知道在实际infer过程中的输入noise是怎么来提供特定场景信息从而生成专向场景

recommend level:低

WEDGE: A multi-weather autonomous driving dataset built from generative vision-language models

comment: 202305 cmu: 利用dalle2弄了个仿真检测的数据集,并验证训练的有效性

recommend level:低

MARS: An Instance-aware, Modular and Realistic Simulator for Autonomous Driving

comment: 202307 air清华:提出部分开源的基于nerf的图像仿真框架,前景和背景模块化,且生成pipeline模块化,效果逼真。

recommend level:中

Adv3D: Generating 3D Adversarial Examples in Driving Scenarios with NeRF

comment: 202309香港科技大学-广州:adv3d,通过2d patch加攻击,通过nerf生成3d 驾驶场景来欺骗3d 检测器。整个生成过程的loss是降低目标周围附近的检测障碍物的confidence

recommend level:中

方向1.2 - 自动驾驶场景数据生成-交通流方向(5篇,强推荐1篇)

Guided Conditional Diffusion for Controllable Traffic Simulation

comment: 202210 nvidia: ctg,提出可控的交通流仿真,离线训练一个diffusion的model,在线通过传入传统规则的stl rule来作为condtional guide来保证交通流,具体的diffusion的数学推导没认真看

recommend level:中

RITA: Boost Autonomous Driving Simulators with Realistic Interactive Traffic Flow

comment: 20221117 上海交大&huawei :rita,基于2020年发布的smart仿真器集成的交通流仿真插件工具。相比于原来的sumo等,这次采用的一种数据驱动的仿真流方法。整体分ritbackend和ritakit,也可以放到sumo等架构中。kit制定感兴趣区域和基本仿真策略,后端利用模仿学习和diffusion来生成轨迹。具体细节没有太描述。

recommend level:中

TrafficBots: Towards World Models for Autonomous Driving Simulation and Motion Prediction

comment: 202303 icra 苏黎世理工:提出一个交通流仿真及轨迹预测的文章,跟之前有一篇将drivescene生成的有点像,对于每个目标设置一个导航方向来确保可配置性,所有agent公用一个场景context来确保可扩展性。整体文章我觉得没撒很创新的点。

recommend level: 低

[推荐]Language-Guided Traffic Simulation via Scene-Level Diffusion

comment: 202301 cmu&nvidia: ctg++,基于ctg的升级版本,提出scene-level diffusion model的结构,避免了ctg的单agent diffusion model。另外condtion引入了自然语言的promot,通过gpt4变为一个lossfunction来去guidance。整体做了比较详细的相对ctg的改进,附录部分阐述了比较多细节。

recommend level:高,利用nlp,且附录细节充足

SurrealDriver: Designing Generative Driver Agent Simulation Framework in Urban Contexts based on Large Language Model

comment: 202309 清华: 提出surrealdriver,通过设计拟人的driver agent来加强模拟车辆的智能性。通过人工驾驶描述数据来作为cot的promot来生成coach driver来引导合理的驾驶行为。另外整个perxeption./decison-making/action都有显示的condition输入。整个框架还是auto-gressive的。整体llm的细节并未完全描述清楚,而且agent与agent的强交互并没有显示建模,而是通过promot的方式来制定(不一定坏)

recommend level:中

方向2 - “world model“场景预测生成(9篇,强推荐6篇)

[推荐]UniSim: A Neural Closed-Loop Sensor Simulator

comment: 202306 wabbi:提出一种数据驱动的传感器仿真数据(camera&lidar),利用神经特征grid的方式来建模动态和静态,然后也训练了一些网络来预测恢复动态车的不同view,从而可以生成逼真的drving grid,然后通过原理生成对应的lidar和camera结果,整个训练的loss包括lidar和camera senor的l2重建loss等。视频效果比较amazing。代码未开源,估计会中2024cvpr

recommend level: 高,惊艳仿真圈的工作

[推荐]UniWorld: Autonomous Driving Pre-training via World Models

comment: 202308 北大 uniworld:通过lidar点云-环视相机,训练预训练模型,通过生成4d occ grid的方式来反向传播,然后再用于做下游任务,比如检测/分割/预测,整体思路比较简单,而实际中bev feature的构建是比较耗时的,各个任务的要求是不一样的。所以bev transformer和feature encoder是否一定要做成预训练,方向是对的,就看算力问题了

recommend level:高,3d点云生成工作

[推荐]GAIA-1: A Generative World Model for Autonomous Driving

comment: 202309 wayve:利用video+text+atction 训练world model,然后接decoer生成视频。整体结构利用autogresssive transfromer结构(65亿参数)。整体利用预测next token的方式来训练。

recommend level:高,高参考性工作

[推荐]DriveDreamer: Towards Real-world-driven World Models for Autonomous Driving

comment: 202309 极佳科技&清华:提出drivedreamer,整体原理跟百度的drivingfusion系列很像,通过生成视频的方式来体现world model的能力。可以通过一些condtion,比如把交通流信息投影到图像上得到2d view的condition,另外又有一些文字描述,或者driving action(刹车油门,方向盘)等信号。文章训练分两个阶段,一个是auto-am, 通过输入多模态的condition训练diffusion生成vedio,然后第二个阶段actionformer,通过gru等结构和cross-attetntion得到新的feature,然后condtion输入到auto-am结构生成进一步的视频。在这里提一下,world models是强化学习领域表达时间和空间信息的一个抽象模型,从这一点看来现在ad领域讲的world model都有点像。但实际上这两者还是有点区别,我们现在更多是通过所谓构建世界模型去生成图像/视频。而直接用于原有world model对三维空间的表达的直接验证还没有说明效果。

recommend level:高,可接入文字等多模态信息输入

[推荐]DrivingDiffusion: Layout-Guided multi-view driving scene video generation with latent diffusion model

comment: 20231014 baidu vis:利用diffusion生成自动驾驶场景多相机视频。利用3d layout和text信息做condition指引,保证生成的图片跨相机和跨时序都有一致性。相对于bevgen多了个时序建模,同时多相机的一致性建模也有些区别(本文采样view-wise的attention,bevgen采用token-wise)。另外方法也不一样。文章也采用了后处理refine model来解决时序长时遗忘问题,因为时序都是由第一帧promot出来的。具体还有光流的condition,不知道这个是如何提取的。文章也提到了可以扩展到其他的mode condition。

recommend level:高,3d layout使用

[推荐]LEARNING UNSUPERVISED WORLD MODELS FORAUTONOMOUS DRIVING VIA DISCRETE DIFFUSION

comment: 202311 waabi: 类似之前usim的生成文章,这篇提出了如果通过历史3d数据 + action 生成未来3d点云数据,利用vqave将点云转化为hidden state,然后通过world model,最后通过类似nerf建模恢复3d世界。其中利用了masked gpt的思路,来使得训练效果更好。

recommend level:高,点云生成

MUVO: A Multimodal Generative World Model for Autonomous Driving with Geometric Representations

comment: 202311 kit(德国一所科研大学):提出通过视觉和点云生成将来的自动驾驶场景的rgb和pointcloud/occ world,引入action作为condition,利用calar仿真环境生成的。整体思路跟其他类似的drivedreamer等大多数文章都比较类似。

recommend level:中

ADriver-I: A General World Model for Autonomous Driving

comment: 20231120 旷世:类似其他生成网络,利用图片,action作为condtion,直接生成action和对应的predict图片。整体思路都差不多。

recommend level:中

Driving into the Future: Multiview Visual Forecasting and Planning with World Model for Autonomous Driving

comment: 202312 中科院学者:类似world model预测,细节还没来及看

recommend level:未知

方向3 - 感知自动标注(8篇,强推荐1篇)

Talk2Car: Taking Control of Your Self-Driving Car

comment: 201909 比利时学者:提出通过nlp commond 来对数据做标注,nlp和image的交互识别方法好像没特别提出,提到了亚马逊的工具。应该是个数据集文章。

recommend level:中

OpenScene: 3D Scene Understanding with Open Vocabularies

comment: 202211 google(2023cvpr):利用clip特征,联合3d点云训练后,可用于3d点云下的open vocabulary的检测。整体实现思路比较简单,估计是第一篇做这个运用的文章,所以中了cvpr。代码已经开源。

recommend level:中

AD-PT: Autonomous Driving Pre-Training with Large-scale Point Cloud Dataset

comment: NeurIPS2023 上海ai实验室&复旦202301:提出了一种点云预训练的方法。利用开源的部分带label训练出的detector在大量无标签的基础上得到大量高精度的伪标签;然后通过点云resampling 和 object size augmentation的方法来增广数据;设计一个随机采集roi特征+一致性loss的方式来召回少见的长尾正样本。训练出来的网络在部分任务上finetune后检测效果更好。可支持不同的检测器来当训练的backbone。文章也没用什么transformer结构。算是第一篇提出3d 点云预训练的文章,但又不是大模型预训练。文章提到的一些resampling和data augemttaion实际工程中也或多或少会采用。这个梗适合来做云端4d gt的标注涨点思路,看起来比较多的trick

recommend level:中

Language-Guided 3D Object Detection in Point Cloud for Autonomous Driving

comment: 202305 北京科技大学&赢彻杨瑞刚:提出language 3d point retrial系统,通过直接监督3d point instance proposal和language,类似clip的点云泛化版本。图像这块链路是opitional的。没有预训练的clip模型。其实跟22年11月发的openscene有点像。

recommend level:中

[推荐]Language Prompt for Autonomous Driving

comment: 202309 北京科技大学&旷世:提出nuprompt数据集,基于nuscene数据集人工标注子属性标签,然后任意组合子属性标签,然后通过gpt3.5生成描述的sentence。整体提出promottrack的识别框架,text encode成单独链路特征,环视图片数据通过时序生成特征,然后作为query送入到text embedding中输出对应的bbox。另外环视图像做正常检测跟踪,类似trackformer结构。

recommend level:高,细节描述较好

[推荐]HiLM-D: Towards High-Resolution Understanding in Multimodal Large Language Models for Autonomous Driving

comment: 202309 香港科技大学&华为:提出一种输入图像,到输出可解释和简单的建议action,并能grounding出导致主车行为变化的risk目标。整体有两个branch,第一个是低分辨率的视频帧席勒输入,另一个是高分辨率的单帧输入。两个branch有交互。低分辨率输出可解释的自然语言描述和建议。高分辨率输出图像的bbox。整体想法还是朝着端到端方向走,只不过为了可解释和无法闭环仿真验证。更多还是在可解释性上做了一些尝试工作。

recommend level:高,nlp出bbox

Unsupervised 3D Perception with 2D Vision-Language Distillation for Autonomous Driving

comment: 202309 waymo: 提出一种利用文字图像匹配特征做open cabutory的物体检测,类似mssg等paper思路。

recommend level:中

OpenAnnotate3D: Open-Vocabulary Auto-Labeling System for Multi-modal 3D Data

comment: 202310 fudan:利用大语言模型构建交互式的3d标准工具,利用clip,sam和llm 交互式的形式。通过2d反投3d得到点云标注。

recommend level:中

方向4 - 利用多模态大模型能力做决策及规划或者end2end(22篇,强推荐7篇)

[推荐]Talk to the Vehicle: Language Conditioned Autonomous Navigation of Self Driving Cars

comment: 2019印度学者iros:算是比较早的把自然语言加入到自动驾驶里的工作了。文章自己提出了一个数据集。然后提出一个wgn的网络来融合感知bev结果和自然语言encoding后的结果输出一个前方大概多少米的大概位置(就是减配版的routing);后面接上一个传统的local planner。整体估计idea比较早,没有跟其他论文方法对比,只是自己做了一些消灭实验。另外本身encoding出来的nlp模块降维比较多,本身还是想把文本的建模难度弱化,也是合理。这可是出在clip文章出来之前的多模态的工作之一了。

recommend level:高,比较早提出引入nlp来做bp

ADAPT: Action-aware Driving Caption Transformer

comment: 202302中科大&清华:输入vedio,直接输出control信号。为了加强可解释性,加了文字的描述:主车行为和原因。整体比较简单,也没撒对比。只是证明加了解释性的head后control信号的输出精度会变好。

recommend level:中

ConBaT: Control Barrier Transformer for Safe Policy Learning

comment: 202305mit学者:提出conbat,一种策略学习方法,基于transfromer backbone输入state/action能输出对应的embedding,然后输入策略pai head输出结果,然后再送入所谓world model网络得出下一刻的action。整体优化函数利用一些控制理论的东西不太懂。整体偏规划类问题。

recommend level:低

Drive Like a Human: Rethinking Autonomous Driving with Large Language Models

comment: 202306上海ai实验室:以当前模块化优化设计为例,列举失效场景的问题,然后提出了一个类人的设计模块思路:可推断,可解释,带记忆。利用感知工具对仿真器的场景进行描述,然后送入gpt3.5推断,如果与人类标注或者其他expert不同,则反馈给gpt3.5,设计成一个记忆模块,然后修正,以提升对长尾问题的结局比例。由于只是提出这个方向和想法,未做具体的工程性实验。

recommend level:中

MTD-GPT: A Multi-Task Decision-Making GPT Model for Autonomous Driving at Unsignalized Intersections

comment: 202306同济:利用gpt2的结构来做决策,输入自车和其他车的信号,通过encoder-decoder输出决策信号(stop)等。利用rl来做专家数据的生产。

recommend level:中

Can you text what is happening? Integrating pre-trained language encoders into trajectory prediction models for autonomous driving

comment: 202309 德国某大学:也是开放性提出了一个验证,对rastied地图的表达,加入文字的描述后,预测结果会更好

recommend level:低

LINGO-1: Exploring Natural Language for Autonomous Driving

comment: wabbi blog

recommend level:未知

Drive as You Speak: Enabling Human-Like Interaction with Large Language Models in Autonomous Vehicles

comment: 提出了一个我曾经非常兴奋的一个想法。driver提出promot指定,结合特定模块的结果,利用llm进行reasoning(text by text)后再进行action的输出。整体文章应该也只是一个idea,实验数据也没给提供。

recommend level:低

DILU: A KNOWLEDGE-DRIVEN APPROACH TOAUTONOMOUS DRIVING WITH LARGE LANGUAGEMODELS

comment: 202310上海ai实验室:提出dilu,跟之前drive like a human那个小论文有点像。整体分为4个部分:reasoning,reflection(纠正),memory,action。相对之前讲的更详细一点。其中通过reflection来发现badcase从而促进知识学习(memory),类似强化学习里的知识。

recommend level:中

DRIVEGPT4: INTERPRETABLE END-TO-ENDAUTONOMOUS DRIVING VIA LARGE LANGUAGEMODEL

comment: 202310 香港大学:引入大语言模型通过标准的3段式来做端到端的决策信号:主车目前帧要干什么,为什么干,预测下一帧主车要干撒。输入层面会把图像vedio token化+额外的bbox token化来表达,再加上action和text的token输入。本文利用llama开源模型来微调的。

recommend level:中

[推荐]Driving with LLMs: Fusing Object-Level Vector Modality for Explainable Autonomous Driving

comment: 202310 wayve:利用大语言模型来做端到端预测,区别于drive-gpt4,文章有显式把感知的结果通过vector encoder来做信息交互,然后通过一个vector former来将信息转化为gpt llm能处理的形态,类似adpater。文章提到了整个数据采集标注的方法,通过在仿真里做agent闭环采集实验。整个结果还是分几步可解释性的预测。

recommend level:高,细节描述比较清楚

Talk2BEV: Language-enhanced Bird's-eye View Maps for Autonomous Driving

comment: 202311 印度学者:利用lvlm来对bev图上的每个object做text的desciption增强,然后再送入到llm中,做一些query-answering的测试。并未完全设计到端到端的控制当中。但是相对其他paper专门对ojbect做增强。但是这样会使整个的计算量变得更大一些。

recommend level:中

LANGUAGEMPC: LARGE LANGUAGE MODELS AS DE-CISION MAKERS FOR AUTONOMOUS DRIVING

comment: 202310清华:提出languagempc,通过引入大语言模型的cot推理能力,将整个理解和规划任务拆解成很多子任务,比如某个障碍物该不该响应,静态场景的表达,与mpc控制器的联合训练等等。整体文章好像没写感知sensor的检测是怎么来的。代码也没有开源。

recommend level:中

BEVGPT: Generative Pre-trained Large Model for Autonomous Driving Prediction, Decision-Making, and Planning

comment: aaai2024, 202310 香港科技大学:bevgpt, 输入感知输出的bev结果(动态加先验地图),然后通过gpt based的网络直接预测出6s后主车的位置&下一帧的bev结果,最后在线构建最小化jerk的非线性优化,来进一步优化得出具体主车的轨迹。具体感知结果如何token化没有讲的很清楚。另外先验的栅格化地图在无图背景下就不能当先验了。文章只和uniad做对比,在lyft数据集上做的验证。

recommend level:中

GPT-DRIVER: LEARNING TO DRIVE WITH GPT

comment: 202311 南加州和清华赵行:将大语言模型纳入到轨迹规划中。这篇会将感知和预测的结果token化,送入gpt3.5,生成固定的3段式格式的推理:看到了哪些感知结果/哪些对主车会造成影响/主车的最终估计预测。然后通过finetuning的方式来做做最终的infer决策。

recommend level:中

Drive Anywhere: Generalizable End-to-end Autonomous Driving with Multi-modal Foundation Models

comment: 202311 mit: 提出了一种feature级别仿真(类别图像提取的fpn特征)增强,来提高open-set的识别能力。整体链路图像和文本送入到clip等特征器中提取,然后通过策略网络输出控制信号(策略没讲,简单的pid)。文中还说在直行等场景还上车了,3fps。

recommend level:中

On the Road with GPT-4V(ision): Early Explorations of Visual-Language Model on Autonomous Driving

comment: 20231109 上海ai实验室botian shi: 一个gpt4v 在ad场景下各个模块的系统测试报告,usal reasoning,challenges remain, particularly in direction discernment, traffic light recognition, vision grounding, and spatial reasoning tasks.

recommend level:中

[推荐]A Language Agent for Autonomous Driving

comment: 202312usc&&nvidia: agent-driver提出了一个全部以text来通信的整个ad框架。包含llm和对应的nn模块(特别是感知的动态目标检测,静态感知模块),整体包含 7个大模块:enviromental information/common sense / chain-of-thoughts reasoning / task planning / motion planning/self-reflection。其中环境感知模块是包含uniad里的感知和预测模块处理传感器数据,通过一个叫tool libary的模块(llm-based instruct),类似一个perception-engine模块以dynamic function call的方式提供文字based的结果,比如leading-car/front-car等等信号。common-sense是包含一个可以人为先验设定的text token库和一个包含历史drving-scene的场景库(这些都是提前训练好的,类似rule-base决策的根据交互类型和背景信息来走不同的决策分支)。chain-of-thoughts reasoning接受上游2个模块,做一些推理分析。task planning是一个顶层的high-level的规划结果,比如大概怎么走,以一定的加速度往前走。motion-planning也是接受上游所有输入,综合得出text-based waypoint。最后还加了一个基于优化的兜底轨迹模块,缓解大模型出来的幻觉现象导致的高危事故。整体看来算是比较靠谱和详细的实现思路。但是里面的用到的llm不止一处,每处都要做instrcuct learning(in-context或者finetune),计算量和训练难度都有点大。文章也提到的limitation-时延。整个还是用language的方式去处理规划决策问题,上游感知和预测还是利用uniad或者cnn的方式来做。文章效果是与gpt-driver来对比的。另外规划的测试指标还是开环的(l2轨迹误差和碰撞率)

recommend level:高,把模块化和可解释性拆解的比较细

[推荐]DriveMLM: Aligning Multi-Modal Large Language Models with Behavioral Planning States for Autonomous Driving

comment: 202312 上海ai实验室&清华daijifeng:提出了一个直接接原始raw-data,然后输出bp信号,最后接apollo后续模块的闭环验证工作。相比drivelm,直接处理时序sensor data和可输入一些promot,直接输出做出目前bp的原因。整体训练如何阶段性训练没有说的太详细(比如如何处理encoder和decoder的训练节奏),代码还没有放出来。基于llmma开源模型。整个相对于apollo的sfm的bp模块做对比。

recommend level:高,首次闭环验证的工作

[推荐]DOLPHINS: MULTIMODAL LANGUAGE MODEL FOR DRIVING

comment: 20231201 nvidia:基于一个vlm模型基于视觉数据+ad 场景数据,做了in-context instruction learning, 使得出来的多模态模型对于ad领域的感知/预测/规划都有一定的reasoning能力,没有实际ad领域的测试

recommend level:高,利用ad数据做了instruct learning工作

[推荐]LMDrive: Closed-Loop End-to-End Driving with Large Language Models

comment: 202312港中文&商汤:lmdrive ,一个用llm做planning的工作,区分之前的gptdrvier4等llm来做决策规划端到端的paper,这篇工作能闭环验证,且开放出代码,基于calra软件。原始信号处理还是单独的模块(利用障碍物检测/红绿灯检测/主车waypint预测head来监督),然后接入一些人类的instruction和notice(注意/小心等等)nlp的信号,送入一个llm,然后输出可翻译成控制信号的text,最后利用pid来做控制。整体比较make sense,而且一个小细节,instuction会引入一些带噪声的信息(人类有时候也会说错话)。算是一遍我看了这么多中,比较有深度的paper了。

recommend level:高,多模态输入且闭环验证

[推荐]DriveLM: Driving with Graph Visual Question Answering

comment: 202312上海ai实验室:发布了drivelm数据集,并做了一版本baseline。即将自动驾驶分成5个模块,在加上多个障碍物,形成了graph约束。每个模块都通过llm做一些qa的工作,而且各个模块都可以单独训练评测。并把这个数据集搞成了cvpr新的比赛

recommend level:高,baseline工作

方向5 - 端到端联合训练自动驾驶(不一定是大模型)(5篇,强推荐3篇)

ALVINN:AN AUTONOMOUS LAND VEHICLE IN A NEURAL NETWORK

comment: 1988cmu:利用3层mlp接入图像和毫米波雷达,输出lane fllowing的方向,算是最早的一篇端到端的文章了

recommend level:中

[推荐]ST-P3: End-to-end Vision-based Autonomous Driving via Spatial-Temporal Feature Learning

comment: eccv2022 taodacheng&junchiyan等:算是比较早的模块化端到端planning的方案,整体利用纯视觉环视输入。首先多帧多时序的特征融合,然后建模运动的不确定度,通过双对偶网络去做预测,最后通过预测出的特征+预测出的bev地图做planning的轨迹预测,最后通过commond 命令做筛选,通过与前向视觉feature(包含红绿灯)进行refine。整体感知,预测,planning每个模块都有单独的loss监督,感知可以出lane和driving-space(2维上)的,预测也是预测的segmantion结果。各个模块输出结果都有评测对比,另外也做了planner的闭环(carla)实验。整体算是整个联合训练,避免传统间结构化信息的漏缺。

recommend level:高,首次提出端到端联合训练

[推荐]Planning-oriented Autonomous Driving

comment: cvpr2023 best paper上海ai实验室(review by 20231231): 整体通过query的方式将自动驾驶里的主要任务都联系起来。检测/跟踪,静态检测,motion prediction/ occ prediction,planning。附录中比较详细的介绍了各个模块的参数细节。整个参数量达到一亿。每个模块的评测都做的比较详细。最后planner的attention 可视化的确是一个亮点。整体算是掀起了模块化训练的开幕。忘记写了是基于什么数据集做的训练了。代码已经开源。

recommend level:高,附件细节描述比较好,代码开源

VAD: Vectorized Scene Representation for Efficient Autonomous Driving

comment: iccv2023 地平线:类似uniad,但比uniad更简单的一个端到端的感知预测planing的模块,通过query的方式来共享,但全局都是用vector(query)的方式表达。效果相对uniad差不大,但是会快不少。利用主车的eg0_query与感知motion-query先做交互得query1,后和statcic-map-query做交互得query2,然后结合ego-state, 直接做planning。中间每个模块也会有自己的约束loss,而且planning部分还加了一些先验的loss。但还是一样的,基于开环的测试指标不太具有可比性。

recommend level:中

[推荐]Rethinking the Open-Loop Evaluation of End-to-End Autonomous Driving in nuScenes

comment: 202305 百度王井东:很有意思的一篇文章来验证现在基于nuscne的planner开环评价指标的不合理性。文中提出一个只接入主车历史4帧的轨迹状态,和一个high-level的commond信号,过几层mlp,直接预测接下来3秒的waypoints,测试的基本基本跟现在基于感知结果的端到端planning方案差不多。一个闭眼开的控制系统和睁眼开的差不多,想想多荒谬。所以闭环测试planner才是正途。

recommend level:高,专门验证开环评测planning不靠谱

FusionAD: Multi-modality Fusion for Prediction and Planning Tasks of Autonomous Driving

comment: 202308 有鹿智能:基于uniad改进做一个融合lidar和vision的端到端系统,改进点:1. 感知加入lidar和时序特融合 2. 层级融合,即预测和planning都接入原始的感知feature 3.预测去掉了先验经验轨迹anchor,而是加入了一个refine 的网络结构来进一步预测displacement(个人感觉用处不大) 4. planning的约束还加入了主车与他车碰撞的loss 5. 最后还利用occ预测的结果利用非线性优化来优化模型出来的轨迹保证合理性和平滑。整体评价下来,感知和预测任务比uniad的效果要好不少,不确定是加了lidar的信息源还是什么。

recommend level:中

参考资料

世界模型和DriveGPT这类大模型到底能给自动驾驶带来什么?

引起OpenAI总裁关注和评论:GPT-4V在自动驾驶真实场景下的测评!

① 2025中国国际新能源技术展会

自动驾驶之心联合主办中国国际新能源汽车技术、零部件及服务展会。展会将于2025年2月21日至24日在北京新国展二期举行,展览面积达到2万平方米,预计吸引来自世界各地的400多家参展商和2万名专业观众。作为新能源汽车领域的专业展,它将全面展示新能源汽车行业的最新成果和发展趋势,同期围绕个各关键板块举办论坛,欢迎报名参加。

② 国内首个自动驾驶学习社区

『自动驾驶之心知识星球』近4000人的交流社区,已得到大多数自动驾驶公司的认可!涉及30+自动驾驶技术栈学习路线,从0到一带你入门自动驾驶感知(端到端自动驾驶、世界模型、仿真闭环、2D/3D检测、语义分割、车道线、BEV感知、Occupancy、多传感器融合、多传感器标定、目标跟踪)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、大模型,更有行业动态和岗位发布!欢迎扫描加入

③全网独家视频课程

端到端自动驾驶、仿真测试、自动驾驶C++、BEV感知、BEV模型部署、BEV目标跟踪、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、车道线检测、轨迹预测、在线高精地图、世界模型、点云3D目标检测、目标跟踪、Occupancy、CUDA与TensorRT模型部署、大模型与自动驾驶、NeRF、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频(扫码即可学习)

④【自动驾驶之心】全平台矩阵

497

497

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?