目前RALM主要存在两个问题:

- 搜索结果误导性:搜索结果依赖其召回和排序,所以不一定和问题相关,不相关的结果融合到大模型中会给大模型带来误导导致错误的答案(甚至有的时候大模型依靠内部记忆能够正确回答);

- 回复幻觉问题:针对无法回答的问题(不管是搜索结果还是内部记忆),大模型有时也会一本正经的胡说八道。

本篇paper CON(Chain-of-Note)主要就是解决上面两个问题:

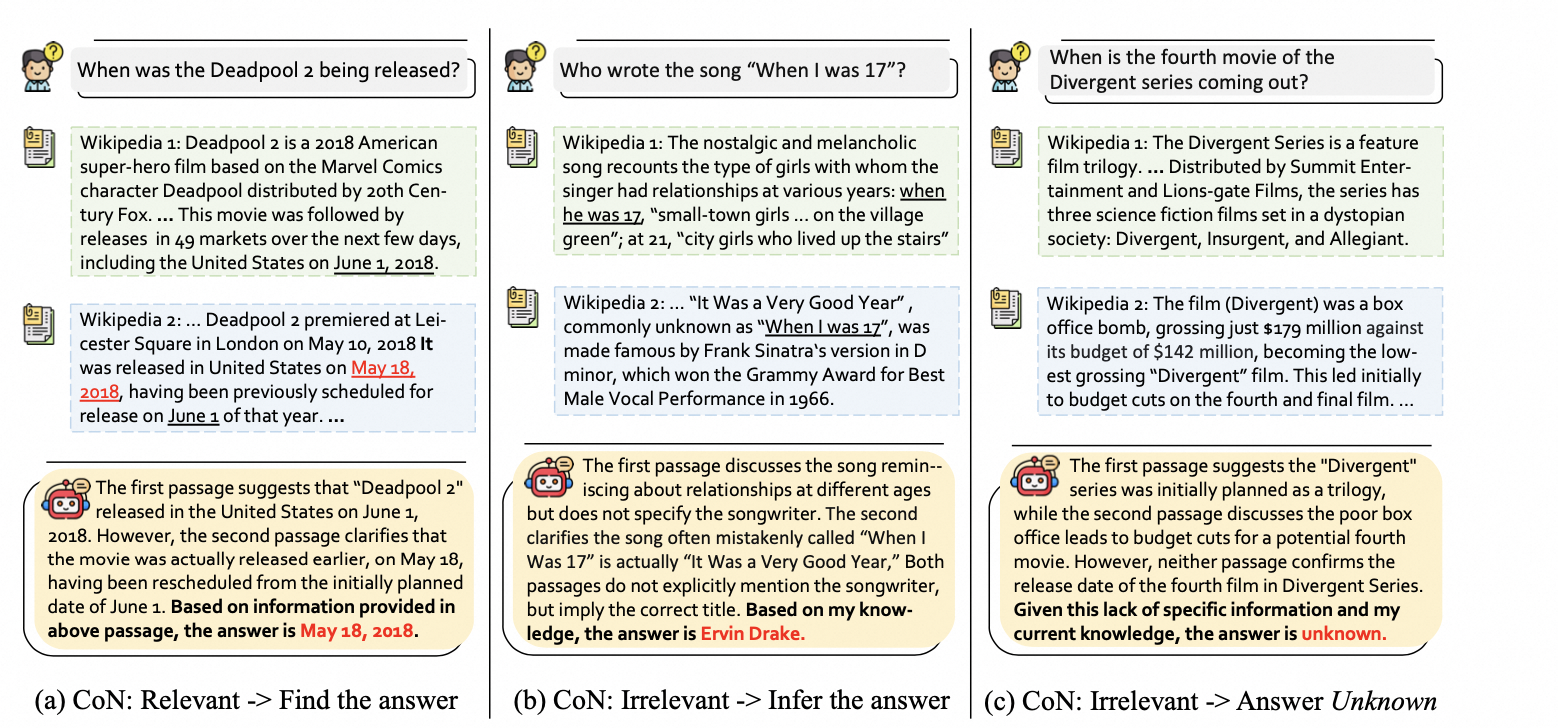

如下图所示,有三种情况

- 搜索结果能够回答问题,能够直接回答问题

- 搜索结果和问题相关,但是不能直接回答问题,但是结合内部记忆,能够回答问题

- 搜索结果和问题不相关,内部记忆也无法回答问题,直接回答Unkoown

针对上面的两个问题,该方法的优势是:

- 通过针对搜索结果生成理解文档,保证在回答问题前只参考相关的搜索结果,这样可以解决不相关搜索结果带来的误导;

- 当搜索结果和内部记忆都不能回答问题时,让大模型输出搜索结果和问题不相关,且自身都无法回答问题,最后输出unknown,这样可以解决大模型胡乱回复的问题。

论文题目:Chain-of-Note: Enhancing Robustness in Re

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1898

1898

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?