拟复现:Discontinuous Named Entity Recognition as Maximal Clique Discovery——不连续实体--缺少数据,先等一天,看邮件有无回复。

也乜有调通,数据处理了。

7号:上午论文复现。下午4点读EMNLP的NER论文。

有一个想法,是吧flat,nest和不连续实体分为不同的level,分别迭代生成。这样效果会好吗?

参考CRF——level那篇论文和An End-to-End Progressive Multi-Task Learning Framework

Named Entity Recognition with Small Strongly Labeled and Large

Weakly Labeled Data——工程----复现

没有调通代码。

8号:

明天需要测试模型在数据上效果,看是否可行(大概一上午)——在二元组上效果不太佳。

之后,是晚上——论文调研报告。

还有。

下午需要读和整理两篇论文,之后,有时间,需要你重新看昨天的任务。。

9号:上午看论文(挑自己感兴趣的看,不是全都摘过来。),下午整理调研报告(论文的题注啥的,都整理好。还有参考文献。)。。还是需要复盘下前两次的复现。

看论文的几个问题:

研究问题是什么?——研究创新点(时间效率、模型性能、空间效率(这点较少有提到))?——现有研究的不足——具有的研究方法——论文方法的不足——总结(有无改善点,其余学者在该问题上的解决方法)

可能会对模型效果产生影响的属性——参考论文:http://explainaboard.nlpedia.ai/leaderboard/task-ner/index.php#charts_single_analysis

10号:NER论文整理处理。论文初稿完成。

11号:整理调研报告,和一周小结。(之前没复现成功的论文,可以重新看了。)

>倒是觉得这篇文章,可以用在nosiy label的识别上,不对,应该是数据量较少的label识别上,这篇文章可以作为NER正式开场之前的“预训练”阶段。(预训练打上引号)——让模型适应该任务之后,在做task domain的NER任务。比如BART的generative,现在一些domain做pre,之后,在specific domain做训练。Coarse-to-Fine Pre-training for Named Entity Recognition

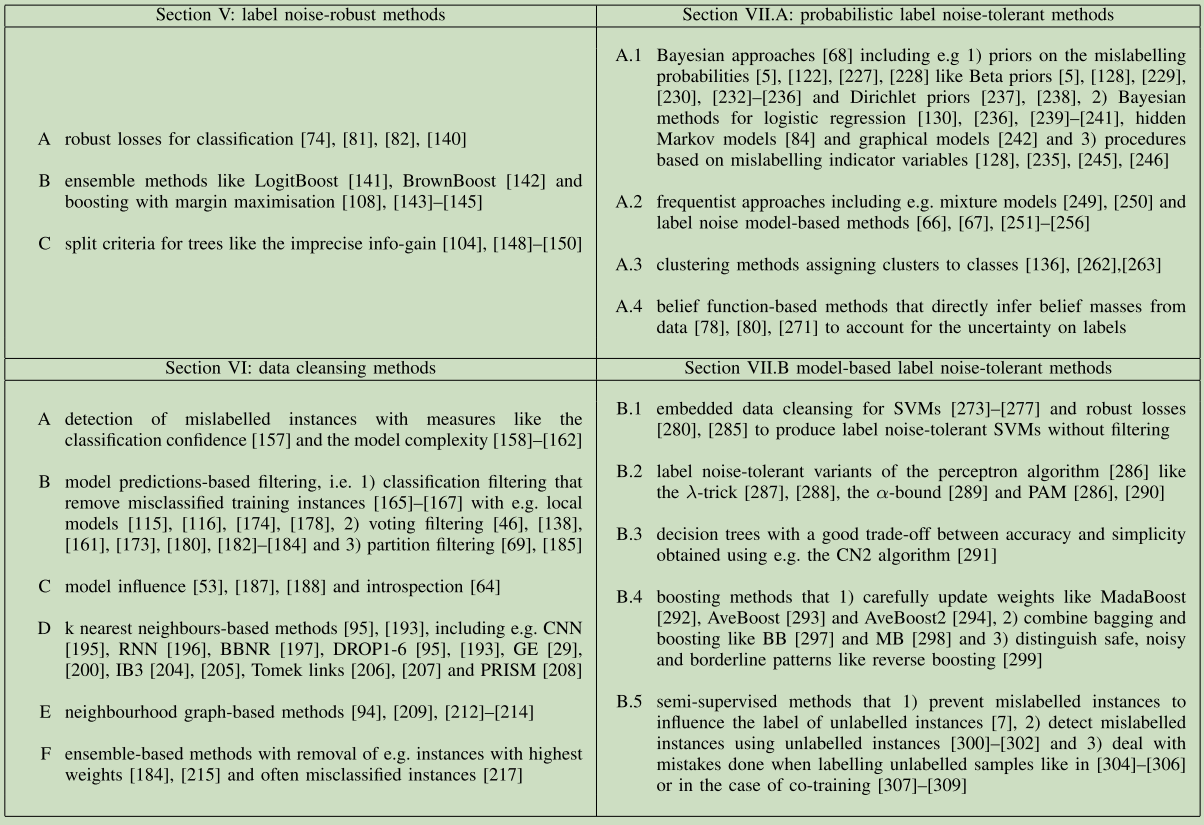

noise label 上的处理方式:(30条消息) [论文阅读笔记58]Learning from Noisy Labels with Deep Neural Networks:A Survey_happyprince的博客-CSDN博客

还有一个想法时Noise 问题的处理,见整理报告。

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?