BLEU: a Method for Automatic Evaluation of Machine Translation

在相似度系列1中,刘老师的文章中,我感觉,维度似乎是一个很重要的指标,维度的设计应该是对实验结果产生影响,但是,作者的关注点似乎更注重怎么实现各个维度的统一evaluate?

他的难点:1是每个维度下数据的构建?2 每个维度下如何评测?

这篇文章是早期的BLEU评测,常用于机器翻译,本质是overlap,基于precision。

为什么会有这篇文章:human evaluation is expensive.

这篇文章看的目的是这里边有很多假设,这些假设一般在后续的改进或者其他新的评测指标中,都是遵循的。

(1)机器翻译的维度:including adequacy, fidelity , and fluency of the translation

(2)怎么评测机器翻译的表现?measure translation performance。机器翻译越接近于人的翻译,说明翻译效果越好。

(3)evaluation metric需要什么?——和人类评估水平非常接近的矩阵;接近于人类翻译水平的语料。

这篇文章围绕BLEU的提出,展开了很清晰的介绍,包括,他的组成,怎么一步步提出来的?

基本前提——在衡量翻译质量时

1 n_grams:在候选答案和参考答案中,当有n_grams越接近时,说明翻译效果越好。

2 当翻译中使用相同的一元单词越多的情形下,说明candidate 和reference越满足 adequacy

3 当翻译中的candidate和reference中最长的n_gram越长的时候,说明越满足fluency。

4 当有越多的reference时,模型的relevance分值越高。

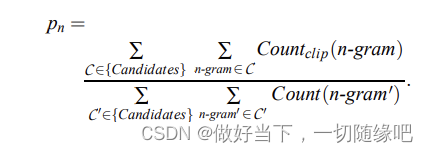

计算准确率(n_grams)

计算n_grams情形下的准确率,是将所有candidate中的n_gram和reference的n_gram对照,然后匹配上的n_gram数量/所有的n_gram数量。

计算权重下的准确率

需要将所有的reference下的结果求和,然后作为整个翻译性能的计算。考虑每个reference下的权重。

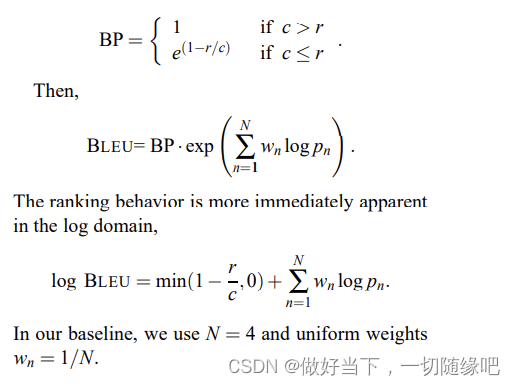

recall不太容易计算,然后 就把recall以一种惩罚项的形式融入到了BLEU函数中。

惩罚项是根据句子的长度设立的,当candidate的句子长度小于reference时,设立惩罚,句子长度越小,惩罚越大。

总结

BLEU还是有一些不足的,虽然考虑了n_grams的匹配数量,但是在句法、单词顺序、同义词方面,考虑的不是很多。后面的改进,而且,他算是单一维度的评价指标吧。虽然在开头提到需要考虑四个维度:连贯性、完整性(一元gram相同的越多时)、流畅度(最长的n_gram越长的时候)…,但在计算中,这四个维度,体现的还不是太好。

884

884

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?