15.Restormer

1.创新点:

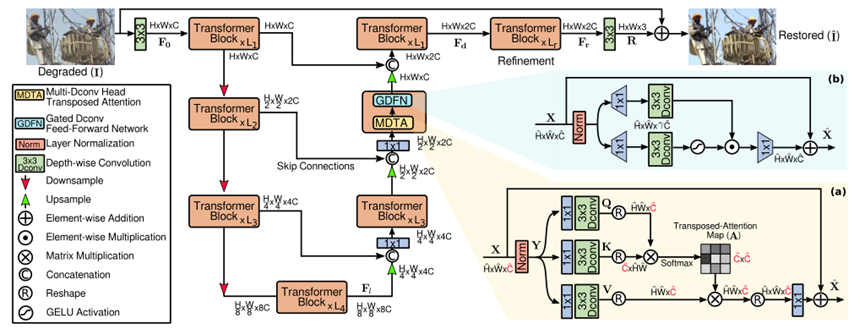

1.提出了Restormer,一种编码器-解码器转换器,用于高分辨率图像上的多尺度局部全局表示学习,而无需将它们分解到局部窗口,从而利用遥远的图像上下文。

2.我们提出了一个多dconv头部转移注意力(MDTA)模块,它能够聚合局部和非局部像素交互,并且足够有效地处理高分辨率图像。

3.一种新的门控dconv前馈网络(GDFN),它执行受控的特征转换,即抑制信息较少的特征,只允许有用的信息在网络层次结构中进一步传递。

4. 通过渐进式学习在混合大小的补丁上训练的模型在测试时表现出了增强的性能,其中图像可以具有不同的分辨率(图像恢复中的常见情况)。随着补丁大小的增加,我们减少批大小,以保持每个优化步骤与固定补丁训练的时间相似。

2.整体网络结构:

1. 编码器-解码器的每一层都包含多个Transformer块,其中块的数量从上到下逐步增加,以保持效率。

2. 连接操作之后是1×1卷积,以减少所有级别的通道(一半),除了顶部的。

3. MDTA:键是跨通道而不是空间维度应用SA,即计算跨通道的交叉协方差,生成隐式编码全局上下文的注意图。在计算特征协方差生成全局注意图之前,对局部上下文进行深度卷积。

4. GDFN:改进点:(1)门控机制;(2)深度卷积。

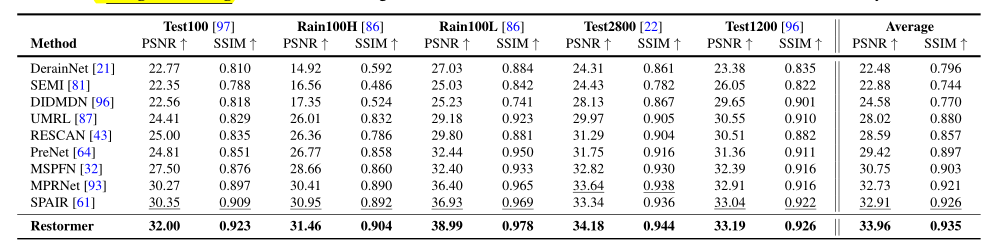

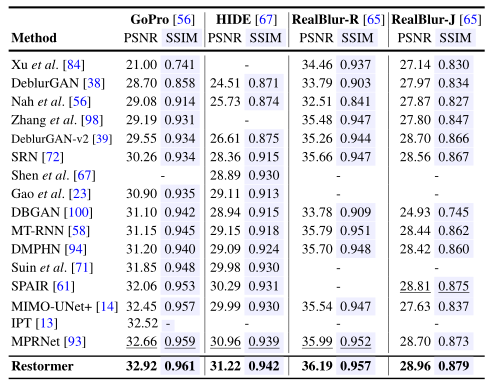

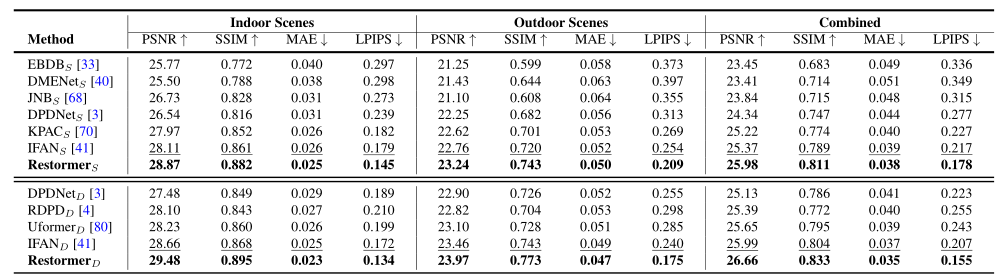

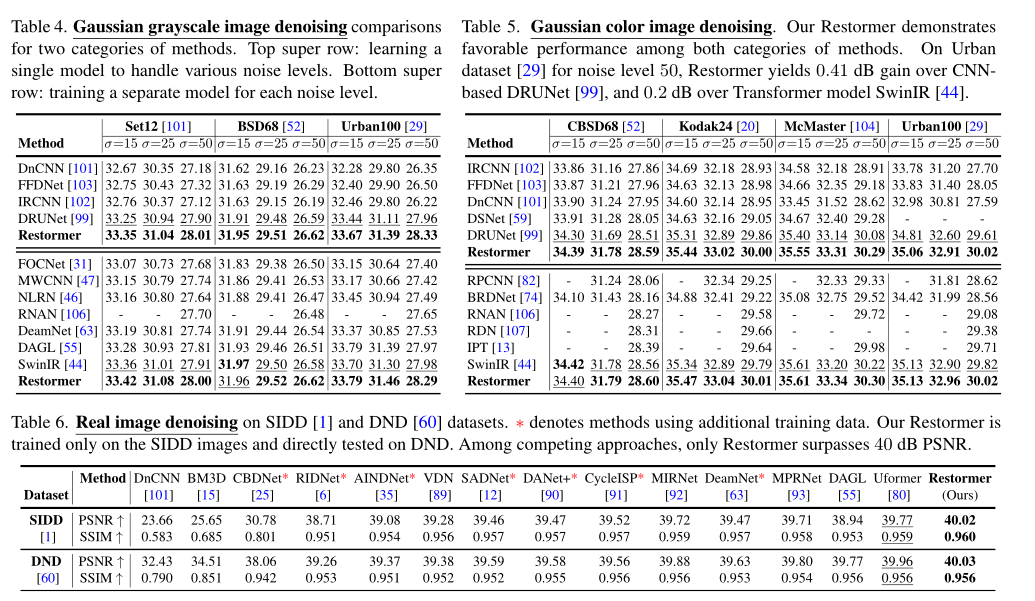

3.实验对比:

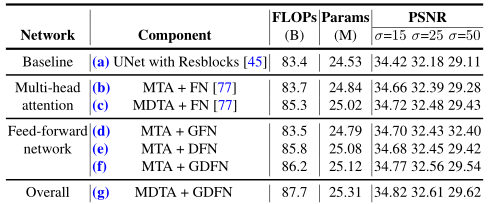

4.消融实验:

通过深度卷积将局地性引入MDTA可以提高鲁棒性,因为去除会导致PSNR下降。

5.学习总结:

1. Transformer模型虽然弥补了CNN的缺点(接受域有限,不适应输入内容),但其计算复杂度随空间分辨率的增加呈二次增长,因此无法应用于大多数涉及高分辨率图像的图像恢复任务。

2. 卷积算子有一个有限的接受域,从而阻止它对长像素依赖性的建模。卷积滤波器在推理时具有静态权值,因此不能灵活地适应输入内容。为了解决上述缺点,一种更强大和动态的替代方法是自注意(SA)机制,它通过所有其他位置的加权和来计算给定像素处的响应。

3. 很少有工作去为图像恢复做专门的transformer,如果通过限制SA的空间范围来方便使用,与捕捉真正的长程像素关系的目标是矛盾的,特别是在高分辨率图像上。

4. 与SwinIR相比,Restormer的flop次数少了3.14倍,运行速度快了13倍。

2734

2734

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?