check_newest ,泛读最新论文,暂不涉及深层思考!

摘要

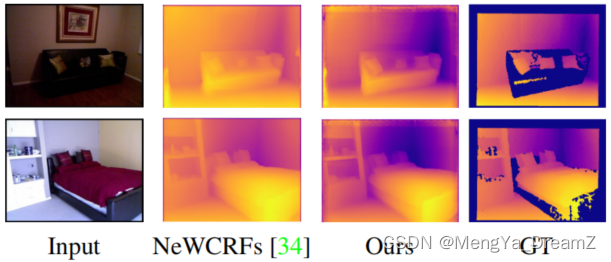

单眼深度估计(MDE)的目的是预测给定一个单一RGB图像的像素级深度。对于这两种情况,卷积模型和最近的基于注意力的模型、基于编码器-解码器的架构都被是有用的,因为它们同时需要全局上下文和像素级分辨率。通常,跳过连接模块用于融合编码器和解码器的特征,其中包括特征映射连接,然后是卷积操作。受注意力在许多计算机视觉问题中的好处的启发,作者提出了一种基于注意力的编码器和解码器特征的融合。将MDE作为一个像素查询细化问题,其中最粗级编码器特征用于初始化像素级查询,然后通过提出的跳过注意模块(SAM)将其细化到更高的分辨率。将预测问题表述为离散连续深度范围的bin中心的有序回归,并引入一个bin中心预测器(BCP)模块,该模块使用像素查询在最粗的级别上预测bin。除了图像自适应深度bin的好处外,所提出的设计有助于学习改进的深度嵌入在初始像素查询中,通过直接监督从地面真相。在两个规范数据集NYUV2和KITTI上进行的大量实验表明,文章的架构分别比最先进的架构高出5.3%和3.9%,并且在SUNRGBD数据集上的泛化性能提高了9.4%。

介绍

- 由于卷积核固有的局部性质,早期的特征图具有更高的分辨率,但缺乏一个全局的接受域。

- 基于金字塔的特征解码器通过自上而下的路径和横向连接,将低分辨率、语义丰富的解码器特征与更高分辨率但语义较弱的编码器特征融合,从而缓解了这一问题。

- 随着transformer的成功,许多最新工作都为MDE使用了基于自关注的架构。

- 自我注意增加了接受域,并允许在特征图中捕获远程依赖关系。实际上,由于内存和计算的限制,使用高分辨率特征图是具有挑战性的。因此,目前的SOTA 使用基于窗口的注意力,使用基于Swin transformer的编码器骨干来提高效率。我们观察到,SOTA技术在对齐深度边缘与物体边界方面是高度精确的。然而,对于单个像素定义标签存在一定的混淆。

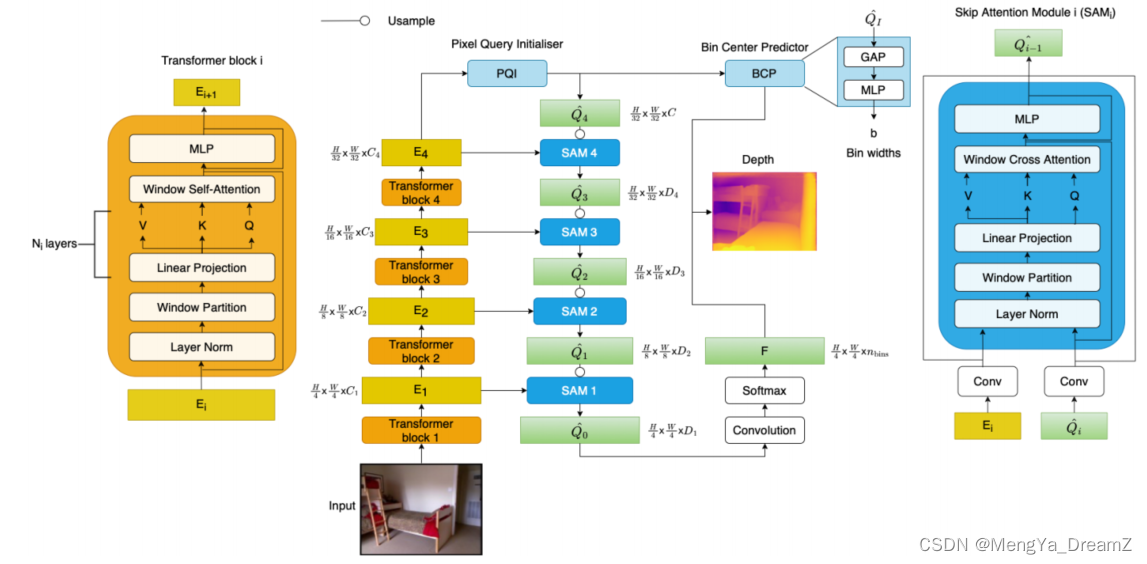

- 假设这是由于目前的技术无法有效地融合来自编码器的高分辨率局部特征和来自解码器的全局上下文特征。通常,这种融合是通过一个跳过连接模块来实现的。特征连接之后进行卷积操作。卷积核的权重是高度局部化的,这限制了语义信息的远距离流动,影响了模型预测一个像素的正确深度标签的能力。为了减轻这种约束条件,作者引入了一个跳过注意模块(SAM),它可以使用基于窗口的交叉注意来帮助集成信息。SAM基于预定义窗口中解码器特征与编码器特征对应邻居的像素查询之间的自相似性,以在更远的范围内关注和聚合信息。作者将整个架构作为一个像素查询细化问题来实现。作者使用来自具有最大全局信息的编码器的最粗的特征映射,使用像素查询初始化器模块来初始化像素查询。然后,在SAM模块的帮助下,将像素查询细化到更精细的规模。

- 最近的MDE技术将这个问题表述为一个分类回归问题,其中深度是通过在深度范围内离散的bin中心的线性组合来预测的。每个图像自适应地预测bin中心,允许网络集中在输入图像场景中更有可能出现的深度范围区域。从另一个基于解码器的transformer模型的输出聚合全局信息的vision通常用于生成bin中心。由于作者将MDE作为一个从最粗糙的分辨率开始的像素查询细化问题,提出了一个轻量级的Bin中心模块(BCP),它基于初始像素查询预测Bin中心。这比解码功能,然后在当前的SOTA 中再次参加更有效。该设计还有助于通过直接地面真实监督将深度信息嵌入初始像素查询。

总结

- 提出了一种新的策略,通过预测深度,将其视为像素查询重新细化问题。

- 引入了一个跳过注意模块(SAM),它使用基于窗口的交叉注意模块来从解码器特征图中细化像素查询,以交叉关注更高分辨率的编码器特征。

- 提出了一个Bin中心预测器(BCP)模块,该模块使用来自粗糙级特征图的全局信息自适应地估计每个图像的Bin中心。这有助于从地面真实深度对初始像素查询提供直接的监督,从而导致更好的查询嵌入。

- 将新的设计元素结合在一个解码器框架组成的视觉变压器骨干。提出的像素结构在室内NYUV2和室外KITTI数据集上实现了最先进的(SOTA)性能,在绝对相对误差和平方相对误差方面分别提高了当前SOTA的5.3%和3.9%。

- 此外,在绝对相对误差方面,像素在SUNRGBD数据集上的泛化性能比SOTA提高了9.4%。

相关工作

- 将MDE建模为一个回归问题会导致次优解,并面临收敛性问题。

- 跳过连接:

- 由UNet引入的跳过连接,通过特征融合将高分辨率的信息从编码器转发到解码器。然而,早期编码器和晚期解码器信息的朴素融合受到其语义间隙的阻碍。

- Multiu UNet用一系列残差块取代了简单的跳过连接,以减轻语义差距。

- Attention U-Net 抑制输入图像中的不相关区域,同时突出显示在特征融合前对特定任务有用的显著特征。

- SANet 利用注意力计算点云,利用编码器的信息给到解码器。

- 在这项工作中,作者使用跳过注意力使用基于解码器特征的全局上下文查询从编码器特征检索高分辨率的细节。

方法

- 作者将单目深度估计视为分类-回归任务。

113

113

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?