一、Transformer概述

1.什么是Transformer?

Transformer是2017年由Google提出的深度学习模型架构,彻底改变了自然语言处理领域。其核心创新在于:

完全基于注意力机制:摒弃传统的RNN/CNN结构

并行处理能力:同时处理整个序列而非逐词计算

长程依赖建模:有效捕捉序列中任意位置的关系

2.与传统模型的对比

| 特性 | RNN/LSTM | Transformer |

|---|---|---|

| 处理方式 | 顺序处理 | 并行处理 |

| 长程依赖 | 容易遗忘 | 完美捕捉 |

| 训练速度 | 慢(无法并行) | 快(完全并行) |

| 典型应用 | 早期NLP任务 | 现代大模型基础 |

二、技术架构详解

1.编码器结构

class EncoderLayer(nn.Module):

def __init__(self):

self.attention = MultiHeadAttention()

self.ffn = PositionwiseFFN()

self.norm1 = LayerNorm()

self.norm2 = LayerNorm()

def forward(self, x):

attn_out = self.attention(x)

x = self.norm1(x + attn_out) # 残差连接

ffn_out = self.ffn(x)

return self.norm2(x + ffn_out) # 残差连接2.解码器结构

掩码注意力:防止信息泄露(只能看到当前位置之前的token)

交叉注意力:连接编码器与解码器的信息流

三、关键技术实现

1.自注意力计算

Attention(Q,K,V) = softmax(\frac{QK^T}{\sqrt{d_k}})V其中:

Q:查询向量

K:键向量

V:值向量

d_k:向量维度

2.多头注意力

分头策略:

def split_heads(x, num_heads):

return x.view(batch_size, -1, num_heads, depth)优势:

并行学习不同表示子空间

头部可专业化(如语法/语义)

3.位置编码

正弦/余弦函数生成:

PE(pos,2i) = sin(pos/10000^{2i/d_model})

PE(pos,2i+1) = cos(pos/10000^{2i/d_model})四、未来前景展望

1.技术演进方向

效率优化:

稀疏注意力(如Longformer)、混合专家系统(MoE)

多模态扩展:

视觉Transformer(ViT)、跨模态统一架构

推理能力增强:

符号逻辑注入、因果推理模块

2.行业应用前景

| 领域 | 应用场景 | 典型模型 |

|---|---|---|

| 自然语言 | 机器翻译、文本生成 | GPT、T5 |

| 计算机视觉 | 图像分类、目标检测 | ViT、DETR |

| 生物信息 | 蛋白质结构预测 | AlphaFold |

| 金融科技 | 风险预测、智能投顾 | FinBERT |

要么驾驭AI,要么被AI碾碎

当DeepSeek大模型能写出比80%人类更专业的行业报告,当AI画师的作品横扫国际艺术大赛,这场变革早已不是“狼来了”的寓言。2025年的你,每一个逃避学习的决定,都在为未来失业通知书签名。

记住:在AI时代,没有稳定的工作,只有稳定的能力。今天你读的每一篇技术文档,调试的每一个模型参数,都是在为未来的自己铸造诺亚方舟的船票。

1.AI大模型学习路线汇总

L1阶段-AI及LLM基础

L2阶段-LangChain开发

L3阶段-LlamaIndex开发

L4阶段-AutoGen开发

L5阶段-LLM大模型训练与微调

L6阶段-企业级项目实战

L7阶段-前沿技术扩展

2.AI大模型PDF书籍合集

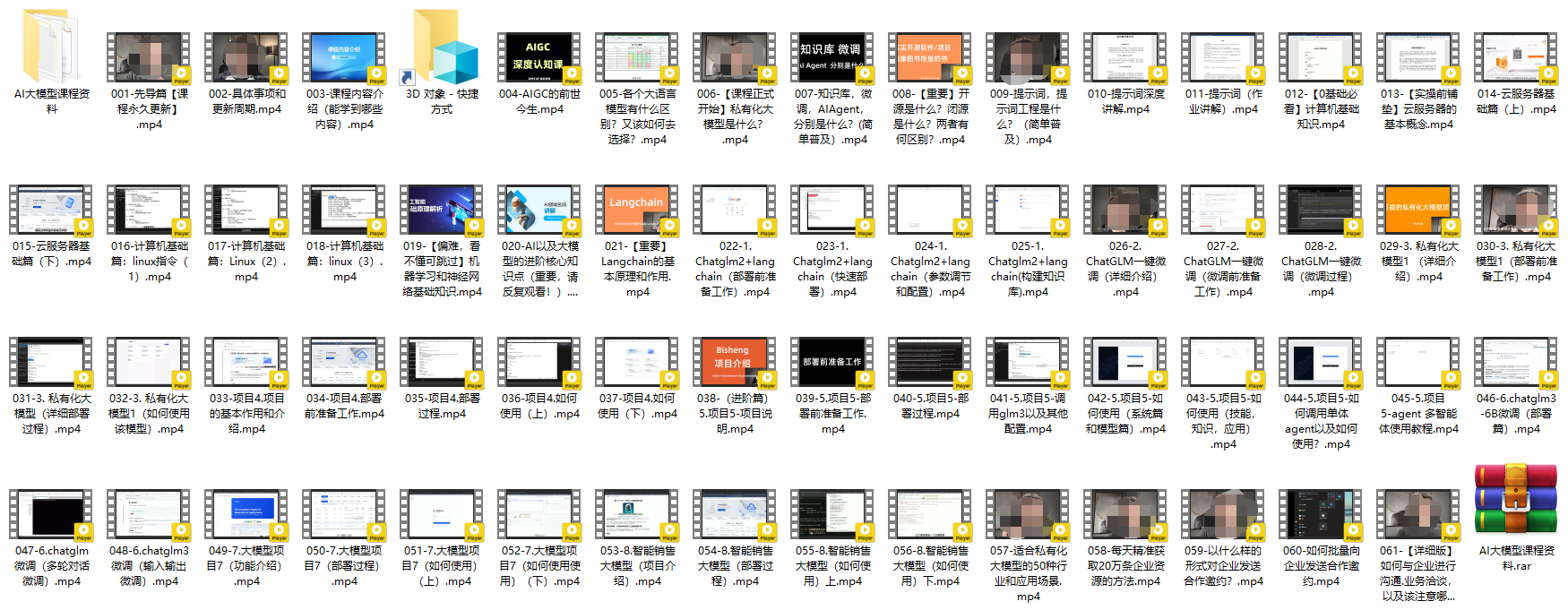

3.AI大模型视频合集

4.LLM面试题和面经合集

5.AI大模型商业化落地方案

📣朋友们如果有需要的话,可以V扫描下方二维码联系领取~

725

725

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?