前言

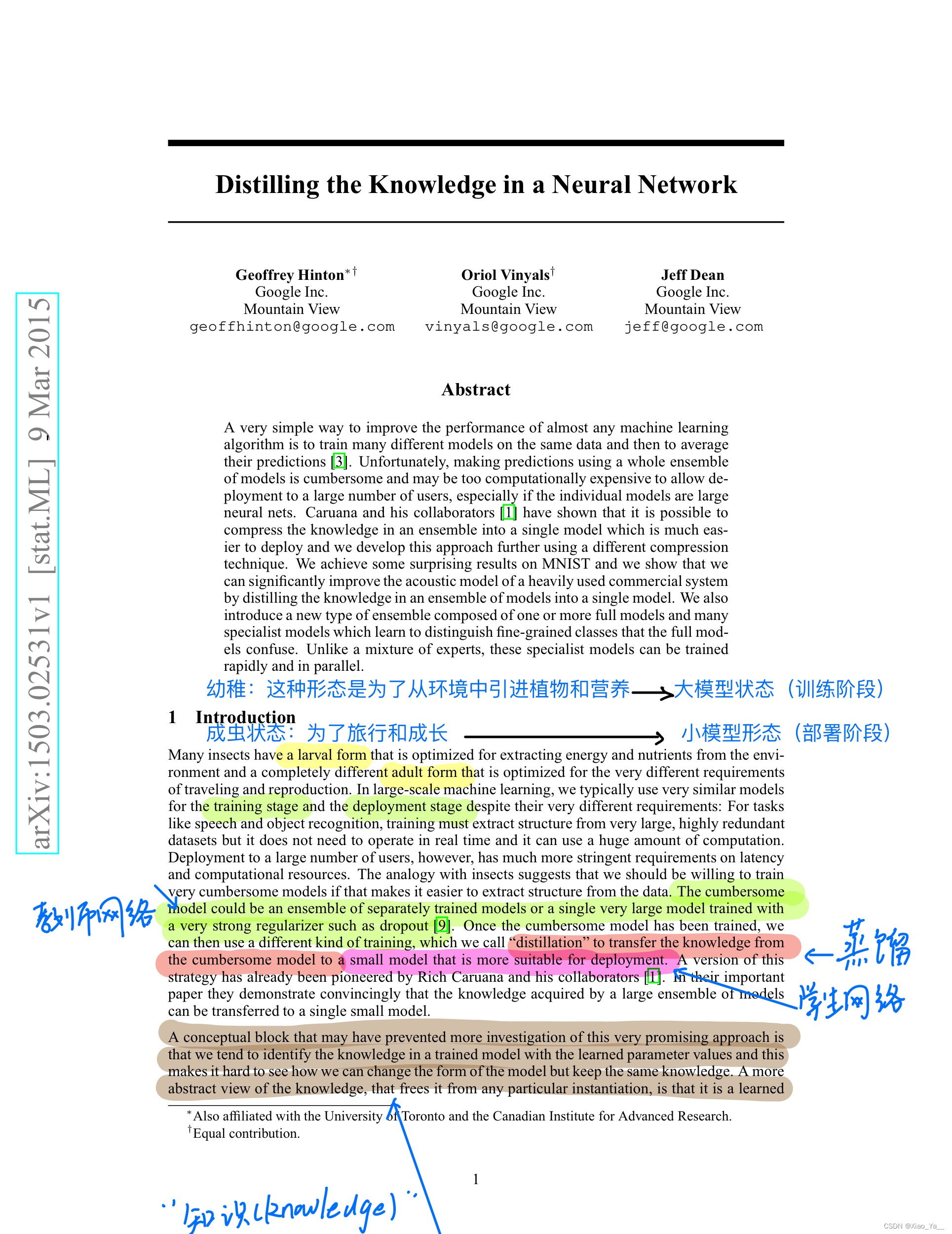

论文名:Distilling the Knowledge in a Neural Network

论文作者:Geoffrey Hinton et.al.

期刊/会议名:NIPS 2014

发表时间:2015-03

论文地址:https://arxiv.org/abs/1503.02531名词解释

-

teacher:大而笨重的模型

-

student:小而紧凑的模型

-

transfer set:用于小模型训练的数据,也是获得teacher模型soft target输出的输入数据集

-

hard target: 样本原始标签

-

soft target:teacher模型输出的预测结果

-

temperature: softmax函数中的超参数

-

knowledge:可以理解为从输入向量到输出向量学习到的映射

符号定义

-

z : logit,模型去除输出层的输出

-

p: probability,每个类的概率

1.Abstract

(1)面临的现状:

传统的提高机器学习效果的简单方法一般是在相同的数据上使用不同的模型,最后平均他们的预测结果,这也就是集成模型。但是集成模型十分的笨重,会消耗很多计算资源,并且不适合部署在用户端,特别是当单个网络特别大的时候。

(2)文章的工作

介绍了知识蒸馏,并使用知识蒸馏在MNIST数据集上,取得了令人惊讶的成就,并且将知识蒸馏运用在语音识别模型中,也取得的很好的效果。最后讲解了专才模型集成(这一部分和知识蒸馏关系不大)。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

183

183

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?