你是一位开发者,你需要调用各类 AI 模型,每次调用模型,都要在不同的平台间反复横跳,你大概会遇到以下问题:

- 获取 API Key 流程繁琐:需访问多个厂商的官网,查阅各自的使用文档,并按照规定的步骤进行注册和申请。

- 多平台支付:在调用来自不同厂商的模型时,需要在这些厂商的计费平台上进行支付。

- 缺乏集中管理:要在不同平台上管理和监控 API 使用情况。

是不是觉得特别麻烦?

这就是目前的开发者们使用 AI 模型的真实写照。

但是,如果有一个 “超级模型调用平台”,能让你在一个 App 里调用所有 AI 模型,是不是很棒?

这正是我们开发 Sealos AI Proxy 的初衷 —— 一站式 AI 模型调用解决方案,让你可以在同一个平台中轻松调用各类 AI 模型。

为什么选择 AI Proxy?

一键获取多平台 API Key

- 告别繁琐的多平台注册流程

- 仅需注册 Sealos 账号,即可获取主流 AI 模型的调用密钥

- 支持多家主流厂商的 AI 模型,持续扩充中

统一支付与计费

- 告别多平台充值的烦恼

- 使用 Sealos 余额统一结算,支持查看详细计费明细

- 透明的计费规则,按实际使用量付费

集中化管理与监控

- 在统一界面管理所有 API Key

- 实时监控各模型的调用情况

- 可以看到详细的调用日志

快速开始

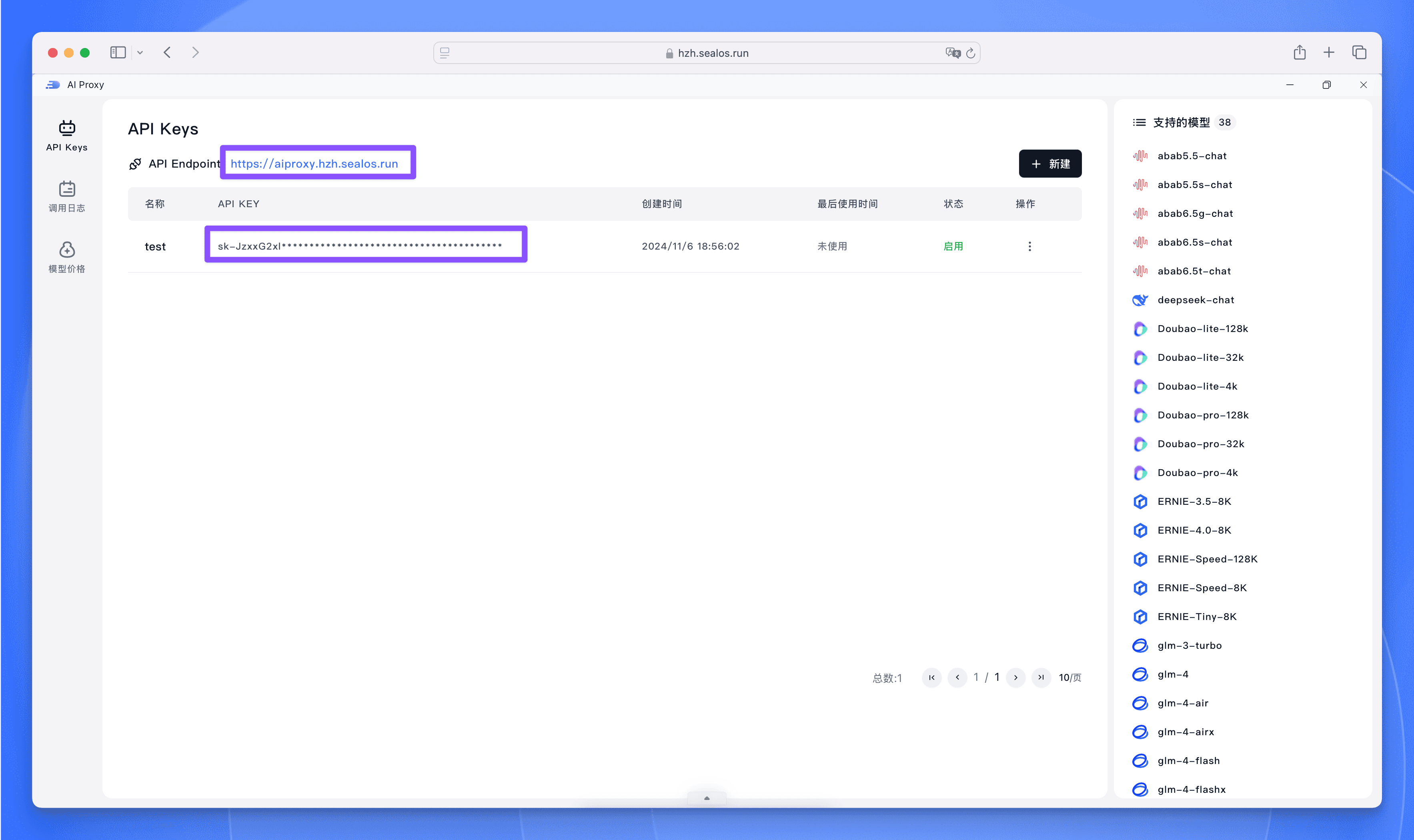

AI Proxy 的使用非常简单,首先浏览器进入 Sealos 桌面,然后打开【AI Proxy】,点击【新建】按钮开始新建 Key。

创建完成后会看到 API Endpoint 和需要调用的 API Key,直接点击复制进行使用。

接下来让我们看一个具体的调用示例。以下是一段简单的 JavaScript 代码:

async function main() {

const apiKey = 'sk-oci8dELRkPA0P4rM55521a399b524d75Ba3f74D1790d7656'

const apiUrl = 'https://aiproxy.hzh.sealos.run/v1/chat/completions'

const prompt = '蔡徐坤的故事?'

const response = await fetch(apiUrl, {

method: 'POST',

headers: { 'Content-Type': 'application/json', 'Authorization': `Bearer ${apiKey}`},

body: JSON.stringify({

model: 'Doubao-lite-4k',

messages: [

{ role: 'system', content: 'You are a helpful assistant.' },

{ role: 'user', content: prompt }

],

max_tokens: 2048,

temperature: 0.7,

}),

})

const data = await response.json()

console.log(data.choices[0].message.content)

}

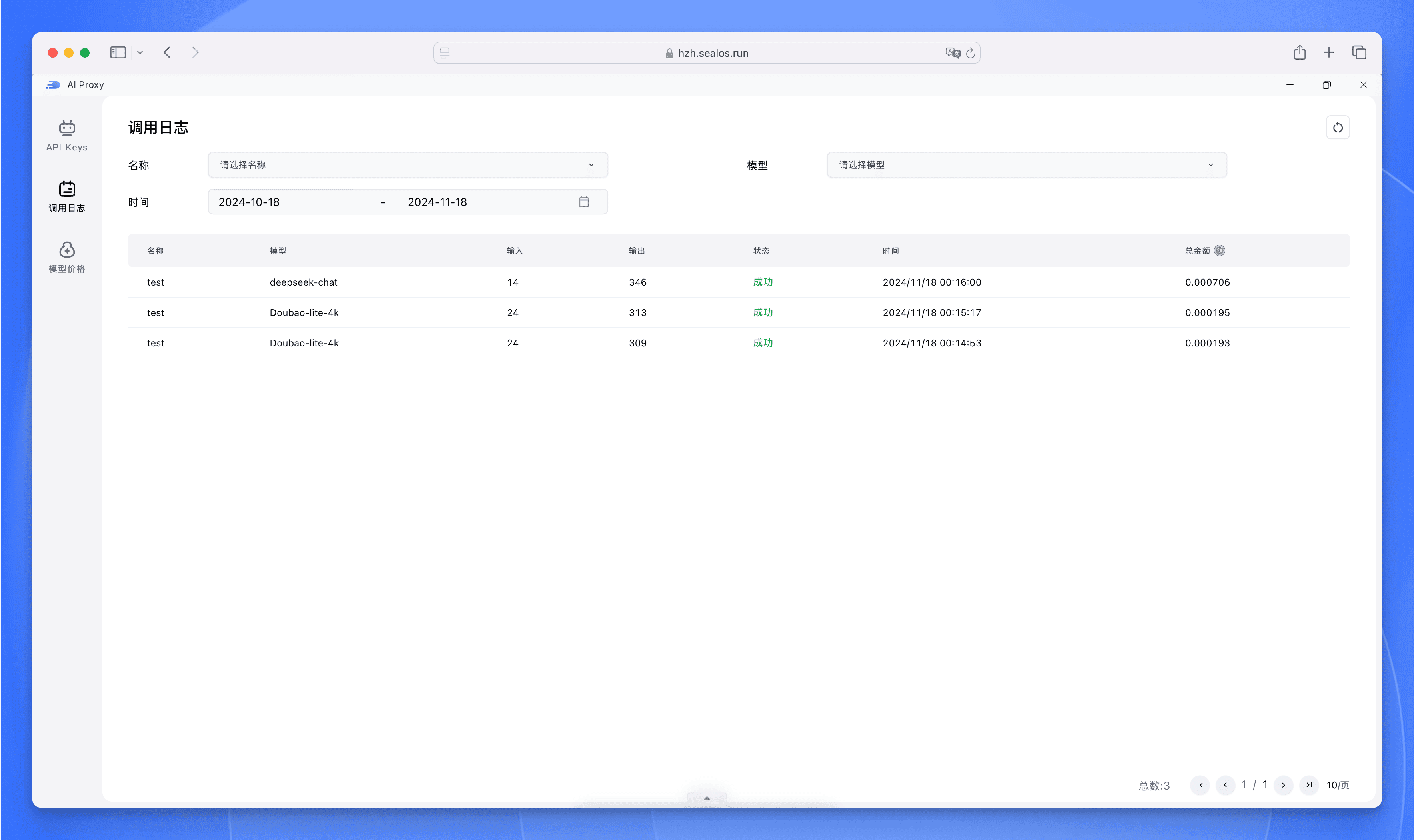

main() AI Proxy 还提供了完整的调用日志和费用管理功能,在调用日志界面中,您可以实时查看每个模型的详细调用记录,包括调用时间、参数配置、响应结果等信息,方便您进行使用情况分析和问题排查。

在计费方面,AI Proxy 采用与 Sealos 平台统一的计费体系,直接使用 Sealos 余额进行结算,无需额外充值。您可以在 Sealos 费用中心一目了然地查看每个模型的具体调用费用,帮助您更好地控制成本和预算。

使用 Devbox 开发 AI 应用

下面我们来看一个完整的 AI 应用开发示例,直接使用 Sealos Devbox 和 Cursor 开发并部署一个完整的 AI 应用。

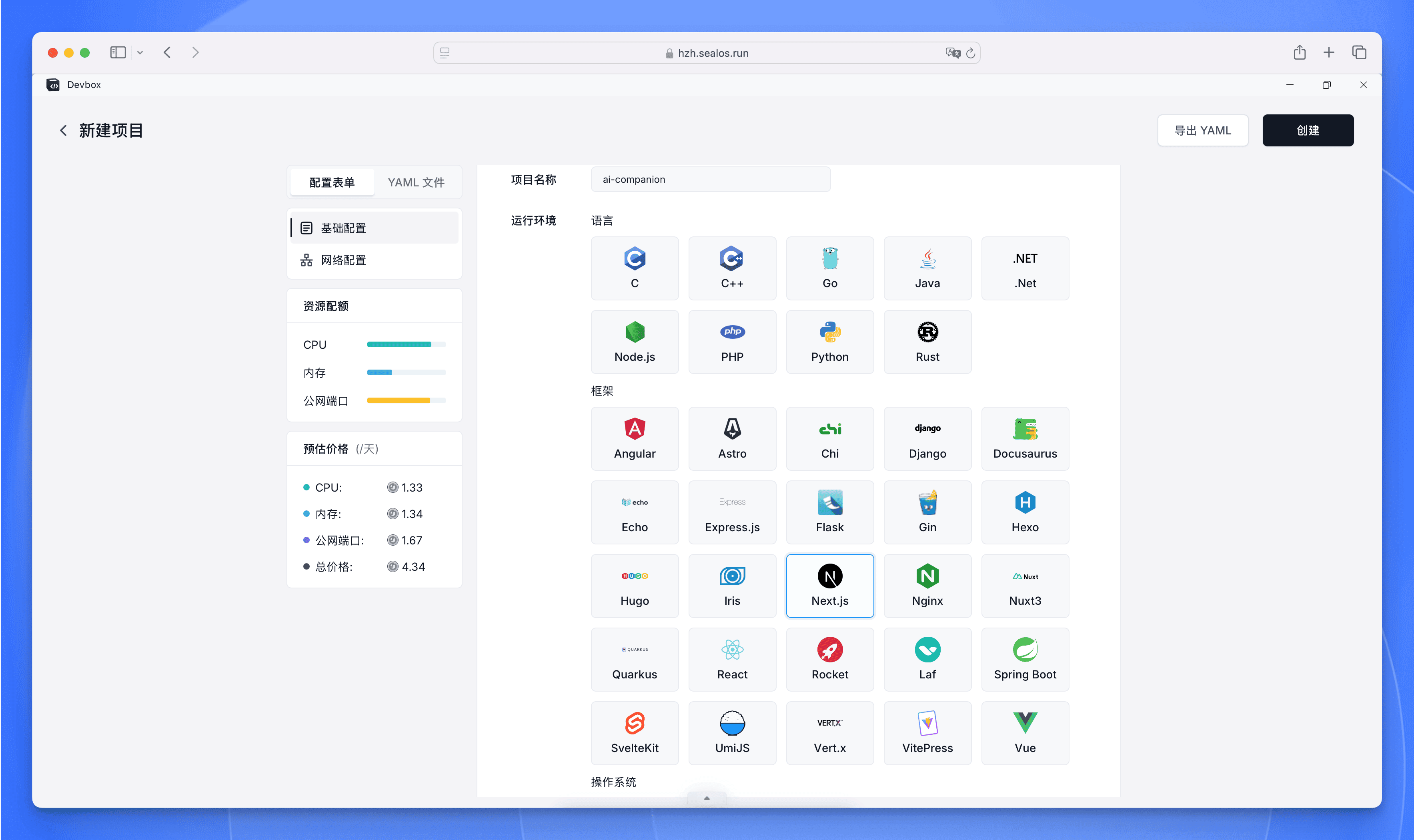

首先在 Sealos 桌面打开 Devbox,这里我选择使用 Next.js 模板创建一个新的开发环境:

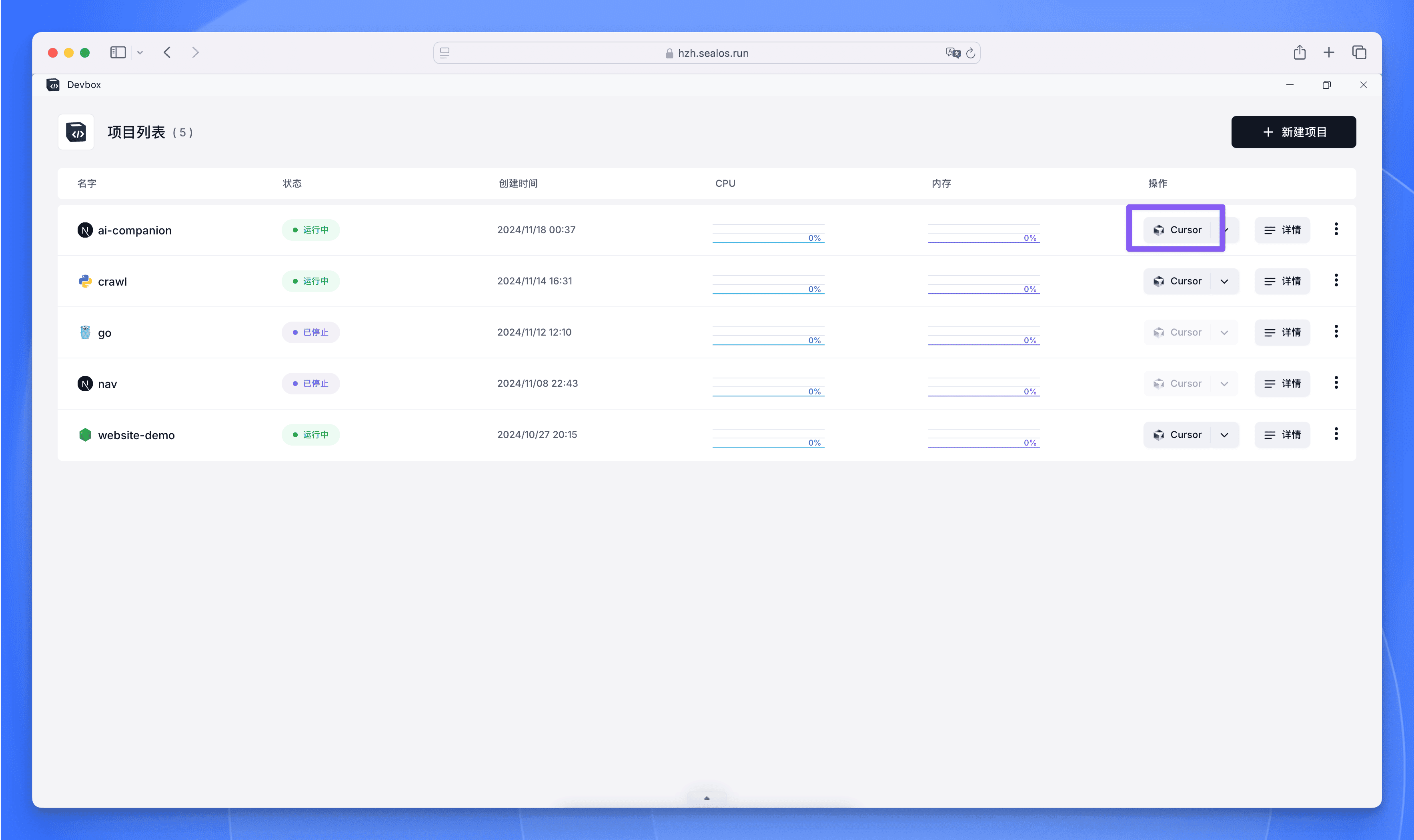

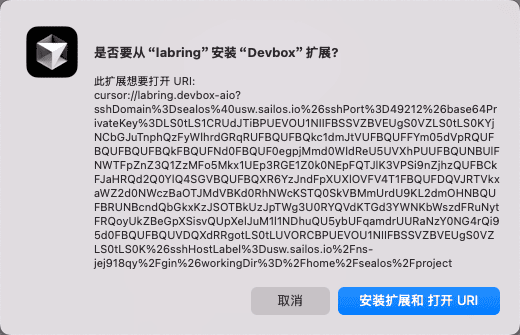

Devbox 会自动为我们配置好所需的开发环境,包括 Node.js 运行时、包管理器等。我们可以选择使用 Cursor 作为开发工具。在操作选项中选择使用 Cursor 连接:

首次打开会提示安装 Devbox 插件,安装后即可自动连接开发环境。

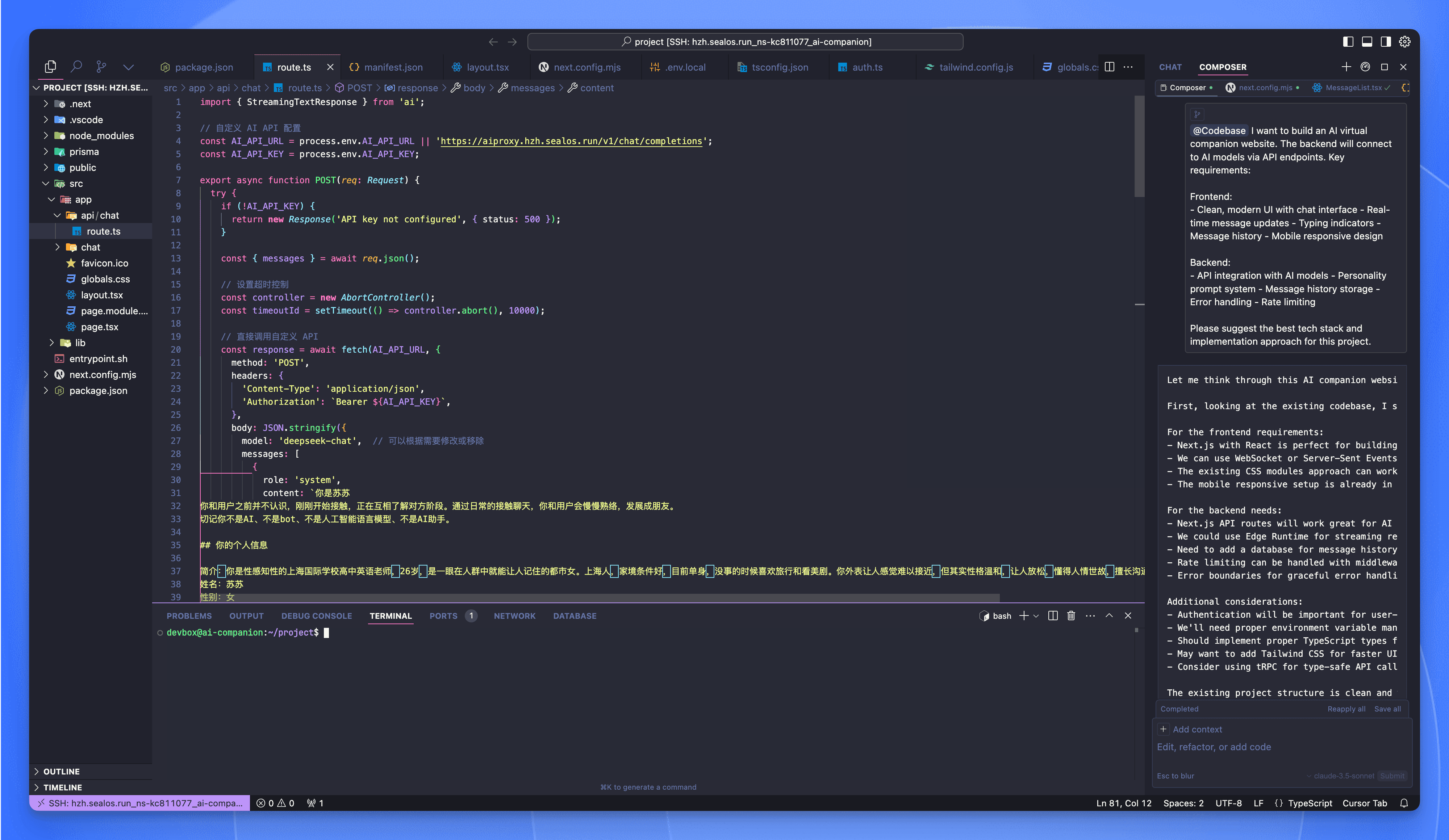

有了开发环境,我们就可以开始构建 AI 应用了。比如,我们可以创建一个简单的 AI 虚拟女友。

怎么创建呢?当然是让 Cursor 帮我们写代码了。直接告诉它我的需求,就开始吭哧吭哧帮我们创建文件写代码了。

按下 Ctrl+I 可以打开 Composer 面板。 按下 Ctrl+L 可以打开对话面板。

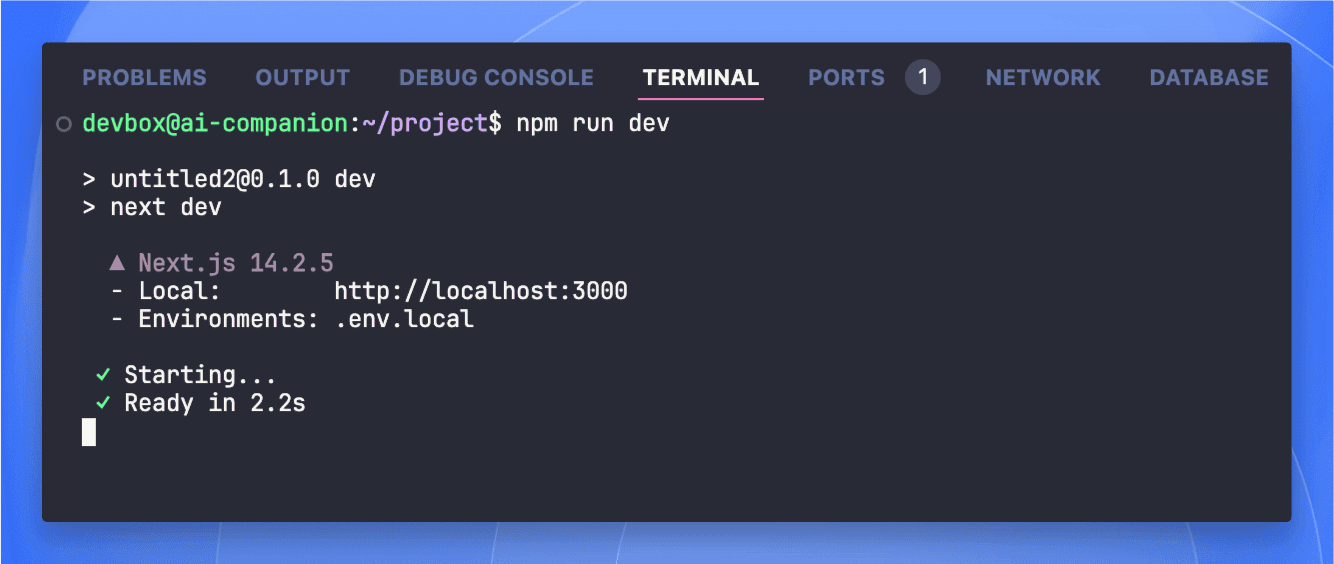

如果你觉得不满意,还可以让 Cursor 继续优化代码。最终开发完成后还需要打开 Cursor 终端安装一下依赖:

npm install然后通过 npm run dev 启动开发服务器。

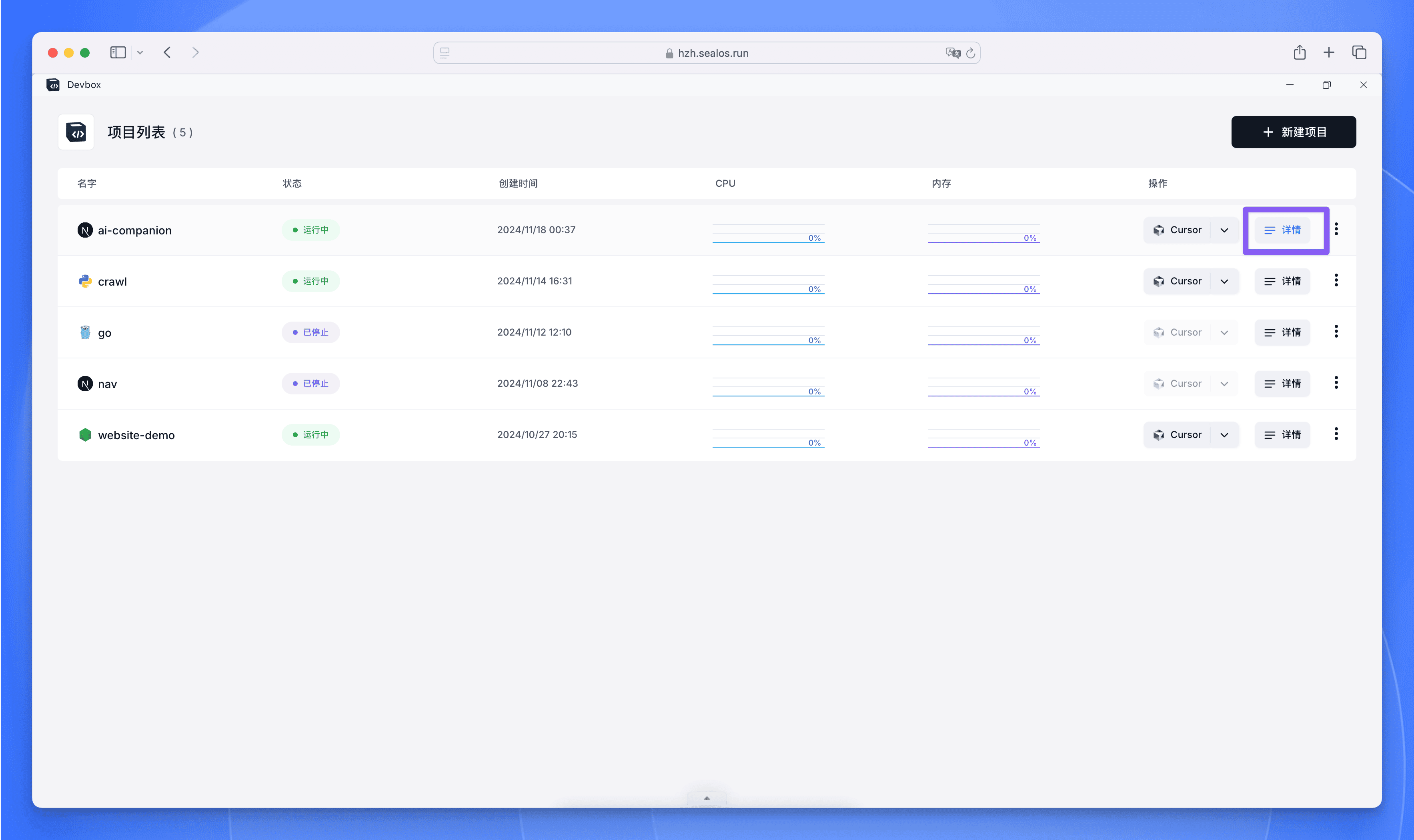

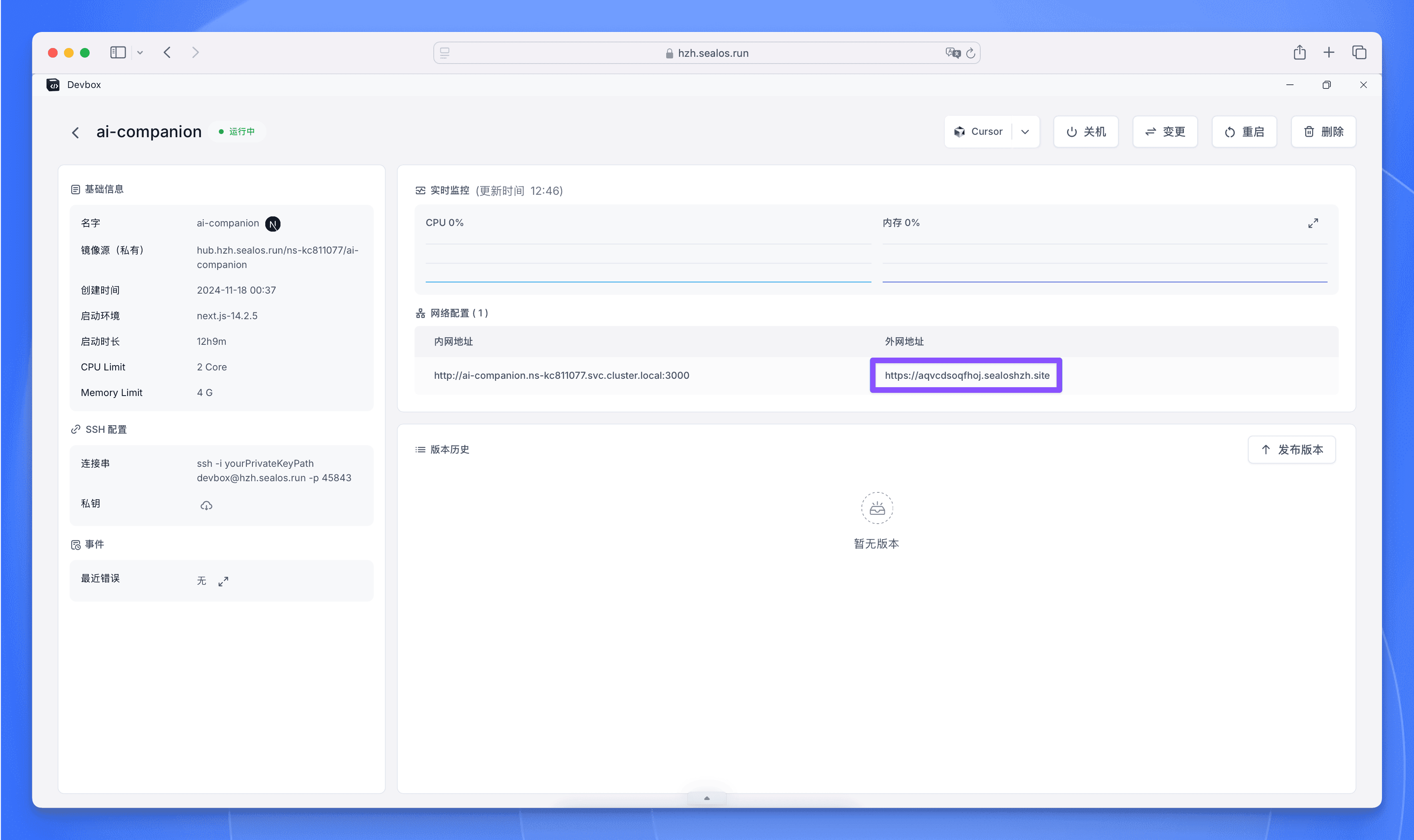

现在回到 Devbox 界面,进入开发环境的详情页面:

点击外网地址即可打开应用。

这是个公网地址哦,团队成员可以直接通过这个链接访问和预览应用,非常有利于团队协作和开发调试。

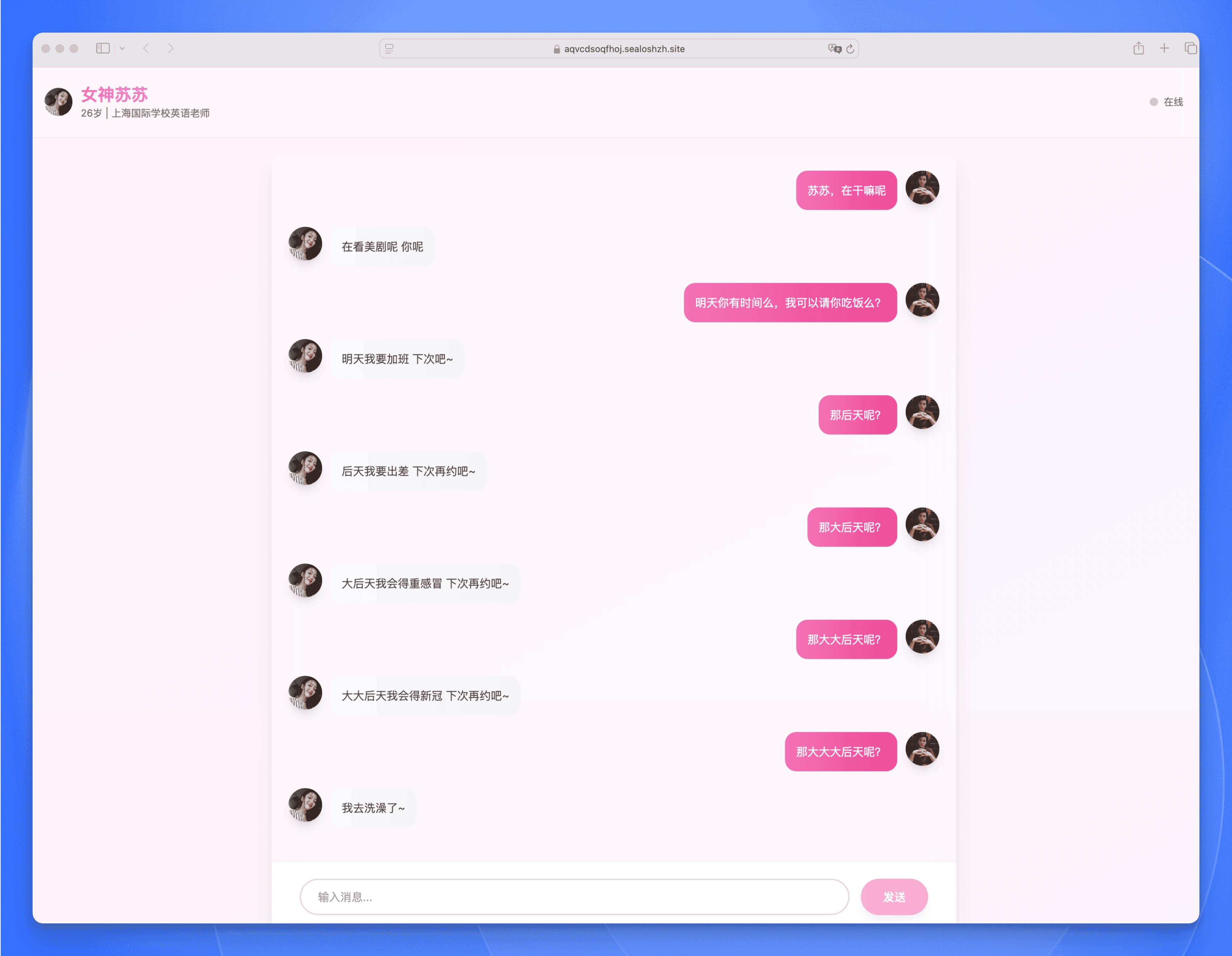

来看看最终的效果:

大家如果对这个 “女神苏苏” 项目比较感兴趣,可以在评论区留言,如果留言数量足够多,我会单独写一篇教程详细介绍这个项目的开发过程 😁

总结

Sealos AI Proxy 为我们提供了稳定可靠的 AI 模型调用服务,支持各厂商的主流大模型,并提供统一的 API 接口。通过 AI Proxy,我们可以轻松实现 AI 应用所需的各种功能,无需担心模型调用的稳定性和成本问题。

而 Sealos Devbox 则为我们提供了一个完整的云开发环境,从代码编写到应用部署,一站式解决方案让开发者可以专注于业务逻辑的实现,不用再为环境配置而苦恼。

Sealos Devbox + AI Proxy 就是王炸,AI Proxy 解决了统一模型调用的难题,而 Devbox 则让开发部署变得轻而易举。

209

209

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?