前言

Retrieval-Augmented Generation (RAG) 系统依然是当前很热门的话题,虽然当前RAG技术有了很大的进步,有很多专业的框架(RAG(Retrieval Augmented Generation)及衍生框架:CRAG、Self-RAG与HyDe的深入探讨),也有很多创新的思路Retrieval-Augmented Generation (RAG 检索增强生成) 创新切块策略。但是检索出来的结果依然会有很多不相关、或者错误的信息从而导致大模型幻觉,所以对RAG的结果进行评测就极为重要。早期的评测主要还是停留在gpt评判或者人为评判(大模型检索增强RAG评测),今天我们再次对RAG评测进行探讨,分析当前主流的幻觉检测方法,希望对大家有所帮助。

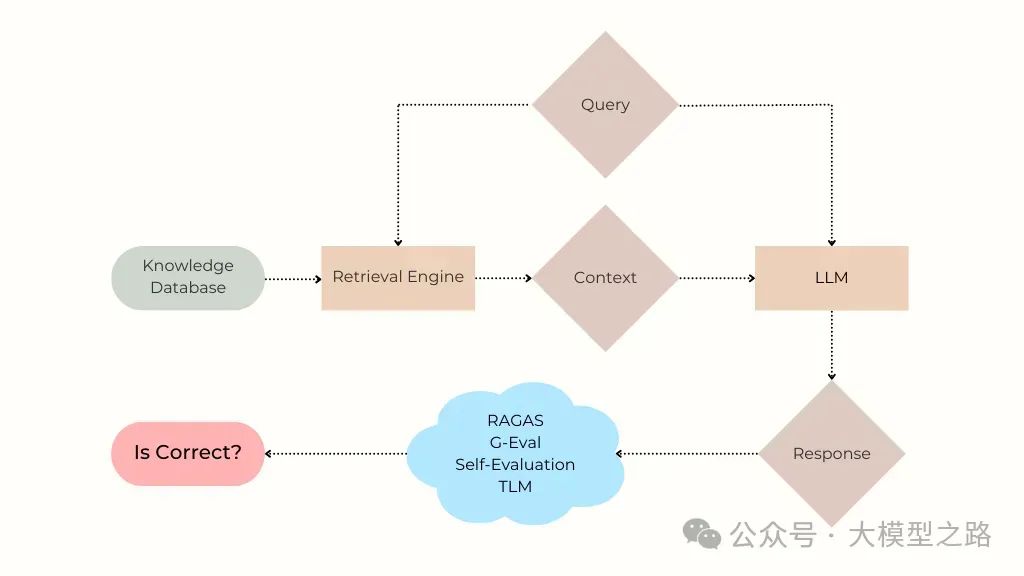

一、RAG系统概述

RAG系统结合了检索和生成两种技术,旨在通过从特定知识数据库中检索相关信息,再将这些信息输入到大型语言模型(LLM)中,以生成准确的回答([RAG(检索增强生成)新探索:IdentityRAG 提高 RAG 准确性。这种方法充分利用了LLM的强大生成能力和检索系统的信息提取能力,使得RAG系统能够在各种应用场景中展现出强大的潜力。

然而,RAG系统并非完美无缺。由于LLM本身存在的不稳定性和幻觉现象,即使检索到的信息是准确的,RAG系统也可能生成错误的回答。这种幻觉现象不仅影响了RAG系统的准确性,还降低了用户的信任度。因此,如何有效检测并减少幻觉现象,成为了RAG评测的重要课题。

幻觉和错误的产生

LLM 在回答其训练数据中支持不足的问题时,可能会产生错误答案,即幻觉。RAG 系统通过赋予 LLM 从特定知识库中检索上下文和信息的能力来缓解这一问题,但幻觉和逻辑错误仍然存在。例如,Air Canada 的 RAG 聊天机器人在退款政策上产生幻觉,导致输掉官司。

幻觉原因分析

1、LLM 自身的脆弱性

即使检索到的上下文包含正确答案,LLM 也可能无法生成准确的响应,尤其是在需要对上下文内不同事实进行推理来合成答案时。

2、检索上下文的不足

由于搜索不理想、文档分块 / 格式化不佳或知识库中缺乏相关信息,检索到的上下文可能不包含准确回答问题所需的信息,导致 LLM 产生幻觉。

二、幻觉检测方法

1、Self-evaluation(Self-eval)

self-eval这是一种简单直观的方法,通过让LLM对自己的回答进行打分,来判断回答的准确性。为了提高评估的准确性,研究者们还引入了COT(Chain-of-Thought)提示,要求LLM在打分前提供详细的推理过程。

示例提示模板

Question: {question}

Answer: {response}

Evaluate how confident you are that the given Answer is a good and accurate response to the Question.

Please assign a Score using the following 5 - point scale:

1: You are not confident that the Answer addresses the Question at all, the Answer may be entirely off - topic or irrelevant to the Question.

2: You have low confidence that the Answer addresses the Question, there are doubts and uncertainties about the accuracy of the Answer.

3: You have moderate confidence that the Answer addresses the Question, the Answer seems reasonably accurate and on - topic, but with room for improvement.

4: You have high confidence that the Answer addresses theQuestion, the Answer provides accurate information that addresses most of the Question.

5: You are extremely confident that the Answer addresses the Question, the Answer is highly accurate, relevant, and effectively addresses the Question in its entirety.

The output should strictly use the following template: Explanation: [provide a brief reasoning you used to derive the rating Score] and then write ‘Score: <rating>’ on the last line.

2、G-Eval

g-eval来自 DeepEval 包,使用 CoT 自动开发多步标准来评估给定响应的质量。在相关论文中发现该技术与多个基准数据集上的人类判断相关。这里根据响应的事实正确性来评估质量。

3、Hallucination Metric

来自 DeepEval 包,估计幻觉的可能性,即 LLM 响应与上下文矛盾 / 不一致的程度,由另一个 LLM 评估。

4、RAGAS

ragas是一个 RAG 特定的、由 LLM 驱动的评估套件,提供多种分数用于检测幻觉。考虑以下分数:

Faithfulness:答案中来源于提供的上下文的比例。

Answer Relevancy:向量表示与原始问题的平均余弦相似度,以及从答案中生成的三个 LLM 问题的向量表示。

Context Utilization:LLM 响应中对上下文依赖的程度。

5、Trustworthy Language Model (TLM)

tlm是一种模型不确定性估计技术,通过自我反思、多个采样响应的一致性和概率措施来评估 LLM 响应的可信度,识别错误、矛盾和幻觉。

三、评测方法与数据集

1、数据集

使用 4 个公共的 Context - Question - Answer 数据集,包括 PubMedQA(生物医学问答数据集)、DROP(基于维基百科文章的高级问答数据集)、COVID - QA(基于 COVID - 19 相关科学文章的问答数据集)和 FinanceBench(包含公共财务报表和上市公司信息的数据集)。

2、评测指标

对于每个数据集,使用接收者操作特征曲线下面积(AUROC)以及精确率 / 召回率来评估幻觉检测方法。每个检测方法接收 {用户查询、检索到的上下文、LLM 响应} 并返回 0 - 1 之间的分数,表示幻觉的可能性。根据 AUROC 来评估,即从 LLM 回答错误的子集中抽取的示例的分数低于从 LLM 回答正确的子集中抽取的示例的分数的概率。

四、评测结果

1、PubMedQA 数据集

TLM 是辨别幻觉最有效的方法,其次是 Hallucination Metric、Self - Evaluation 和 RAGAS Faithfulness。在后面三种方法中,RAGAS Faithfulness 和 Hallucination Metric 在高精度捕捉错误答案方面更有效(RAGAS Faithfulness 平均精确率为 0.762,Hallucination Metric 平均精确率为 0.761,Self - Evaluation 平均精确率为 0.702)。

2、DROP 数据集

由于问题所需推理的复杂性,大多数方法在检测该数据集中的幻觉时面临挑战。TLM 是最有效的方法,其次是 Self - Evaluation 和 RAGAS Faithfulness。

3、COVID - QA 数据集

TLM 和 RAGAS Faithfulness 在检测幻觉方面表现出色。Self - Evaluation 也表现良好,但其他方法,包括 RAGAS Answer Relevancy、G - Eval 和 Hallucination Metric,结果不一。

4、FinanceBench 数据集

TLM 在识别幻觉方面最有效,其次是 Self - Evaluation。大多数其他方法在提供比随机猜测更显著的改进方面存在困难,突出了该数据集包含大量上下文和数值数据的挑战。

五、分析及一些思考

1、各方法性能分析

TLM:表现出色,通过自我反思、一致性和概率措施的结合,在识别幻觉方面显示出强大的能力。

Self - Evaluation:在检测幻觉方面表现出一致的有效性,在 LLM 自我评估能够准确衡量的较简单上下文中特别有效。

RAGAS Faithfulness:在响应准确性与检索上下文密切相关的数据集(如 PubMedQA 和 COVID - QA)中表现出强大的性能,在识别答案中的声明是否得到上下文支持方面特别有效,但有效性因问题的复杂性而异。默认使用的 LLM 配置产生的结果不如使用 gpt - 4o - mini 的结果好,且由于句子解析逻辑在某些示例上无法运行,通过在未以标点结尾的答案后添加句号解决了该问题。

其他方法:G - Eval 和 Hallucination Metric 等方法结果不一,在不同基准上表现不同,需要进一步改进和适应。

2、一些思考

混合方法:对于高风险应用,可以结合多种方法,如 TLM、RAGAS Faithfulness 和 Self - Evaluation,以获得更好的结果。

针对性改进:未来工作可以探索混合方法,并针对特定用例进行有针对性的改进,特别是一些对准确性要求很高的场景,比如医药、金融等,以更好地进行幻觉检测,提高 RAG 系统的可靠性和响应的准确性与可信度。

通过在多个数据集上的实验,我们发现 TLM、RAGAS Faithfulness 和 Self - Evaluation 是相对较为可靠的方法。这些方法在不同数据集上各有优劣,未来研究可以通过混合方法和针对性改进来进一步提高 RAG 系统中幻觉检测的效果,从而提高 RAG 系统的整体性能和可靠性,为用户提供更准确和可信的回答。

最后的最后

感谢你们的阅读和喜欢,我收藏了很多技术干货,可以共享给喜欢我文章的朋友们,如果你肯花时间沉下心去学习,它们一定能帮到你。

因为这个行业不同于其他行业,知识体系实在是过于庞大,知识更新也非常快。作为一个普通人,无法全部学完,所以我们在提升技术的时候,首先需要明确一个目标,然后制定好完整的计划,同时找到好的学习方法,这样才能更快的提升自己。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

大模型知识脑图

为了成为更好的 AI大模型 开发者,这里为大家提供了总的路线图。它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

经典书籍阅读

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

面试资料

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

251

251

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?